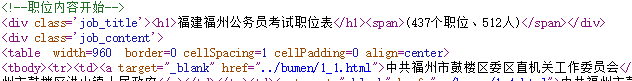

Precisamos encontrar o rótulo web crawling do código-fonte e configuração de html rastejando classe target = 'job_titile' e class = 'job_content'

Precisamos encontrar o rótulo web crawling do código-fonte e configuração de html rastejando classe target = 'job_titile' e class = 'job_content'

Importação pedidos de BS4 Import a BeautifulSoup Import BS4 Import PANDAS PD AS # ferramenta de referência URL = ' http://fj.huatu.com/zt/2019zwb/diqu/1.html ' DEF Job (S): # função -definida o try : cabeçalhos {= ' o User-- agente ' : ' o Mozilla / 5.0 (Windows NT 6.3; Win64; x64) AppleWebKit / 537,36 (KHTML, como o gecko) o cromo / 69.0.3497.100 Safari / 537,36 ' } R & lt = requests.get (S, tempo limite = 30, headers = cabeçalhos) # solicitação get send r.raise_for_status () r.encoding = r.apparent_encoding # Unicode Soup = BeautifulSoup (r.text, ' lxml ' ) # usar a biblioteca BeautifulSoup retorno Soup a exceção : retorno "" # erro, devolve uma cadeia vazia de sopa = the Job ( URL) a = [] # definir duas lista vazia B = [] para link1 em soup.find_all ( ' div ' , o class_ = ' job_content ' ): # uso find_all tag pesquisa função b.append (link1.get_text ()) para link2 em soup.find_all ( ' div ' , o class_ = ' JOB_TITLE ' ): (. link2.get_text () tira ()) a.append Dados = pd.DataFrame ([A , B], index = [ " diretório " , " posição " ]) # uso trama de dados visuais de impressão ( " dados de posição Fuzhou Região: " , " \ n- ' ) # usando a função de impressão para imprimir print (dados)

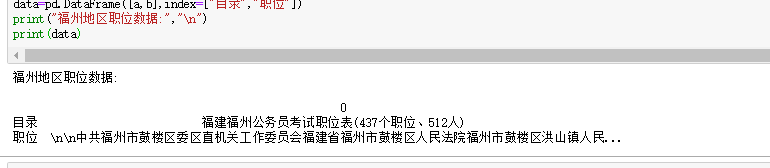

Os resultados são mostrados rastejando

Os resultados são mostrados rastejando