Capítulo 2 HDFS operações da Shell

1. A sintaxe básica

bin/hadoop fs 具体命令

bin/hdfs dfs 具体命令

dfs是fs的实现类。

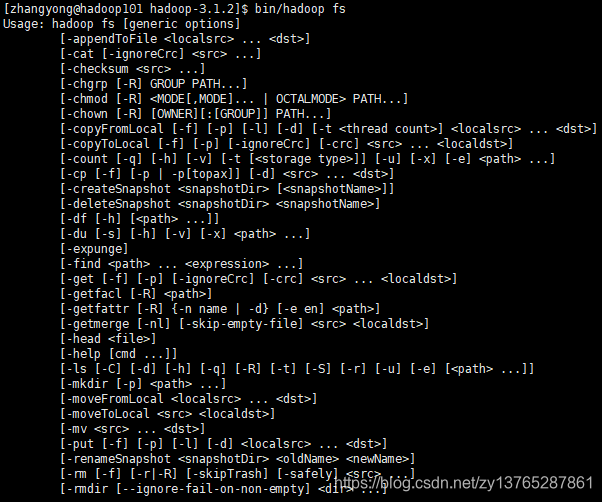

2. comando Daquan

[zhangyong@hadoop101 hadoop-3.1.2]$ bin/hadoop fs

3. funcionamento prático de comandos mais usados

(0) cluster de Iniciar Hadoop (para facilitar o teste subsequente)

[zhangyong@hadoop101 hadoop-3.1.2]$ sbin/start-dfs.sh 启动dsf

[zhangyong@hadoop102 hadoop-3.1.2]$ sbin/start-yarn.sh 启动yarn

[zhangyong@hadoop103 hadoop-3.1.2]$ mr-jobhistory-daemon.sh start historyserver 启动历史服务器

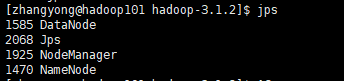

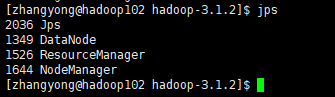

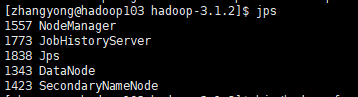

Lançamento OK Visualização JPS:

exibindo o serviço representa um início bem sucedido:

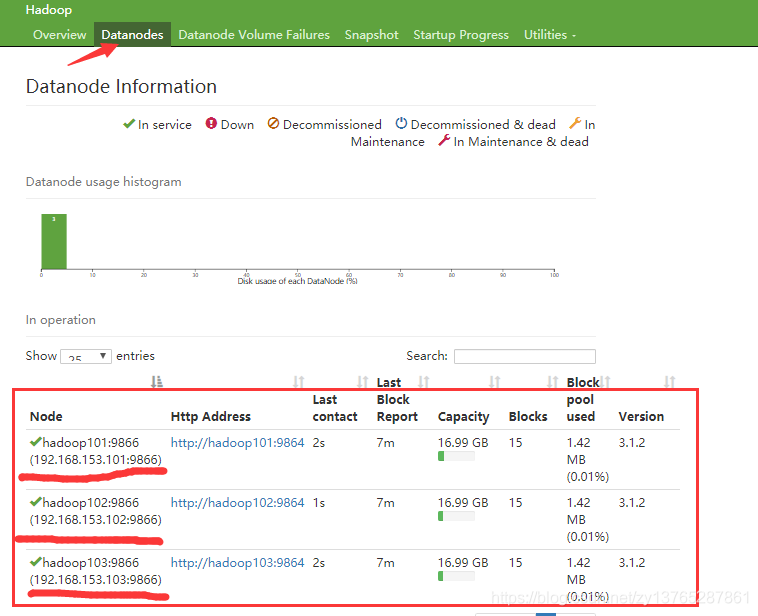

página verificar se iniciado com êxito:

http://hadoop101:9870/dfshealth.html#tab-datanode

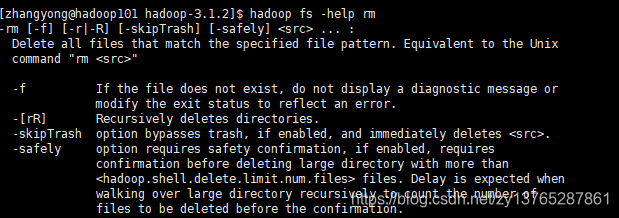

(1) -help: saída deste parâmetro de comando

[zhangyong@hadoop101 hadoop-3.1.2]$ hadoop fs -help rm

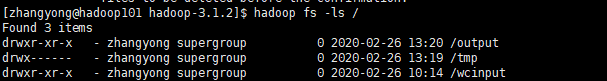

(2) -É: informações do diretório de exibição

[zhangyong@hadoop101 hadoop-3.1.2]$ hadoop fs -ls /

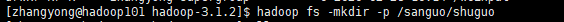

(3) -mkdir: Crie um diretório no HDFS

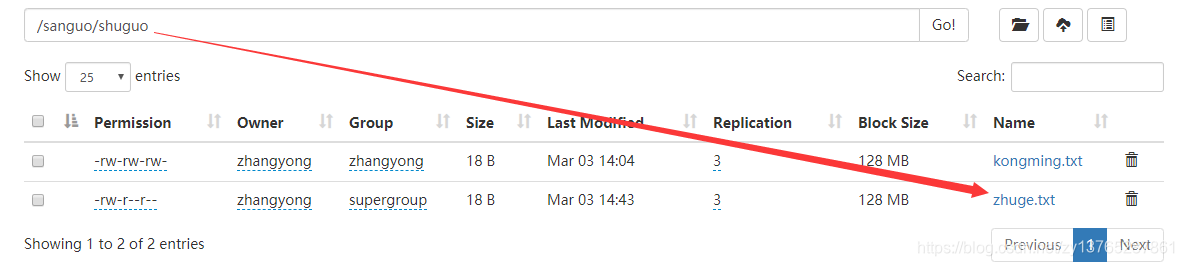

[zhangyong@hadoop101 hadoop-3.1.2]$ hadoop fs -mkdir -p /sanguo/shuguo

(4) -moveFromLocal: Cole corte do local para os HDFS

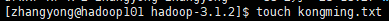

[zhangyong@hadoop101 hadoop-3.1.2]$ touch kongming.txt //在本地创建kongming.txt

[zhangyong@hadoop101 hadoop-3.1.2]$ hadoop fs -moveFromLocal ./kongming.txt /sanguo/shuguo //将本地的kongming.txt提交到fds中

(5) -appendToFile: Anexar um arquivo para o final do arquivo já existe

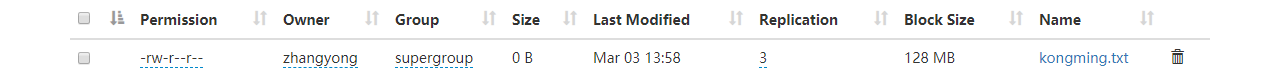

[zhangyong@hadoop101 hadoop-3.1.2]$ touch zhangyong.txt

[zhangyong@hadoop101 hadoop-3.1.2]$ vi zhangyong.txt

entrada

zhangyong cainiao

[zhangyong@hadoop101 hadoop-3.1.2]$hdfs dfs -appendToFile zhangyong.txt /sanguo/shuguo/kongming.txt

(6) -cat: exibir o conteúdo do arquivo

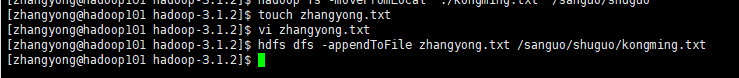

[zhangyong @ hadoop101 hadoop-3.1.2] $ hadoop FS -cat /sanguo/shuguo/kongming.txt

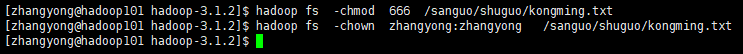

(7) -chgrp, -chmod, -chown: o uso do sistema de arquivos Linux como, modificar as permissões de arquivo pertence

[zhangyong@hadoop101 hadoop-3.1.2]$ hadoop fs -chmod 666 /sanguo/shuguo/kongming.txt

[zhangyong@hadoop101 hadoop-3.1.2]$ hadoop fs -chown zhangyong:zhangyong /sanguo/shuguo/kongming.txt

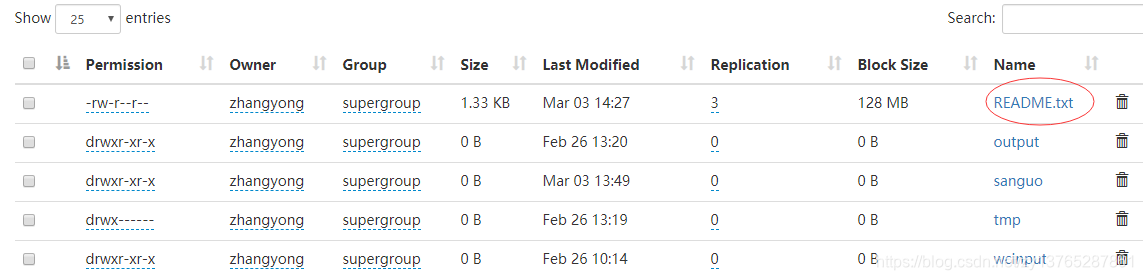

(8) -copyFromLocal: a partir do sistema de arquivos local para copiar arquivos para caminho HDFS

[zhangyong@hadoop101 hadoop-3.1.2]$ hdfs dfs -copyFromLocal README.txt /

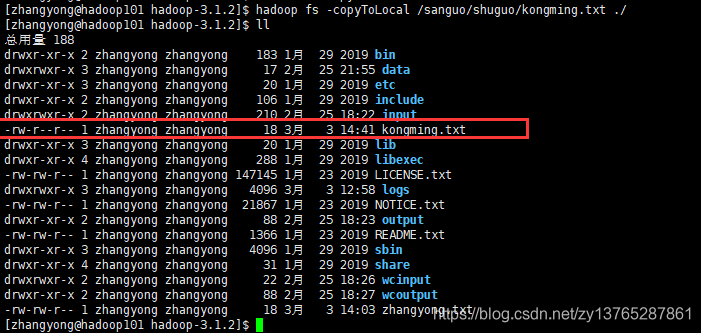

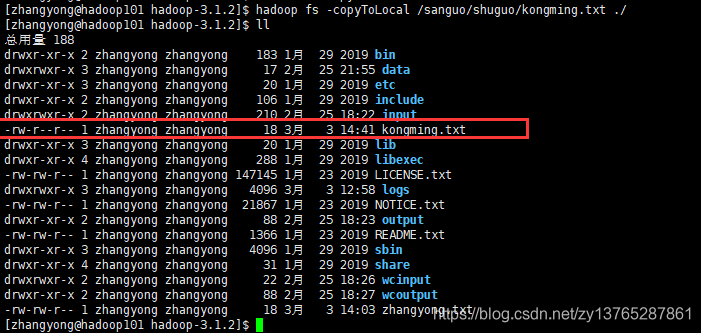

(9) -copyToLocal: copiado do local para HDFS

[zhangyong@hadoop101 hadoop-3.1.2]$ hadoop fs -copyToLocal /sanguo/shuguo/kongming.txt ./

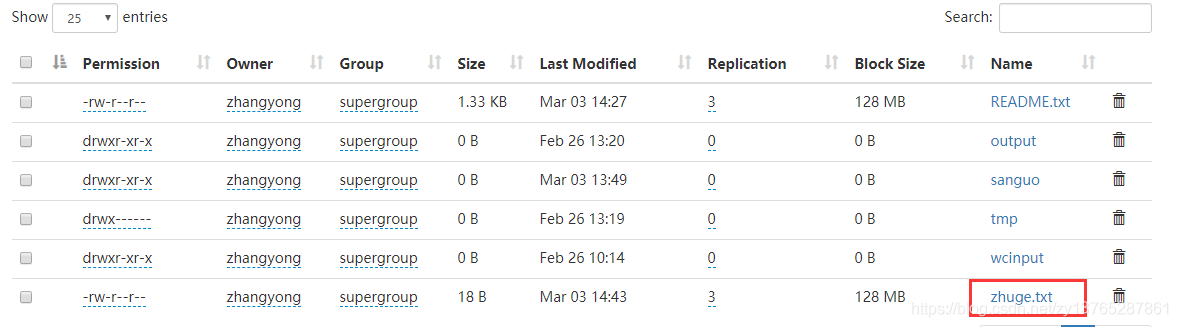

(10): -cp HDFS copiado a partir de um caminho para o outro caminho de HDFS

[zhangyong@hadoop101 hadoop-3.1.2]$ hadoop fs -cp /sanguo/shuguo/kongming.txt /zhuge.txt

(11) -mv: mover arquivos no diretório HDFS

[zhangyong@hadoop101 hadoop-3.1.2]$ hadoop fs -mv /zhuge.txt /sanguo/shuguo/

(12) -get: equivalente a copyToLocal, é para baixar arquivos de HDFS ao local,

[zhangyong@hadoop101 hadoop-3.1.2]$ hadoop fs -get /sanguo/shuguo/kongming.txt ./

(13) -getmerge: Mesclar download de vários arquivos, arquivos múltiplos, tais como diretório HDFS / user / zhangyong / test: log.1, log.2, log.3, ...

[zhangyong@hadoop101 hadoop-3.1.2]$ hadoop fs -getmerge /user/zhangyong/test/* ./zaiyiqi.txt

(14) -put: equivalente a copyFromLocal

[zhangyong@hadoop101 hadoop-3.1.2]$ hadoop fs -put ./zaiyiqi.txt /user/zhangyong/test/

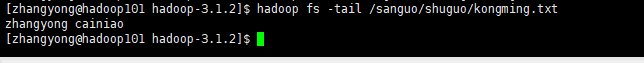

(15) -tail: aparece no final de um arquivo

[zhangyong @ hadoop101 hadoop-3.1.2] $ hadoop FS -tail /sanguo/shuguo/kongming.txt

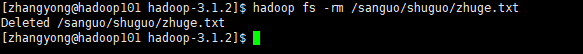

(16) -rm: excluir um arquivo ou pasta

[zhangyong @ hadoop101 hadoop -3.1.2] $ hadoop FS -rm /sanguo/shuguo/zhuge.txt

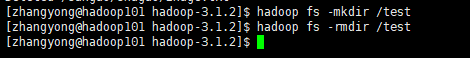

(17) -rmdir: diretório vazio de exclusão

[zhangyong@hadoop101 hadoop-3.1.2]$ hadoop fs -mkdir /test 创建空目录

[zhangyong@hadoop101 hadoop-3.1.2]$ hadoop fs -rmdir /test 删除目录

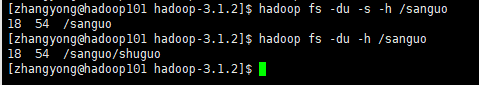

pasta estatísticas informações de tamanho (18) -du

[zhangyong@hadoop101 hadoop-3.1.2]$ hadoop fs -du -s -h /user/zhangyong/test

[zhangyong@hadoop101 hadoop-3.1.2]$ hadoop fs -du -h /user/zhangyong/test

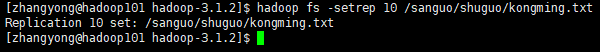

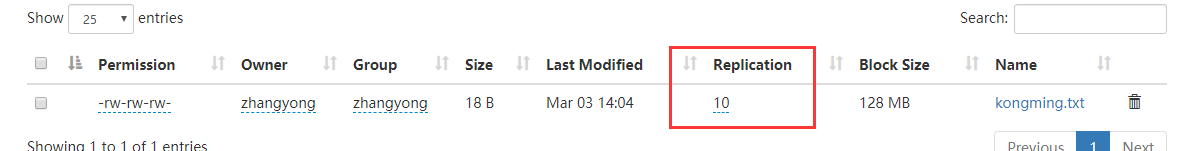

(19) -setrep: Defina o número de cópias dos arquivos em HDFS

[zhangyong@hadoop101 hadoop-3.1.2]$ hadoop fs -setrep 10 /sanguo/shuguo/kongming.txt

número HDFS de cópias

do número de cópias definido aqui só é registrado no NameNode metadados se existem realmente tantas cópias, terá de ver o número de DataNode. Uma vez que, actualmente, apenas três dispositivos no máximo três cópias, apenas o número de nodos aumentada para 10, o número de cópias para atingir 10.