メカニズムの注目を導入する理由

「コーダ - デコーダ(seq2seq)」⼀部⾥、様々な時点で同じステップデコーダ従属変数の背景(コンテキストベクトル)配列情報入力STARTを得ました。

しかし、長距離勾配のRNNメカニズムは長い文章のために消え実用上の問題がある、それはとても文章翻訳の必要な長さとして、固定長のベクターへの入力シーケンスいると、すべての有用な情報の保存希望することは困難です増加、このような構造の効果が大幅に削減されます。

同時に、ターゲットの単語は、復号化することができる唯一のオリジナルの入力に関するいくつかの言葉で、しかし、すべての入力に関連付けられていない、この選択プロセスのメカニズムに注目が明示的にモデル化することができます。

注目の制度的枠組み

注目重み付け手段の共通プールであり、入力が2つの部分から構成:照会(クエリ)とキーオン(キーと値のペア)は、ベクトルoは加重和の出力値であり、各キーが算出されます重量と値を一つずつ。

注意内積

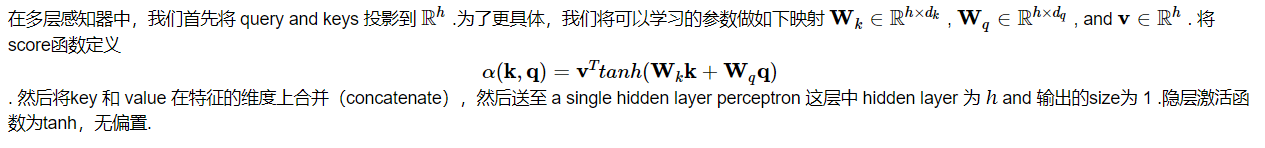

MLPの注意

注意メカニズムSeq2seqモデルの導入

このセクションでは、明示的に右の再凝集状態を使用するシーケンスの機構モデルにシーケンスに追加されることに注意してください。次の図に示すコードとモデル構造の復号化時にステップtは時間です。今、注目層は、参照をencoderingすべての情報を保持している - エンコード出力のすべてのステップということ。復号化段階では、デコーダの時間TT隠された状態では、クエリのようになる、注目重合のためのキーと値として、エンコーダの各時間ステップにおける隠れ状態。Attetionモデルは、コンテキストベクトルにコンテキスト情報、及びデコーダ入力として出力されます。 dTdTでは、デコーダに沿って一緒にステッチ

変成器

前のセクションでは、我々は、このような畳み込みニューラルネットワーク(CNNs)とリカレントニューラルネットワーク(のRNN)としてニューラルネットワークアーキテクチャの主流を導入しました。レッツ・レビューいくつか:

- 並列化しやすいCNNsは、より長い配列に依存関係をキャプチャするのに適していません。

- RNN適切な捕獲配列依存長い距離が長くなり、並列処理シーケンスを達成することは困難です。

为了整合CNN和RNN的优势,[Vaswani et al., 2017] 创新性地使用注意力机制设计了Transformer模型。该模型利用attention机制实现了并行化捕捉序列依赖,并且同时处理序列的每个位置的tokens,上述优势使得Transformer模型在性能优异的同时大大减少了训练时间。

相关知识

1多头注意力层

2基于位置的前馈网络

3、Add and Norm相加归一化层

4位置编码 、解码器