編集者注: 現在、大規模言語モデルが自然言語処理の分野で注目を集めています。 LLM は本当に「賢い」のでしょうか?彼らは私たちにどのようなインスピレーションをもたらしてくれましたか?これらの質問に答えて、Darveen Vijayan がこの示唆に富んだ記事を提供してくれました。

著者は主に 2 つの点を説明します。 まず、LLM は次の単語を予測することによって機能する単語計算機と見なされるべきであり、この段階では「インテリジェント」として分類されるべきではありません。第 2 に、LLM には現在の制限があるにもかかわらず、人間の知性の性質について考える機会が与えられます。私たちは心を開いて、常に新しい知識と知識の新しい理解を追求し、他の人と積極的にコミュニケーションをとって認知の境界を広げる必要があります。

LLM が賢いかどうかについては、おそらくまだ議論の余地があります。しかし、1 つ確かなことは、それらが自然言語処理の分野に革新をもたらし、人間の知性の性質についての考え方に新しい次元を提供したということです。この記事は、すべての大規模モデル ツール ユーザーと AI 実践者にとって、注意深く読んで理解する価値があります。

著者 | ダルビーン・ビジャヤン

編集済み | ユエ・ヤン

17 世紀初頭、エドモンド・ゴーントという数学者兼天文学者は、前例のない天文学的な課題に直面しました。惑星の複雑な運動を計算して日食を予測するには、天文学者は直感だけでなく、複雑な対数演算や三角関数にも頼る必要がありました。方程式。そこで、優れたイノベーターと同じように、グンター氏もアナログ コンピューティング デバイスを発明することにしました。彼が作成した装置は、最終的に計算尺として知られるようになりました[1]。

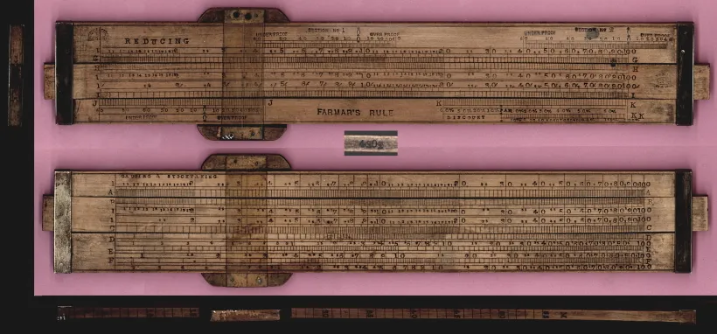

計算尺は長さ 30 cm の長方形の木製のブロックで、固定フレームとスライド部分から構成されます。固定フレームには固定対数目盛が、スライド部には可動目盛が収納されています。計算尺を使用するには、対数の基本原理と、乗算、除算、およびその他の数学演算のスケールを調整する方法を理解する必要があります。数字が揃うように可動部分をスライドさせて結果を読み取り、小数点の位置に注意する必要があります。おっと、本当に複雑すぎます!

計算尺

計算尺

それから約 300 年後の 1961 年、ベル パンチ カンパニーは最初のデスクトップ電子計算機「ANITA Mk VII」を発表しました。その後数十年にわたり、電子計算機はますます複雑になり、機能もさらに増えました。以前は手作業での計算が必要だった業務にかかる時間が短縮され、従業員はより分析的で創造的な作業に集中できるようになりました。したがって、現代の電子計算機は仕事の効率を高めるだけでなく、問題をより良く解決できるようにもします。

電卓は数学のやり方に大きな変化をもたらしましたが、言語についてはどうでしょうか?

文章をどのように構成するかを考えてください。まず、アイデア (この文が何を意味するか) を理解する必要があります。次に、たくさんの語彙をマスターする必要があります(十分な語彙を持ちます)。次に、これらの単語を正しく文に組み込むことができる必要があります(文法は必須です)。おっと、まだとても複雑です!

現生ホモ・サピエンスが初めて言語を生み出した5万年前から、言語の単語を生成する方法はほとんど変わっていません。

おそらく、私たちは文を組み立てる際に今でも計算尺を使うギュンターのようなものでしょう。

私たちはまだ、文章を生成する際に計算尺を使用していたギュンターの時代にあると言っても過言ではありません。

考えてみれば、適切な語彙と正しい文法を使用することは、言語の規則に従うことになります。

それは数学と似ています。数学にはルールがたくさんあるので、1+1=2 や電卓の仕組みを理解することができます。

言葉の計算機が必要です!

私たちに必要なのは電卓ですが、言葉は必要です。

確かに、言語が異なれば、異なるルールに従う必要がありますが、言語のルールに従うことによってのみ、その言語を理解することができます。言語と数学の明確な違いの 1 つは、数学には固定された確実な答えがあるのに対し、文に適合する妥当な単語が多数存在する可能性があることです。

次の文を入力してみてください: 私は _________ を食べました (私は _________ を食べました。) 次に出てくる単語を想像してください。英語には約 100 万語があります。ここでは多くの単語を使用できますが、すべてではありません。

「ブラック ホール」と答えることは、2+2=5 と言うのと同じです。また、「リンゴ」と答えるのは不正確です。なぜ?文法上の制約があるからです!

過去数か月の間に、大規模言語モデル (LLM) [2] が世界を席巻しました。これを自然言語処理分野における大きなブレークスルーと呼ぶ人もいますが、人工知能 (AI) の新時代の幕開けと考える人もいます。

LLM は人間のようなテキストを生成するのに非常に優れていることが証明されており、言語ベースの AI アプリケーションの水準を引き上げます。 LLM は、その膨大な知識ベースと優れた文脈理解により、言語翻訳やコンテンツ生成から、顧客サポートのための仮想アシスタントやチャットボットに至るまで、さまざまな分野に適用できます。

私たちは今、1960 年代に電子計算機が登場したときと同じような転換点を迎えているのでしょうか?

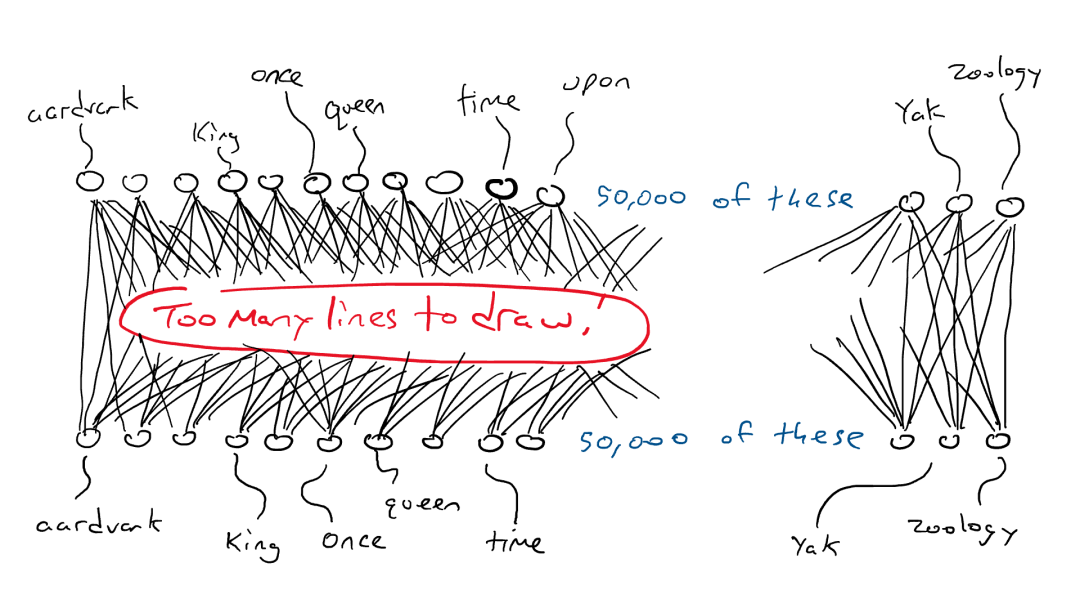

この質問に答える前に、LLM がどのように機能するかを理解しましょう。 LLM は Transformer ニューラル ネットワークに基づいており、文内で次に最適な単語を計算して予測するために使用されます。強力な Transformer ニューラル ネットワークを構築するには、大量のテキスト データでトレーニングする必要があります。これが、「次の単語またはトークンを予測する」アプローチが非常にうまく機能する理由です。簡単に入手できるトレーニング データが大量にあるためです。 LLM は、単語のシーケンス全体を入力として受け取り、次に可能性の高い単語を予測します。次に最も可能性の高い単語を学習するために、ウィキペディアのデータをすべてむさぼり、次に山積みの本をむさぼり、最後にインターネット全体をむさぼり食うことでウォーミングアップを行いました。

私たちは言語には規則とパターンが含まれていることを以前に確立しました。モデルは、これらすべての文を通じてこれらのルールを暗黙的に学習し、次の単語を予測するタスクを完了します。

ディープニューラルネットワーク

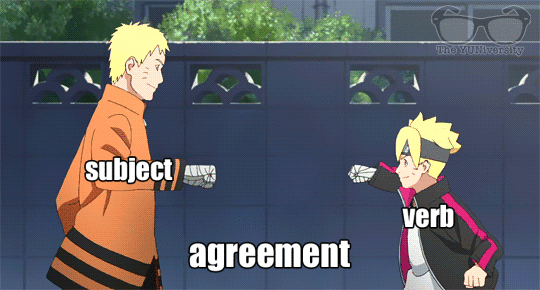

単数名詞の後、次の単語では動詞が「s」で終わる確率が高くなります。同様に、シェイクスピアの作品を読むと、「doth」や「wherefore」などの単語が出現する確率が高くなります。

トレーニング中に、モデルはこれらの言語パターンを学習し、最終的には言語の専門家になります。

しかし、それで十分でしょうか?言語のルールを学ぶだけで十分でしょうか?

しかし、それだけで十分でしょうか?言語規則を学ぶだけで十分ですか?

言語は複雑で、文脈に応じて単語が複数の意味を持つことがあります。

したがって、自己注意が必要です。簡単に言えば、自己注意とは、言語学習者が文や記事内の異なる単語間の関係を理解するために使用するテクニックです。ストーリーを理解するためにストーリーのさまざまな部分に注目するのと同じように、自己注意により、LLM は情報を処理するときに文内の特定の単語をより強調することができます。こうすることで、モデルは言語ルールのみに基づいて盲目的に次の単語を予測するのではなく、テキストの全体的な意味とコンテキストをよりよく理解できるようになります。

自己注意のメカニズム

大きな言語モデルを単に次の単語を予測する単語計算機として考えると、どうすればすべての質問に答えることができるでしょうか?

LLM が次の単語を予測するだけの単語の計算機である場合、どうやってすべての質問に答えることができるでしょうか?

思考を必要とするタスクの処理を大規模な言語モデルに依頼し、それが成功した場合、それはおそらく、ユーザーが与えたタスクを何千もの例の中で認識しているためです。たとえ次のような非常にユニークな要件がある場合でも、

「鶏を食べるシャチについて詩を書いてください」

鶏を食べるシャチについての詩を書いてください

大規模な言語モデルは、割り当てられたタスクを正常に完了することもできます。

波の真ん中、まだ見ぬ光景、シャチは素早く、鋭く狩りをする、海の王国でダンスが始まる、ニワトリの運命として、シャチが勝つ。

強大な顎で獲物を襲い、羽根が舞い、漂い、自然の成り行きで物語が紡がれる、生と死がひとつになる場所。

~ チャットGPT

悪くないですよね?これは、関連情報を効果的に融合および照合して、合理的で一貫した答えを構築できる自己注意メカニズムのおかげです。

大規模言語モデル (LLM) は、トレーニング中に、データ内の単語 (およびフレーズ) 間のパターン、関連付け、および関係を識別することを学習します。広範なトレーニングと微調整の後、LLM は言語翻訳、要約生成、質問応答、さらには創造的な文章などの新機能を発揮できるようになります。モデルには特定のタスクやスキルが直接教えられるわけではありませんが、大量のデータを学習してトレーニングすることで、モデルは予想を超える能力を発揮し、非常に優れたパフォーマンスを発揮できます。

では、大規模な言語モデルはインテリジェントなのでしょうか?

大規模言語モデルはインテリジェントですか?

電子計算機は 60 年以上前から存在しています。このツールはテクノロジーを「飛躍的に」進歩させましたが、決して賢いとは考えられていませんでした。なぜ?

チューリング テストは、機械が人間の知能を持っているかどうかを判断する簡単な方法です。機械が人間と区別できない方法で会話できる場合、その機械は人間の知能を持っていると考えられます。

電卓は人間と同じ言語を使用せず、数学的言語のみを使用して通信するため、チューリング テスト [3] を受けたことはありません。ただし、大規模な言語モデルは人間の言語を生成します。その訓練プロセス全体は、人間の音声を模倣することを中心に展開されます。したがって、それが「人間と見分けがつかないような方法で話す」ことができるのは驚くべきことではありません。

したがって、インテリジェンスの真の定義について明確なコンセンサスがないため、大規模な言語モデルを説明するために「インテリジェント」という用語を使用するのは少し困難です。何かがインテリジェントであるかどうかを判断する 1 つの方法は、何か興味深くて便利で、一定レベルの複雑さまたは創造性を備えた何かを実行できるかどうかです。大規模な言語モデルは確かにこの定義に当てはまります。ただし、私はこの解釈に全面的に同意するわけではありません。

私は知性を知識の境界を広げる能力と定義しています。

私はインテリジェンスを知識のフロンティアを拡大する能力と定義しています。

この記事の執筆時点では、次のトークン/単語を予測することで動作するマシンはまだ知識の境界を拡張できません。

ただし、既存のデータに基づいて推測して入力することはできます。言葉の背後にある論理を明確に理解することも、既存の知識体系を理解することもできません。革新的なアイデアや深い洞察を生み出すことはできません。比較的一般的な答えしか得られませんが、画期的なアイデアを生み出すことはできません。

機械が革新的な思考や深い洞察を生み出すことができないことに直面すると、それは私たち人間にどのような影響や影響を与えるのでしょうか?

では、これは私たち人間にとって何を意味するのでしょうか?

大規模言語モデル (LLM) は、単語の計算機としてもっと考える必要があります。 私たちの思考プロセスは大規模なモデルに完全に依存すべきではなく、代替品ではなく思考と表現の補助として見なされるべきです。

同時に、これらの大規模なモデルのパラメーターの数が指数関数的に増加するにつれて、私たちはますます圧倒され、理解できなくなったと感じるかもしれません。これに関する私のアドバイスは、一見無関係に見えるアイデアに対して常に好奇心を持ち続けることです。時々、私たちは一見関係のない、または矛盾したアイデアに遭遇しますが、観察、認識、経験、学習、他者とのコミュニケーションを通じて、これらのアイデアの間に何らかのつながりがあるかもしれない、またはこれらのアイデアが合理的であるかもしれないことがわかります。 (訳者注: このつながりは、私たちの観察、物事の理解と解釈、または異なる分野の知識と概念を関連付けることによって導き出された新しいアイデアから来ている可能性があります。私たちはオープンな心を保つ必要があります。表面的な直感に自分自身を限定するだけでなく、観察し、認識する必要があります。 、より深い意味とつながりを発見するために、経験し、学び、他者とコミュニケーションする)私たちは、既知の領域に留まることに満足するのではなく、積極的に新しい領域を探索し、常に認識の境界を拡大する必要があります。また、私たちは常に新しい知識、またはすでに取得した知識の新しい理解を追求し、それらを既存の知識と組み合わせて新しい洞察やアイデアを生み出す必要があります。

私が説明したように考え、行動することができれば、電卓であれ大規模な言語モデルであれ、あらゆる形態のテクノロジーが、心配する必要がある存続の脅威ではなく、活用できるツールになるでしょう。

終わり

参考文献

[2] https://en.wikipedia.org/wiki/Large_ language_model #:~:text=Large%20 language%20models%20(LLMs)%20are,MassiveText%2C%20Wikipedia%2C%20and% 20GitHub 。

[3] https://en.wikipedia.org/wiki/Turing_test

この記事は、原著者の許可を得て、Baihai IDP によって編集されました。翻訳を転載する必要がある場合は、許可を得るため当社までご連絡ください。

元のリンク:

https://medium.com/the-modern-scientist/large- language-models-a-calculator-for-words-7ab4099d0cc9

RustDesk、不正行為横行のため国内サービスを停止 Apple、M4チップを発売 タオバオ(taobao.com)、Webバージョンの最適化作業を再開 高校生が成人への贈り物として独自のオープンソースプログラミング言語を作成 - ネチズンの批判的なコメント:防衛 Yunfeng 氏は Alibaba を退職し、将来的には Windows プラットフォーム上で 独立したゲーム プログラマー向けの。 Visual Studio Code 1.89 は Java 17 をリリースします。これは、最も一般的に使用されている Java LTS バージョンです。Windows 10 の市場シェアは 70 です。 %、Windows 11 は減少し続ける。Google はオープンソースの Rabbit R1 を支持する。Haier Electric はオープン プラットフォームを閉鎖する。