新しい知識の効率的な統合: 大規模モデルの課題

大規模なモデル製品を使用している場合、よくある問題が発生することがあります。つまり、対話を複数回行うと、モデルが前回の対話内容を忘れてしまい、一貫性のない回答が得られる可能性があります。これは実際には、大規模なモデルが多くの新しいコンテンツに圧倒され、気が散るような印象を与えていることが原因です。

この問題は、実際には、現在の大規模モデルにとっての大きな課題でもあります。つまり、大量の新しい知識をモデルにどのように効果的に統合するかということです。現在の一般的なソリューションの 1 つは微調整ですが、この方法は多くのリソースと複雑なプロセスを必要とするだけでなく、新しい知識を統合する方法をモデルに常に明確に導くことができません。たとえば、「不思議の国のアリス」のようなテキストを微調整する場合、モデルはストーリー自体に関連する質問に答えることはできず、次の単語を予測するか、文を完成させることしかできません。この状況はイライラさせられます。

新しい知識を統合するための代替アプローチ: コンテキスト統合

微調整以外のもう 1 つの効果的な代替方法は、モデルのトレーニングを行わずに新しい知識をコンテキストに組み込むことです。ただし、このアプローチはモデル コンテキストの長さによって制限されます。大規模な知識データベースを処理するには、モデルはコンテキストの長さを数百万のトークンに拡張する必要がありますが、これは現実的には不可能です。強力な GPT-4 モデルでさえ、コンテキスト長はわずか 32K です。

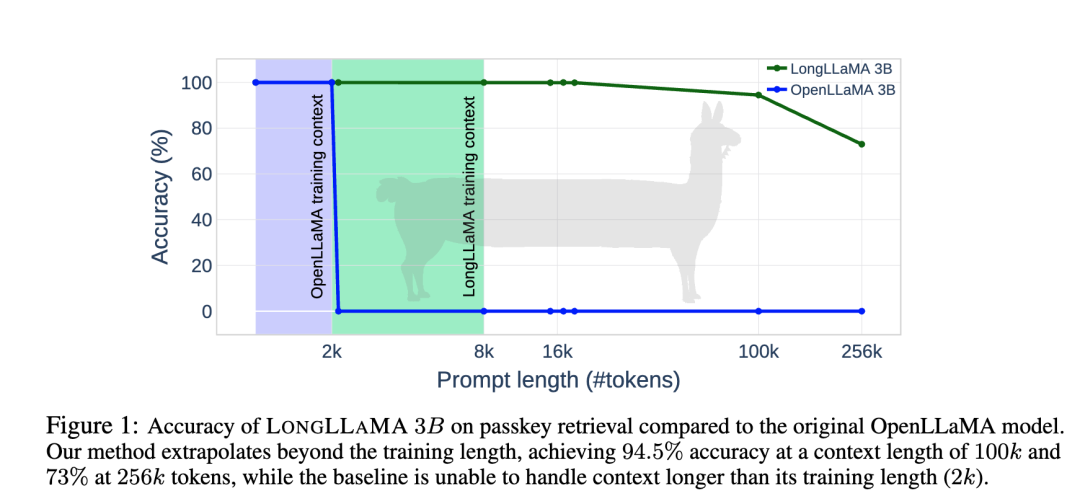

Google DeepMind 研究チームは最近、大規模モデルの気が散る問題を解決することを目的とした、「Focused Transformer」(FoT) と呼ばれる注意に焦点を当てた Transformer アーキテクチャを提案しました。彼らは FoT を使用して LLaMA モデルを微調整し、LLaMA と同じアーキテクチャを持つ LongLLaMA という名前のモデルを作成しました。LongLLaMA は、大規模モデルの注意散漫の問題を解決することで、モデルのコンテキスト長を大幅に改善し、パスキー取得タスクでは 256K の長さのコンテキストまで拡張することもできます。さらに重要なのは、LongLLaMA は標準の Transformer に非常に小さな変更を加え、他のタスクのために大規模な言語モデルにシームレスに切り替えることができることです。

Focused Transformer (FoT) は、注目に焦点を当てた Transformer アーキテクチャです。モデルの注意メカニズムを最適化することで、モデルが大量の新しい知識やコンテキスト情報をより適切に処理できるようになります。この革新的なテクノロジーの導入により、モデルは新しい知識を効果的に統合し、対話の一貫性を向上させることができます。

研究チームはFoTに基づいてLLaMAモデルを微調整し、LongLLaMAモデルを取得しました。LLaMA と比較して、LongLLaMA はコンテキスト長の処理において大幅な改善を実現します。パスキー取得タスクでは、LongLLaMA は最大 256K のコンテキスト情報を処理できますが、これは以前は達成が困難でした。

LongLLaMA-3B モデルの精度率は、コンテキスト長が 100k の場合は 94.5%、コンテキスト長が 256k に達すると精度率は 73% になりますが、標準の LLaMA-3B モデルは、コンテキスト長が 256k に達すると精度率が 0 に近くなります。長さは2kなので基本的には使い物になりません。

FoTの実装方法は非常にシンプルで、実は2022年にGoogleが提案したメモリ増設版のMemoryrizing Transormerとよく似ています。FoT はさらに、履歴情報のキーと値のペアを保存するために大規模なメモリを使用し、次に、対照学習のアイデアを使用してトレーニング段階でクロスバッチ トレーニングを使用し、大量の履歴情報をサンプルに統合して空間的情報を強化します。キーと値のペアの構造を変更することで、モデルが現在の問題に関連性の高い履歴情報にさらに重点を置くことができます。

LongLLaMA モデルの現在のコードと重みは、github と Hugging Face で公開されています。

論文リンク:

https://arxiv.org/pdf/2307.03170.pdf

プロジェクトアドレス:

https://github.com/CStanKonrad/long_llama

ハグフェイス:

https://huggingface.co/syzymon/long_llama_3b