大規模点群の弱教師付きセマンティック セグメンテーション

まとめ

- プロキシ タスクである点群の色付けは、自己教師あり学習を使用して、ラベルのない大きな点群から学習済みの事前確率を弱く教師ありのネットワークに転送するために構築されます。このようにして、異種タスクのガイダンスの下で、弱く監視されたネットワークの表現能力を向上させることができます。

- ラベル付けされていないデータの疑似ラベルを生成するために、生成されたクラス プロトタイプに基づくスパース ラベル伝播メカニズムが提案され、ラベル付けされていないポイントの分類信頼度を測定します。

本論文の方法

この方法は、知識の伝達とラベルの伝播を使用して、弱く監視された大規模な点群セグメンテーションの下でネットワークによって生成される不安定性と不十分な表現の問題を解決することを目的としており、次の 3 つの部分に分かれています。

- 事前知識を学習する自己管理型エージェント タスク

- 事前知識を使用した弱教師付きセマンティック セグメンテーション ネットワークの微調整

- 疎なラベルの伝播により、ラベルのないデータに疑似ラベルが生成され、弱い教師付きタスクの有効性が向上します.

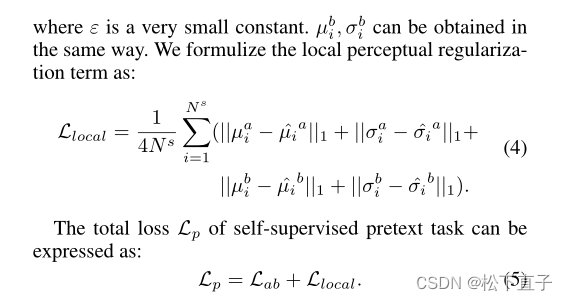

点群の色付けは、事前ベースの初期化分布を学習するための自己教師付きプロキシ タスクとして使用されます. コンテキスト情報を学習するために、ローカルを意識した正則化法が提案されています。次に、弱い教師ありネットワークがエンコーダーの事前トレーニング済みパラメーターで初期化され、特徴表現の有効性が向上します。

さらに、ラベル付けされたポイントを利用して、ネットワークを直接監視し、ネットワーク パラメータを微調整します。弱く教師ありセマンティック セグメンテーションのノンパラメトリック ラベル伝搬法も導入されています。一部のラベルのないポイントには、クラス プロトタイプ間の類似性を介して、疑似ラベルとラベルのないポイントの埋め込みが割り当てられます。したがって、トレーニングの効果を向上させるために、より多くの監督情報が導入されます。大規模な点群の計算効率とストレージ効率を考慮して、RandLA-Net をバックボーンとして選択します。これは、大規模な点群のセマンティック セグメンテーションのための効率的で軽量なニューラル アーキテクチャです。以下では、自己教師ありの口実タスクと疎なラベルの伝播方法について説明します。

自己管理エージェント タスク

2D ビジョン タスクのゼロからのトレーニングとは異なり、カラー化は強力な監視信号を提供します。トレーニング データは簡単に収集できるため、任意の色の点群をトレーニング データとして使用できます。点群取得装置の進歩により、色情報を持つラベルのない大量の点群データにアクセスできるようになりました。点群の色付けの自己教師あり学習をプロキシ タスクとして研究し、実装します。ポイント カラーリングの目的は、自己教師ありモデルが特徴表現を学習するように導くことです。Lab色空間は距離の認識に適しています

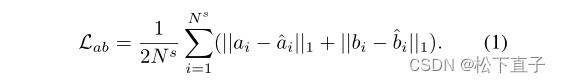

したがって、この色空間で a、b 補完を介して点群の色付けを実行します。輝度チャネル L が与えられると、ネットワークは a と b のカラー チャネル、および各点のローカル ガウス分布を予測します。セグメンテーション タスクへの入力と同じ次元を維持するために、チャネル L の値が各ポイントで 3 倍に複製されることに注意してください。したがって、入力点群 Xs = [x1, x2, ...], xN s] ∈ RN s × 6 は、座標 xyz の N 個の 3D 点で構成されます。ここで、3 l は点群内の点の数です。

さらに、最終出力層を変更することにより、自己教師ありタスクに RandLA-Net を実装します。つまり、このネットワークの出力は、予測された a、b、および対応する局所平均と分散を含む 6 次元ベクトルです。

ここで、a、b、µ、および σ は、予測された a、b、および対応するローカル平均と分散をそれぞれ示します。

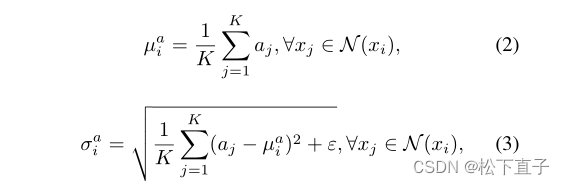

さらに、各ポイントのローカル カラー分布を学習するために、ローカルを意識した正則化用語を導入します。ネットワークが近隣の色分布 (平均と分散) を予測できる場合、セグメンテーション タスクと一致するローカル情報を使用して、弱く監視されたセマンティック セグメンテーションのローカル機能を埋め込むことができます。点 xi を重心として指定すると、ユークリッド距離に従って KNN によって局所近傍 N(xi) が計算されます。チャネルの標準値 µai と σai は、次のように指定できます。

プロキシ タスクから学んだ知識がセマンティック セグメンテーションに役立つのはなぜですか?

プロキシ タスクは、セマンティック セグメンテーション タスクと同様の特徴分布を学習します。同じカテゴリのオブジェクトは通常、同様の色分布を持ちます (たとえば、植生は通常緑で、道路は黒です)。シーンの表面の色のテクスチャは、多くのカテゴリに十分な手がかりを提供します。

プロキシ タスクは、ローカル フィーチャ リプレゼンテーションを埋め込みます。局所的な色分布を元の分布と一致するように制約するために、局所性を意識した正則化用語を導入します。したがって、ネットワークはより多くのローカル情報を埋め込むことができます。したがって、セマンティック セグメンテーション タスクでローカル機能の埋め込みを強化できます。

スパース ラベルの伝播

ラベル付けされたポイントが少ない場合、セグメンテーションのパフォーマンスは大幅に低下します。主な理由は、いくつかのラベル付きポイントによって提供される監視情報が、ラベルなしポイントに十分に伝播できないことです。したがって、ラベル付けされたポイントを使用して、ラベル付けされていないポイントに疑似ラベルを割り当て、さらに追加の管理情報を提供して、監視が不十分なネットワークの表現を改善します。

この目標を達成するには、次の側面を考慮する必要があります。1) 計算の複雑さが高くなく、メモリ リソースが大きくない。通常、大規模な点群には最大 106 個の点が含まれており、すべての点をノードとして使用して完全に接続されたグラフを作成すると、大量のメモリとコンピューティング リソースが消費されます。2) アンカー ポイントはまばらにする必要があります。一部のあいまいなポイントには、ネットワークをトレーニングするためにラベルを付けるべきではありません。3) スプレッドラベルはソフトであるべきです。伝播されたラベルは、それらの類似性に関連している必要があります。類似性が高いほど、ラベルは類似しています。

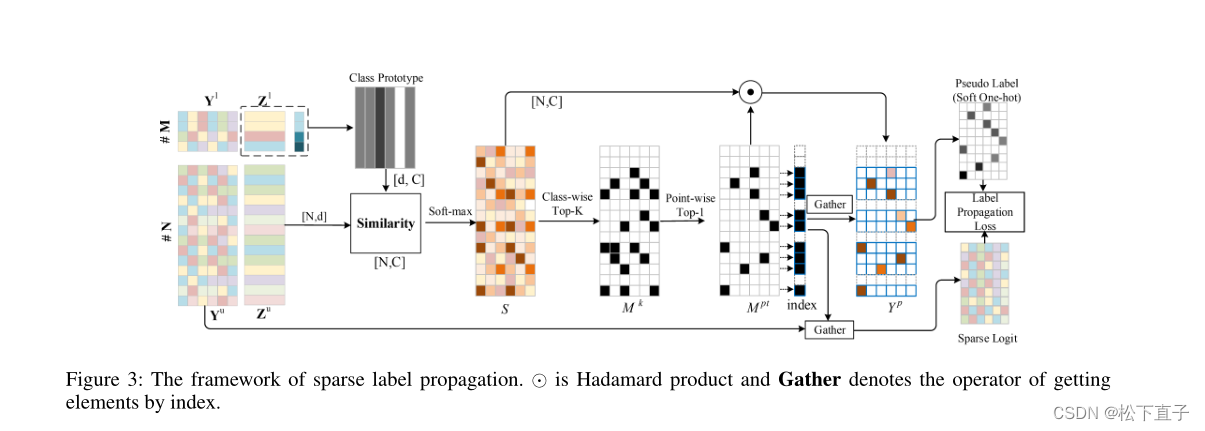

まばらなラベル伝播方法が設計されています。全体の枠組みを図に示します。これは、クラス プロトタイプの生成、クラス割り当てマトリックスの構築、スパース疑似ラベルの生成の 3 つの部分で構成されます。

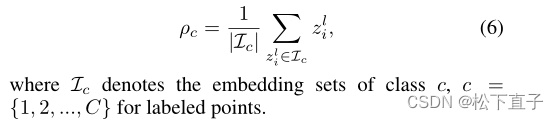

クラス プロトタイプの生成

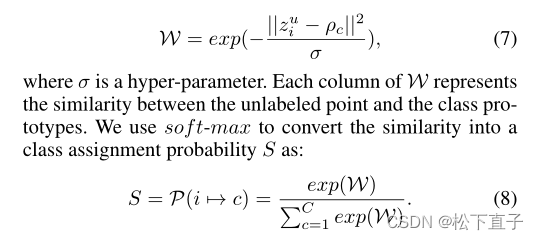

ネットワークの最後の 2 層では、埋め込み Z = [zl1, zl2,..., zlM;Zu1, zu2,..., zuN]∈R(M+N)×d を出力し、対応する予測 Y = [yl1, yl2,...,ylM;Yu1,yu2,...,yuN]∈R(M+N)×C は、M 個のラベル付き点と N 個のラベルなし点から得られます。ラベル付けされた点とラベル付けされていない点の埋め込みをそれぞれ Zl、Zu で表します。クラス C を表すラベル付きポイントから C プロトタイプが最初に生成されます。具体的には、各クラスの Zl を埋め込んだラベル付きポイントの平均を取ります。クラス c の場合、プロトタイプ ρc は

次の

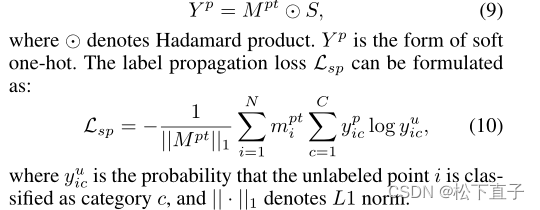

ようになります。これらのポイントは、ネットワークをトレーニングするための監視された情報を提供するのには適していません。具体的には、クラスごとに、クラス割り当て行列 S に従って、最初の k 個のマークされていない点が選択され、マスク Mk∈{0,1}N×C が取得されます。ここで、mkic = 1 は、i 番目の点の埋め込みを意味します。は、最初の k ポイントと同様にクラス c と一致します。N は、マークされていないポイントの数です。これは、クラスの不均衡をある程度緩和できるクラス数のバランスをとったラベル拡張方法です。ラベルのないポイントは複数のクラスに属する可能性があるため、最も類似したクラスを選択してバイナリ マスクを生成します。Mk から点マスク Mpt ∈ {0,1}N を得る。MPTi = 1 は、I 番目のポイントに疑似ラベルが割り当てられていることを意味します。まばらな疑似ラベル Y p ∈ RN×C は、次の方法で取得できます。従来の全結合グラフ ラベル伝搬法と比較して、この方法は計算効率が高くなります。この方法の複雑さは O(N Cd) ですが、全結合グラフ法の複雑さは O((N + M)2d) です。C はカテゴリの数、d は先祖の次元です。C の大きさは ~101 であり、N よりもはるかに小さい損失関数です。

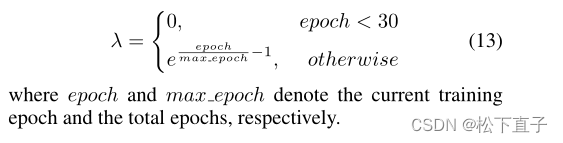

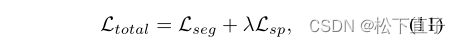

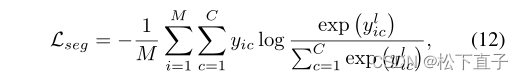

これら 2 つの損失のバランスを取るために、非線形パラメーター λ が導入されます。