1.準備作業

2.時刻の同期

アイデア:マスターノードが外部ネットワークに接続する時間、およびスレーブノードがマスターノードにのみ接続する時間は、3台のマシンの時間と同じ目的を達成します。

2.1マスターノードの時刻同期

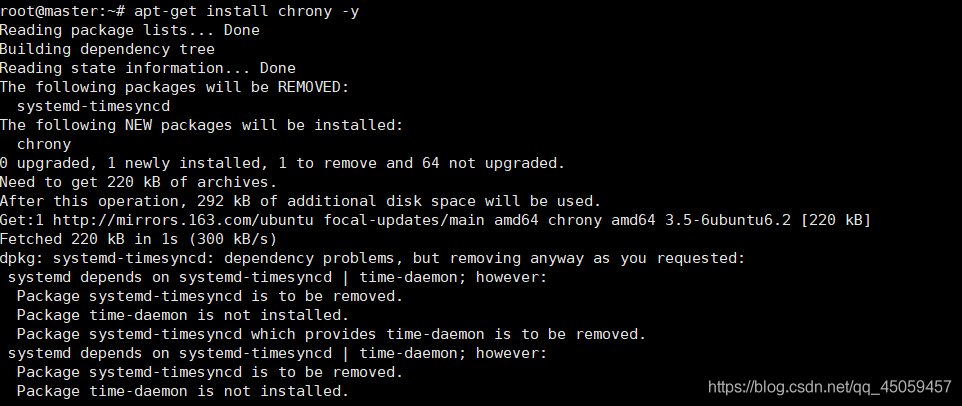

2.1.1ソフトウェアパッケージをインストールします

apt-get install chrony -y

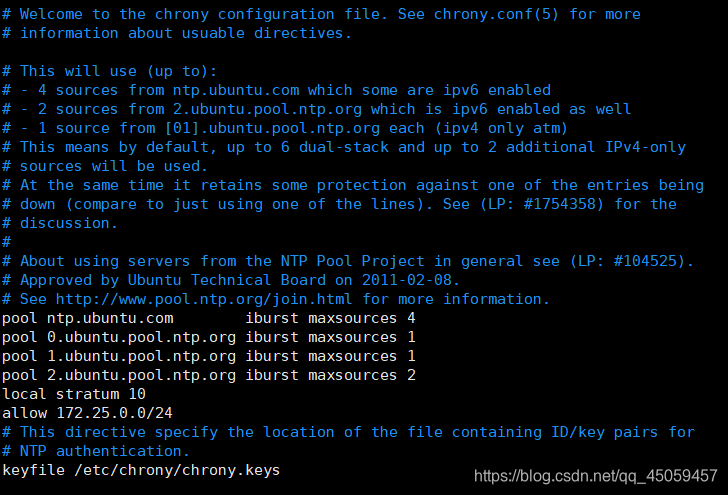

2.1.2 / chrony.confを編集します

vi /etc/chrony/chrony.conf

add

local stratum 10

allow 172.25.0.0/24

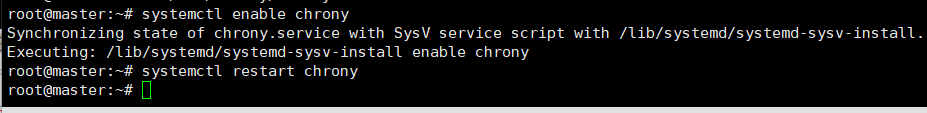

2.1.3NTPサービスの開始をアクティブ化する

systemctl enable chrony

systemctl restart chrony

2.2スレーブノードの時刻同期

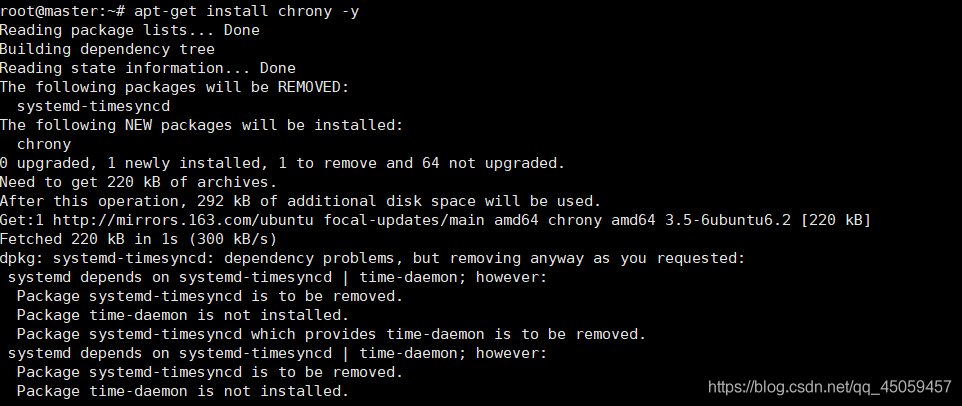

2.2.1ソフトウェアパッケージをインストールします

apt-get install chrony -y

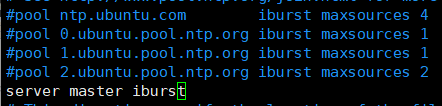

2.2.2 / chrony.confを編集します

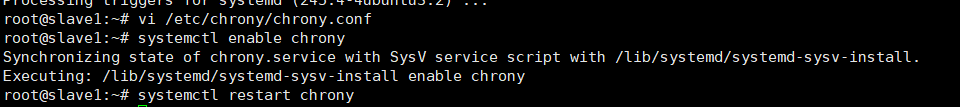

vi /etc/chrony/chrony.conf

これらの4行にコメントし、サーバーマスターiburstを追加します

2.2.3NTPサービスの開始をアクティブ化する

2.3テストが成功したかどうか

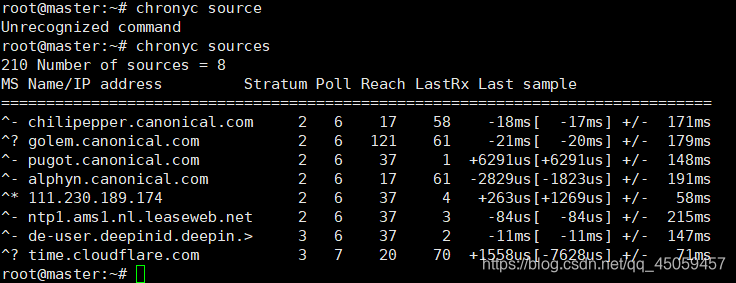

2.3.1マスターノードテスト

chronycソース

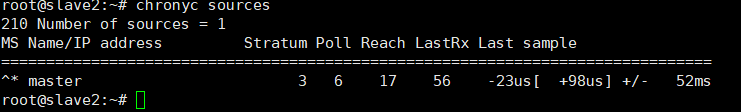

2.3.2スレーブノードテスト

この時点で、NTPは完了です。

3.パスワードなしのSSH設定

目的は、編集したドキュメントをスレーブノードに送信することです

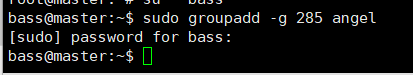

3.1すべてのノードのグループを作成する

sudo groupadd -g 285 angel

(bassの通常のユーザーの下で操作でき、rootユーザーの下で操作できます。bassでsudoの特権を増やす必要がある場合、rootユーザーはそれを必要としません。)

285はグループです。番号、および天使はグループ名です。

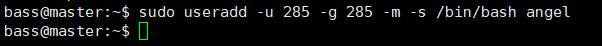

3.2すべてのノードのユーザーを作成する

$ sudo useradd -u 285 -g 285 -m -s / bin / bash angel

ユーザー番号は285、ユーザーグループ番号は285、ユーザー名はangelです。

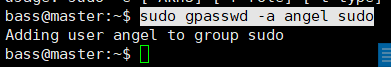

3.3エンジェルユーザーのパスワードを設定する

sudo gpasswd -a angel sudo

は、angelユーザーをsudoグループに追加します。

sudo passwdangelの

パスワードは123です

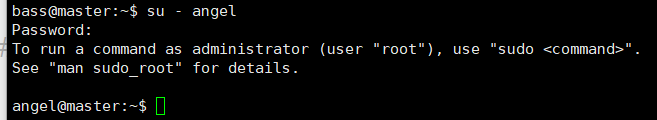

3.4エンジェルユーザーの切り替え

su-angel

パスワード:123

3.5証明書を生成します(マスターノードで操作します)

ssh-keygen -t rsa

暗号化アルゴリズムの選択rsa、

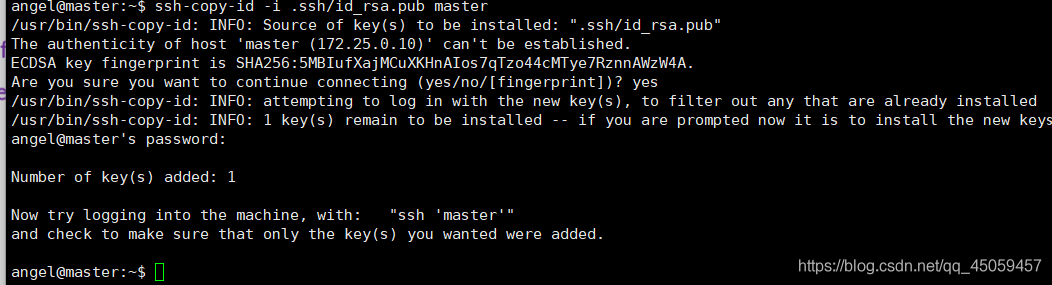

3.6公開鍵をすべてのポイントにコピーする

3.6.1マスターノード

ssh-copy-id -i .ssh /id_rsa.pubマスター

はい

パスワード:123

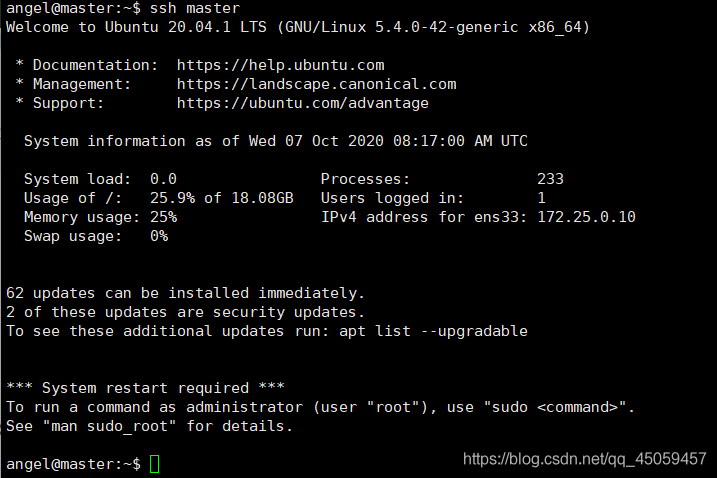

3.7テスト

ssh master

ctrl + D exit

logout

3.7.1マスターノードでのスレーブノードへの接続

ssh slave1

ssh slave2

4.Javaのインストール

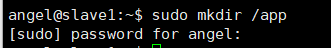

4.1すべてのノードのアプリディレクトリを作成する

angelユーザーの下に

sudomkdir / app

sudo chown -R angel:angel / appを作成します

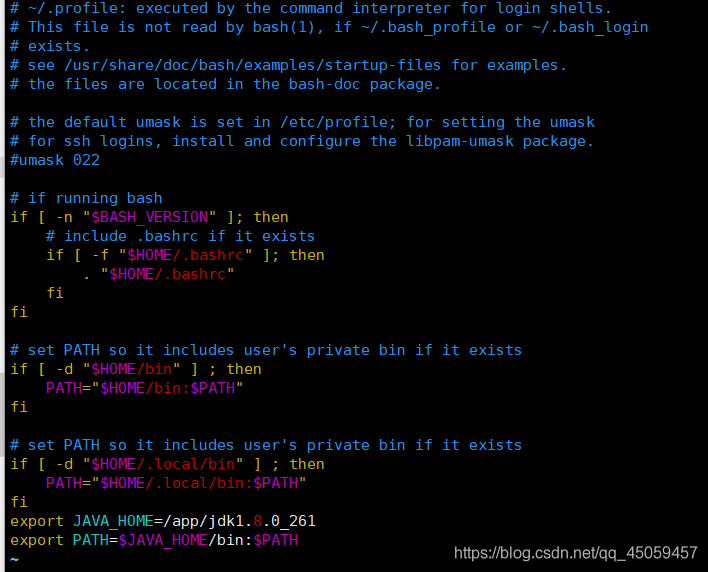

4.2すべてのノードのjdk環境変数を編集する

vi / home / angel / .profile最後

に2行追加

4.3すべてのノードjdk環境変数が有効になります

ソース/home/angel/.profile

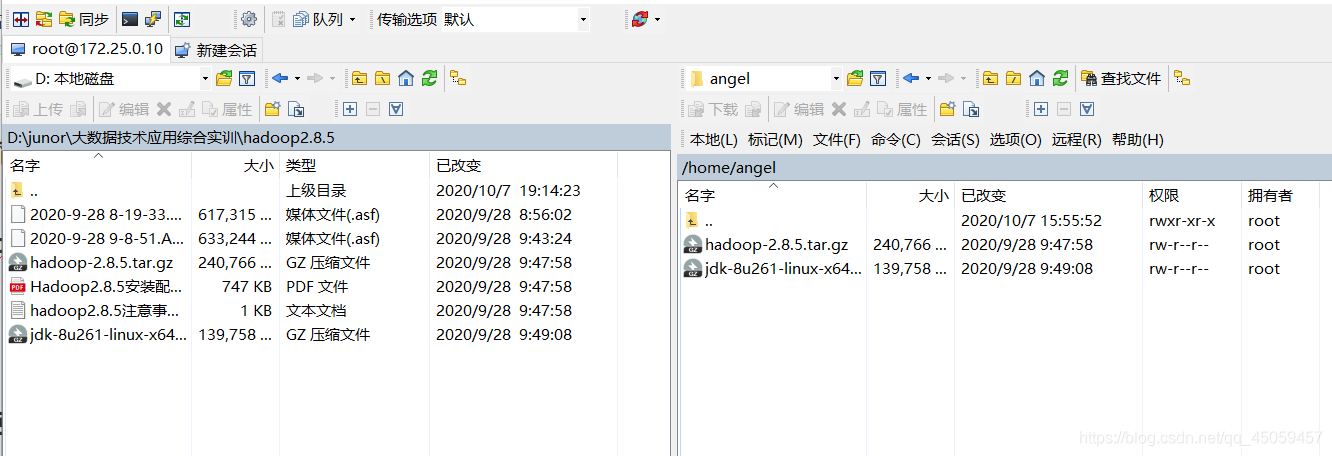

4.4jdk圧縮をangelユーザーにアップロードする

4.4.1winscpツールを使用してrootユーザーとしてログインします

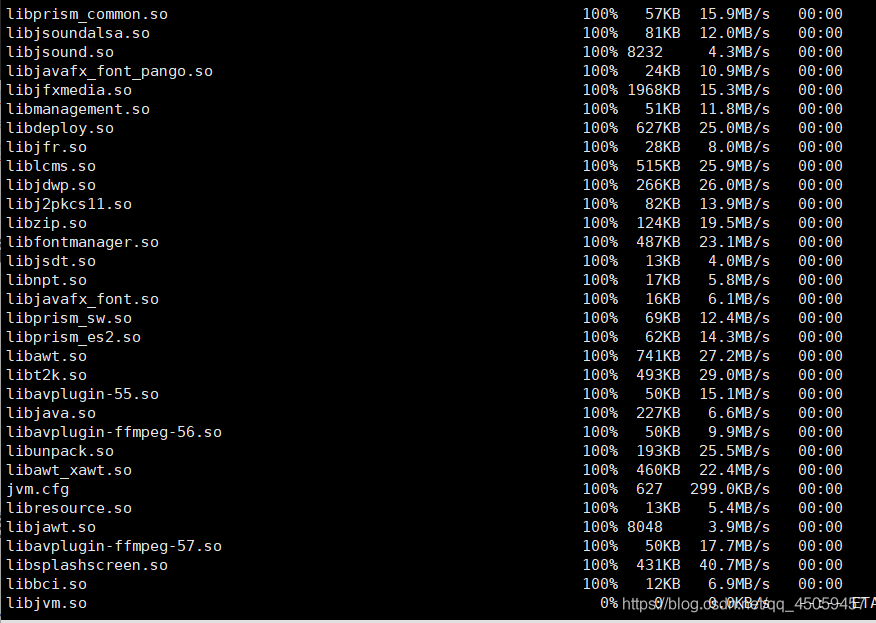

4.5 jdk圧縮パッケージを解凍し、/ appディレクトリに配置します

cd / app

tar xzvf /home/angel/jdk-8u261-linux-x64.tar.gz -C / app

5. / appのコンテンツをスレーブノードに配信します

scp -r / app / * angel @ slave1:/ app

scp -r / app / * angel @ slave2:/ app

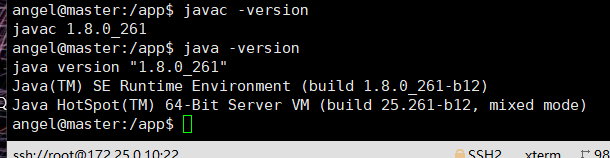

6テスト

java -version

javac -version

7Hadoopのインストール

7.1Hadoopパッケージをエンジェルユーザーにアップロードする

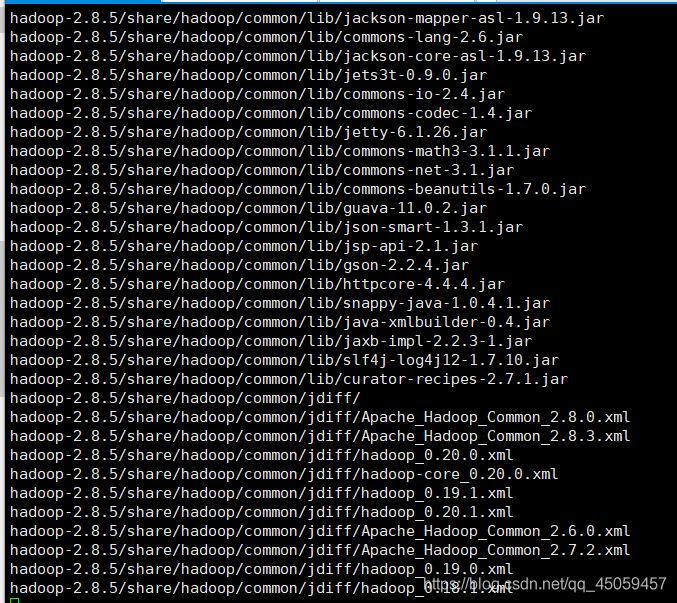

tar xzvf /home/angel/hadoop-2.8.5.tar.gz -C / app

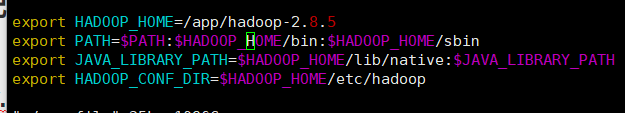

7.2すべてのノードのHadoop環境変数を編集する

vi /home/angel/.profile

追加:

export HADOOP_HOME=/app/hadoop-2.8.5

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

export JAVA_LIBRARY_PATH=$HADOOP_HOME/lib/native:$JAVA_LIBRARY_PATH

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

7.3Hadoop環境変数はすべてのノードで有効になります

ソース/home/angel/.porfile

7.4Hadoop構成ファイルの変更

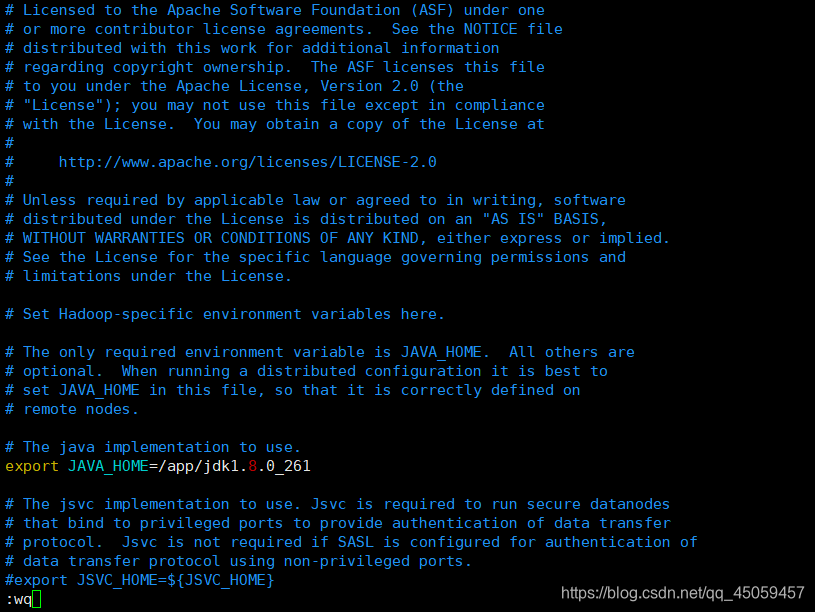

7.4.1 hadoop-env.sh

vi /app/hadoop-2.8.5/etc/hadoop/hadoop-env.sh

export JAVA_HOME=/app/jdk1.8.0_261

7.4.2 core-site.xml

vi /app/hadoop-2.8.5/etc/hadoop/core-site.xml

<property>

<name>fs.defaultFS</name>

<value>hdfs://master:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/tmp/hadoop-2.8.5</value>

</property>

<property>

<name>hadoop.proxyuser.angel.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.angel.groups</name>

<value>*</value>

</property>

7.4.3 hdfs-site.xml

vi /app/hadoop-2.8.5/etc/hadoop/hdfs-site.xml

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/app/hadoop-2.8.5/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/app/hadoop-2.8.5/dfs/data</value>

</property>

7.4.4 mapred-site.xml

最初にmapred-site.xml.templateをコピーし、mapred-site.xml

cp / app / hadoop-2.8.5 / etc / hadoop / mapred-site.xml.template / app / hadoop-2.8.5 / etc / hadoopという名前を付けます。 /mapred-site.xml

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>master:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>master:19888</value>

</property>

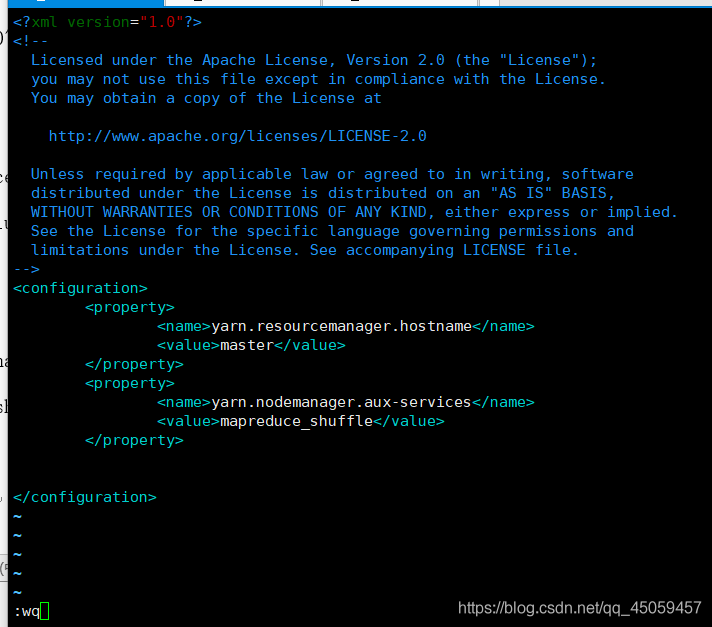

7.4.5yarn-site.xml

vi /app/hadoop-2.8.5/etc/hadoop/yarn-site.xml

<property>

<name>yarn.resourcemanager.hostname</name>

<value>master</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

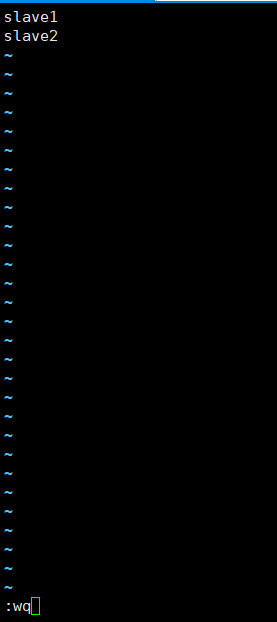

7.4.6スレーブ

vi /app/hadoop-2.8.5/etc/hadoop/slaves

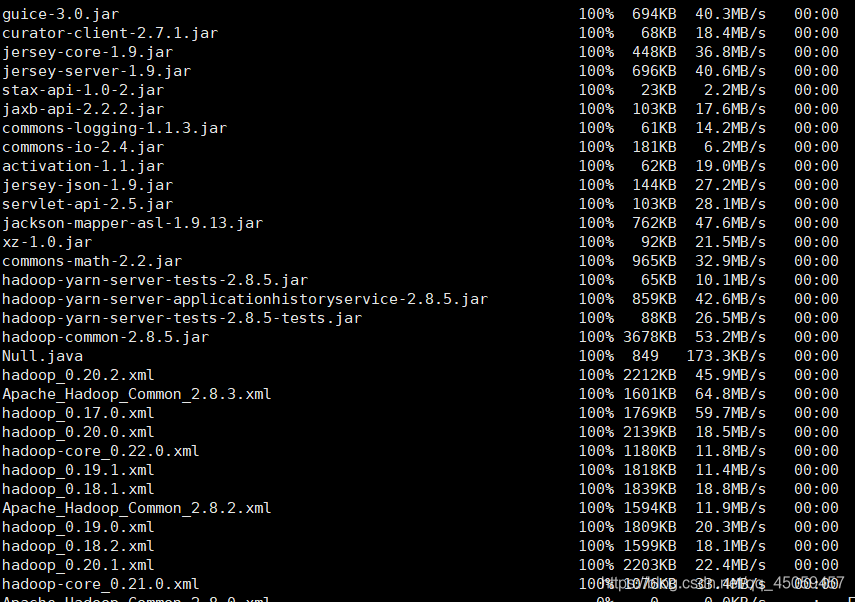

7.5スレーブノードにコピー

scp -r /app/hadoop-2.8.5/ angel @ slave1:/ app

scp -r /app/hadoop-2.8.5/ angel @ slave2:/ app

配信が完了するまで辛抱強く待ちます

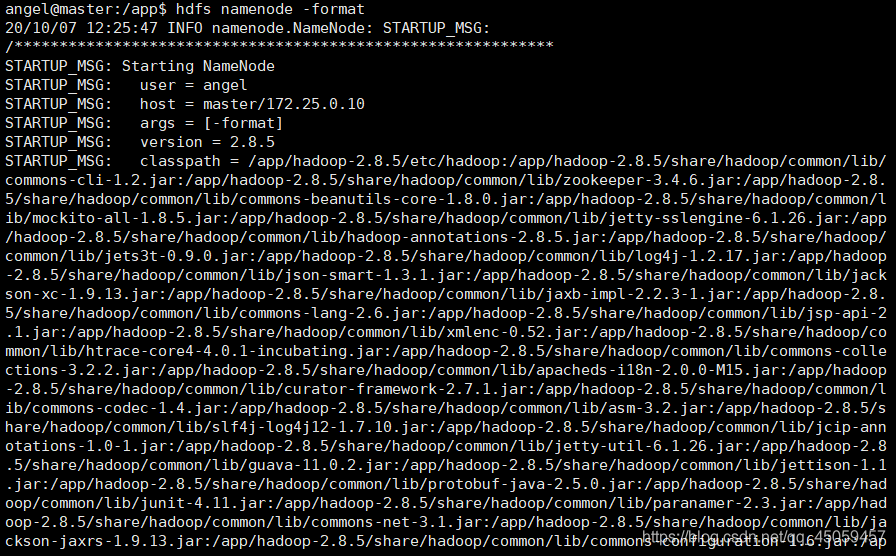

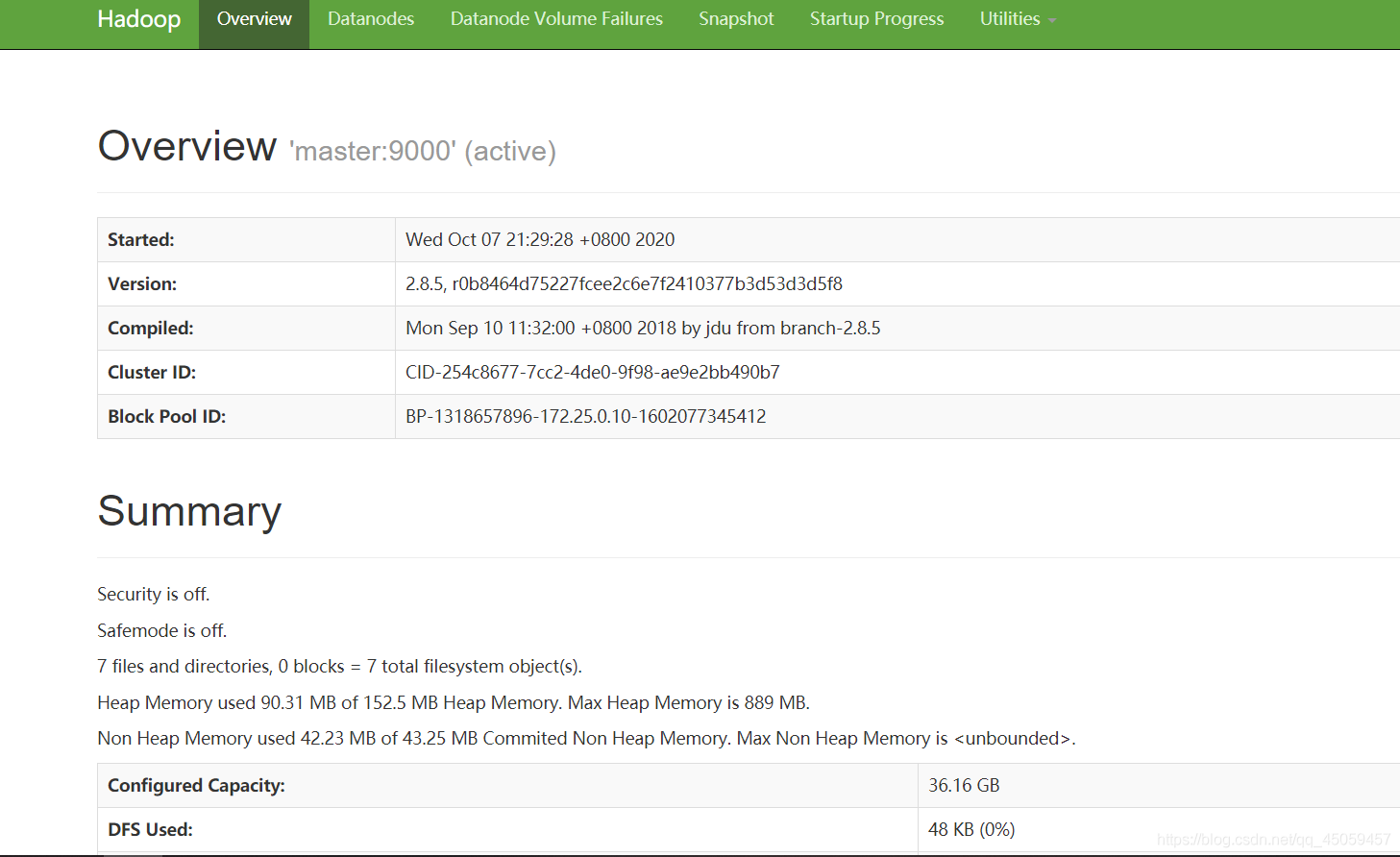

8.Hadoopの起動

8.1フォーマットnamenode

hdfsの目的-フォーマット

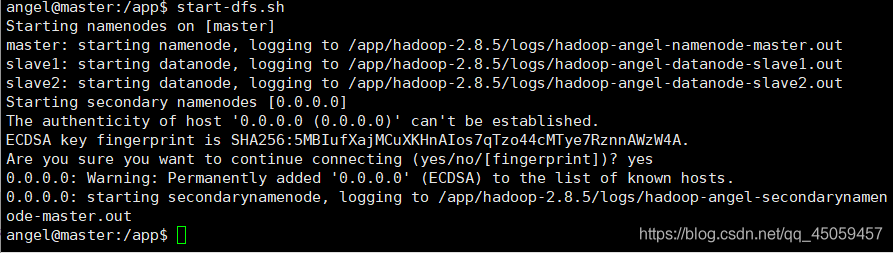

8.2Hadoopを開始する

start-dfs.sh

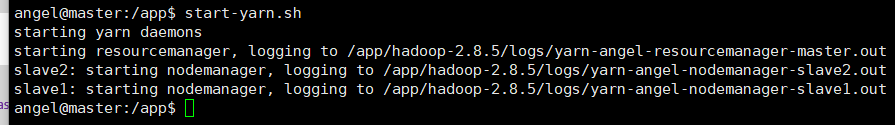

8.3スタートヤーン

start-yarn.sh

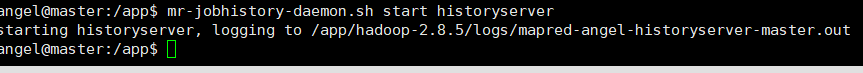

8.4JobHistoryServerを起動します

mr-jobhistory-daemon.sh start historyserver

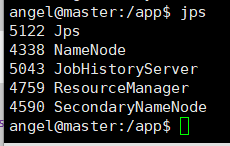

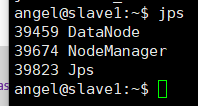

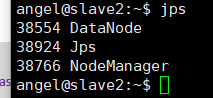

8.5プロセスの表示

8.5.1マスターノード

jps

8.5.2 slave1、slave2ノード

jps

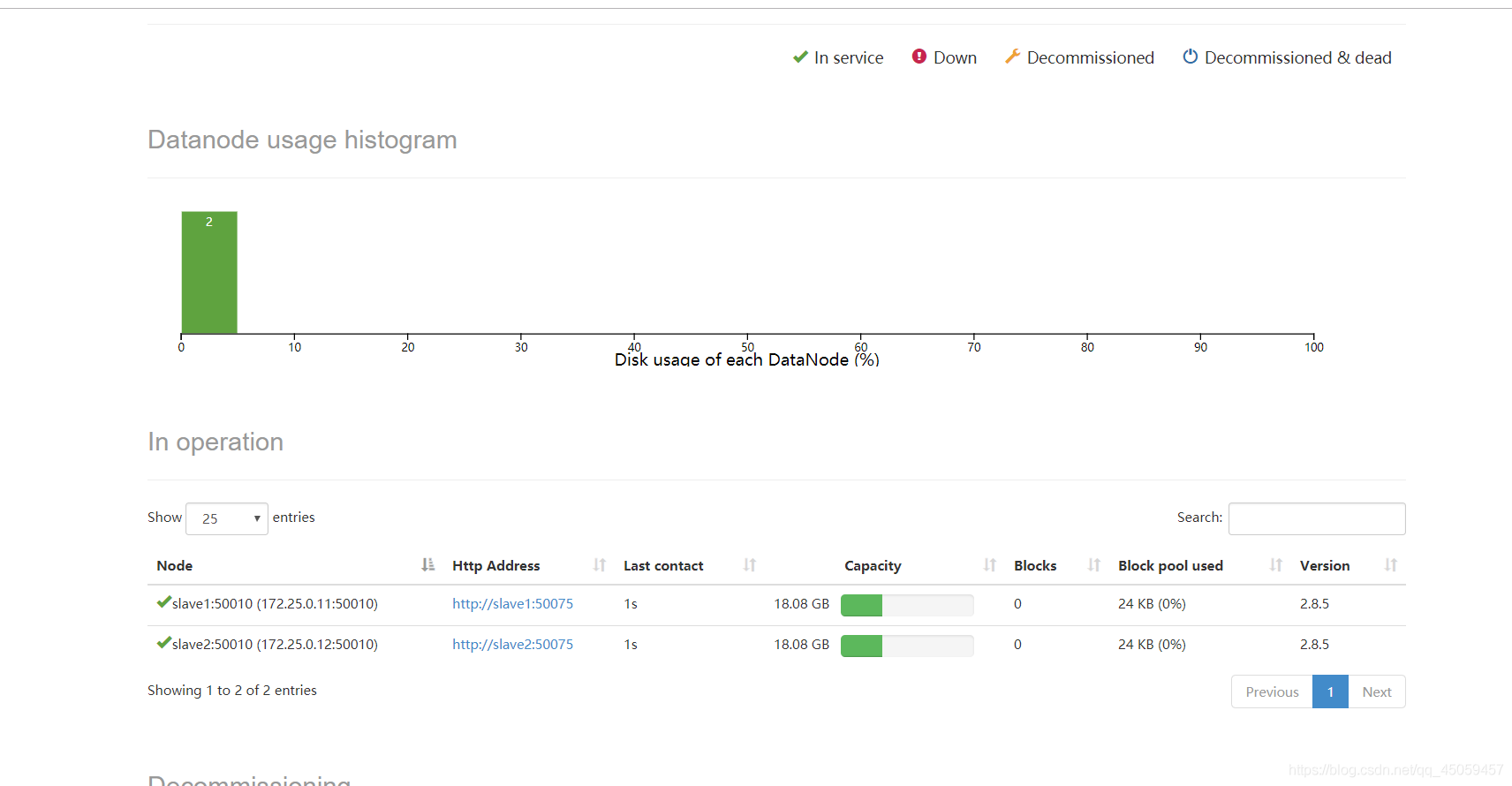

2つのライブノードがあり、ポート番号50070と8088が

このHadoop環境で正常に構成されています。