著者:Ben Dickson(ソフトウェアエンジニア、TechTalks創設者)

翻訳者:hhhnoone

原文:ディープラーニングはブラックボックスである必要はありません

ディープニューラルネットワークの成功は、その非常に大きく複雑なパラメータネットワークによるものですが、この複雑さはいくつかの欠点ももたらしました。ニューラルネットワークの内部動作は、通常、作成者にとってさえ謎です。2010年代初頭にディープラーニングが普及して以来、この問題は人工知能コミュニティを悩ませ続けています。

さまざまな分野でのディープラーニングの適用と拡大に伴い、ニューラルネットワークの結果と学習パラメーターを検証することでニューラルネットワーク(内部動作原理)を解釈できるテクノロジーに人々はますます関心を持っています。

最近、Nature Machine Intelligenceが発表した論文で、有望な新しい方法が紹介されました。デューク大学の科学者は、パフォーマンスを犠牲にすることなく特定の概念を学習するように神経ネットワークを導くのに役立つ「概念ホワイトニング」と呼ばれる手法を提案しました。概念のホワイトニングは、トレーニングされた何百万ものパラメーターの中から答えを検索する代わりに、深層学習モデルに解釈可能性をもたらし、有望な結果を示します。

深層学習モデルの機能と隠れた空間

十分に高品質のトレーニング例がある場合、合理的なアーキテクチャを備えた深層学習モデルは、さまざまなタイプの入力を区別できるはずです。たとえば、コンピュータビジョンタスクでは、訓練されたニューラルネットワークが画像のピクセル値を対応するカテゴリに変換できるようになります。ホワイトニングの概念は、画像認識のコンテキストで提案されています。

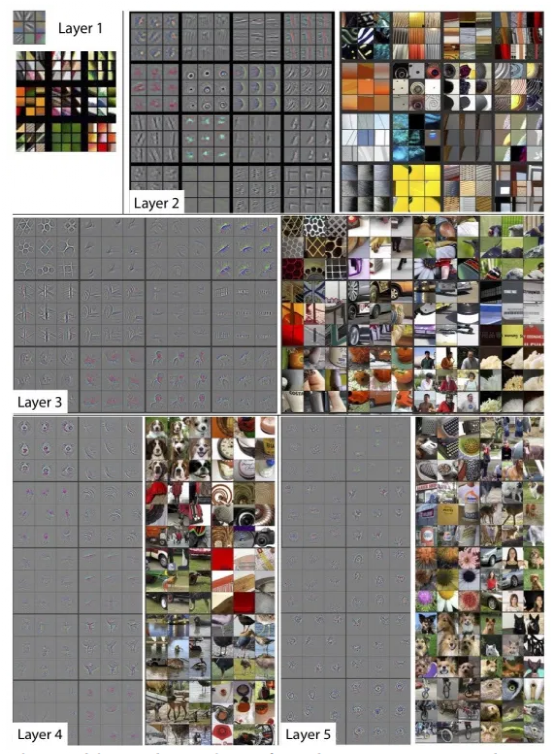

トレーニングプロセス中に、深層学習モデルの各レイヤーは、トレーニング画像の特性を値のセットにエンコードし、それらをパラメーターに格納します。これは、AIモデルの潜在空間と呼ばれます。一般的に、多層畳み込みニューラルネットワークの下位層はコーナーやエッジなどの基本的な特徴を学習し、高レベルのニューラルネットワークは顔、オブジェクト、完全なシーンなどのより複雑な特徴を検出することを学習します。 。

図:ニューラルネットワークの各層は、入力画像の特定の特性をエンコードします

理想的には、ニューラルネットワークの潜在空間は、ニューラルネットワークによって検出される画像カテゴリに関連するいくつかの概念を表しますが、通常、これを明確に認識することはできず、深層学習モデルは最も認識可能な特徴を学習する傾向があります。これらの特性は間違っています。

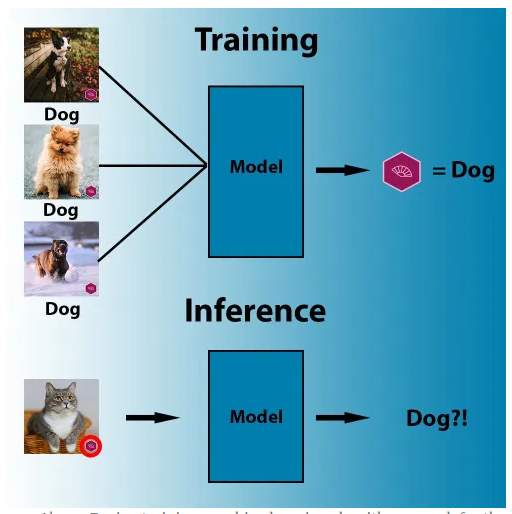

たとえば、次のデータセットには子猫を含むいくつかの画像が含まれており、右下隅に正確にロゴがあります。ロゴはターゲットとは関係がないと簡単に考えて無視できますが、深層学習モデルでは、右下隅のロゴが猫と他の動物を区別するための最も簡単で効果的な方法であることがわかります。同様に、トレーニングセット内のすべての羊の画像に大きな緑の牧草地が含まれている場合、ニューラルネットワークは羊の代わりに緑の牧草地を検出することを学習する可能性があります。

図:トレーニング中、機械学習アルゴリズムは、ピクセルをラベルに関連付ける最も識別可能な機能を検索します。

したがって、トレーニングおよびテストデータセットでの深層学習モデルのパフォーマンスに加えて、検出することを学習した概念と機能を理解することも重要です。ここで、古典的な解釈手法が役立ちます。

ニューラルネットワークの帰属

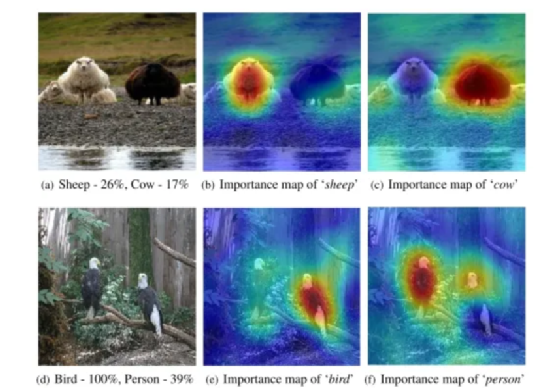

多くの深層学習手法は事後的です。つまり、出力とパラメーター値をチェックすることにより、トレーニングされたニューラルネットワークを意味のあるものにしようとします。たとえば、一般的な手法は、入力画像のさまざまな部分をマスクして、ニューラルネットワークが画像内で何を見ているか(画像のどの部分または特徴がニューラルネットワークによって理解されているか)を判断し、これらの変更がの出力にどのように影響するかを観察することです。ディープラーニングモデル、このテクノロジーは、ニューラルネットワークにより関連性のある画像の特徴を強調するために使用できるヒートマップ(ヒープマップ)の作成に役立ちます。

図:フィーチャマップの例

他の後知恵の手法には、さまざまな人工ニューロンのオンとオフを切り替えたり、これらの変更がAIモデルの出力にどのように影響するかを調べることが含まれます。これらの方法は、機能と隠しスペースの関係を発見するのに役立ちます。これらの方法は役立ちますが、それでも深層学習モデルをブラックボックスとして扱い、ニューラルネットワークがどのように機能するかを明確に説明することはできません。

既存の解釈方法は通常、モデル計算の実際の解釈ではなく、パフォーマンスの要約統計量(たとえば、局所近似、ノードアクティブ化の一般的な傾向)です」と、コンセプトホワイトニングペーパーの著者は書いています。たとえば、機能マップの問題は次のとおりです。 、ニューラルネットワークが学習した可能性のある間違った内容を表示できないことがよくあります。ニューラルネットワークの特性が隠れた空間に散在していると、単一のニューロンの役割を説明することが非常に困難になります。

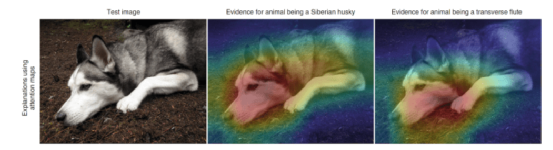

図:機能マップの説明は、ブラックボックスAIモデルがどのように機能するかを正確に説明していません。

デューク大学のコンピューターサイエンスの博士課程の学生であり、コンセプトホワイトニングペーパーの最初の著者であるZhi Chenは、次のように述べています。「ディープニューラルネットワーク(DNN)は、画像認識の分野で非常に強力ですが、その複雑さのために、あなたが学ぶことはDNNの隠れ層では不明です。解釈可能性の欠如により、ニューラルネットワークは信頼できず、トラブルシューティングが困難になります。」これまでの多くの研究では、各ニューロンが学習した概念など、ニューラルネットワークモデルが学習したことを説明しようとしましたが、これらは作品は、これらの概念が実際にはニューラルネットワークによって学習され(実際には学習されない)、単一のニューロンに集中しているという仮定に大きく依存しています。

デューク大学のコンピューターサイエンスの教授であるCynthiaRudin(Cynthia Rudin)は、コンセプトホワイトニングペーパーの共著者であり、ブラックボックス解釈手法を信じることの危険性について以前に警告し、このアプローチが誤っている可能性があることを示しました。ニューラルネットワークの説明。ジャーナルNatureMachine Intelligenceに以前に掲載された別の論文で、Rudinは、固有の解釈可能性を備えたAIモデルの使用と開発を奨励しました。

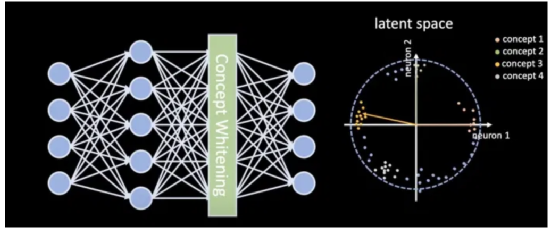

今回提案されたコンセプトホワイトニングは、ニューラルネットワークの隠れた空間をいくつかのコンセプトと整合させることを目的としており、これらのコンセプトがニューラルネットワークの目標です。この方法により、深層学習モデルが解釈可能になり、入力画像の特性とニューラルネットワークの出力との関係を見つけやすくなります。ルーディン氏は次のように述べています。「私たちの仕事は、ニューラルネットワークを直接変更して、隠れた空間を切り離し、軸を既知の概念に合わせます。」

深層学習モデルは通常、単一のラベル付きサンプルデータセットでトレーニングされます。概念のホワイトニングは、概念的な例を含む別のデータセットを導入します。これらの概念は、AIモデルの主なタスクに関連しています。たとえば、深層学習モデルが主に寝室の検出に使用される場合、関連する概念には、ベッド、ライト、窓、ドアなどが含まれます。

「代表的なサンプルは、解釈可能性の定義を構成する可能性があるため、手動で選択できます。機械学習の実践者は、これらのサンプルを任意の方法で収集して、アプリケーションに適した概念データセットを作成できます。たとえば、医師に選択を依頼できます。医療概念(データセット)を定義するための代表的なX線画像。」

コンセプトのホワイトニングを通じて、チームはディープラーニングモデルの2つの並行トレーニングサイクルを実施しました。ニューラルネットワークが全体的なパラメーターを調整してメインタスクのカテゴリを表すと、コンセプトホワイトニングは各レイヤーの特定のニューロンを調整して、これらのニューロンをコンセプトデータセットに含まれるカテゴリに合わせます。

その結果、分離された隠れた空間が生まれ、概念は各層できちんと分離され、ニューロンの活性化はそれぞれの概念に対応します。「このようなデカップリングにより、ニューラルネットワークがさまざまなレベルで概念を徐々に学習する方法をより明確に理解できます」とChen氏は述べています(ここでのデカップリングは、隠れた空間のさまざまな部分がさまざまな概念を表すことを意味します)。

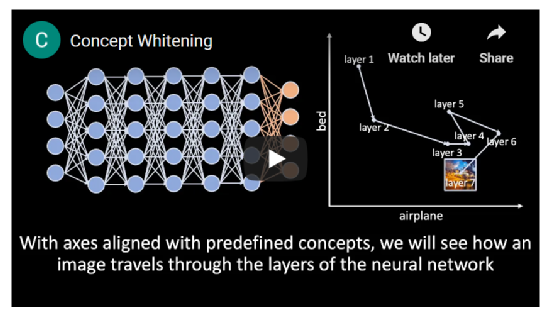

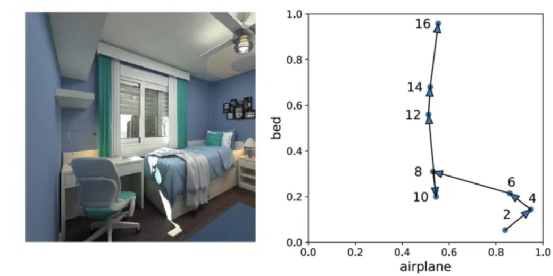

コンセプトホワイトニングテクノロジーの有効性を評価するために、研究者は、さまざまなレベルでコンセプトホワイトニングモジュールを挿入したディープラーニングモデルを通じて一連の検証画像を実行しました。次に、各層でアクティブ化された概念ニューロンに従って画像を分類します。ニューラルネットワークの下位層では、コンセプトwhiteninモジュールが色やテクスチャなどの低レベルの機能をキャプチャします。たとえば、ニューラルネットワークの下位層は、白いオブジェクトを含む青い画像が「航空機」の概念と密接に関連しているのに対し、暖かい色の画像は「ベッド」の概念を含む可能性が高いことを学習できます。より高いレベルでは、ニューラルネットワークは概念を分類することを学習します。

図:コンセプトホワイトニングは、低レベルの情報(色やテクスチャなど)を低レベルで学習し、高レベルの情報(オブジェクト、人物など)を高レベルで学習します。

概念の分解と調整の利点の1つは、ニューラルネットワークが明らかな間違いを犯しにくくなることです。画像がニューラルネットワークに入ると、上位層の概念ニューロンが下位層で発生する可能性のあるエラーを修正します。たとえば、下の画像では、青と白のピクセルが密集しているため、ニューラルネットワークの下層が誤って画像を「航空機」の概念に関連付けています。しかし、画像がより高いレベルで移動すると、コンセプトニューロンは結果を正しい方向に向けます(図を参照)。

図:画像がニューラルネットワークの下位層から上位層に移動するとき、概念のホワイトニングは間違った概念やエラーを修正できます。

AI分野での以前の作業には、ニューラルネットワークの潜在空間の値から概念を推測しようとする分類器の作成が含まれていました。ただし、Chenによれば、分離された潜在空間はありません。これらの方法で学習された概念(概念のホワイトニングなし)は、概念ニューロンの予測スコアを相関させることができるため、純粋ではありません。「過去に、教師あり学習によってニューラルネットワークの絡み合いを解決しようとした人もいましたが、実際には隠れた空間をある意味で切り離していませんでした。一方、コンセプトホワイトニングはホワイトニング変換を使用して相互作用を取り除きます。軸の関連付けは、これらの概念を真に切り離します。

ディープラーニングにおけるコンセプトホワイトニングの適用

具体的には、コンセプトホワイトニングは、畳み込みニューラルネットワークに挿入してバッチ正規化モジュールを置き換えることができるモジュールです。バッチ正規化は2015年に開始され、ニューラルネットワークのトレーニングに使用されるデータの分布を調整してトレーニングを高速化し、過剰適合などのアーティファクトを回避できる人気のあるテクノロジーです。ほとんどの畳み込みニューラルネットワークは、各層でバッチ正規化を使用します。

バッチ正規化機能に加えて、コンセプトホワイトニングは、関連するコンセプトを表す複数の軸に沿ってデータを整列させます。

Conceptホワイトニングアーキテクチャの利点は、既存の多くの深層学習モデルに簡単に統合できることです。調査プロセス中に、チームはバッチ正規化モジュールをコンセプトホワイトニングに置き換えることで、いくつかの一般的な事前トレーニング済みディープラーニングモデルを変更し、1つのエポックトレーニングのみで期待される結果を達成しました(1つのエポックは完全なトレーニングセットをトレーニングする時間です。ディープラーニングモジュールはゼロからトレーニングされ、通常は多くのエポックを通過します)。

「CWは、解釈可能性が非常に重要な医用画像などの分野に適用できます」とルーディン氏は述べています。

彼らの実験では、研究者たちは、皮膚の損傷を診断するための深層学習モデルにコンセプトホワイトニングを適用しました。「CW潜在空間で概念の重要性スコアを測定することで、皮膚病変の診断においてどの概念がより重要であるかについての実用的な洞察を得ることができます」と彼らは論文に書いています。

チェン氏は次のように述べています。「さらに発展させるために、事前定義された概念に依存するのではなく、データセットからこれらの概念、特に未発見、有用、未定義の概念を発見し、ニューラルネットワークでそれらを切り離す予定です。これらの発見概念は、よりよく説明するためにネットワークの隠された空間で明確に表現されています(ニューラルネットワークの動作原理)」。

彼らにとって、将来の研究の別の方向性は、概念を階層構造に編成し、個々の概念ではなく概念クラスターを分離することです。

深層学習研究への影響

長い間、深層学習モデルの年々の拡大と複雑さにより、ニューラルネットワークの透明性に対処する方法についてますます多様な理論がありました。

主な議論の1つは、ブラックボックスがどのように機能するかを確認するのではなく、AIモデルの動作を観察するかどうかです。これは、動物と人間の脳を研究し、実験を行い、脳の活動を記録するのと同じ方法です。この理論の支持者は、ニューラルネットワークに解釈可能な設計制約を課そうとすると、モデルの品質が低下すると考えています。インテリジェントなトップダウン設計なしで脳が数十億回の反復を通じて進化する場合、ニューラルネットワークも純粋に進化的なアプローチを通じて最高のパフォーマンスを達成する必要があります。

コンセプトホワイトニングはこの理論に反論し、パフォーマンスを低下させることなくニューラルネットワークにトップダウンの設計制約を課すことが可能であることを証明しています。興味深いことに、実験では、深層学習モデルの概念ホワイトニングモジュールが解釈可能性を提供でき、タスクの精度が大幅に低下することはないことが示されています。

ルーディン氏は次のように述べています。「私たちの研究室(および他の多くの研究室)でのコンセプトホワイトニングや他の多くの研究は、パフォーマンスを損なうことなく解釈可能なモデルを構築できることを明確に示しています。この研究が人々を変えることができることを願っています。ブラックボックスが必要であるという仮定良好なパフォーマンスであり、この作業がより多くの人々を引き付け、それぞれの分野で解釈可能なモデルを構築することを願っています。」

参考資料:

1、https://bdtechtalks.com/2021/01/11/concept-whitening-interpretable-neural-networks/

2、https://www.nature.com/articles/s42256-020-00265-z

データ戦闘派について

データ実務者は、実際のデータと業界の実際の事例を使用して、読者がビジネス能力を向上させ、興味深いビッグデータコミュニティを構築できるようにしたいと考えています。