出力層ソフトマックス活性化機能が追加されていません

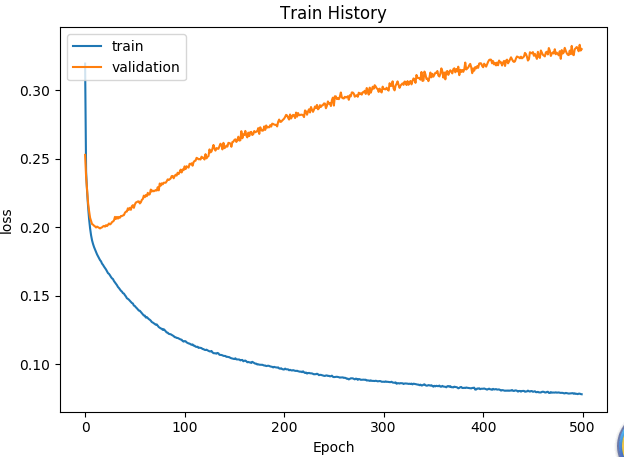

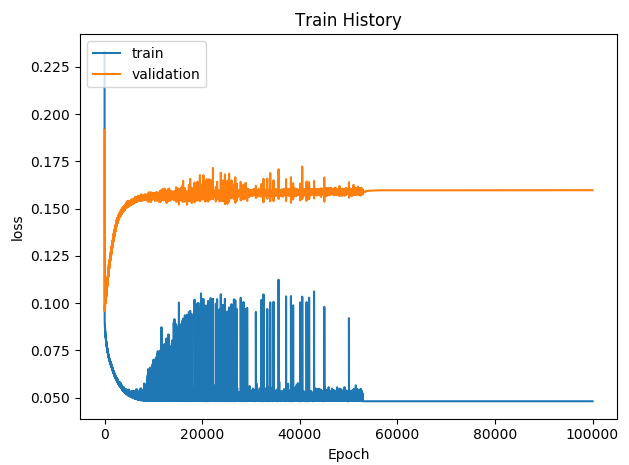

損失の値は高くないが、トレーニングの喪失が一貫した減少を設定するが、損失テスト・セットが、ショックにほとんど変化しなかったものの、精度の値も低いものの。私は解決する方法がわかりません。--2019.11.28 11時29分

出力層は、ソフトマックス活性化関数の後に追加されます。

損失の検証セットが半分に減少し、なぜそれをドロップしませんか??まだオーバーフィッティングのため?他の誰かの引数を見ては、勾配爆発は、その学習の速度を低下させることが、レートを学ぶことは、それは比較的小さかった、今0.001であるということです。

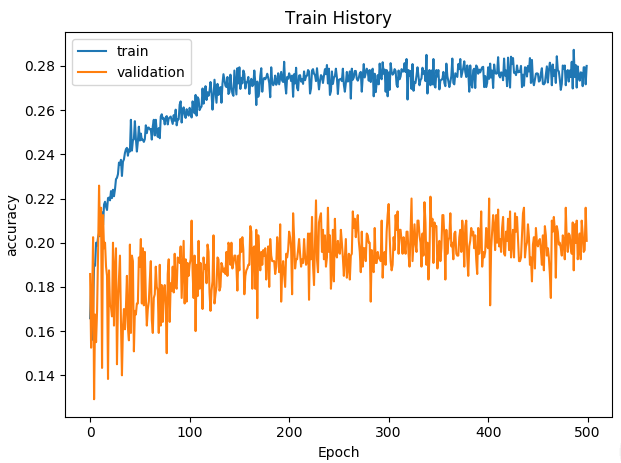

精度とエレベーターなし、損失もほとんどより大きいソフトマックスを追加し、損失テスト・セットおよびバリデーションセットしません。--11:33

学ぶために0.0001の再び減少率を試してみてください。

損失は0.2で、ほとんどの検証セットのまま。

Accがオーバーフィットする必要があります検証セットのACCの上昇、下落、上の訓練を受け、ニューラルネットワークの層数を減らすために、次には、隠された層は、128-64-32が64から32になったから構成されています。

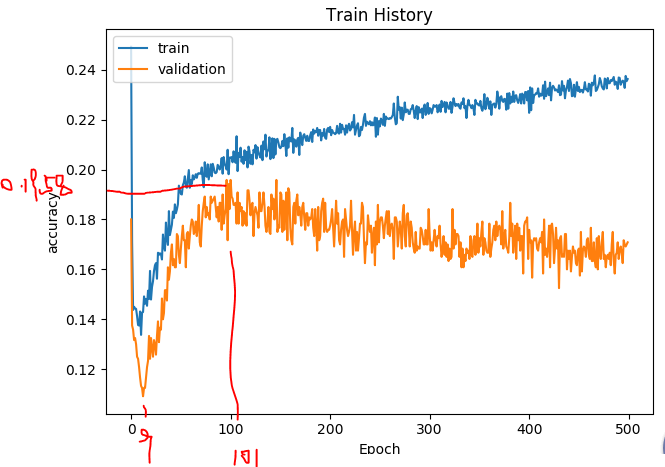

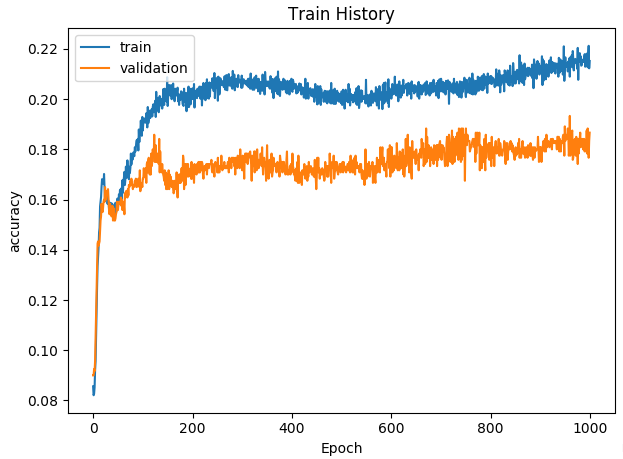

少し改善された検証セットACCは、エポックを増やし1000に500を試してみてください。

何を助けていません。。。

問題はどこにありますか?損失はほとんどが、生と死は、ACCを増加させません。。。

このステートメントと私の状況のような、または自分のパフォーマンスの関数を記述します。

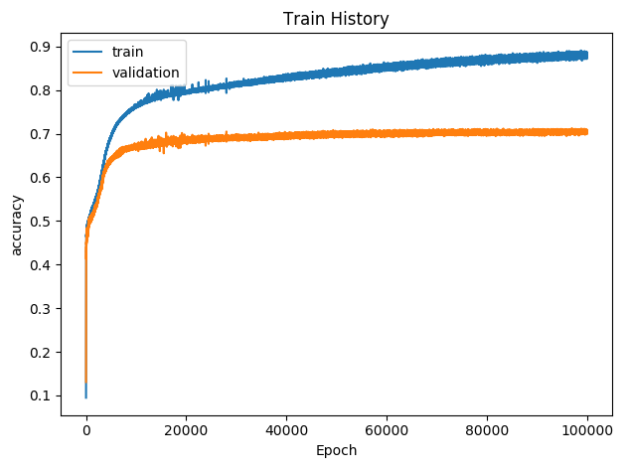

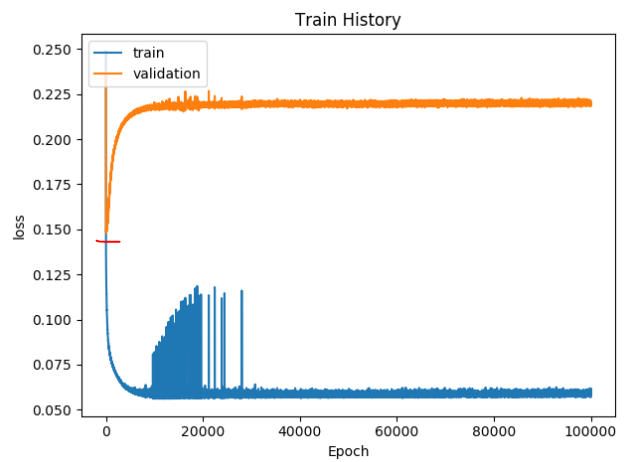

現実には、私は兄弟の助けを借りて、データセットを生成しなかったことである、正しく実行しないでください、成功し、データセットを生成した場合の符号化の不存在下で、結果はなかった得ることとして、次のとおりです。 - 2019年11月29日9時09分

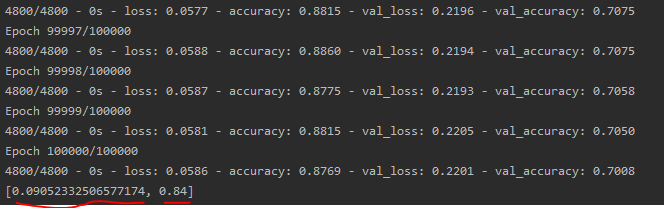

10万の反復。

モデルとして保存

model.save( ' polar_dnn_16_8.h5 ')

これは、モデルコードを訓練することはありません。

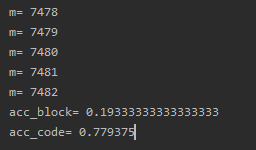

ACCライトの性能関数に応じて、テスト・セットを使い果たしたブロック誤り率が 78%高すぎます。22%の正解率

ビット・コンピューティングの誤り率 17.2%、精度83.8パーセントを

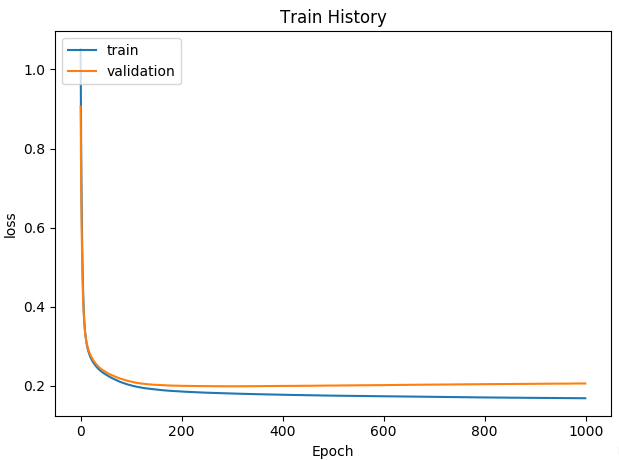

加入编码过程, 运行结果如下图所示:

但是正确率还是达不到百分之90以上。

不知道这个为什么会先降低后升高。验证集的loss比未编码之间要高。迭代40000次的时候就已经收敛了。

由图可知,错误率为9.05%,正确率为84%。

然后跑一下自己写的性能函数:

误块率80.7%,误码率22.1%

还是很差劲。。。