Información del papel

name_en: Modelos de lenguaje aumentado: una encuesta

name_ch: Una encuesta de modelos de lenguaje aumentado

paper_addr: http://arxiv.org/abs/2302.07842

date_read: 2023-05-20

date_publish: 2023-02-15

tags: ['Aprendizaje profundo' ,'Procesamiento del lenguaje natural','Modelo grande']

autor: Grégoire Mialon, Meta

despues de leer

El artículo es una revisión de los Modelos de Lenguaje Aumentado (ALM).La mejora aquí se refiere principalmente a la combinación de modelos de lenguaje grande (LM) con módulos de extensión externos a través de métodos no paramétricos, para obtener más que un simple modelado de lenguaje natural . . Las habilidades específicas incluyen: razonamiento, uso de herramientas y actuación . No sólo puede resolver más tipos de problemas , sino que su capacidad para lidiar con el procesamiento del lenguaje natural también ha hecho avances después de conectar módulos externos .

El artículo se adentra en la interpretación desde la perspectiva de la metodología . El contenido se divide en seis partes: introducción, razonamiento, uso de herramientas y acciones, métodos de aprendizaje, discusión, conclusión, 22 páginas de texto.

Para los lectores que están más interesados en el campo de LM, no hay un método especial sorprendente mencionado en este artículo. Sin embargo, el artículo presenta una recopilación completa y meticulosa de los métodos existentes, proporcionando una descripción general panorámica con referencias detalladas a la literatura relevante y ejemplos de software. Es una buena visión general y clasificación del conocimiento.

(Los siguientes paréntesis son opiniones personales, no rocíe si no le gusta)

1. Introducción

1.1 Motivación

En los últimos años, el desarrollo de modelos de lenguaje a gran escala (LLM) ha sido muy rápido. A medida que aumenta el tamaño del modelo, el modelo emerge con sus capacidades innovadoras (varias capacidades se promueven entre sí). Sin embargo, LLM a menudo produce algunas alucinaciones (tonterías graves), lo que hace que sus respuestas a veces no sean creíbles. Especialmente cuando se resuelven problemas complejos como problemas matemáticos y razonamiento, el rendimiento de LLM suele ser insatisfactorio.

Al resolver problemas específicos, debemos proporcionar el conocimiento necesario a gran escala al modelo. Sin embargo, actualmente existen dos limitaciones principales: (i) los modelos paramétricos son fijos (generalmente no se pueden entrenar modelos grandes con sus propios datos); (ii) el contexto es limitado (transferencia limitada de conocimiento a modelos grandes).

1.2 Definición

Razonamiento: Usualmente traducido como razonamiento o planificación, se refiere a descomponer tareas complejas en subtareas simples, de modo que las herramientas existentes puedan usarse para resolver estas subtareas.

Herramienta: LLM se combina con módulos externos, como un recuperador de documentos, para mejorar la capacidad del modelo para resolver problemas complejos a través de la operación interactiva del trabajo y el modelo grande.

Actuar: Invocar una herramienta que tiene un efecto en el mundo virtual o físico y observar sus resultados, como un brazo robótico.

2 razonamiento

El razonamiento generalmente incluye: razonamiento de sentido común, razonamiento matemático y razonamiento simbólico, etc., entre los cuales la cadena de razonamiento se denomina razonamiento de varios pasos. Los LLM funcionan bien para resolver problemas simples, pero se desempeñan mal en problemas complejos, a menudo necesitan expandir sus capacidades de razonamiento.

2.1 Obtención de inferencias a través de indicaciones (indicaciones elicitivas)

Las sugerencias se utilizan principalmente para tareas de cero disparos y pocos disparos. Las indicaciones elicitivas alientan al LM a resolver la tarea siguiendo pasos intermedios antes de generar la respuesta.

Para tareas de pocos disparos, Chain-of-think (CoT) puede mejorar efectivamente su capacidad de razonamiento y, además, también puede mejorar el efecto al comparar la consistencia de las respuestas.

Para tareas de cero disparo, se pueden usar indicaciones como "Pensemos paso a paso" para ayudar con la resolución de problemas.

2.2 Pistas recursivas

Para resolver problemas complejos, los métodos recursivos a menudo se utilizan para dividir problemas grandes en subproblemas. Este método incluye dos formas específicas: una es resolver cada subproblema por separado y luego sintetizar los resultados para obtener la respuesta final (en paralelo); la otra es resolver los subproblemas paso a paso (en serie). Los resultados del trabajo y las citas relevantes se enumeran en el documento.

2.3 Enseñar un modelo de lenguaje a razonar

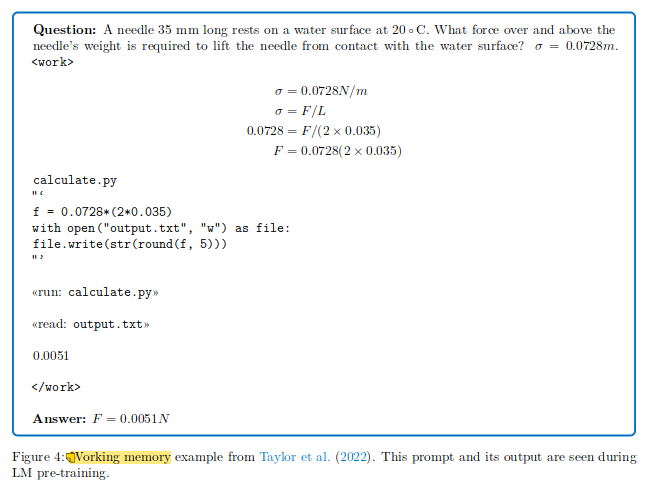

Cuando una tarea requiere múltiples pasos para resolverla correctamente, los humanos generalmente confían en la memoria de trabajo. Los datos paso a paso se pueden agregar al entrenamiento del modelo a través del entrenamiento previo y el ajuste fino, de modo que el modelo pueda predecir los pasos de razonamiento. Por ejemplo, la etiqueta de trabajo podría usarse para contener información similar a la memoria de trabajo interna.

2.4 Limitaciones del razonamiento

Ya sea que se trate de un razonamiento iterativo o de un razonamiento recursivo, es difícil explorar todas las rutas de razonamiento factibles y no se puede garantizar la corrección de cada paso del razonamiento.

3 Herramientas y Comportamiento

No es necesario almacenar todo el conocimiento necesario para responder preguntas en los pesos del modelo, y las funciones del modelo también se pueden ampliar llamando al conocimiento externo. Esto requiere una combinación de LLM con módulos de extensión.

3.1 Llamar a otros modelos

3.1.1 Llamadas LM iterativas

Un modelo de recuperación iterativo puede mejorar gradualmente la salida, lo que permite que el modelo de lenguaje se invoque a sí mismo de forma iterativa hasta que la salida cumpla con ciertos criterios. Por ejemplo, Re3 puede generar automáticamente historias de más de 2000 palabras. Durante este proceso, el modelo invoca GPT3 utilizando señales previamente proporcionadas, generando un plan, escenarios ambientales y personajes; luego infunde información sobre el plan y el estado actual de la historia para generar nuevos segmentos de la historia. Además, el esquema se puede expandir gradualmente a cualquier granularidad requerida.

3.1.2 Combinando Multimodalidad

Los LM también pueden servir como una interfaz general para trabajar con modelos entrenados previamente en diferentes modalidades. Por ejemplo, maneja datos de múltiples modalidades como texto e imágenes, y puede adaptarse a diferentes tareas. Por ejemplo, Flamingo es un modelo de lenguaje visual (VLM) que puede manejar cualquier secuencia intercalada de datos de texto e imagen. Al entrenar un corpus de red multimodal a gran escala y aprender de una pequeña cantidad de muestras, se puede adaptar fácilmente a tareas de generación o tareas de clasificación. Además, Socratic Models es un marco modular que puede combinar modelos previamente entrenados de diferentes modalidades para permitir el intercambio de información entre modelos y admitir nuevas aplicaciones, como la percepción y planificación de robots, la respuesta a preguntas de video de forma libre, etc.

3.2 Recuperación de información

Los LM pueden lograr un rendimiento comparable al de los LM grandes y reducir la cantidad de parámetros requeridos al aumentar las unidades de memoria para mejorar las capacidades de razonamiento, o al evitar la información no fáctica y desactualizada mediante la recuperación de fuentes de conocimiento externas.

3.2.1 Modelo de lenguaje mejorado de recuperación

Representación densa y dispersa

El texto del conocimiento externo generalmente se convierte en una representación vectorial, y los métodos de representación se dividen en densos y dispersos. El tipo disperso se refiere al uso del método de bolsa de palabras para generar una representación de cada palabra; el tipo denso usa un modelo de aprendizaje profundo para representarlo a través de la incrustación. En el proceso de uso específico, primero se recupera el conocimiento externo y luego las preguntas y los resultados de la recuperación se pasan al LLM. Al recuperar, para datos dispersos, generalmente se usa para verificar la superposición exacta de términos; para datos densos, a menudo se usa para calcular la similitud semántica entre conceptos relacionados.

Ajuste de LM con documentos recuperados

Este método es excelente en tareas intensivas en conocimiento. Los métodos específicos incluyen: uso de grandes modelos preentrenados para el ajuste fino; entrenamiento de modelos de extremo a extremo; combinación de modelos de preentrenamiento BERT ya entrenados sin ajustar parámetros , etc método.

Chain of Thought Prompts and Retriever

Al combinar la cadena de razonamiento CoT con un retriever, este enfoque no requiere un ajuste fino del modelo. Simplemente use el razonamiento CoT para guiar el paso de recuperación, descomponiendo la intención en consultas.

3.2.2 Consulta del motor de búsqueda

Cuando el modelo está equipado con la capacidad de generar consultas basadas en sugerencias, LM puede expandir su espacio de acción y volverse más proactivo. LaMDA y BlenderBot son dos modelos LM para el diálogo. Se mejoran mediante la introducción de mecanismos como la recuperación, el cálculo y la traducción, que mejoran aún más la capacidad de diálogo.

3.2.3 Búsqueda y navegación en la web

Los agentes están capacitados para navegar por Internet abierto para lograr objetivos específicos, como buscar información o comprar bienes. WebGPT es un agente basado en LM que puede interactuar con un entorno de navegación web para refinar aún más las consultas iniciales o realizar otras acciones en función de sus interacciones con la herramienta para mejorar las capacidades de respuesta a preguntas. El mejor modelo actual es un modelo de recompensa que ajusta GPT3 en demostraciones humanas y luego realiza un muestreo de rechazo para entrenar para predecir las preferencias humanas. Las tiendas web pueden encontrar, personalizar y comprar productos según las instrucciones proporcionadas. Ambos sistemas se basan en la comprensión y el razonamiento del lenguaje natural y, por lo tanto, son adecuados para los modelos de lenguaje.

3.3 Cálculo a través de módulos simbólicos e intérprete de código

LM es principalmente bueno en el procesamiento del lenguaje natural, y no es perfecto para problemas que necesitan tratar con grandes números o realizar operaciones aritméticas complejas, incluso si fortalece la capacidad de razonamiento del entrenamiento previo. Un paso más allá es combinar los LM con motores o herramientas especializadas, como motores de física o programas Python. Por ejemplo, CoT proporciona LM a gran escala que pueden descomponer el razonamiento simbólico, el razonamiento matemático o las tareas algorítmicas en pasos intermedios y el código Python correspondiente para cada paso.

3.4 Actuar sobre el mundo virtual o físico

Además de la interacción de información, LM también puede interactuar con el mundo real.

3.4.1 Control de agentes virtuales

El primer paso para interactuar con el mundo real es realizar tareas en entornos simulados en 2D y 3D. Por ejemplo, predecir la siguiente acción tomando una secuencia de incrustaciones como entrada. Esto implica la generalización combinatoria en diferentes dominios, donde los LM se pueden usar como planificadores de varios pasos, descomponiendo tareas de alto nivel en subobjetivos.

3.4.2 Control del robot

Algunos investigadores han proporcionado ejemplos que permiten a los LM escribir códigos de políticas de robots correspondientes a comandos de lenguaje natural y combinar lógica clásica y bibliotecas externas para generar códigos de políticas que utilizan el razonamiento geométrico espacial.

Sin embargo, debido a la falta de formación contextual, los modelos de lenguaje tienen problemas para tomar decisiones prácticas. Para superar este problema, algunos investigadores proponen introducir habilidades de bajo nivel de los robots para descomponer instrucciones complejas de alto nivel en subobjetivos simples y seleccionar las habilidades de bajo nivel más valiosas para completar tareas de acuerdo con la situación.

Además, el rendimiento del robot para lograr tareas de control mejora al incorporar información contextual en el entorno en la toma de decisiones del robot mediante la alineación de imágenes y texto.

4 métodos de aprendizaje

En esta sección se presentan métodos específicos para mejorar el rendimiento del modelo.

4.1 Aprendizaje supervisado

4.1.1 Consejos de pocos disparos

Los ejemplos escritos por humanos son una de las formas comunes de enseñar a los LM a razonar y usar herramientas y acciones. Este método no necesita ajustar los parámetros del modelo y, al mismo tiempo, puede realizar experimentos rápidos y el mismo modelo puede usarse en diferentes escenarios. Además, el tamaño del LM, el tamaño de la ventana de contexto, la elección de ejemplos de pocas tomas y el orden en que se presentan también son importantes. Este enfoque también tiene sus inconvenientes: (1) un nuevo comportamiento es muy difícil de aprender y requiere más que unos pocos ejemplos (2) el aprendizaje de modelos también puede ser muy difícil cuando hay muchas posibilidades para el espacio de acción.

4.1.2 Ajuste fino del modelo

Para mejorar las capacidades de razonamiento y operación del modelo de lenguaje previamente entrenado, sus parámetros pueden actualizarse a través del aprendizaje supervisado estándar, que se ha aplicado a muchas herramientas y sistemas, como motores de búsqueda, navegadores web, calculadoras y sistemas de traducción. . Además, la capacidad del modelo para seguir instrucciones se puede mejorar etiquetando manualmente los datos para su ajuste.

4.1.3 Sugerencias previas al entrenamiento

Para evitar distorsionar la capacidad del modelo ajustado para predecir las capacidades básicas del modelo entrenado, se puede usar un método de mezclar datos previamente entrenados con ejemplos de inferencia etiquetados (mensaje mejorado). Este enfoque combina datos previos al entrenamiento con ejemplos de varias tareas posteriores.

4.1.4 arranque (bootstrap)

Bootstrapping es un enfoque supervisado indirecto que puede servir como una alternativa al ajuste fino. La exploración se realiza utilizando este método en varios pasos. Deseche los ejemplos en los que la acción realizada o el paso de inferencia no dieron como resultado una predicción correcta. Finalmente, afine todos los ejemplos correctos usando el LM original u otro modelo (generalmente más pequeño) (la selección de los ejemplos por el modelo entrenado puede ser más precisa).

4.2 Aprendizaje por refuerzo

El aprendizaje supervisado requiere muchas anotaciones porque es complejo y costoso. Por el contrario, el aprendizaje por refuerzo puede utilizar datos ya preparados, como las preferencias del usuario y los resultados de clasificación, lo que es más conveniente, rápido y económico. El núcleo del aprendizaje por refuerzo es el mecanismo de la función de recompensa.

El aprendizaje por refuerzo a menudo se aplica al modelado de escenas, como robots y juegos, y su objetivo es obtener el máximo valor de recompensa general al proporcionar estrategias para una serie de problemas. En este proceso interviene la interacción entre el modelo y los usuarios u otras herramientas.

4.2.1 Función de recompensa codificada

Al entrenar un modelo de lenguaje, es común usar una función de recompensa codificada para actualizar los pesos del modelo usando herramientas externas. Esta recompensa se calcula en función de la salida de la herramienta. Específicamente, se puede ingresar un fragmento de texto en el modelo y luego se genera una serie de tokens o acciones en función del estado actual del modelo. El aprendizaje basado en recompensas tiene un potencial significativo para dotar a los LM de la capacidad de interactuar con herramientas externas. Por ejemplo, WebGPT utiliza esta técnica.

4.2.2 Comentarios humanos

En muchos casos, la idoneidad de una respuesta también depende de la intención del interrogador. Dado que las preferencias y los valores humanos son difíciles de evaluar de forma codificada, se introduce el aprendizaje por refuerzo de la retroalimentación humana (RLHF: Reinforcement Learning from Human Feedback). Este método consiste en utilizar humanos para calificar múltiples respuestas generadas por la máquina y luego entrenar aún más el modelo. Por ejemplo, GPT-3.5 utiliza este método, mejorando la utilidad, inocuidad y precisión del modelo.

4.3 Limitaciones y direcciones futuras

Los métodos actuales de RL todavía sufren de inestabilidad, especialmente en tareas que requieren razonamiento y acción sin datos fácilmente disponibles, así como problemas de calidad de datos. Las soluciones a estos problemas pueden provenir de métodos guiados y RL fuera de línea, así como de algunos métodos autosupervisados. Investigar cómo extender estos métodos a escenarios más complejos sería una dirección de investigación prometedora para modelos generales basados en LM.

5 discusiones

Alejarse del modelado de lenguaje tradicional : los ALM son diferentes del modelado de lenguaje tradicional. Podría realizar pasos intermedios de razonamiento o poseer la capacidad de acceder a Internet. Además, puede vincular explícitamente las respuestas a los pasos intermedios a través de datos supervisados orientados a tareas. También considera el estado actual y los factores de instrumentación al tomar decisiones.

Compensación entre herramientas y memoria : para algunos casos, como calcular 213443^344, usar una herramienta externa puede ser una mejor opción; sin embargo, información como "La Torre Eiffel está ubicada en París" no debe entregarse a un herramienta externa. El modelo se puede ajustar para determinar cuándo usar la herramienta. Además, también es posible integrar el presupuesto computacional de cada herramienta en la función de pérdida para permitir que el modelo aprenda a usar la herramienta.

Marcos no paramétricos : ALM es una generalización de los marcos no paramétricos. Además de la recuperación de información, los LM pueden delegar en las herramientas externas correspondientes para manejar otros problemas, como el cálculo, para evitar almacenar en sus pesos conocimientos a los que rara vez se accede. Los LM mejorados con herramientas pueden ser más escalables, capaces de producir modelos más pequeños mientras retienen el poder de los modelos más grandes. Esto es de gran beneficio para la generalización no paramétrica de ALM, capaz de obtener la información más reciente del mundo externo y evitar actualizaciones frecuentes.

El camino hacia la inteligencia artificial autónoma : LeCun (2022) propuso el concepto de agente inteligente autónomo (Agent). Aunque los pesos de los ALM contienen básicamente los módulos de modelo mundial, percepción y actor, como modelos predictivos a nivel de palabra, no pueden planificar y razonar como el Agente de LeCun. Aunque los ALM se pueden utilizar como agentes de interacción humana, todavía quedan muchos problemas de investigación abiertos por resolver.

Ventajas de ALM

- Más fiable: Se puede aumentar su fiabilidad corroborándolo con otras herramientas.

- Reducción de la incertidumbre: mediante el uso de herramientas externas para ayudar al modelo a determinar lo que sabe y lo que no, ALM puede explotar directamente esta incertidumbre para comprender mejor cuándo debe confiar en sus propios pesos y cuándo debe consultar herramientas externas.

- Interpretabilidad: ALM proporciona pasos de razonamiento intermedios y se basa en herramientas para mejorar la interpretabilidad. Citar las fuentes utilizadas para escribir las respuestas es crucial, y las cadenas de pensamiento también pueden conducir a predicciones correctas.

- Mejoras: los ALM con capacidades y herramientas de razonamiento mejoradas pueden convertirse en herramientas más útiles y resolver una gama más amplia de tareas que los LM estándar. Se forma un ciclo de retroalimentación entre el razonamiento y la manipulación, y cada habilidad mejora aún más a la otra. La interacción con herramientas, entidades y entornos externos puede mejorar el razonamiento. Asimismo, el razonamiento puede mejorar las capacidades de toma de decisiones de ALM.

Cuestiones morales y éticas : ALM plantea nuevas cuestiones éticas potenciales. De hecho, muchas de estas predicciones siguen siendo incorrectas, lo que dificulta la detección de errores. Especialmente cuando actúa en el mundo virtual o físico, sin verificación humana, puede amplificar las consecuencias dañinas de LM.

6. Conclusión

El artículo analiza principalmente la atribución y las herramientas, así como las mejoras para los LM no sintonizados. Dichos modelos de lenguaje mejorados generalmente requieren el apoyo interactivo de anotaciones y comentarios humanos. Además, la atribución y las herramientas se pueden combinar para futuras investigaciones para resolver problemas más complejos.