Enlace original: Queso AI come pescado

Aprendizaje situacional a través de indicaciones

En biología, la emergencia es una propiedad increíble en la que, como resultado de las interacciones, las partes se juntan para exhibir nuevos comportamientos (llamados emergencia) que no se pueden ver en escalas más pequeñas. Lo que es aún más increíble es que a pesar de que la versión de menor escala se parece a la de mayor escala, la mayor escala en realidad se compone de más partes e interacciones, que terminan exhibiendo un conjunto de comportamientos completamente diferente.

Todo comienza con la capacidad de entrenar estos modelos de IA sin supervisión. De hecho, el aprendizaje no supervisado ha sido uno de los principios clave de esta revolución de la IA que ha frenado el progreso de la IA en los últimos años.

Antes de 2017, la mayoría de la IA trabajaba con aprendizaje supervisado a partir de pequeños conjuntos de datos estructurados, lo que permitía entrenar modelos de aprendizaje automático en tareas muy limitadas. Después de 2017, las cosas empezaron a cambiar con la llegada de una nueva arquitectura llamada Transformer.

Esta nueva arquitectura se puede utilizar con métodos de aprendizaje no supervisados. Los modelos de aprendizaje automático se pueden entrenar previamente en conjuntos de datos no estructurados muy grandes con una función objetivo muy simple: predicción de texto a texto.

El aspecto interesante es que para aprender cómo realizar predicciones de texto a texto correctamente (lo que puede parecer una tarea muy simple), un modelo de aprendizaje automático comienza a aprender una serie de patrones y heurísticas en torno a los datos en los que se entrena. .

Esto permite que los modelos de aprendizaje automático aprendan una amplia variedad de tareas.

En lugar de intentar realizar una sola tarea, los grandes modelos de lenguaje comienzan a inferir patrones a partir de los datos y reutilizan esos patrones al realizar nuevas tareas.

Esta es una revolución hasta la médula. Además, con el papel GPT-3, otro punto de inflexión es poder insinuar estos modelos.

En resumen, permite que estos modelos aprendan más el contexto del usuario a través de instrucciones en lenguaje natural, lo que puede cambiar drásticamente la salida del modelo.

Este otro aspecto también está surgiendo porque nadie lo ha pedido explícitamente. Entonces, así es como obtenemos aprendizaje contextual a través de señales que son una propiedad central emergente de los modelos actuales de aprendizaje automático.

Más información sobre la ingeniería de puntas

La ingeniería de pistas es una propiedad emergente clave del paradigma actual de IA.

Uno de los aspectos más interesantes de Prompt Engineering es su surgimiento como una propiedad emergente de extender la arquitectura de Transformer para entrenar modelos de lenguaje grandes.

Así como sus deseos expresados pueden trabajar en su contra, cuando le da una señal a una máquina, la forma en que expresa lo que necesita hacer puede cambiar drásticamente la salida.

¿Cuál es la parte más divertida? Las sugerencias no son una función desarrollada por expertos en IA. Esta es una característica emergente. En resumen, al desarrollar estos enormes modelos de aprendizaje automático, las sugerencias se convierten en la forma de hacer que la máquina actúe sobre la entrada. ¡Nadie pidió esto, simplemente sucedió!

En un artículo de 2021, los investigadores de la Universidad de Stanford destacaron que los modelos basados en transformadores son fundamentales.

Como se explica en el mismo documento:

La historia de la inteligencia artificial siempre ha sido una historia de surgimiento y homogeneización. Con la introducción del aprendizaje automático, la forma en que se realizan las tareas surge de los ejemplos (inferencia automática); a través del aprendizaje profundo, surgen funciones avanzadas para la predicción; a través de modelos básicos, incluso pueden surgir funciones avanzadas como el aprendizaje situacional. Al mismo tiempo, el aprendizaje automático homogeneiza los algoritmos de aprendizaje (como la regresión logística), el aprendizaje profundo homogeneiza las arquitecturas de modelos (como las redes neuronales convolucionales) y los modelos básicos homogeneizan el propio modelo (como GPT-3).

La ingeniería de sugerencias es un proceso utilizado en inteligencia artificial en el que una o más tareas se convierten en un conjunto de datos basado en sugerencias y luego se entrena un modelo de lenguaje para que aprenda.

En la superficie, la motivación detrás de la ingeniería de pistas puede ser difícil de entender, así que describamos la idea con un ejemplo.

Imagine que está creando una plataforma de entrega de alimentos en línea y tiene miles de imágenes de diferentes vegetales para incluir en el sitio. El único problema es que no hay metadatos de imagen que describan qué vegetales están en qué fotos. En este punto, puede hacer la tediosa clasificación de las imágenes y poner las fotos de papas en la carpeta de papas, las fotos de brócoli en la carpeta de brócoli, y así sucesivamente.

También puede ejecutar todas las imágenes a través del clasificador para ordenarlas más fácilmente, pero, como descubrió, entrenar el modelo del clasificador aún requiere datos etiquetados. Con la ingeniería de sugerencias, puede escribir sugerencias basadas en texto que cree que producirán los mejores resultados de clasificación de imágenes.

Por ejemplo, se le puede decir al modelo que muestre "una imagen que contiene papas". La estructura de esa sugerencia, o la declaración que define cómo el modelo reconoce la imagen, es la base de la ingeniería de sugerencias. Escribir los mejores consejos a menudo requiere prueba y error. De hecho, el mensaje "imagen que contiene papas" es muy diferente de "fotografías de papas" o "una colección de papas".

Sugerencias para mejores prácticas de ingeniería

Como ocurre con la mayoría de los procesos, la calidad de la entrada determina la calidad de la salida. El diseño de señales efectivas puede aumentar la probabilidad de que un modelo devuelva una respuesta favorable y contextualmente apropiada. Las sugerencias bien escritas se refieren a comprender lo que el modelo "sabe" sobre el mundo y luego aplicar esa información en consecuencia. Algunos lo ven como un juego de adivinanzas, donde los actores brindan a sus compañeros suficiente información para usar su inteligencia para descifrar una palabra o frase.

Piense en el modelo como si representara a un compañero en un juego de adivinanzas, con pistas de entrenamiento que brindan al modelo suficiente información para resolver el patrón y completar la tarea en cuestión. No tiene sentido sobrecargar un modelo con toda la información a la vez e interrumpir su flujo natural de inteligencia.

Ingeniería Rápida y Modelos CLIP

El modelo CLIP (Contrastive Language-Image Pre-training) fue desarrollado en 2021 por el laboratorio de investigación de inteligencia artificial OpenAI.

Según los investigadores, CLIP es "una red neuronal entrenada en varios pares (imagen, texto). Se puede instruir en lenguaje natural para predecir el fragmento de texto más relevante dada una imagen, sin optimizar directamente la tarea, similar al cero. -características de disparo de GPT-2 y 3.”

Basado en un modelo de red neuronal, CLIP se entrenó en más de 400 millones de pares de imagen y texto que contenían imágenes que coincidían con los subtítulos. Usando esta información, las personas pueden introducir imágenes en el modelo, y el modelo generará lo que cree que es el título o resumen más preciso. La cita anterior también se refiere a las capacidades de disparo cero de CLIP, lo que lo hace algo especial entre los modelos de aprendizaje automático.

Por ejemplo, se espera que la mayoría de los clasificadores capacitados para reconocer manzanas y naranjas se desempeñen bien en la clasificación de manzanas y naranjas, pero normalmente no detectan plátanos. Ciertos modelos (incluidos CLIP, GPT-2 y GPT-3) pueden reconocer bananas. En otras palabras, pueden realizar tareas para las que no fueron capacitados explícitamente. Esta capacidad se conoce como aprendizaje de tiro cero.

Ejemplo de ingeniería rápida

A partir de 2022, la evolución de los modelos de IA se está acelerando. Esto hace que la ingeniería de pistas sea cada vez más importante. Primero usamos modelos de lenguaje como GPT-3, BERT para el procesamiento de texto a texto. Luego usamos Dall-E, Imagen, MidJourney y StableDiffusion para la conversión de texto a imagen. En esta etapa, nos estamos moviendo a texto a video con Make-A-Video de Meta, y ahora Google está trabajando en su propio Imagen Video. ¡Los modelos efectivos de IA de hoy se enfocan en obtener más con menos! Un ejemplo es DreamFusion: Text to 3D using 2D Diffusion, creado por Google Research Labs.

En resumen, los modelos de difusión de IA son modelos generativos, lo que significa que producen resultados similares a aquellos en los que fueron entrenados. Los modelos de difusión, por definición, funcionan agregando ruido a los datos de entrenamiento y recuperando esos datos invirtiendo el proceso de ruido para generar una salida. DreamFusion de Google Research puede convertir texto en imágenes 3D sin tener un gran conjunto de datos 3D etiquetados (no disponible actualmente).

¡Eso es todo! Como explicó el equipo de investigación:

"La adaptación de este enfoque a la síntesis 3D requiere conjuntos de datos a gran escala de datos 3D etiquetados y arquitecturas eficientes para eliminar el ruido de los datos 3D, ninguno de los cuales existe actualmente. En este trabajo, evitamos estas limitaciones mediante el uso de un modelo de difusión de texto a imagen para realizar síntesis de texto a 3D".

¿Porque es esto importante? Después de más de dos décadas de estar principalmente basado en texto o imágenes 2D en la web, ahora es el momento de habilitar formatos mejorados como 3D que pueden funcionar bien en un entorno AR.

En resumen, imagine que está usando las gafas AR de Google, y estos modelos de IA a continuación pueden aumentar dinámicamente el mundo real con objetos 3D, lo que le permite hacer que sus experiencias AR sean aún más atractivas.

Al mismo tiempo, OpenAI anunció el lanzamiento de las capacidades de voz a texto de Whisper. Combinados, estos modelos de IA crearán un entorno multimodal en el que una persona o un pequeño equipo pueden aprovechar todas estas herramientas para la generación de contenido, la realización de películas, la medicina y mucho más. Esto significa que algunas industrias que antes eran inaccesibles se vuelven más fáciles de expandir a medida que se eliminan las barreras de entrada. Se puede probar/lanzar/iterar más rápido, lo que permite que el mercado evolucione más rápido.

Internet ha evolucionado durante casi 30 años, pero muchas industrias (desde la atención médica hasta la educación) todavía se limitan a modelos antiguos. Una década de inteligencia artificial puede barajar completamente las cartas. Cada modelo de IA se solicitará de la misma manera, pero la forma en que se solicita la máquina puede ser muy sutil y la máquina puede producir muchos resultados diferentes debido a las variaciones en las señales.

Recién en octubre de 2022:

-

Stability AI anunció $ 101 millones en fondos para inteligencia artificial de código abierto.

-

Jasper AI, una startup que desarrolla una plataforma de "contenido de inteligencia artificial", ha recaudado 125 millones de dólares con una valoración de 1500 millones de dólares. Jasper está adquiriendo la startup de IA Outwrite, un corrector de gramática y estilo con más de 1 millón de usuarios.

-

OpenAI, valorado en casi $20 mil millones, está en conversaciones avanzadas con Microsoft para obtener más fondos.

Hoy, con sugerencias, puede generar más y más resultados.

Algunos casos de uso de OpenAI se pueden generar a partir de sugerencias. Desde la respuesta a preguntas hasta clasificadores y generadores de código. La cantidad de casos de uso que la IA permite a través de sugerencias está creciendo exponencialmente.

¿Otra aplicación genial? Puedes diseñar tus propios zapatos de acuerdo con las indicaciones:

Solicite a DreamStudio AI que genere un par de zapatillas personalizadas.

Ejemplos de ingeniería oportunos y estudios de casos

Aquí hay un ejemplo de ingeniería rápido con algunas mejores prácticas en el proceso.

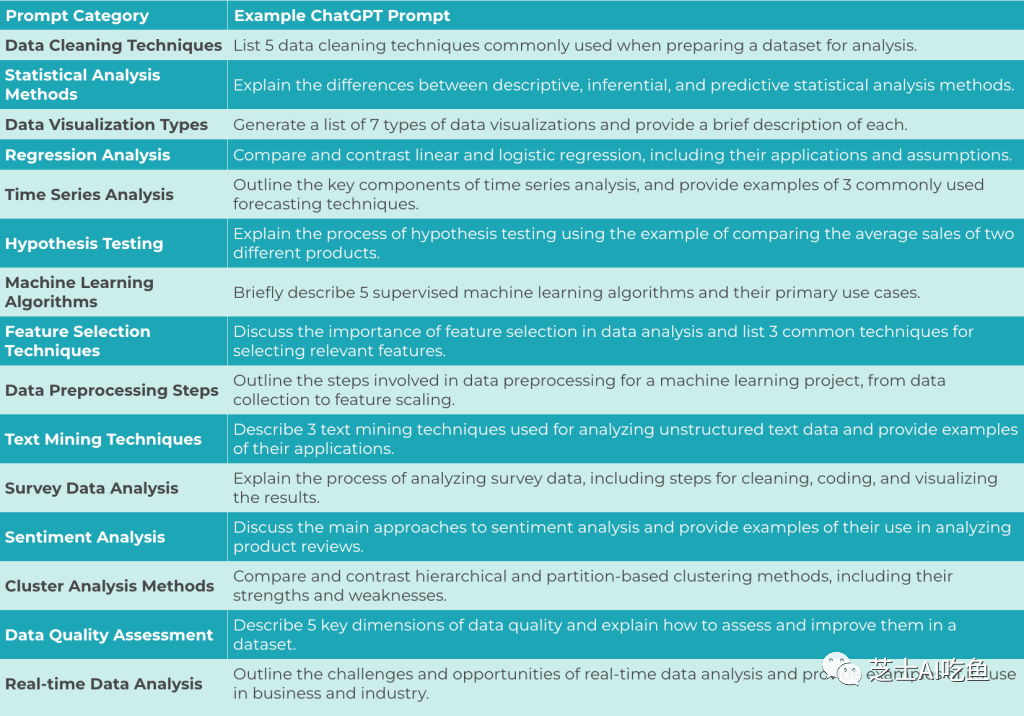

Ejemplo de sugerencia de ChatGPT

codigo de GENERACION

creación de contenido

análisis de los datos

Educación y entrenamiento

toma de decisiones y resolución de problemas

Puntos principales:

-

La ingeniería de sugerencias es un concepto de procesamiento del lenguaje natural (NLP) que implica descubrir entradas que producen resultados deseados o útiles.

-

Como ocurre con la mayoría de los procesos, la calidad de la entrada en la ingeniería rápida determina la calidad de la salida. El diseño de señales efectivas puede aumentar la probabilidad de que un modelo devuelva una respuesta favorable y contextualmente apropiada.

-

El modelo CLIP (Contrastive Language-Image Pre-training), desarrollado por OpenAI, es un ejemplo de un modelo que utiliza señales para clasificar imágenes y leyendas en más de 400 millones de pares de imágenes y leyendas.