Este artículo son las notas de lectura del blogger sobre "Aprendizaje por refuerzo: una introducción". No implica la traducción del contenido, sino principalmente para la comprensión y el pensamiento personal.

El aprendizaje TD es el núcleo de los métodos modernos de aprendizaje por refuerzo. Es una combinación del método de Monte Carlo y el método de programación dinámica . Por un lado, al igual que el método de Monte Carlo, no necesita comprender completamente el entorno, sino que aprende de la interacción del entorno. Por otro lado, es similar al método de programación dinámica, que actualiza la nueva ronda de estimación basada en la ronda de estimación anterior, en lugar de estimar la actualización a través de la recompensa final como el método de Monte Carlo. Se puede ver que el aprendizaje TD sigue siendo similar al proceso de iteración de política generalizada (GPI) En comparación con el método de Monte Carlo y el método de programación dinámica, la diferencia central radica en la estimación de la función de valor.

1. Estimación del aprendizaje TD

Primero, consideramos la función de estimación de valor del método de Monte Carlo discutido en la sección anterior , y la cambiamos al siguiente proceso iterativo de actualización, es decir, la nueva ronda de estimación se actualiza a través de la ronda de estimación anterior. En este momento, si el factor de actualización está configurado para ser fijo, se denomina método MC de paso fijo.

En este momento, considere la fórmula para resolver el ingreso acumulativo G en la programación dinámica. En este momento, representa el siguiente estado y acción, y

representa la recompensa

En este momento, la fórmula para la actualización iterativa se puede reescribir como

Significa que bajo la decisión óptima

, esto es incognoscible, por lo que solo podemos usar lo que se conoce actualmente

para resolverlo. Así que habrá una cierta discrepancia entre esto. Pero podemos deducir que

en ese momento , esta desviación puede converger. Supongamos que

, en este momento, la desviación se puede escribir como:

Especialmente cuando el factor de actualización se establece en un valor pequeño, esta desviación es aproximada y la teoría demuestra que puede converger a la función de decisión óptima.

El aprendizaje TD combina las ventajas de la programación dinámica y Monte Carlo. Por un lado, no necesita modelar el entorno. Por otro lado, no necesita esperar una ronda de muestreo completa de muestras como el método Monte Carlo. Por lo tanto, para algunas rondas cuando el tiempo es demasiado largo o el costo es demasiado alto, usar el aprendizaje TD puede acelerar el aprendizaje.

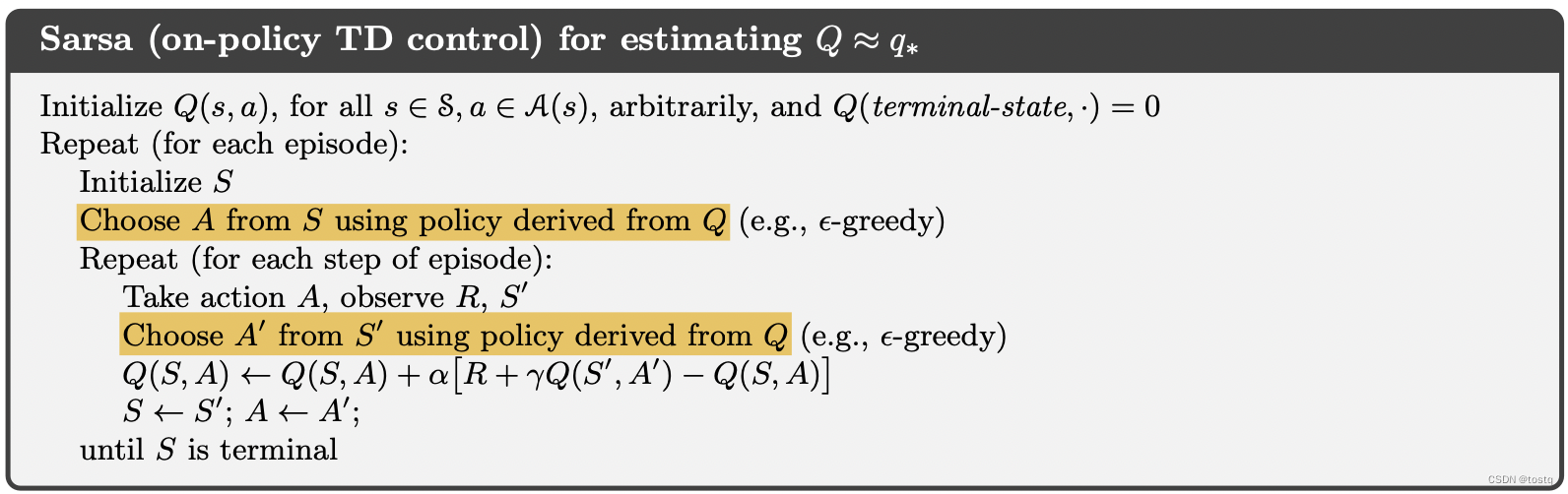

Describimos completamente la versión inicial del método de aprendizaje de TD anterior, también llamado Sarsa (control de TD en la política)

2. Fuera de la política

En la última sección, nuestra estimación de la rentabilidad acumulada G está determinada por el estado real y la acción de la próxima ronda . Este método se denomina estrategia con política. De hecho, podemos referirnos a la estrategia sin política en la sección anterior. capítulo y no use la siguiente ronda.

Es una forma intuitiva de estimar un estado y una acción en función de la función de valor existente, y este método también se denomina Q-learning.

Pero tomar max traerá el llamado sesgo de maximización, porque el valor de tomar argmax es a menudo mayor que su valor esperado real, a saber:

Pero tomar max traerá el llamado sesgo de maximización, porque el valor de tomar argmax es a menudo mayor que su valor esperado real, a saber:

Por lo tanto, una forma es no tomar el valor máximo, sino tomar la expectativa, que es el llamado método Sarsa esperado. Comparado con el anterior, puede eliminar mejor la varianza causada por acciones de selección aleatoria, por lo que tendrá un efecto más estable Pero buscar expectativas al mismo tiempo también aumenta el costo computacional

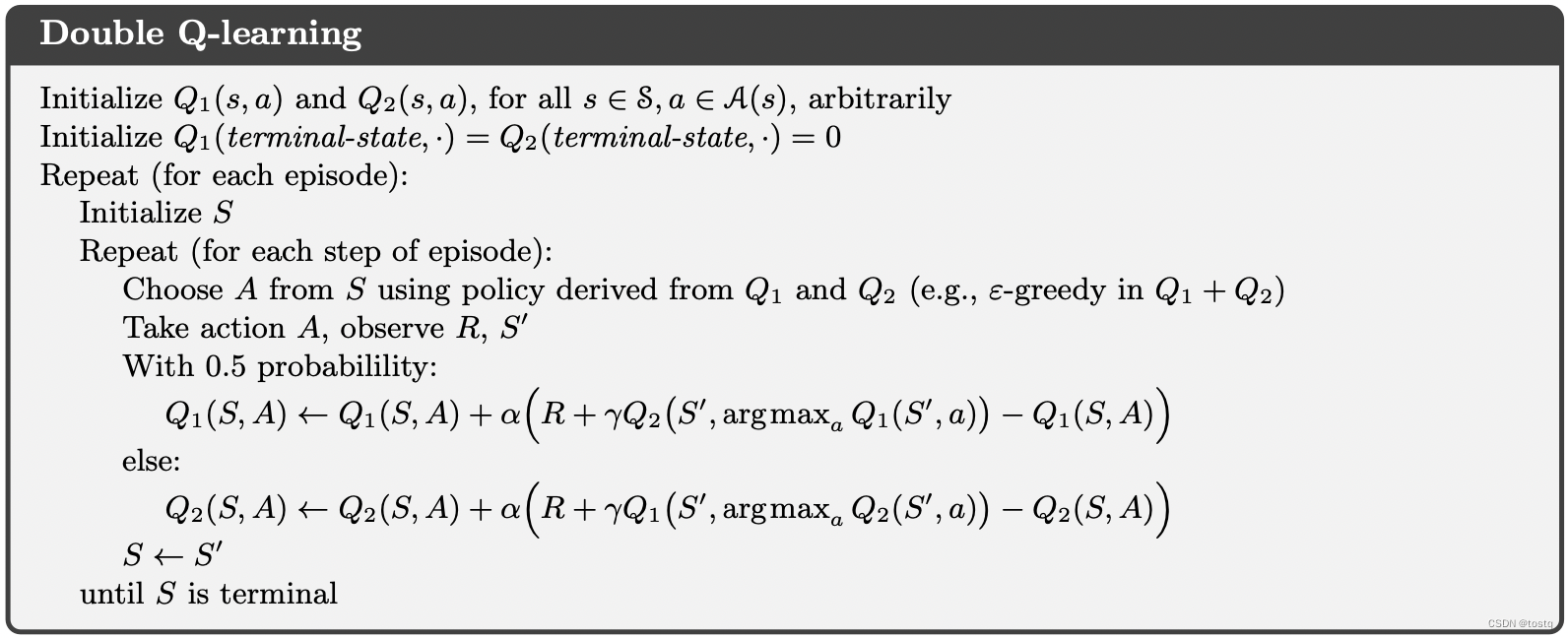

Hay otra forma llamada Double Q-learning, que cree que el sesgo de maximización es causado principalmente por la distribución (hay una probabilidad mayor que la expectativa, debe haber una probabilidad menor que la expectativa), porque distorsiona esto a través de dos Q independientes. desviación de las distribuciones.