前言

最近整理以前的笔记,发现还是写了一些文章的,以前都是记录在自己的笔记空间,没有分享,打算逐步进行分享,笔记的内容有工程方面的、有算法方面的,比较杂。

文末有福利!

线性模型的基本形式

-

输入:x=(x1;x2;x3;...;xd)。表示:示例有d个属性,xi表示第i个属性;y表示输入x的标记。(x,y)组成样本点。

-

输出:通过训练样本集,学习一个通过属性的线性组合进行预测的函数

f(x) = w1x1 + w2x2 + w3x3 + ... + wdxd;

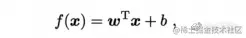

一般用向量形式写成:

线性模型形式简单、易于建模,但是却蕴含着机器学习中的一些重要的基本思想。

线性回归

- 输入:给定数据集D = {(x1,y1), (x2,y2), ... ,(xm, ym)},其中xi=(xi1;xi2;xi3;...;xid),y术语R,输出标记;

- 输出:回归模型,该模型尽可能准确的预测实值输出标记;

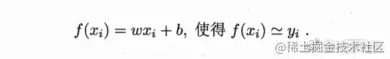

由于输入x有很多的属性,我们为了方面研究,暂时只考虑只有一个属性的情况,之后我们再研究多个属性的情况。那么问题转化为,求如下的线性模型(目标函数)

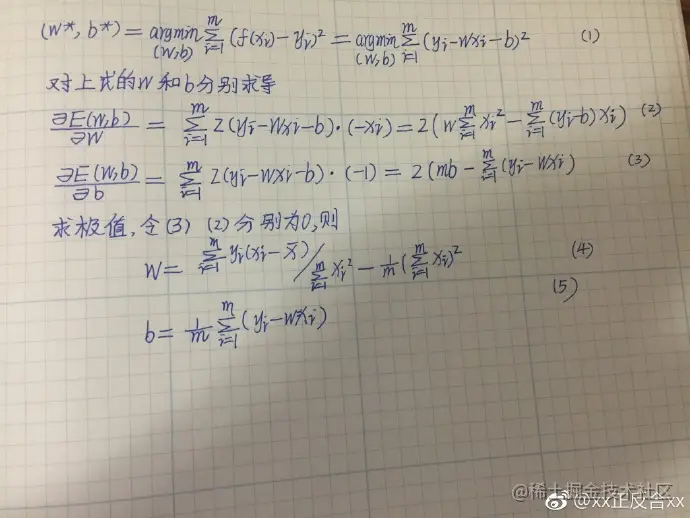

ok,到目前为止,我们已经知道了我们要求解的目标函数,那么损失函数或者或代价函数如何定义呢,我们要采用什么样的方法来确定目标函数中的参数w和参数b呢?

- 损失函数 下面先介绍几个术语

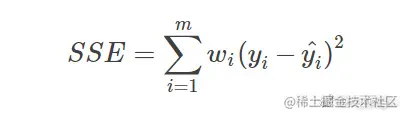

- SSE(和方差):在统计学里,该参数计算的是拟合数据跟原始数据对应点的误差的平方和,计算公式为:

image

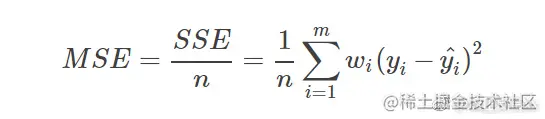

- 均方误差:该统计参数是预测数据和原始数据对应点误差的平方和的均值,也就是SSE / n,和SSE没有太大的区别,计算公式为,

- ok,那么目前我们已知的是,我们有个训练样本集,有m个样本点,每个样本点有1个属性,一个标记。我们要求出一个模型,这个模型要尽量拟合所有的训练样本点,那么一个朴素的思想就是通过该模型预测的标记与真正的标记的偏差和最小-- ==最小二乘法==;公式如下推倒:

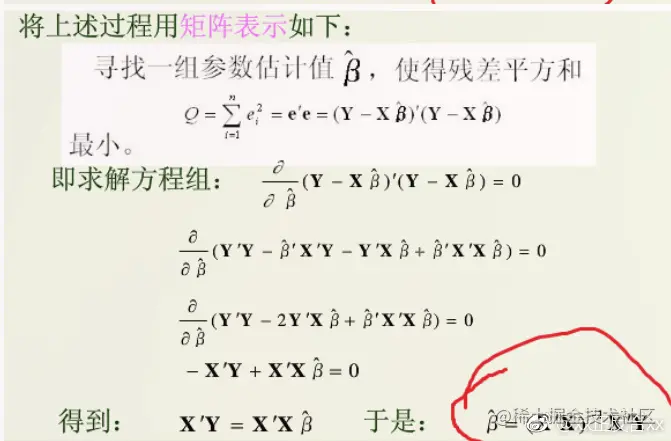

多元回归

多元回归的处理如下:

ps:迪迦粉丝专属福利来了!为感谢大家的支持~,(只要是关注了迪迦的朋友,200G人工智能学习大礼包免费领取!)

只需要你点个关注,然后扫码添加助手小姐姐VX即可无套路领取,或者加入迪迦的粉丝交流群:796741749也可领取!

扫码添加即可