人工智能、机器学习与深度学习

人工智能

定义

个人浅定义:让计算机机器模拟能到学习跟人一样掌握某种技能。类似于弱人工智能。如果让计算机跟人类一样具有自主 的情感,具有自主意识。那么可以理解为强人工智能。如果出现像钢铁侠这种的,智能化超过人类的,超级人工智能。

人工智能

- 强人工智能:认为有可能制造出真正能推理和解决问题的智能机器,这样的机器被认为是有自主意识的

- 弱人工智能:认为不可能制造出能真正进行推理和解决问题的智能 机器,这些机器只不过看起来像是智能的,但是并不真正拥有智能, 也不会有自主意识

- 超级人工智能:机器的智能彻底超过了人类,“奇点”2050年到来?

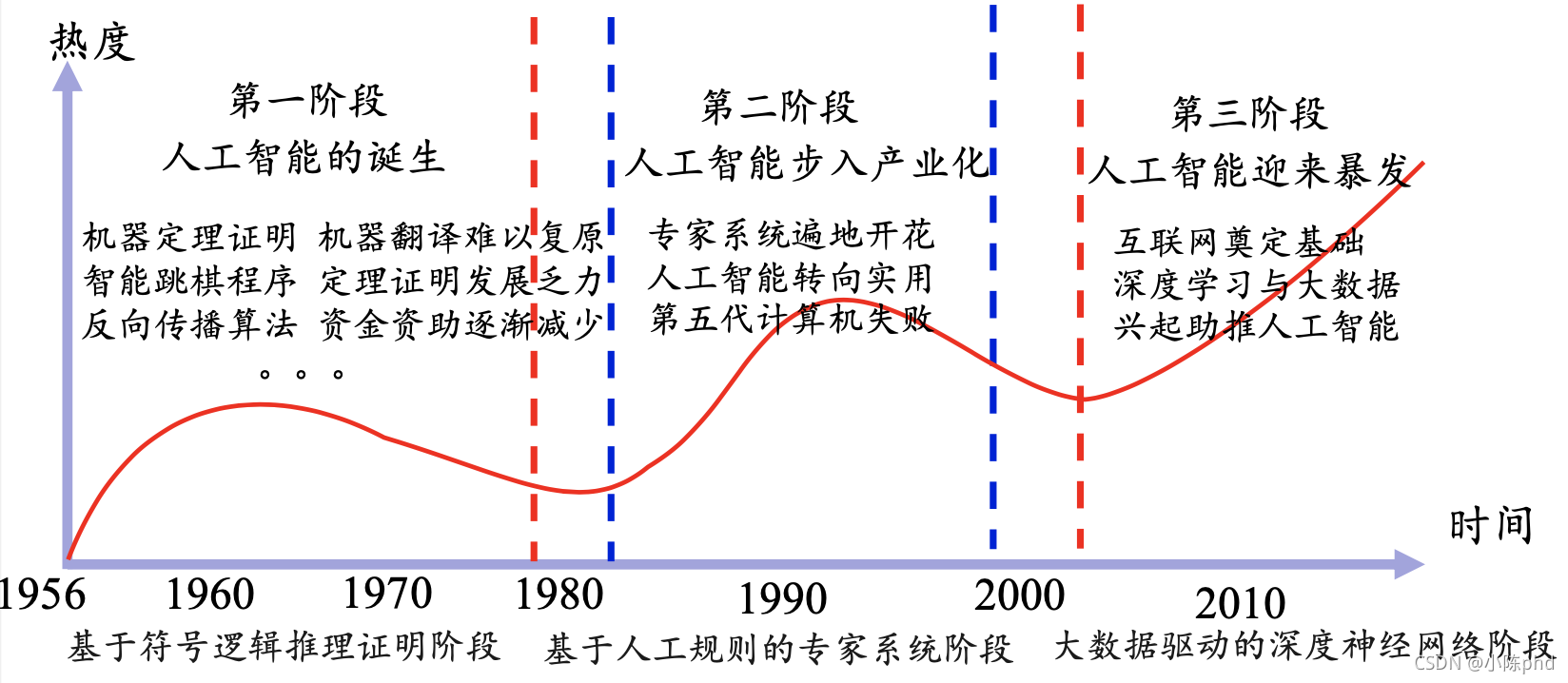

历史

机器学习

定义:从已知数据中获得规律,并利用规律对未知数据进行预测的技术

分类,按照监督方式

-

有监督学习,有标签有数据,学习已有标签的数据,来对数据进行预测。

-

半监督学习,少部分有标签,大部分没标签,也就是少部分已知,大部分未知,利用少部分的这份数据,来对着未知标签进行学习。目钱也归为自监督学习一类。

-

无监督学习,没有标签,让计算机自己进行自学,通过相同相似的数据聚合在一起。

-

第一阶段,主要是当时因为感知机连最简单的异或问题都没法解决,让人们进一步丧失了信心

-

第二阶段,辛顿提出了BP神经网络,解决了此类问题,并且BP网络的应用在大多数问题上证明有效且合适。但是BP网络在深层网络中的表现依然不尽人意,一直成为当时的’卡脖子‘问题。

-

06年辛顿提出了反向传播算法。后面科学家发现了许多新兴的激活函数,初始化方式等,有效解决了梯度爆炸和梯度弥散问题。

-

知名大牛

- 辛顿 ---- 提供饭碗的大大,提出BP和深度网络

- 杨乐坤 - 卷积神经网络的大大,辛顿学生

- Bengio - 小花书的作者之一,然后入门表示看不懂。。LSTM是他干的!

- 知名网红老师:吴恩达,入门首选。

-

知名机构

- DeepMind

- OpenAI

深度学习

深度学习定义:一般是指通过训练多层网络结构对未知数据进行分类或回归,体现深度,直接体现就是层数多了…

深度学习分类:有监督学习方法——深度前馈网络、卷积神经网络、循环神经网络等;无监督学习方法——深度信念网、深度玻尔兹曼机,深度自编码器等。

主要应用

CV:目标检测,姿态估计,图像分割、分类。

语音:语音合成,识别

NLP:文字,情感,翻译

~~~ 忘了,还有个TTS

数学基础

张量基本知识

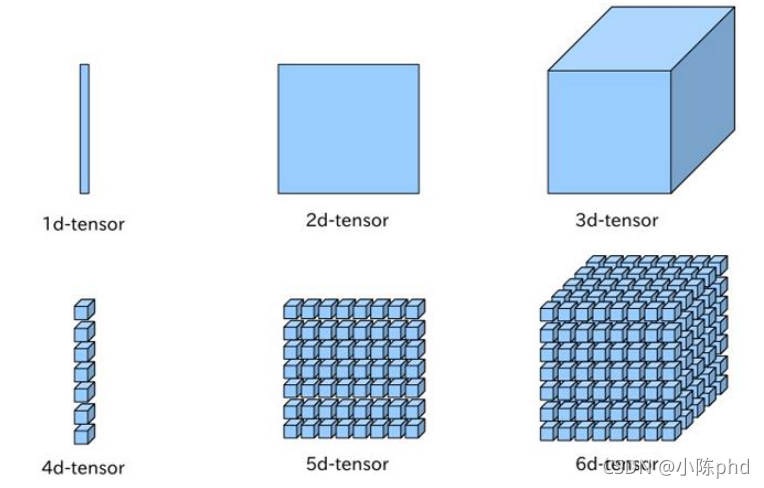

张量:万物皆可张量,

标量---------> 0 维度张量

向量---------> 1维度张量

矩阵---------> 2 维度张量

张量---------> 3 维度以及以上,张量

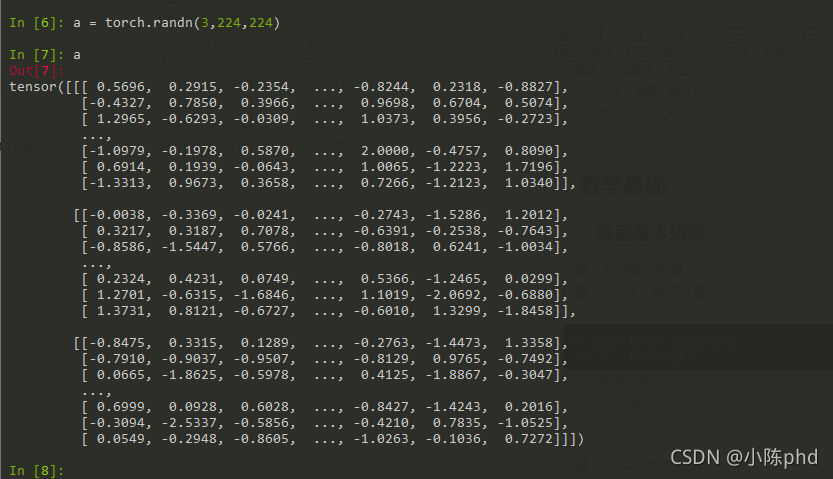

以一张RGB 的224*224图像为例。

矩阵的秩:

矩阵列向量中的极大线性无关组的数目,记作矩阵的列秩,同样可以定义行秩。行秩=列秩=矩阵的秩,通常记作rank(A)。

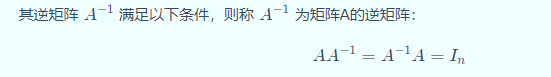

矩阵的逆

若矩阵A为方阵,当 rank(A_{n×n})<nrank(A n×n)<n时,称A为奇异矩阵或不可逆矩阵;

若矩阵A为方阵,当 rank(A_{n×n})=nrank(A n×n)=n时,称A为非奇异矩阵或可逆矩阵。

奇异矩阵求逆比较难,,利用这个原理,最简单的解决办法可以利用最小二乘法。

矩阵的广义逆矩阵

- 如果矩阵不为方阵或者是奇异矩阵,不存在逆矩阵,但是可以计算其广义逆矩阵或者伪逆矩阵;

- 对于矩阵A,如果存在矩阵 BB 使得 ABA=AABA=A,则称 BB 为 AA 的广义逆矩阵。

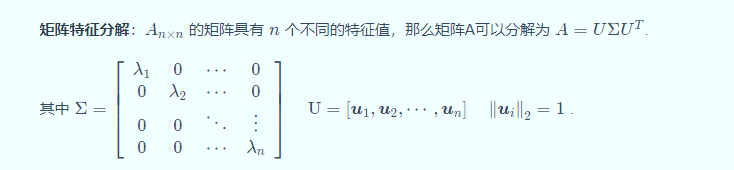

矩阵分解

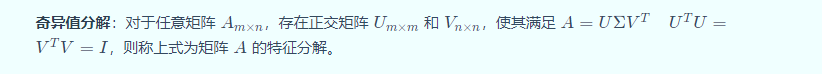

机器学习中常见的矩阵分解有特征分解和奇异值分解。

先提一下矩阵的特征值和特征向量的定义:

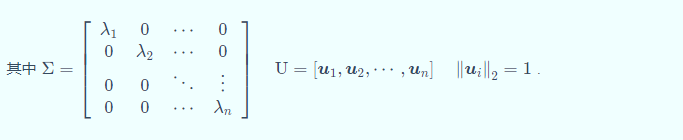

矩阵特征分解

总结其实:一个向量可以有在维度内的多个正交向量组合而成,是不是有点像高中的,一个向量可以由多个向量线性组合组成。

常见的概率分布

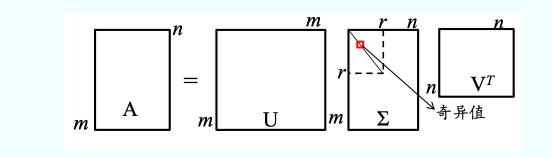

0-1 分布(请说伯努利分布,高大上些):

二项分布

- 重复n次伯努利实验,实验之间相互独立。

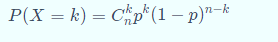

- 如果每次试验时,事件发生的概率为p,不发生的概率为1-p,则n次重复独立试验中事件发生k次的概率为

均匀分布

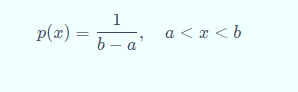

均匀分布,又称矩形分布,在给定长度间隔[a,b]内的分布概率是等可能的,均匀分布由参数a,b定义,概率密度函数为

高斯分布 ***

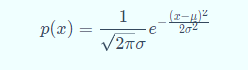

高斯分布,又称正态分布(normal),是实数中最常用的分布,由均值μ和标准差σ决定其分布,概率密度函数为:

指数分布

常用来表示独立随机事件发生的时间间隔,参数为λ>0的指数分布概率密度函数为:

特点:无记忆性

多变量概率分布

条件概率

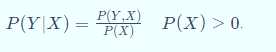

事件X在事件Y发生的条件下发生的概率,P(X|Y)

联合概率

两个事件X和Y共同发生的概率,P(X,Y)

条件概率和联合概率的关系

贝叶斯公式(重点掌握)

常用统计量

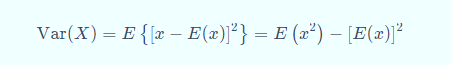

方差:衡量变量与数学期望的偏离程度。

协方差:其实可以衡量变量与变量之间的相关性(除此之外还有联合概率公式、余弦相似、互信息等等):

信息论

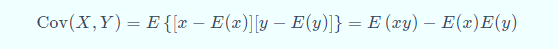

熵(Entropy)

- 衡量信息的多少。

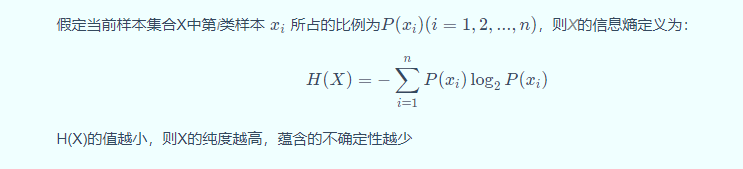

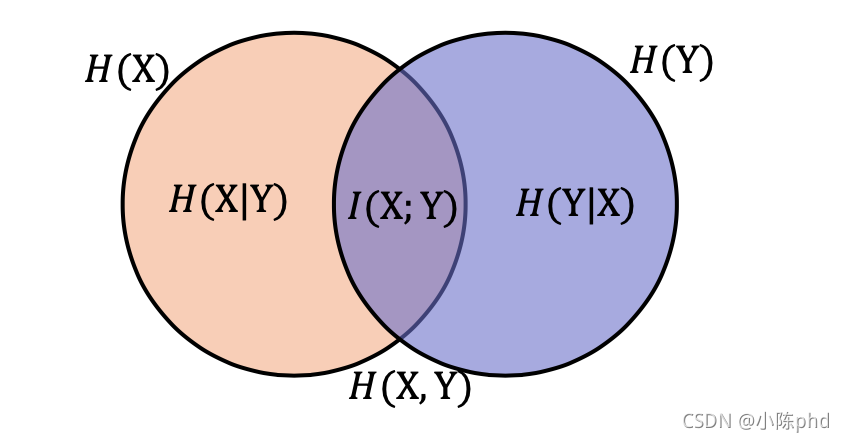

联合熵

两个随机变量X和Y的联合分布可以形成联合熵,度量二维随机变量XY的不确定性:

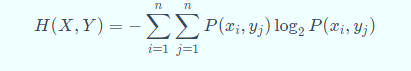

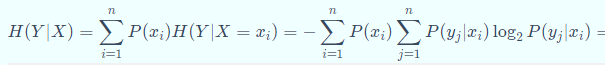

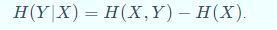

条件熵

在随机变量X发生的前提下,随机变量Y发生带来的熵,定义为Y的条件熵,用H(Y|X)表示,定义为:

条件熵用来衡量在已知随机变量X的条件下,随机变量Y的不确定。 熵、联合熵和条件熵之间的关系:

决策树算法中,就是利用前后熵的信息差异大小,来划分树节点

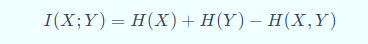

互信息

看起来,就是非公共部分

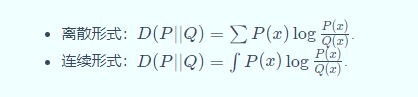

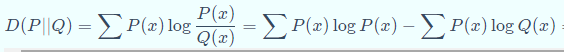

KL散度,相对熵

相对熵又称KL散度,是描述两个概率分布P和Q差异的一种方法,记做D(P||Q)。在信息论中,D(P||Q)表示用概率分布Q来拟合真实分布P时,产生的信息表达的损耗,其中P表示信源的真实分布,Q表示P的近似分布。

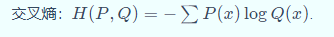

交叉熵

多分类常用softmax,二分类常用sigmoid.

一般用来求目标与预测值之间的差距,深度学习中经常用到的一类损失函数度量,比如在对抗生成网络( GAN )中

最小二乘估计

最小平方法,是一种数学优化方法。它通过最小化误差的平方和寻找数据的最佳函数匹配。最小二乘法经常应用于回归问题,可以方便地求得未知参数,比如曲线拟合、最小化能量或者最大化熵等问题。

优化目标: min w ∣ ∣ X w − y ∣ ∣ 2 2 \min_{w} || X w - y||_2^2 wmin∣∣Xw−y∣∣22

普通最小二乘法的系数估计依赖于特征的独立性。当特征与设计矩阵x的列相关时具有近似线性的相关性,设计矩阵变得接近奇异,因此,最小二乘估计对观察到的目标中的随机误差变得高度敏感,从而产生很大的方差。例如,在没有实验设计的情况下收集数据时,可能会出现这种多重共线性的情况。

参考github:

链接: datawhale.