Über den Autor: Ein Cloud-Computing-Netzwerk-Betriebs- und Wartungspersonal, das täglich Netzwerk-, Betriebs- und Wartungstechnologie sowie nützliche Informationen austauscht.

Öffentliches Konto: Netdou Cloud Computing School

Motto: Kopf gesenkt und respektvoll

Persönliche Homepage: Homepage von Internet Bean

schreibe vorne

Hallo zusammen, ich bin Wangdou, ein Blogger mit Schwerpunkt auf dem Bereich Betrieb und Wartung. Heute bringe ich Ihnen ein besonderes Thema: Fragen zu Betriebs- und Wartungsinterviews. Heutzutage, da sich die IT-Branche weiterentwickelt, beschränken sich Vorstellungsgespräche für Betriebs- und Wartungspositionen nicht mehr nur auf die Prüfung von Grundkenntnissen, sondern legen mehr Wert auf die praktische Erfahrung, die Problemlösungsfähigkeiten und die Einstellung der Kandidaten zu kontinuierlichem Lernen. Daher werden in diesem Artikel einige häufig gestellte Fragen zu Betriebs- und Wartungsinterviews mit Ihnen geteilt, damit Sie sich besser auf Vorstellungsgespräche vorbereiten und Ihre Wettbewerbsfähigkeit verbessern können.

Mit der Popularisierung von Cloud Computing, Big Data und anderen Technologien gewinnen Betriebs- und Wartungspositionen im IT-Bereich immer mehr an Bedeutung. Ein ausgezeichneter Betriebs- und Wartungsingenieur muss nicht nur über solide technische Grundlagen verfügen, sondern auch über gute Fähigkeiten zur Problemlösung, Teamgeist und Lernfähigkeit verfügen. Daher ist das Vorstellungsgespräch ein wichtiger Schritt bei der Auswahl hervorragender Betriebs- und Wartungsingenieure.

Im Vorstellungsgespräch prüft der Interviewer in der Regel Aspekte wie Grundkenntnisse, Praxiserfahrung, Teamarbeit und Lernfähigkeit. Im Folgenden werde ich die Interviewfragen in diesen Aspekten einzeln vorstellen und entsprechende Antwortideen und -techniken geben. Ich hoffe, dass dieser Artikel Ihnen dabei helfen kann, sich besser auf das Betriebs- und Wartungsgespräch vorzubereiten und Ihre Lieblingsposition zu finden.

Bitte beachten Sie, dass diese Fragen nur eine der häufigsten Fragen im Vorstellungsgespräch sind und andere Aspekte im eigentlichen Vorstellungsgespräch behandelt werden können. Daher empfiehlt es sich, sich bei der Vorbereitung auf Vorstellungsgespräche neben der Bewältigung dieser Fragen auch auf die umfassende Verbesserung Ihrer technischen Fähigkeiten und der Gesamtqualität zu konzentrieren.

Inhaltsverzeichnis

1. Erkennung der Festplattennutzung (mithilfe eines Shell-Skripts)

2.Welche Strategien gibt es für den LVS-Lastausgleich?

3. Erzählen Sie uns von Ihrem Verständnis von LVS?

4. Was ist das Prinzip des Lastausgleichs?

5. Aus welchen zwei Teilen besteht LVS?

6. Welche Begriffe gibt es im Zusammenhang mit LVS?

8. Eigenschaften des LVS-NAT-Modells

10. Eigenschaften des LVS-DR-Modells

1. Erkennung der Festplattennutzung (mithilfe eines Shell-Skripts)

root@ecs-c13b ~]# cat fdisk.sh

#!/bin/bash

# 截取IP

IP=`ifconfig eth0 |awk -F " " 'NR==2{print $2}'`

# 定义使用率,并转换为数字

SPACE=`df -Ph |awk '{print int($5)}'`

for i in $SPACE

do

if [ $i -ge 90 ]

then

echo "$IP的磁盘使用率已经超过了90%,请及时处理"

fi

done2.Welche Strategien gibt es für den LVS-Lastausgleich?

LVS verfügt über drei Arbeitsmodi: DR, Tunnel, NAT

3. Erzählen Sie uns von Ihrem Verständnis von LVS?

LVS ist ein virtuelles Server-Cluster-System, das Lastausgleichsfunktionen unter Unix-Systemen implementiert; es wird mithilfe der IP-Lastausgleichstechnologie und der opportunistischen Technologie zur Verteilung von Inhaltsanforderungen implementiert.

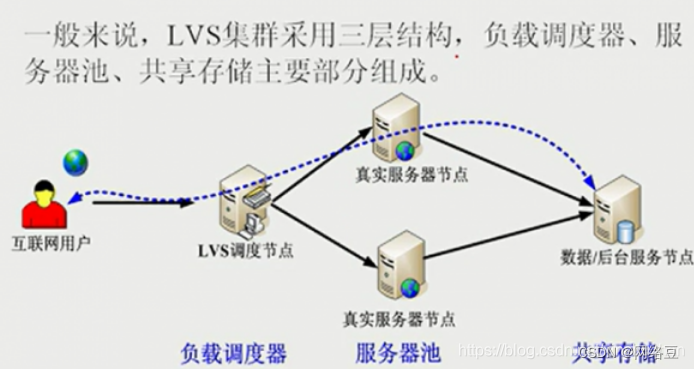

LVS verwendet eine dreischichtige Struktur:

erste Schicht: Lastplaner,

zweite Schicht: Service-Pool,

dritte Schicht: gemeinsam genutzter Speicher

Der Load Balancer/Director ist der Generalagent des gesamten Clusters. Er verfügt über zwei Netzwerkkarten, von denen eine zum Zugangsnetzwerk zeigt.

Auf der Client-Seite der Station ist eine Netzwerkkarte intern dem gesamten Cluster zugewandt. Verantwortlich für das Senden von Client-Anfragen zur Ausführung an eine Gruppe von Servern, und der Client glaubt auch, dass der Dienst von diesem Host kommt. Um ein anschauliches Beispiel zu geben: Der Cluster ist ein Unternehmen, und der Lastplaner soll Geschäfte von außen sammeln und die empfangenen Geschäfte an die tatsächlichen Hosts im Hintergrund verteilen, die tatsächlich funktionieren. Natürlich muss die Arbeit nach einem bestimmten Algorithmus verteilt werden, damit alle fair arbeiten können.

Der Serverpool (Serverpool/Realserver) ist eine Gruppe von Servern, die tatsächlich Clientanforderungen ausführen und als WEB-Server verwendet werden können. Dies ist der kleine Mitarbeiter im obigen Beispiel.

Shared Storage stellt einen gemeinsamen Speicherbereich für den Serverpool bereit, sodass der Serverpool problemlos über denselben Inhalt verfügen und dieselben Dienste bereitstellen kann. Ein Unternehmen muss über ein Back-End-Konto verfügen, damit es koordiniert werden kann. Andernfalls zahlt der Kunde das Geld an A und B erhält den Kunden, weil er nicht das gleiche Konto hat. B sagte, dass der Kunde nicht bezahlt habe, es sei also kein Problem der Kundenerfahrung.

4. Was ist das Prinzip des Lastausgleichs?

Wenn der Client eine Anfrage initiiert, wird die Anfrage direkt an den Director-Server (Scheduler) gesendet. Zu diesem Zeitpunkt wird die Anfrage gemäß dem festgelegten Planungsalgorithmus intelligent an den realen Backend-Server verteilt. um den Druck gleichmäßig zu verteilen.

Aber wir wissen, dass HTTP-Verbindungen zustandslos sind. Angenommen, es gibt ein Szenario, in dem ich mich in einem bestimmten Geschäft anmelde, um etwas zu kaufen. Wenn mir ein bestimmtes Produkt gefällt, füge ich es dem Warenkorb hinzu, aktualisiere aber die Seite. Zu diesem Zeitpunkt Aufgrund des Lastausgleichs wählte der Planer einen neuen Server aus, um Dienste für mich bereitzustellen. Der gesamte Inhalt meines Warenkorbs war verschwunden, was zu einer sehr schlechten Benutzererfahrung führte.

Daher ist eine Speicherfreigabe erforderlich, um sicherzustellen, dass die vom Benutzer angeforderten Daten identisch sind.

5. Aus welchen zwei Teilen besteht LVS?

LVS besteht aus zwei Programmen, darunter ipvs und ipvsadm.

1. ipvs (virtueller IP-Server): Ein Codeteil namens ipvs, der im Kernelbereich arbeitet, ist der Code, der die Planung tatsächlich implementiert.

2. ipvsadm: Der andere Abschnitt arbeitet im Benutzerbereich und heißt ipvsadm. Er ist dafür verantwortlich, Regeln für das IPvs-Kernel-Framework zu schreiben und zu definieren, wer der Clusterdienst

und wer der echte Back-End-Server (realer Server) ist.

6. Welche Begriffe gibt es im Zusammenhang mit LVS?

DS: Director-Server. Bezieht sich auf den Front-End-Load-Balancer-Knoten.

RS: Echter Server. Der wirklich funktionierende Server im Backend.

VIP: Virtuelle IP fordert den Benutzer direkt von außen als IP-Adresse des Ziels der Benutzeranforderung an.

DIP: Director Server IP, eine IP-Adresse, die hauptsächlich für die Kommunikation mit internen Hosts verwendet wird.

RIP: Echte Server-IP, die IP-Adresse des Backend-Servers.

CIP: Client IP, die IP-Adresse des Zugriffsclients.

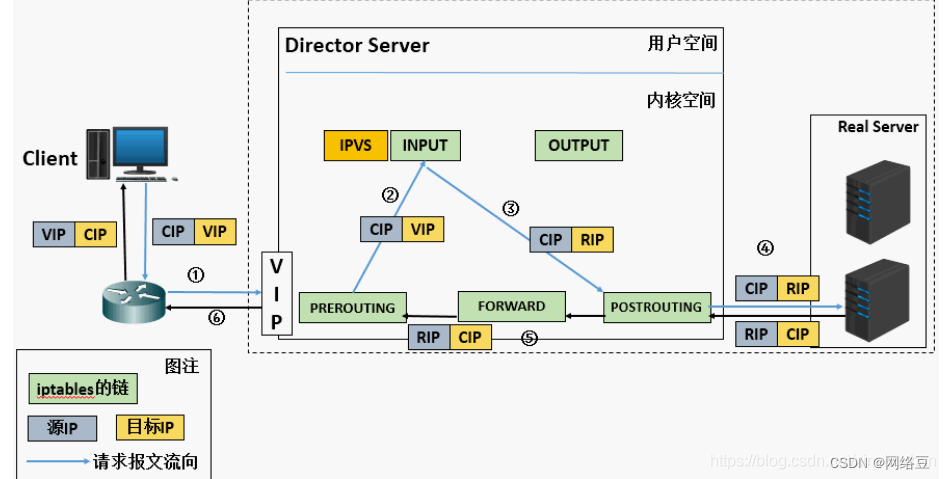

7. Prinzip des LVS-NAT-Modus

(a). Wenn die Benutzeranforderung den Director-Server erreicht, wird das angeforderte Datenpaket zunächst an die PREROUTING-Kette im Kernelraum weitergeleitet.

Zu diesem Zeitpunkt ist die Quell-IP des Pakets CIP und die Ziel-IP VIP

(b). PREROUTING prüft und stellt fest, dass die Ziel-IP des Pakets der lokale Computer ist, und sendet das Paket an die INPUT-Kette

©. IPVS vergleicht, ob Der vom Paket angeforderte Dienst ist ein Clusterdienst. Wenn ja, ändern Sie die Ziel-IP-Adresse des Datenpakets in die Back-End-Server-

IP und senden Sie das Datenpaket dann an die POSTROUTING-Kette. Zu diesem Zeitpunkt ist die Quell-IP der Nachricht CIP und die Ziel-IP RIP

(d). Die POSTROUTING-Kette wählt die Route aus und sendet das Datenpaket an den realen Server

(e). Der reale Server vergleicht und findet das Ziel ist seine eigene IP und beginnt mit dem Erstellen einer Antwortnachricht. Wird an den Director-Server zurückgesendet. Zu diesem Zeitpunkt ist die Quell-IP der Nachricht

RIP und die Ziel-IP CIP

(f). Bevor der Director-Server dem Client antwortet, ändert er die Quell-IP-Adresse in seine eigene VIP-Adresse und antwortet dann dem Client

. Zu diesem Zeitpunkt ist die Quell-IP der Nachricht VIP und die Ziel-IP CIP.

8. Eigenschaften des LVS-NAT-Modells

RS sollte eine private Adresse verwenden und das Gateway von RS muss auf DIP verweisen.

DIP und RIP müssen sich im selben Netzwerksegment befinden.

Sowohl Anforderungs- als auch Antwortnachrichten müssen über Director Server geleitet werden. In Hochlastszenarien kann Director Server dies problemlos tun wird zu einem Leistungsengpass.

Unterstützt Port-Mapping.

RS kann verwendet werden. Jedes Betriebssystem.

Nachteile: Der Druck auf den Director-Server ist relativ hoch. Sowohl Anfragen als auch Antworten müssen über den Director-Server laufen.

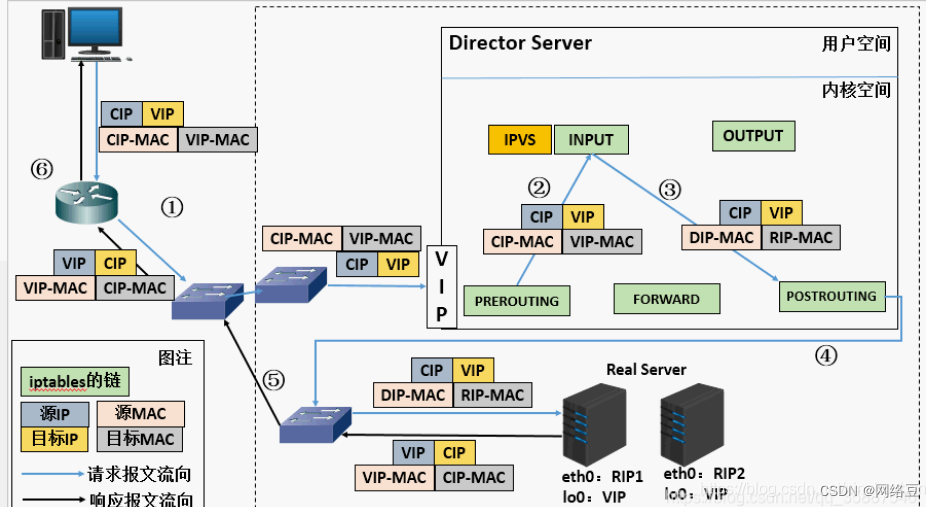

9. Prinzip des LVS-DR-Modus

(a) Wenn eine Benutzeranfrage den Director-Server erreicht, wird das angeforderte Datenpaket zunächst an die PREROUTING-Kette im Kernelraum weitergeleitet. Zu diesem Zeitpunkt ist die Quell-IP der Nachricht CIP und die Ziel-IP VIP.

(b) Die PREROUTING-Prüfung stellt fest, dass die Ziel-IP des Datenpakets der lokale Computer ist, und sendet das Datenpaket an die INPUT-Kette

(c) IPVS vergleicht, ob der vom Datenpaket angeforderte Dienst ein Clusterdienst ist. Wenn ja, ändert es die Quell-MAC-Adresse in der Anforderungsnachricht in die MAC-Adresse von DIP und die Ziel-MAC-Adresse in die MAC-Adresse von RIP. und sendet dann das Datenpaket an POSTROUTING CHAIN. Zu diesem Zeitpunkt wurden weder die Quell-IP noch die Ziel-IP geändert. Nur die Quell-MAC-Adresse wurde in die MAC-Adresse von DIP geändert, und die Ziel-MAC-Adresse wurde in die MAC-Adresse von RIP geändert.

(d) Da sich DS und RS im selben Netzwerk befinden, werden sie über Layer 2 übertragen. Die POSTROUTING-Kette überprüft, ob die Ziel-MAC-Adresse die MAC-Adresse von RIP ist, und sendet dann das Datenpaket zu diesem Zeitpunkt an den realen Server.

(e) RS stellt fest, dass die MAC-Adresse der Anforderungsnachricht seine eigene MAC-Adresse ist, und empfängt die Nachricht. Nach Abschluss der Verarbeitung wird die Antwortnachricht über die lo-Schnittstelle an die eth0-Netzwerkkarte gesendet und dann gesendet. Zu diesem Zeitpunkt ist die Quell-IP-Adresse VIP und die Ziel-IP CIP.

(f) Die Antwortnachricht wird schließlich an den Client übermittelt

10. Eigenschaften des LVS-DR-Modells

Funktion 1: Stellen Sie sicher, dass das Front-End-Routing alle Pakete mit Zieladressen an VIP an Director Server statt an RS sendet

RS kann eine private Adresse verwenden; es kann auch eine öffentliche Netzwerkadresse sein. Wenn eine öffentliche Netzwerkadresse verwendet wird, kann auf RIP direkt über das Internet zugegriffen werden.

RS und Director Server müssen sich im selben physischen Netzwerk befinden

Alle Anforderungsnachrichten passieren den Director-Server, Antwortnachrichten dürfen jedoch nicht den Director-Server passieren.

Unterstützt keine Adressübersetzung oder Portzuordnung

RS kann die gängigsten Betriebssysteme sein

Das Gateway von RS darf niemals auf DIP verweisen (da wir es nicht zulassen, dass es den Director passiert).

Konfigurieren Sie die VIP-IP-Adresse auf der lo-Schnittstelle des RS

Defekt: RS und DS müssen sich im selben Computerraum befinden

Abschließend hoffe ich, dass dieser Artikel Ihnen dabei helfen kann, im Betriebs- und Wartungsgespräch gute Ergebnisse zu erzielen und Ihre Karriereziele zu erreichen. Wenn Sie weitere Fragen haben oder weitere Hilfe benötigen, können Sie mich gerne fragen. Ich wünsche Ihnen viel Erfolg im Bereich Betrieb und Wartung!