Notas de papel EfficientNet

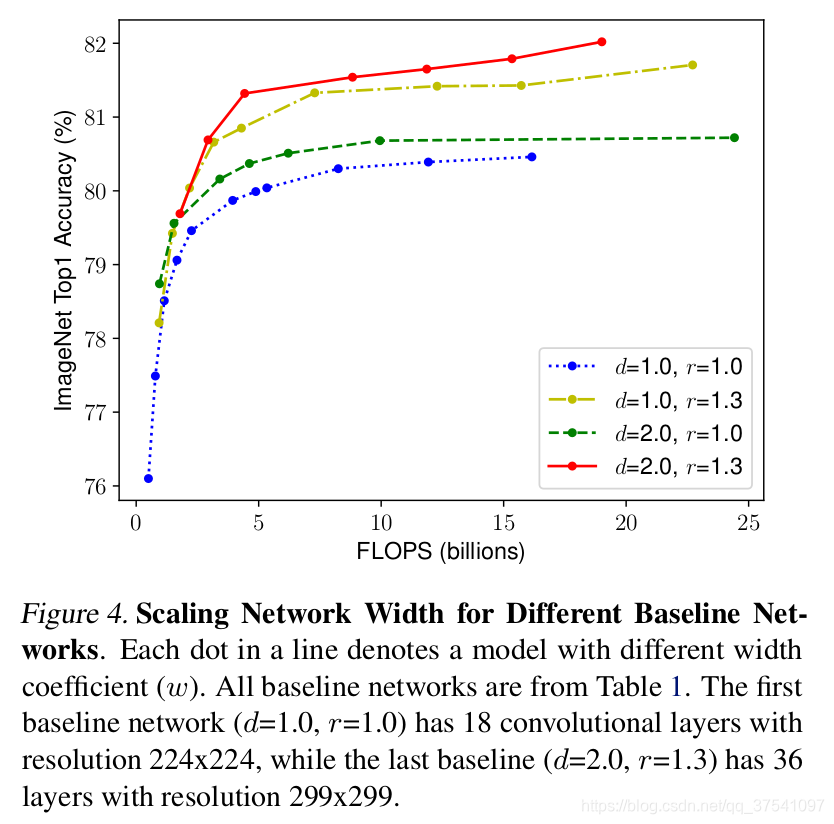

Balanceamos canal, profundidade e resolução por meio do NAS e descobrimos que, nos mesmos FLOPs, aumentar a profundidade e a resolução ao mesmo tempo tem o melhor efeito.

O que devo fazer se o efeito do conjunto de dados for menor que a resolução?

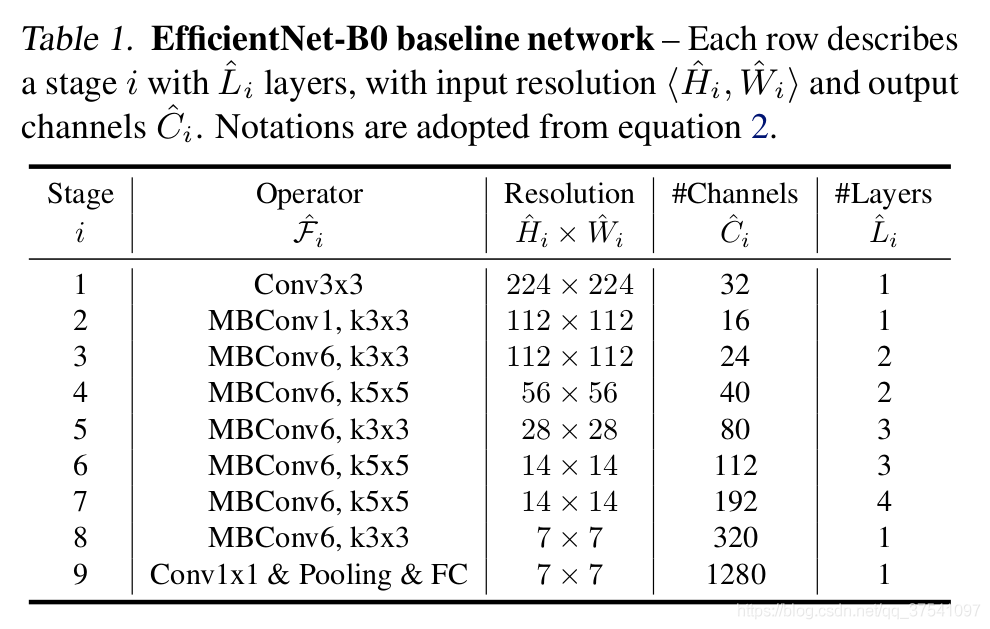

Estrutura EfficientNet — b0

Cada MBConv na tabela será seguido por um número 1 ou 6. O 1 ou 6 aqui é o fator de ampliação n. Ou seja, a primeira camada de convolução 1x1 no MBConv expandirá os canais da matriz de recursos de entrada para n vezes , onde k3x3 ou k5x5 representa o tamanho do kernel de convolução usado pelo Depthwise Conv no MBConv. Canais representa os canais que geram a matriz de recursos após passar pelo palco.

Estrutura MBConv

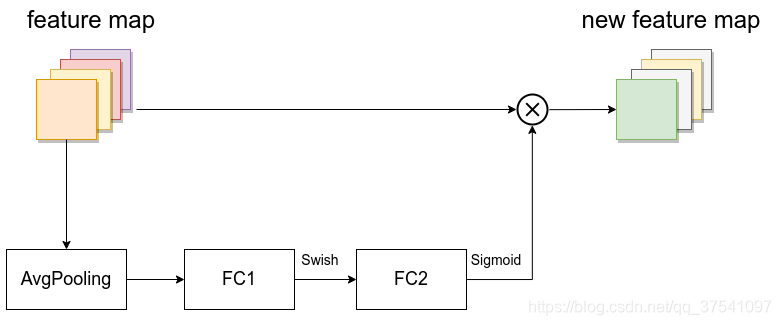

Função de ativação Swish + módulo SE

- A primeira camada de convolução 1x1 dimensionalmente ascendente tem n vezes o número de núcleos de convolução como canal de matriz de recursos de entrada.Esta camada não é necessária quando n é igual a 1.

- Usado somente quando a matriz de recursos da estrutura MBConv de entrada tem o mesmo formato que a matriz de recursos de saída. Na implementação do código-fonte, existe uma camada Dropout apenas quando o atalho é usado.

Módulo SE:

A primeira função de ativação é substituída pela função de ativação Swish

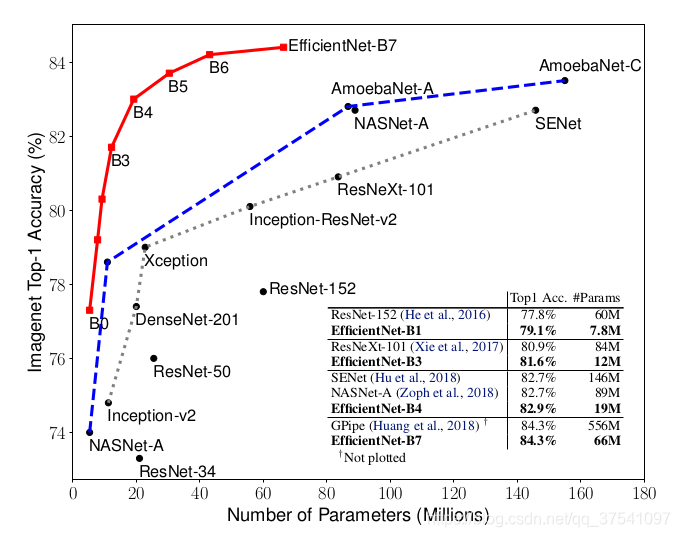

Parâmetros detalhados para outras versões:

input_sizeRepresenta o tamanho da imagem da rede de entrada ao treinar a redewidth_coefficientRepresenta o fator de ampliação na dimensão do canal. Por exemplo, o número de núcleos de convolução usados na camada de convolução 3x3 do Estágio1 em EfficientNetB0 é 32, então em B6 é 32 × 1,8 = 57,6 e então arredondado para o número inteiro mais próximo de 8. Os tempos são 56, e o mesmo se aplica às demais etapas (operações aceleradas).depth_coefficientRepresenta o fator de ampliação na dimensão de profundidade (somente para Stage2 a Stage8).Por exemplo, em EfficientNetB0, Li=4 para Stage7, então em B6 é 4 (bloco) × 2,6 = 10,4 e depois arredondado para 11drop_connect_rateé o drop_rate usado pela camada de dropout na estrutura MBConv.dropout_rateÉ o dropout_rate da camada de dropout antes da última camada totalmente conectada (entre Pooling e FC no estágio 9).

NAS:Pesquisa de Arquitetura Neural

aprendizagem por reforço