Lucro acima da privacidade: aumenta a coleta de dados opacos

Antecedentes e Riscos

As ferramentas de IA generativa são construídas com base em uma variedade de modelos grandes e complexos de aprendizado de máquina que exigem grandes quantidades de dados de treinamento para serem eficazes. Para ferramentas como ChatGPT, os dados incluem texto extraído da internet. Para produtos como Lensa ou Stable Diffusion, os dados incluem fotos e arte. Devido às enormes demandas de dados da IA generativa, muitos desenvolvedores de IA podem vasculhar indiscriminadamente a web em busca de dados. Embora em alguns casos esses desenvolvedores tenham tentado higienizar seus dados de treinamento filtrando trabalhos protegidos, conteúdo explícito, discurso de ódio ou informações tendenciosas, a prática de higienizar os dados fica muito aquém dos padrões do setor. Na ausência de regras significativas de minimização ou divulgação de dados, as empresas têm um incentivo para recolher e utilizar quantidades crescentes de dados (e mais sensíveis) para treinar modelos de IA. O pretexto para a recolha indiscriminada destes dados aumenta a concorrência e a inovação na IA, o que é prejudicial ao estado da privacidade dos dados. Esta narrativa da corrida armamentista cria a razão para maximizar a recolha de dados, caso mais tarde proporcione alguma vantagem vaga. Na verdade, estas ferramentas podem ser construídas com menos dados e sem processos obrigatórios e secretos de recolha de dados.

Buscar para treinar dados

Muitas ferramentas generativas de inteligência artificial utilizam modelos construídos com base em dados coletados de sites disponíveis publicamente. Essas informações geralmente incluem informações pessoais publicadas em mídias sociais e outros sites. As pessoas postam nas redes sociais e em outros lugares por vários motivos: para permitir que potenciais empregadores as encontrem no LinkedIn; para que amigos e conhecidos possam encontrá-las no Facebook, Twitter e Venmo; O objetivo de postar informações em um site é fazer com que o informações visíveis nesse site. Mas às vezes, as informações pessoais de uma pessoa são tornadas públicas sem o seu consentimento. Terceiros poderão publicar as suas fotografias ou outras informações sobre eles. As configurações de privacidade confusas de uma plataforma podem levar uma pessoa a divulgar acidentalmente suas informações. Bugs de software ou alterações de design também podem expor informações que uma pessoa definiu para serem visíveis apenas para alguns selecionados.

Quando as empresas recolhem informações pessoais e as utilizam para criar ferramentas de geração de inteligência artificial, estão a utilizar as informações para fins que os consumidores não consentem, minando assim o controlo dos consumidores sobre as suas informações pessoais. Quando um indivíduo coloca seus dados online, ele pode nem pensar que seus dados serão utilizados por uma empresa. Armazenar ou hospedar dados pessoais roubados nem sempre pode ser prejudicial em seu estado inicial, mas há muitos riscos. Vários conjuntos de dados podem ser combinados de formas prejudiciais: informações que são insensíveis quando divulgadas em diferentes bases de dados podem ser muito reveladoras quando recolhidas num só local e podem ser utilizadas para tirar inferências sobre uma pessoa ou grupo de pessoas. Como a raspagem replica os dados de alguém tal como existiam num determinado momento, a empresa também retira a capacidade de um indivíduo alterar ou remover informações do domínio público.

Os riscos de privacidade decorrentes da recolha indiscriminada de informações pessoais para dados de formação em IA também representam riscos para o discurso online e para a abertura da Internet. À medida que as ferramentas de inteligência artificial utilizam as informações pessoais das pessoas para fins cada vez mais prejudiciais, as pessoas podem ficar mais hesitantes em partilhar qualquer informação que possa ser roubada no futuro nas redes sociais ou em websites, mesmo que esses sites prometam proteger os seus dados. Podem ser menos propensos a publicar fotografias suas, a participar em debates públicos nos "grandes fóruns públicos da Internet", especialmente nas redes sociais, ou a ter perfis nas redes sociais ou websites pessoais associados a eles. Negar às pessoas o direito de participar no discurso público e na interacção online limitará a utilidade da Internet em geral, e das ferramentas web em particular.

Os princípios básicos de minimização de dados estabelecem que as informações pessoais das pessoas só devem ser utilizadas para a finalidade específica para a qual cada indivíduo as forneceu. Mas atualmente não existem regulamentações que impeçam as empresas de roubar informações pessoais das pessoas e usá-las para treinar ferramentas generativas de inteligência artificial. As leis de privacidade dos EUA isentam a maioria das informações publicamente disponíveis de regulamentação devido a preocupações de que sua coleta e uso sejam protegidos pela Primeira Emenda. Mas os legisladores subestimaram os importantes interesses antitrust da privacidade de permitir que as empresas obtivessem acesso indiscriminado a informações pessoais.

As pessoas devem poder postar fotos de perfis públicos sem medo de que sejam usadas para criar deepfakes ou alimentar outros aplicativos que abusam de IA. As leis que restringem a recolha e/ou utilização subsequente de informações pessoais publicamente disponíveis protegem o interesse das pessoas em controlar as suas informações e incentivam as pessoas a continuarem a divulgar informações na Internet.

Gere dados de usuário de IA

Muitas ferramentas generativas de IA exigem que o usuário faça login para acessar, e muitas retêm informações do usuário, incluindo informações de contato, endereços IP e todas as entradas e saídas do usuário, ou “conversas”, dentro do aplicativo. Estas práticas envolvem questões de consentimento, uma vez que as ferramentas generativas de IA utilizam estes dados para treinar ainda mais os modelos, tornando os seus produtos “gratuitos” à custa dos dados do utilizador utilizados para treinar as ferramentas. Conforme discutido na próxima seção, isso é consistente com a segurança, mas as práticas recomendadas incluem não exigir que os usuários façam login para usar a ferramenta e não reter ou usar conteúdo gerado pelo usuário em qualquer momento após o uso ativo pelo usuário.

Gerar resultados de IA

As ferramentas de IA generativa podem compartilhar inadvertidamente informações pessoais sobre uma pessoa ou sobre a empresa de uma pessoa, ou podem incluir elementos pessoais em fotos. Em particular, as empresas preocupadas com a incorporação dos seus segredos comerciais no modelo pelos funcionários proibiram explicitamente os funcionários de utilizar o modelo.

ferir

- Física : Indivíduos que desejam que seus dados pessoais sejam excluídos para sua própria segurança, como vítimas de violência doméstica ou perseguição, podem não conseguir fazê-lo porque os dados são adicionados ao conjunto de dados de IA resultante e, portanto, podem estar em risco de seu agressor.

- Perdas financeiras/econômicas : As empresas cujos segredos comerciais são incorporados ao treinamento enfrentam possíveis perdas financeiras.

- Psicológico : Indivíduos que não conseguem remover dados pessoais do conjunto de treinamento podem enfrentar frustração ou medo se esses dados os impactarem negativamente se forem divulgados.

- Autonomia : Indivíduos que não conseguem impedir a adição ou remoção forçada de informações pessoais do conjunto de treinamento perderam claramente o controle de seus dados.

- Autonomia : Os indivíduos muitas vezes não são informados, consultados ou escolhidos sobre se os dados pessoais são ou não adicionados ao conjunto de dados de treinamento.

- Autonomia/Perda de Oportunidade : A falha em excluir ou atualizar dados imprecisos ou que não sejam mais precisos pode levar a resultados errôneos, que então se agravam à medida que a desinformação prolifera.

exemplo

- A Autoridade Italiana de Proteção de Dados iniciou ações de fiscalização sob o Regulamento Geral de Proteção de Dados da União Europeia contra OpenAI, proibindo o uso do serviço no país enquanto se aguarda uma investigação. Isso levou a empresa a impor algumas divulgações e controles de privacidade ao sistema. O interesse regulamentar de instituições de todo o mundo pode funcionar como um catalisador para um melhor comportamento em matéria de proteção de dados.

- Fotos de prontuários particulares foram encontradas no banco de dados público LAION-5B, que foi utilizado para confecção do gerador de imagens.

intervenção

- Aplicar leis que proíbam práticas comerciais injustas e enganosas, exigir o consentimento de crianças usuárias e exigir justificativa para o processamento de dados.

- Promulgar leis e regulamentos que impõem padrões de minimização de dados e limitam o uso de dados pessoais para gerar treinamento em IA (por exemplo, a Lei de Proteção à Privacidade de Dados dos EUA, Regras de Supervisão Empresarial da FTC e certas regulamentações estaduais de privacidade)

- Suporte para ferramentas criadas com conjuntos de dados limitados e disponíveis publicamente.

- Os desenvolvedores empregam padrões rígidos de minimização de dados para ajudar a mitigar os riscos de privacidade decorrentes da criação, ajuste e atualização de modelos para treinar IA. A minimização de dados é uma norma que, por definição exata, só deve permitir a recolha de dados pessoais na medida necessária à execução do serviço solicitado pelo utilizador. O princípio da minimização de dados está fundamentalmente em conflito com o princípio da criação de conjuntos de dados generativos de IA em escala a partir de informações públicas, sem divulgação ou consentimento.

Aumento do risco de segurança de dados

Antecedentes e Riscos

O Identity Theft Resource Center estima um recorde de 1.862 violações de dados em 2021; e outras 1.802 em 2022. Além dos danos inerentes às violações de privacidade, pode haver sérios efeitos posteriores. Um relatório do Government Accountability Office afirma que as vítimas “perderam oportunidades de emprego devido ao roubo de identidade, tiveram empréstimos negados e foram até presas por crimes que não cometeram”. ou relatórios de crédito, e é quase impossível controlar onde um número de segurança social é usado; devido à sua natureza única e inalterável, um SSN é um identificador poderoso para entidades governamentais e do setor privado. Para piorar a situação, ao contrário de um cartão de crédito roubado, um SSN roubado não pode ser efetivamente cancelado ou substituído. Os criminosos com SSN podem abrir novas contas financeiras e cometer roubo de identidade, uma vez que muitas instituições financeiras dependem de SSN para verificar transações. Não é novidade que a pesquisa do Bureau of Justice Statistics mostra que o roubo de identidade pode levar a desastres graves.

O cenário de ameaças também piorou nos últimos anos com a introdução de ransomware como serviço, malware como serviço e outros serviços de proxy por meio dos quais hackers contratados produziram métodos para acesso não autorizado a dados. Devemos esperar ver mais exemplos de ferramentas compráveis através das quais os dados podem ser acessados, criptografados e/ou manipulados sem autorização.

Assim como todos os outros tipos de indivíduos e organizações estão explorando possíveis casos de uso para gerar produtos de IA, o mesmo acontece com os atores mal-intencionados. Isso pode assumir a forma de promoção ou amplificação de métodos de ameaças existentes, como elaboração de código de malware real, tentativas de comprometimento de e-mail comercial, tentativas de phishing. Isso também pode assumir a forma de novas abordagens de ameaças, por exemplo, mineração de informações alimentadas em conjuntos de dados de modelos de aprendizagem de IA ou envenenamento de conjuntos de dados de modelos de aprendizagem com dados estrategicamente ruins. Devemos também esperar que existam alguns novos vetores de ataque nos quais ainda nem pensamos, vetores que ainda não são possíveis ou mais amplamente acessíveis à IA generativa.

ferir

- Físico : Se um indivíduo for vítima de roubo de identidade, poderá ser preso por um crime que não cometeu.

- Perdas financeiras/económicas : As vítimas podem perder oportunidades de emprego ou ter empréstimos negados devido a roubo de identidade e violações de crédito.

- Reputação/estigma social : O roubo de identidade pode causar sérios danos à reputação, e o malware também pode ser usado para vazar informações pessoais confidenciais, causando danos sociais adicionais.

- Aspectos psicológicos : As vítimas destes ataques podem enfrentar constrangimento e medo como resultado destes ataques, bem como emoções como desamparo e raiva.

- Autonomia : Esses ataques podem levar à perda de controle de identidade, controle financeiro, imagem, etc.

- Discriminação : Os golpes muitas vezes têm como alvo grupos historicamente vulneráveis, como os idosos.

exemplo

- ChatGPT sofreu uma violação massiva de dados que expôs informações do usuário e histórico imediato.

- A Samsung proíbe o uso de inteligência artificial depois que foi descoberto que funcionários vazaram informações de segurança para o ChatGPT.

- OpenAI permite que os usuários extraiam informações de usuários por meio de plug-ins, e os chatbots podem acessar novas fontes de informações, como Expedia e Instacart.

intervenção

Se as empresas investirem na formação dos funcionários e na correção de vulnerabilidades conhecidas, poderão mitigar alguns dos riscos de gerar métodos de ameaças existentes sobrecarregados de IA. No entanto, os próprios riscos associados à utilização de modelos de IA exigirão soluções diferentes, incluindo, entre outras, aquelas descritas no Quadro de Gestão de Riscos de IA do NIST e nos requisitos da solução proposta da Lei de Proteção e Privacidade de Dados dos EUA (ADPPA).

Confrontando a Criatividade: Implicações para a Propriedade Intelectual

Antecedentes e Riscos

A lei de propriedade intelectual inclui direitos autorais, patentes, marcas registradas e segredos comerciais. Em termos gerais, os direitos de autor protegem obras de expressão originais em qualquer meio de expressão (como livros, música, peças de teatro e obras de arte), as patentes protegem invenções, as marcas registadas protegem quaisquer palavras ou símbolos utilizados para identificar a origem de bens e serviços específicos, e o comércio segredos protegem informações comerciais proprietárias. Cada ramo da lei de propriedade intelectual contém direitos específicos que os criadores e proprietários de obras têm sobre o seu trabalho, por exemplo, para controlar a forma como o trabalho é utilizado ou para impedir que outros reivindiquem o trabalho como seu. Embora todas as áreas do direito de propriedade intelectual apresentem desafios à utilização de IA generativa e à geração de obras, os direitos de autor são, de longe, os mais frequentemente invocados.

Com o surgimento da inteligência artificial generativa, o âmbito e a eficácia das proteções legais da propriedade intelectual estão a ser questionados. A IA generativa é treinada em grandes quantidades de dados, muitas vezes incluindo obras protegidas por propriedade intelectual. Como afirmado numa recente carta aberta do Center for Arts Investigation and Reporting, “os geradores de arte de IA são treinados em enormes conjuntos de dados que consistem em milhões de imagens protegidas por direitos de autor, criadas sem o conhecimento dos seus criadores”. ... Este é literalmente o maior roubo de arte da história.”. “Um sistema treinado nessas obras pode aprender a imitar um determinado estilo, como já aconteceu em vários casos. Vários artistas cujos estilos foram copiados expressaram profunda frustração, raiva e frustração, apontando que a IA está lucrando com seu trabalho para desenvolver diferentes estilos, impactam seus meios de subsistência e reduzem o trabalho profundamente pessoal a algoritmos. Nas palavras de Nick Cave, um artista confronta uma música escrita no estilo de "Nick Cave", "Essa música é uma besteira e uma zombaria grotesca da natureza humana. "

As questões sobre até que ponto a protecção da propriedade intelectual se estende no domínio da IA generativa podem ser divididas em ciclos de entrada ou de saída destes sistemas.

|

Estudo de caso – O que há no som? Uma música gerada por IA, anunciada como uma “colaboração” entre Drake e o Weeknd, apareceu no Spotify, Tidal, Apple Music e YouTube, rapidamente acumulou escutas e visualizações suficientes no fim de semana e apareceu nas paradas musicais na segunda-feira. A música foi criada pegando vários samples da voz e da música do artista, criando uma nova música que parece realista. A música foi removida após repetidas reivindicações de direitos autorais do Universal Music Group, levantando questões sobre se as músicas originais podem ser protegidas por direitos autorais e quais proteções existem para artistas cujas vozes e estilos musicais foram clonados. |

digitar

Os sistemas generativos de IA podem gerar conteúdo extremamente detalhado e adaptável porque são treinados em grandes quantidades de dados coletados na Internet. O tipo de dados adquiridos varia de acordo com o tipo de sistema. Por exemplo, os geradores de arte de IA capturariam arte e imagens, traduziriam informações sobre suas principais características em código, que seria então revisado por esses sistemas em busca de padrões, relacionamentos e regras, que seriam então usados para gerar respostas às solicitações do usuário. À medida que a saída desses sistemas se torna mais “precisa” ou responde a mais dados, muitos são programados para extrair contínua e automaticamente os tipos de conteúdo de sua preferência.

Esses enormes conjuntos de dados quase sempre contêm obras protegidas. As entidades que utilizam conjuntos de dados para criar sistemas generativos de IA raramente, ou nunca, obtêm permissão ou licença dos criadores e proprietários de obras de arte para utilizá-los. Na verdade, muitos artistas declararam publicamente que não querem que o seu trabalho entre num sistema que possa torná-lo obsoleto.

Há um debate sério e contínuo sobre se as ferramentas generativas de IA deveriam ser autorizadas a utilizar obras protegidas sem licença. Alguns argumentam que tal uso constitui uso justo, uma exceção a algumas proteções de direitos autorais muito limitadas. O uso justo geralmente depende do uso de material protegido por direitos autorais. Por exemplo, uma organização de pesquisa ou sem fins lucrativos que utiliza o conteúdo pode ter melhores direitos de uso justo do que uma empresa que pretende vender uma obra produzida a partir da obra original. Até que ponto o uso justo se aplica à IA generativa permanece uma questão jurídica em aberto.

saída

Os usuários finais de ferramentas de geração de IA tentaram reivindicar a propriedade do resultado das ferramentas de geração de IA, incluindo alguns que tentaram solicitar direitos autorais junto ao Escritório de Direitos Autorais dos EUA. O uso crescente de inteligência artificial generativa para criar trabalhos criativos, e as subsequentes tentativas de registo de direitos de autor, foram suficientes para levar o Gabinete de Direitos de Autor a lançar uma nova iniciativa de IA.

Até agora, o Escritório de Direitos Autorais dos EUA declarou que uma obra não pode ser protegida por direitos autorais a menos que contenha uma “contribuição criativa de um ator humano”, observando que os direitos autorais só podem proteger “produtos da criatividade humana”. Embora alguns argumentem que a insinuação constitui "criatividade humana" suficiente para trazer proteção de propriedade intelectual ao trabalho final, o Copyright Office discorda, comparando a insinuação a "instruções para artistas comissionados que determinam que o insinuador deseja representar o conteúdo, mas a máquina determina como esses instruções são executadas em sua saída."

Esta distinção torna-se mais complicada quando os empregos são parcialmente gerados pela IA e parcialmente gerados por humanos. Os direitos autorais podem ser aplicados a obras que contenham ou sejam baseadas em obras geradas por inteligência artificial, mas os direitos autorais só se aplicam a aspectos da criação humana.

ferir

Os danos para criadores individuais e grupos de artistas são enormes.

- Perdas Económicas/Económicas : Como mencionado acima, os danos legais nesta área podem incluir violações de direitos de trabalho e de utilização, bem como questões de propriedade de produtos gerados por IA. A violação de obras pode surgir da produção de inteligência artificial gerada. Estes incluem a reprodução não autorizada (que pode ser o caso quando uma obra gerada por inteligência artificial é demasiado semelhante à obra original) e trabalhos derivados (obras que contêm demasiados elementos originais da obra original, muitas vezes em reproduções, condensações ou resumos de a obra original). O direito de uso estará relacionado à geração de dados de IA, independentemente de o sistema gerador de IA ter ou não uma licença para usar o trabalho original no conjunto de estudo, ou se isso se enquadrar em uma exceção, como o uso justo.

- Perdas financeiras/económicas : Os criadores e proprietários podem enfrentar graves perdas financeiras, uma vez que há menos procura pelas suas obras quando obras semelhantes podem ser produzidas de forma fácil e barata. Estes danos podem manifestar-se como falta de oportunidades e de emprego (já que muitos empregos e comissões de criadores são substituídos por IA generativa), bem como violações dos interesses financeiros de obras originais (perda de licenciamento ou venda de obras porque os compradores estão a utilizar cópias ) ). Se houver uma preocupação crescente de que o trabalho gerado pela IA torne a vida do criador demasiado difícil, isso também poderá levar a um declínio acentuado no número de artistas profissionais. Finalmente, o influxo de obras geradas pela IA afectará o mercado dessas obras.

- Reputação : os criadores também podem enfrentar danos à reputação. É perfeitamente possível que os fãs confundam um trabalho gerado por IA com o de um criador inspirador, o que é um problema porque o criador não estava envolvido com o trabalho e não pode oferecer informações sobre uso, qualidade ou direção. Obras criadas no estilo ou na voz de um determinado criador podem ser usadas para promover causas com as quais o criador discorda, ou podem ser de baixa qualidade, podendo ambas causar danos à reputação.

- Psicologia : Vários artistas expressaram dor, tristeza, raiva, etc. pelo uso e reprodução de seu trabalho por inteligência artificial generativa. Em muitos casos, o trabalho de um artista é profundamente pessoal, assim como a reprodução e exploração de uma obra.

- Perda de oportunidade/relacionamento/dignidade : Se os criadores e as suas obras não forem protegidos da exploração e da cópia pela IA generativa, isso poderá levar a que menos artistas invistam tempo e esforço no desenvolvimento dos seus próprios estilos artísticos únicos, levando a um declínio geral na a quantidade de grupos e todas as obras criativas da humanidade.

exemplo

- Vários artistas descobriram que o seu trabalho foi utilizado sem a sua permissão para treinar inteligência artificial, que em alguns casos pode replicar de forma convincente o seu estilo artístico exato quando solicitado.

- Conforme observado no estudo de caso acima, isso se estende a músicas geradas por IA que são “tocadas” de uma forma que imita exatamente o tom e o estilo musical do artista.

- Artistas descobriram que a IA copiou seu estilo ou modificou seu trabalho de alguma forma para fazê-lo parecer uma mensagem pró-ódio, assim como um artista descobriu que a direita alternativa usava ferramentas geradas por IA para influenciar suas criações de estilo artístico expressar visões de mundo ofensivas também.

- Atualmente, existem alguns exemplos de indivíduos que tentam reivindicar direitos autorais de obras geradas por ferramentas de IA.

- Três artistas entraram com uma ação coletiva no Distrito Norte da Califórnia contra a empresa que gera imagens de IA, alegando que ela usou seu trabalho sem consentimento ou compensação para construir conjuntos de treinamento que informam a plataforma.

- A Getty Images entrou com uma ação legal contra a Stability AI, acusando-a de copiar e processar milhões de imagens para um conjunto de treinamento sem permissão.

intervenção

- Os desenvolvedores de IA poderiam ser forçados a licenciar qualquer IP contido nos dados de treinamento que geram a tecnologia de IA, o que impediria a extração indiscriminada e persistente de conteúdo na Internet.

- Os clientes podem ser obrigados a realizar alguma forma de due diligence para confirmar se o modelo recebeu algum treinamento sobre conteúdo protegido antes de usar o modelo.

- As ferramentas de IA podem ser forçadas a solicitar permissão dos criadores antes de gerar arte no “estilo” de qualquer criador específico.

- Pesquisadores acadêmicos da Universidade de Chicago desenvolveram uma ferramenta chamada Glaze, que introduz elementos quase imperceptíveis em obras de arte, projetadas para interromper a inteligência artificial generativa. Pegue informações de obras de arte e adicione-as aos dados de treinamento.

- A Shutterstock está oferecendo aos criadores a opção de não ter seu trabalho usado em treinamento de IA e criou um fundo de doações que compensará os criadores se sua propriedade intelectual for usada para treinamento.

- O DeviantArt implementa uma tag de metadados para imagens compartilhadas na web que inclui um aviso para os sistemas de IA não rastrearem o conteúdo marcado.

impactos exacerbados das alterações climáticas

Antecedentes e Riscos

O planeta está correndo em direção a uma catástrofe climática contínua. As alterações climáticas causaram centenas de milhares a milhões de mortes, milhares de milhões de dólares em perdas económicas e extinção em massa de espécies. Cada décimo de grau de aquecimento que pudermos evitar no futuro significa milhões de vidas salvas, enormes perdas económicas evitadas e a oportunidade de um futuro habitável. Em última análise, por escolha ou necessidade, a nossa sociedade avaliará cada indústria e actividade em termos de recursos e custos de carbono.

Neste cenário de alto risco, o campo cada vez maior da IA generativa entra em colapso, com consequências imediatas e graves para o nosso clima: a IA generativa tem uma elevada pegada de carbono e um preço de recursos igualmente elevado, que em grande parte passa despercebido ao radar dos o discurso público da IA.

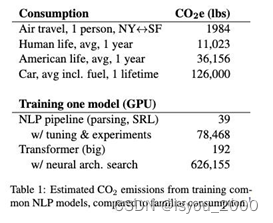

O treinamento e a operação de ferramentas generativas de IA exigem que as empresas usem quantidades extremas de energia e recursos físicos. Treinar um modelo de processamento de linguagem natural com ajuste e experimentação normais emite, em média, a mesma quantidade de carbono que sete pessoas emitem em um ano inteiro.

Libras de CO2 produzidas por pessoas/objetos comuns em comparação com tarefas relacionadas à IA generativa

Os modelos de IA requerem quantidades significativas de carbono para serem produzidos e, dados os incentivos da indústria, é pouco provável que esta tendência melhore significativamente. Grande parte da investigação sobre IA, especialmente em grandes empresas tecnológicas que controlam eficazmente o espaço, centra-se na precisão ou em medidas relacionadas, em detrimento de todas as outras considerações. Uma grande parte da pesquisa em IA tenta “comprar” melhores resultados investindo exponencialmente mais dinheiro ao longo do tempo para aumentar linearmente a precisão, ignorando outros fatores externos, como custos de recursos. Esses custos são um requisito físico de muitos sistemas de IA: a relação entre o desempenho do modelo e a complexidade do modelo é, na melhor das hipóteses, logarítmica, portanto, para um ganho linear no desempenho, é necessário um modelo exponencialmente maior e menos eficiente em termos de recursos. Embora alguns investigadores de IA tenham começado a concentrar-se na eficiência, seja por razões ambientais ou de redução de custos, não há razão para pensar que as grandes empresas tecnológicas abandonarão a busca pela precisão tão cedo.

Ao mesmo tempo, os data centers que os desenvolvedores de IA usam para treinar e hospedar modelos generativos de IA têm altos custos de energia e grandes pegadas de carbono. Embora parte desta energia possa vir de fontes renováveis, o consumo de energia dos centros de dados continua a ser uma preocupação por vários motivos. Em primeiro lugar, muitas regiões com centros de dados ainda utilizam energia com utilização intensiva de carbono para gerar eletricidade. Em segundo lugar, mesmo quando a energia renovável está disponível, ela poderia ser melhor alocada para aquecer casas, aquecer estufas ou promover outros objetivos socialmente importantes, em vez de treinar modelos de IA, mas esta compensação geralmente não é estudada ou discutida.

Esses data centers também consomem recursos de maneira insustentável. Muitas empresas de tecnologia provocaram a reação pública por usarem o abastecimento público de água para resfriar seus centros no meio de regiões áridas. “Novas pesquisas mostram que só o treinamento GPT-3 consome 185.000 galões (700.000 litros) de água. De acordo com um novo estudo, a conversa do usuário médio com o ChatGPT é basicamente equivalente a jogar uma grande garrafa de água doce no chão.” também dependem fortemente de minerais adquiridos em condições violentas e de exploração.

ferir

- Físico : Mudanças ambientais severas causarão graves danos físicos às pessoas em todo o mundo (secas, desastres naturais, etc.).

- Perdas económicas/económicas : Os recursos económicos necessários para lidar com os riscos ambientais ou executar a IA generativa são muito importantes.

- Autonomia : Com tantos recursos limitados destinados a grandes empresas que os utilizam para IA generativa, isto significa necessariamente que outras empresas terão menos acesso e enfrentarão escassez.

exemplo

- Sasha Luccioni, líder climática da HuggingFace, avalia os impactos ambientais e sociais da IA generativa - ela destaca "toneladas de emissões de carbono", "enormes quantidades de energia/água" e "custo de hardware de fabricação" em seu raro modelo de iceberg de custo de IA generativa metais".

Fonte: Sasha Luccioni

intervenção

- O governo holandês impôs uma moratória de nove meses aos grandes centros de dados do país para manter a supervisão devido a danos ambientais.

- As empresas tecnológicas devem ser obrigadas a monitorizar e publicar a quantidade de energia e recursos que os seus modelos e centros de dados estão a utilizar.

- Devem ser solicitadas reuniões para rastrear recursos para desenvolver e operar um sistema.

- Os investigadores académicos devem ter acesso equitativo aos recursos informáticos. Até agora, os académicos não tiveram oportunidade suficiente para compreender os detalhes de como funcionam as ferramentas modernas de IA e quais os recursos de que necessitam. Esse conhecimento está acumulado nas grandes empresas de tecnologia. Sem este conhecimento e acesso, o foco estará no lucro/precisão e não nas preocupações ambientais. A luz solar é o melhor desinfetante, e os acadêmicos que entendem de ciência da computação são janelas úteis para deixá-la entrar.

Manipulação trabalhista, roubo e deslocamento

Antecedentes e Riscos

As manchetes recentes sobre clickbait ampliaram o medo e o hype de que a IA generativa está vindo para os empregos das pessoas. Embora a inteligência artificial generativa vá perturbar a forma como algumas indústrias funcionam, é demasiado cedo para ver como esta tecnologia irá afectar o mercado de trabalho e ser integrada nos empregos existentes.

Em termos de força de trabalho e domínio de mercado, grandes empresas de tecnologia como Apple, Meta, Amazon, Google e Microsoft empregam a maior parte da indústria de P&D de IA. Estas empresas estão a orientar esta força de trabalho especializada para desenvolver produtos comerciais de IA que possam ser utilizados para benefício privado e não para bem público.

As grandes empresas tecnológicas também são líderes no desenvolvimento de novos sistemas generativos de IA, porque a formação de modelos generativos de IA requer grandes quantidades de dados, poder computacional e recursos técnicos e financeiros. O seu domínio de mercado tem repercussões no mercado de trabalho, afetando tanto os trabalhadores dentro destas empresas como aqueles que implementam externamente os seus produtos gerados pela IA. Com uma tal concentração de poder de mercado, conhecimentos especializados e recursos de investimento, estas poucas grandes empresas tecnológicas empregam a maior parte da I&D em IA generativa. O poder da criação de emprego também significa que estas empresas tecnológicas podem cortar postos de trabalho face à incerteza económica. Externamente, as ferramentas generativas de IA desenvolvidas por estas empresas têm o potencial de impactar o trabalho de escritório de colarinho branco para aumentar a produtividade dos trabalhadores e automatizar tarefas.

Local de trabalho gerando inteligência artificial

O desenvolvimento global da inteligência artificial está a mudar a forma como as empresas concebem locais de trabalho e modelos de negócio. A IA generativa não é exceção. O tempo dirá se os empregadores adotarão, implementarão e integrarão a IA generativa no local de trabalho e até que ponto isso afetará os trabalhadores.

Ainda assim, os primeiros sinais sugerem que a IA generativa transformará o trabalho de colarinho branco. Muitos trabalhadores de colarinho branco já adotaram a IA generativa para ajudar nas tarefas diárias, como redigir apresentações, materiais de marketing, falar, enviar e-mails, realizar pesquisas e até mesmo programar. Uma pesquisa da Fishbowl descobriu que 43% dos profissionais usam ferramentas generativas de inteligência artificial para concluir tarefas de trabalho, e 70% dos entrevistados o fazem sem o conhecimento de seus chefes. Meios de comunicação e sites usam o ChatGPT para escrever todos ou parte de seus artigos. Os gerentes de contratação estão recorrendo à IA generativa para ajudar a escrever descrições de cargos e redigir perguntas para entrevistas, e os advogados estão usando a IA generativa para pesquisas, tarefas administrativas e até mesmo na elaboração de contratos. Na medicina, os médicos estão usando IA generativa para realizar pesquisas e resumir as consultas dos pacientes.

A proliferação da IA generativa também criou uma procura de trabalhadores experientes com estas ferramentas, bem como de empregos inteiramente novos construídos em torno delas. De acordo com um estudo da ResumeBuilder.com, nove em cada 10 empresas pesquisadas estão atualmente procurando funcionários com experiência em ChatGPT. A ascensão das ferramentas generativas de IA também criou uma necessidade crescente de “engenheiros instantâneos”, pessoas que treinam chatbots de IA para testar e refinar respostas ou, de outra forma, fornecer melhores informações instantâneas para grandes modelos de linguagem como o ChatGPT. Na verdade, já existe um banco de dados de dicas onde as pessoas podem vender suas próprias dicas para produzir melhores resultados.

Nem todos os empregadores estão aderindo à onda da IA. Alguns locais de trabalho têm receio de adotar rapidamente a tecnologia, que por vezes responde a avisos com a mensagem ou resposta errada, devido a questões de fiabilidade. Outros empregadores expressaram preocupações sobre os riscos de segurança e a limitação do uso pelos funcionários. Locais de trabalho como JPMorgan, Chase, Bank of America, Citigroup e Verizon proibiram os funcionários de usar o ChatGPT. A Samsung proibiu a ferramenta generativa de IA depois que os funcionários enviaram dados confidenciais para o ChatGPT, citando preocupações de que os dados transferidos fossem armazenados em servidores externos, difíceis de recuperar ou excluir e poderiam vazar para outras pessoas.

O impacto global da IA generativa na economia continua por ver. A IA generativa não regulamentada e implementada livremente pode prejudicar a concorrência, reduzir os salários e levar à sobreautomação e à desqualificação, dizem alguns especialistas. Mas ao discutir os riscos potenciais da geração de IA para a força de trabalho, é necessário distinguir se a geração de ferramentas de IA leva à automação ou aumenta as funções profissionais. Desde a década de 1980, grande parte da desigualdade de rendimentos tem sido impulsionada pela automação. Quando a IA é gerada para automação, os riscos potenciais incluem perdas de empregos, desvalorização do trabalho e aumento da desigualdade económica.

Automação do trabalho em vez de aumento

O impacto da IA no trabalho pode ser positivo e negativo. Um relatório da Casa Branca observou que a IA “tem potencial para aumentar a produtividade, criar novos empregos e melhorar os padrões de vida”, mas também pode perturbar certas indústrias, levando a grandes mudanças, incluindo perdas de empregos. Além dos riscos de perda de emprego, os trabalhadores podem descobrir que as ferramentas generativas de IA automatizaram partes dos seus empregos ou descobrir que os requisitos do seu trabalho mudaram fundamentalmente.

O impacto da geração de IA dependerá de a tecnologia ser utilizada para automação (sistemas automatizados substituem empregos humanos) ou para aumento (IA utilizada para ajudar trabalhadores humanos). Ao longo das últimas duas décadas, o ritmo rápido da automação levou a “um declínio na percentagem de mão-de-obra, à estagnação dos salários e ao desaparecimento de bons empregos em muitas economias avançadas”.

Alguns estudos sugerem que a IA poderia reduzir as contratações se substituir muitas tarefas rotineiras anteriormente realizadas pelos trabalhadores. Mas outra investigação demonstrou que a IA pode criar novas oportunidades, especialmente em empregos altamente qualificados, e aumentar a produtividade dos trabalhadores concentrados em tarefas complexas ou criativas. No entanto, os empregadores que procuram reduzir custos, maximizar os lucros e aumentar o valor para os acionistas são mais propensos a dar prioridade às tecnologias de IA que automatizam em vez do aumento do emprego.

Embora seja demasiado cedo para determinar se a IA irá desvalorizar substancialmente ou substituir completamente os trabalhadores, a investigação preliminar sugere que a IA generativa irá de facto afectar as tarefas relacionadas com o trabalho. De acordo com a pesquisa da OpenAI, “80% da força de trabalho dos EUA provavelmente terá pelo menos 10% das tarefas de trabalho impactadas por grandes modelos de linguagem”, e espera-se que esse impacto abranja todos os níveis salariais em todos os setores. O artigo da OpenAI também descobriu que “aproximadamente 19% dos trabalhadores podem ter 50% das tarefas afetadas”.

Um relatório da Goldman Sachs afirma que a IA generativa pode afetar até 300 milhões de empregos. A IA generativa poderia substituir um quarto dos empregos existentes, sendo os trabalhadores administrativos e jurídicos os mais susceptíveis de serem afectados. O relatório da Goldman Sachs também mostrou que a IA afectará o mercado de trabalho de forma mais geral, mas o relatório sublinhou que grande parte deste impacto dependerá das capacidades da tecnologia e da forma como é adoptada.

Desvalorização do trabalho e aumento da desigualdade económica

Os avanços tecnológicos que aceleram a produtividade, automatizam o trabalho e aumentam a rentabilidade através da redução de custos começaram muito antes do boom da IA generativa. Historicamente, a automação tem sido um dos contribuintes mais visíveis para os declínios salariais. De acordo com um relatório da Casa Branca, grande parte do desenvolvimento e da adopção da inteligência artificial visa automatizar, e não aumentar, empregos. O relatório observou que o foco na automação poderia levar a um mercado de trabalho menos democrático e justo.

Considere o impacto potencial da IA generativa na força de trabalho da indústria de engenharia de software, onde muitas startups estão usando GPT-4 para reduzir gastos com programadores humanos. Embora a IA generativa não substitua todos os engenheiros de software tão cedo, afetará a acessibilidade do código de aprendizagem, o custo dos serviços para os programadores e a necessidade de programadores humanos. Os programadores juniores poderiam beneficiar da utilização de IA generativa para os ajudar a aprender a programar, mas os programadores mais experientes poderão considerar o seu trabalho menos valioso à medida que a concorrência aumenta.

Em 2021, o CEO da OpenAI, Sam Altman, prevê que haverá uma revolução tecnológica “esmagadora” da IA que verá o preço de muitos tipos de trabalho cair para zero, uma vez que uma IA suficientemente poderosa “se junte à força de trabalho”. Altman elaborou que, uma vez que o trabalho é o principal custo das cadeias de abastecimento, as tarefas executadas pela IA reduzirão o custo dos bens e serviços. Ele reconheceu que se a política pública não for adaptada a tal revolução prevista, “a maioria das pessoas estará em pior situação do que outras”. .” Hoje é ainda pior. Esta previsão mostra como os CEO das principais empresas de IA generativa veem um futuro onde a IA acelera a desigualdade económica.

Além disso, a IA generativa agrava a persistente lacuna global da força de trabalho em I&D de tecnologia de IA. A externalização de mão-de-obra para subcontratantes no Sul Global em benefício do Norte Global é um problema mais amplo inerente à indústria tecnológica e a todo o ecossistema económico global. O trabalho considerado simples e rotineiro é muitas vezes externalizado para locais onde os trabalhadores são forçados a condições de trabalho precárias e a salários baixos. As cadeias de abastecimento de IA reflectem e reproduzem as desigualdades do colonialismo imperial, onde o Norte global, com maior poder económico, beneficia da proliferação de tecnologias de IA com exclusão do Sul global.

O desenvolvimento da IA tem revelado consistentemente uma lacuna de poder entre aqueles que trabalham em modelos de IA e aqueles que controlam e lucram com estas ferramentas. Os trabalhadores estrangeiros que treinam chatbots de IA, ou cujo conteúdo online é involuntariamente inserido em modelos de formação, não colhem os enormes lucros gerados pela geração de ferramentas de IA. Em vez disso, as empresas que exploram trabalhadores substituíveis e com baixos salários, ou o trabalho não remunerado de artistas e criadores de conteúdos, suportam o peso. O desenvolvimento de tecnologias de IA generativas apenas irá exacerbar esta lacuna de poder, com as empresas tecnológicas a investirem fortemente em ferramentas de IA generativas, beneficiando às custas dos trabalhadores. Por exemplo, a OpenAI espera atingir US$ 1 bilhão em receitas até 2024.

Mas a ação coletiva dos trabalhadores em torno da IA está a crescer. Por exemplo, mais de 150 funcionários de moderação de conteúdos e rotulagem de dados em África votaram recentemente pela sindicalização. Além disso, o Writers Guild of America entrou em greve em parte porque os estúdios se recusaram a negociar a proibição do uso de IA para gerar roteiros e do uso de trabalhos escritos por escritores para treinar IA.

ferir

- Economia/Danos económicos/Perda de oportunidades : A subcontratação de mão-de-obra para a IA generativa pode resultar na perda de empregos e na deslocação de empregos a nível mundial, afetando inclusive os empregos atualmente externalizados para outros países.

- Autonomia/Perda de Oportunidades : A indústria como um todo pode ser afetada pela procura no local de trabalho para a geração de IA, o que significa que aqueles que se especializam em determinadas indústrias podem não conseguir encontrar trabalho e ter de se mudar para novos locais. campo são "desperdiçados".

exemplo

- A Sama, com sede em São Francisco, emprega funcionários em Uganda, Quênia e Índia para anotar dados para Microsoft, Meta, Google e Google. A OpenAI terceirizou o trabalho para a Sama, que pagou aos trabalhadores quenianos menos de US$ 2 por hora para rotular os dados e ajudar a reduzir a toxicidade do ChatGPT, que um funcionário da Sama descreveu como “tortura”. A natureza traumática do trabalho levou Sama a encerrar seu relacionamento com a OpenAI em fevereiro de 2022, oito meses antes.

- Em uma pesquisa ResumeBuilder.com com 1.000 líderes empresariais dos EUA, metade das empresas pesquisadas está usando ChatGPT, 30% planejam fazê-lo e 48% já substituíram funcionários por ChatGPT.

- Em janeiro de 2023, o BuzzFeed disse que usaria o ChatGPT para criar questionários e conteúdo personalizado para os leitores, e os funcionários levantaram preocupações sobre se a mudança resultaria em uma força de trabalho reduzida. Na época, o BuzzFeed argumentou que permanecia “focado no jornalismo artificial na redação”, mas desde então o BuzzFeeds fechou sua divisão de notícias como parte de uma demissão de 15% de sua força de trabalho.

intervenção

Redistribuir poder e lucros entre todos os jogadores

- Os locais de trabalho não devem utilizar a IA generativa como meio de reduzir os custos laborais e as contribuições dos trabalhadores. Na verdade, os salários deveriam aumentar para corresponder à melhoria da produtividade dos trabalhadores gerada pela inteligência artificial.

- As empresas tecnológicas devem levantar a voz e entregar o poder de decisão àqueles que estão verdadeiramente empenhados no desenvolvimento e formação de IA generativa, especialmente aqueles no sul global. As grandes empresas precisam aumentar o envolvimento dos funcionários para garantir a justiça.

- Os fornecedores de tecnologia e prestadores de serviços devem investir em investigação e desenvolvimento de IA para aumentar a produtividade dos trabalhadores e não para substituir funções profissionais.

- Se o local de trabalho beneficia financeiramente da geração de IA, as empresas devem partilhar os lucros com aqueles que deles beneficiam, em vez de partilhar os lucros entre os acionistas e os que ganham mais.

investir em talentos

- Os empregadores devem investir em formação e serviços de transição profissional para formar os trabalhadores em novas competências para empregos alterados pela geração de IA.

- Os empregadores devem investir na formação que tem uma procura crescente para os novos empregos criados pela IA generativa (por exemplo, engenheiro instantâneo, gestor de máquinas, auditor de IA e formador de IA).

- As empresas devem implementar programas políticos que se comprometam a investir na formação para reter a força de trabalho, em vez de cortar custos através da redução de pessoal, em favor de tecnologias de IA generativas.

- As empresas, os governos locais e federais e outros programas público-privados devem comprometer-se a investir em recursos para ajudar os trabalhadores deslocados pela IA generativa a encontrar empregos alternativos.

Investindo em IA Complementar

- Os locais de trabalho devem investir e implementar IA generativa para aumentar e complementar os empregos, e não substituí-los.

- As empresas tecnológicas devem investir em I&D em IA para melhorar a produtividade dos trabalhadores e não para substituir funções profissionais.

- Os decisores políticos devem regular e redireccionar a investigação generativa em IA para desenvolver tecnologias para casos de utilização de interesse público, e não principalmente para casos de utilização comercial.

Destaque: Discriminação

A IA e outros sistemas automatizados de tomada de decisão têm sido implementados há muito tempo de uma forma opaca e irresponsável que prejudica os indivíduos e agrava os preconceitos existentes. Como a IA é treinada com base em dados históricos e é frequentemente utilizada por controladores de recursos (empresas de recrutamento, proprietários, agências governamentais de assistência social), os negros, as mulheres, os deficientes e os pobres são os mais atingidos. O dano não é trivial: os sistemas algorítmicos colocam homens negros inocentes na prisão, têm limites de crédito mais baixos para as mulheres, têm taxas mais elevadas para licenciados em faculdades historicamente negras ou latinas e impedem as pessoas de obter entrevistas ou ofertas de emprego.

Quando você pede ao gerador de imagens para gerar a imagem de uma faxineira, é mais provável que ele mostre uma mulher, e quando você pede para gerar a imagem de um chefe, é mais provável que ele mostre um homem branco. O gerador de texto Bard do Google replica teorias de conspiração perigosas. Recomenda terapia de conversão para gays, gera textos que chamam as pessoas trans de “noivos” e gera textos que afirmam que grande parte do Holocausto foi fabricada.

A IA generativa é inadequada para determinar oportunidades vitais na vida, mas o público deve permanecer vigilante para identificar utilizações inadequadas da IA para estes fins – tais como chatbots que atuam como árbitros para pessoas em sites de justiça criminal ou de serviços sociais.

A discriminação está no centro de cada um dos riscos descritos neste artigo, e as comunidades marginalizadas sentirão mais de perto o impacto negativo das violações de segurança, das violações de privacidade e dos impactos ambientais.