Link para o artigo: https://www.researchgate.net/publication/371661341_Social_bot_detection_in_the_age_of_ChatGPT_Challenges_and_opportunities

Índice

1.2. A ascensão de chatbots gerados por IA, como o ChatGPT

1.4. Escopo e objetivos do artigo

2.1. Métodos de detecção precoce baseados em heurísticas simples

2.2. A incorporação de aprendizado de máquina e processamento de linguagem natural

2.3. Abordagens baseadas em aprendizado profundo e redes neurais

2.4. O impacto de grandes modelos de linguagem em técnicas de detecção

3.1. Conteúdo gerado por IA cada vez mais sofisticado

3.2. Ataques adversários e táticas de evasão

3.3. Escalabilidade e detecção em tempo real

3.4. Considerações éticas e preocupações com a privacidade

4. Oportunidades e tendências emergentes

4.1. Aproveitando o aprendizado por transferência e o aprendizado não supervisionado

4.2. Abordagens multimodais para detecção

4.3. Aprendizagem colaborativa e federada para detecção

4.4. IA explicável e interpretabilidade em técnicas de detecção

4.5. Combinando várias técnicas de detecção

4.6. Modelos em constante atualização e ajuste fino

4.7. Agentes geradores como fonte de dados sintéticos

5. Estudos de caso: detecção de bots sociais em aplicativos do mundo real

5.1. Interferência eleitoral e manipulação política

5.3. Golpes financeiros e manipulação de criptomoedas

6.3. Considerações finais e possíveis direções de pesquisa

Resumo:

Fornecemos uma visão abrangente dos desafios e oportunidades da detecção de bots sociais no contexto do surgimento de sofisticados chatbots baseados em IA. Ao examinar o estado da arte na detecção de bots sociais e os aplicativos mais proeminentes do mundo real até o momento, identificamos lacunas e tendências emergentes no campo, com foco em abordar os desafios únicos impostos pelo diálogo e comportamento gerados por IA.

Sugerimos oportunidades potencialmente promissoras e direções de pesquisa na detecção de bots sociais, incluindo (i) o uso de agentes generativos para geração, teste e avaliação de dados sintéticos; (ii) a necessidade de detecção multimodal e multiplataforma; (iii) a oportunidade para estender a detecção de bots para localidades não inglesas e com poucos recursos; (iv) o espaço para desenvolver modelos de detecção de aprendizado federados e colaborativos que podem ajudar a facilitar a colaboração entre diferentes organizações e plataformas, protegendo a privacidade do usuário.

introdução

A proliferação de tecnologias de inteligência artificial (IA) e processamento de linguagem natural (NLP) deu origem a robôs sociais avançados, criando novos desafios para comunicação online e segurança cibernética. Esses bots imitam o comportamento humano e interagem entre plataformas, geralmente com intenções potencialmente maliciosas, como espalhar desinformação ou manipular o sentimento público. O advento de chatbots gerados por IA, como o ChatGPT, ampliou esses problemas, tornando a detecção e mitigação de bots sociais uma tarefa imperativa.

análise

Este artigo apresenta uma análise aprofundada da detecção de bots sociais, destacando os desafios, perspectivas e tendências emergentes no campo. Traçamos a evolução das técnicas de detecção de robôs, desde a heurística inicial até o uso de aprendizado de máquina, NLP e métodos de aprendizado profundo. Modelos avançados de linguagem (por exemplo, ChatGPT) em técnicas de detecção também são discutidos. Em seguida, abordamos as complexidades da detecção de bots sociais, como a complexidade do conteúdo gerado por IA, estratégias adversárias, escalabilidade, detecção em tempo real e considerações éticas e de privacidade.

Direções de pesquisa futura

Ao mesmo tempo, destacamos as direções futuras, como o uso de aprendizado por transferência, aprendizado não supervisionado, abordagens multimodais, aprendizado colaborativo e inteligência artificial explicável em métodos de detecção.

Casos de aplicação do mundo real

Além disso, apresentamos casos reais que demonstram a aplicação da detecção de bots em áreas como interferência eleitoral, campanhas de desinformação, teorias de conspiração online e fraude financeira. Também discutimos o papel potencial de proxies generativos e dados sintéticos no avanço do campo.

Resumir

Em conclusão, propomos as melhores práticas para detecção de bots sociais. Isso envolve a integração de diferentes técnicas de detecção, fontes de dados e modalidades, refinando modelos regularmente, mantendo a privacidade em um ambiente federado e aproveitando proxies generativos e dados sintéticos.

1.1. Histórico sobre bots sociais e seu papel na sociedade

Social bots, ou softwares automatizados que imitam o comportamento humano em plataformas de mídia social, operam por meio de algoritmos que variam de scripts simples a inteligência artificial complexa, envolvendo-se em tarefas ou conversas online (Ferrara et al., 2016). Seu uso, benigno e malicioso, cresceu com o surgimento das mídias sociais.

benigno

Os bots sociais benignos ajudam a automatizar o compartilhamento de conteúdo, agregação de notícias, atendimento ao cliente e suporte, ajudando assim as empresas a gerenciar sua presença na mídia social e aumentar o envolvimento do usuário (Ferrara, 2020; Mønsted et al., 2017; Brandtzaeg e Følstad, 2017).

malicioso

Por outro lado, bots sociais maliciosos receberam mais atenção devido ao seu potencial dano às comunidades online e sua capacidade de manipular o sentimento público, envolvendo-se na disseminação de desinformação, proliferação de conspiração online e interferência política (Bessi e Ferrara, 2016; Shao et al.). , 2018; Ferrara, 2020; Wang et al., 2023). Portanto, sua detecção e mitigação tornam-se críticas.

A sofisticação dos bots sociais evoluiu de interações iniciais baseadas em regras e orientadas por palavras-chave para a combinação de aprendizado de máquina e processamento de linguagem natural para uma comunicação humana mais realista (Chu et al., 2010; Chang e Ferrara, 2022). Por exemplo, alguns bots empregam modelos baseados em cadeia de Markov para gerar texto que imita o conteúdo gerado por humanos (Hwang et al., 2012; Pozzana e Ferrara, 2020).

Avanços em aprendizado profundo e redes neurais aumentaram ainda mais as capacidades de linguagem dos robôs (Radziwill e Benton, 2017). Os bots baseados em IA, como o ChatGPT da OpenAI, podem melhorar os recursos dos bots sociais, dominando padrões complexos de comunicação humana e gerando respostas que são cada vez mais indistinguíveis da conversa humana real.

1.2. A ascensão de chatbots gerados por IA, como o ChatGPT

A introdução de técnicas avançadas de inteligência artificial facilitou a criação de chatbots sofisticados, como o ChatGPT da OpenAI. O ChatGPT é baseado na arquitetura GPT-4 (uma extensão do GPT original) (Radford et al., 2018), gerando texto coerente e sensível ao contexto que se assemelha muito à conversa humana. Essa arquitetura emprega um modelo de aprendizado profundo chamado Transformer (Vaswani et al., 2017), que é muito eficaz para tarefas que envolvem compreensão e geração de linguagem natural.

Devido aos seus dados de treinamento extensos e em grande escala, o ChatGPT é treinado em centenas de bilhões de palavras e ajustado usando aprendizado por reforço com feedback humano (RLFH) (OpenAI, 2021). A combinação de pré-treinamento não supervisionado e ajuste fino baseado em aprendizado de reforço permite que o ChatGPT gere respostas apropriadas ao contexto e semelhantes às humanas.

O progresso na geração de linguagem natural pelo ChatGPT e outros modelos de linguagem em larga escala, como BERT (Devlin et al., 2018) e XLNet (Yang et al., 2019), aprimorou bastante as capacidades dos robôs sociais. Isso torna as interações do usuário mais complexas e diferenciadas, abrindo novas oportunidades para aplicativos de IA, mas também exacerbando o potencial de uso indevido, complicando assim a detecção de bots sociais.

1.3. A importância da detecção de bots sociais

Identificar e distinguir entre usuários humanos e bots sociais é fundamental para manter a integridade das comunidades online e plataformas de mídia social. A detecção efetiva de bot social pode reduzir o impacto de bots mal-intencionados, como a disseminação de desinformação, manipulação da opinião pública e amplificação de conteúdo prejudicial.

Bots sociais maliciosos exploram plataformas de mídia social para espalhar desinformação e influenciar o discurso público (Ferrara, 2017; Shao et al., 2018). Em cenários políticos como eleições, esses bots espalham desinformação para manipular o sentimento público (Bessi e Ferrara, 2016; Howard e Kolanyi, 2016). A detecção confiável de bot social pode ajudar a identificar e combater essas campanhas de desinformação, promovendo um espaço online transparente e democrático.

Os bots sociais também perpetuam as teorias da conspiração online (Samory e Mitra, 2018; Muric et al., 2021). Esses bots podem amplificar conteúdo prejudicial e realizar campanhas direcionadas. O emprego de mecanismos robustos de detecção de bots pode ajudar a proteger os usuários desse tipo de atividade maliciosa, garantindo um ambiente online seguro e inclusivo.

As políticas das plataformas de mídia social proíbem a atividade maliciosa de contas automatizadas ou a manipulação de indicadores de plataforma, como curtidas, compartilhamentos e seguidores (Ferrara, 2022). A aplicação dessas políticas requer detecção e eliminação eficazes de bots sociais, melhorando assim a experiência do usuário autenticidade. Além disso, os bots sociais podem violar a privacidade do usuário por meio de coleta ou vigilância não autorizada de dados (Gorwa e Guilbeault, 2020), o que destaca a importância da detecção robusta de bots sociais.

Embora as técnicas de detecção de robôs sociais sejam diversas, variando de métodos simples baseados em regras e métodos de engenharia de recursos (Chu, et al., 2010; Subrahmanian, et al., 2016) até aprendizado de máquina avançado e técnicas de aprendizado profundo (Ferrara, et al. al., 2016); Z. Yang et al., 2019), a complexidade dos chatbots orientados por IA, como o ChatGPT, apresenta novos desafios de detecção, enfatizando a importância da pesquisa contínua nessa área (Abdullah et al., 2022; Hajli et al., al., 2022).

1.4. Escopo e objetivos do artigo

Este documento de ponto de vista visa fornecer uma análise detalhada da detecção de bots sociais no contexto da crescente sofisticação dos chatbots gerados por IA, como o ChatGPT. Ele se concentrará nos desafios e oportunidades que uma nova geração de chatbots traz para a detecção de bots, enfatizando a necessidade de soluções inovadoras e colaboração das partes interessadas.

Desafios da detecção de bots: a complexidade dos chatbots orientados por IA, como o ChatGPT, apresenta obstáculos significativos às técnicas tradicionais de detecção de bots, como sistemas baseados em regras e abordagens de engenharia de recursos (Cresci et al., 2020). Os pesquisadores estão se voltando para técnicas avançadas de aprendizado de máquina e aprendizado profundo para resolver esse problema (Yang et al., 2019; Varol et al., 2017). Este artigo se aprofundará nas limitações existentes do ensaio e discutirá possíveis soluções.

Práticas recomendadas e direções futuras: este artigo se concentrará nas práticas recomendadas para detecção de bots sociais, incluindo a combinação de diferentes técnicas de detecção, atualizações contínuas de modelos e abordagem de considerações éticas nos métodos de detecção. Também explorará potenciais tendências futuras na detecção de robôs sociais, como a adoção de técnicas explicáveis de inteligência artificial (Adadi e Berrada, 2018) e a integração de métodos de interação humano-robô (Holzinger, 2016).

2. A evolução das técnicas de detecção de bots sociais

2.1. Métodos de detecção precoce baseados em heurísticas simples

Nos estágios iniciais da detecção de bots sociais, os pesquisadores contavam principalmente com heurísticas simples e sistemas baseados em regras para identificar bots (Ferrara, et al., 2016; Cresci, 2020; Orabi, et al., 2020). Essas técnicas se concentram na exploração de padrões e recursos facilmente observáveis para indicar um comportamento semelhante ao do robô.

Atividade da conta: os bots geralmente exibem mensagens de alta frequência e atividades da conta em comparação com usuários humanos. Ao analisar o número de postagens, retuítes ou mensagens por unidade de tempo, os pesquisadores foram capazes de identificar bots em potencial (Benevenuto et al., 2010).

Metadados da conta: certos metadados associados a um perfil de usuário, como data de criação da conta, número de seguidores e proporção de seguidores para seguidores, podem ser indicativos do comportamento do bot. Por exemplo, os bots geralmente têm taxas de seguidores desproporcionalmente altas e ciclos de vida de conta curtos (Chu, et al., 2010; Wang, et al., 2012).

Recursos baseados em conteúdo: os bots geralmente geram conteúdo repetitivo, contém palavras-chave específicas ou se origina de fontes limitadas . Ao analisar a diversidade de conteúdo, a presença de certas palavras-chave e a distribuição de fontes, os pesquisadores podem identificar bots em potencial (Ratkiewicz et al., 2011; Lee et al., 2011).

Recursos baseados em rede: os bots geralmente exibem padrões de rede distintos, como formar grupos fortemente conectados ou ter poucos relacionamentos recíprocos. Ao analisar a estrutura das redes de seguidores e amigos, os pesquisadores podem detectar possíveis contas de bot (Stringhini et al., 2010).

Embora esses métodos de detecção precoce forneçam a base para a identificação de robôs sociais, eles têm capacidade limitada de se adaptar à complexidade crescente do comportamento do robô. Robôs mais avançados podem contornar facilmente esses métodos baseados em heurísticas, imitando o comportamento humano, ajustando seus padrões de atividade ou gerando conteúdo diferente (Chang e Ferrara, 2022).

Além disso, a dependência de regras e recursos criados manualmente torna esses métodos suscetíveis a falsos positivos e falsos positivos, pois usuários reais podem exibir comportamento semelhante ao de um bot e vice-versa. Essa limitação levou ao desenvolvimento de técnicas mais avançadas que combinam aprendizado de máquina e processamento de linguagem natural para melhorar a precisão e a adaptabilidade da detecção (Subrahmanian et al., 2016; Ferrara et al., 2016).

2.2. A incorporação de aprendizado de máquina e processamento de linguagem natural

À medida que os bots sociais se tornam mais sofisticados, os métodos de detecção continuam a evoluir, incluindo aprendizado de máquina e técnicas de processamento de linguagem natural (NLP). Essas abordagens inovadoras visam identificar bots analisando padrões diferenciados no comportamento do bot, uso da linguagem e características da rede, melhorando assim a precisão e a adaptabilidade em comparação com os métodos heurísticos tradicionais.

Algoritmos de aprendizado de máquina, como árvores de decisão, máquinas de vetores de suporte, regressão logística e florestas aleatórias, são usados para classificar contas como bots ou humanos com base em diferentes características de seu comportamento online (Subrahmanian et al., 2016; Ferrara et al.) e outros, 2016). Ao treinar modelos em conjuntos de dados validados de bot e contas humanas, os pesquisadores projetaram classificadores que generalizaram para instâncias desconhecidas e se adaptaram ao comportamento em evolução dos bots sociais.

A eficácia da detecção baseada em aprendizado de máquina depende muito da qualidade dos recursos de classificação , que incluem metadados de conta, recursos baseados em conteúdo e atributos baseados em rede. Recursos linguísticos de conteúdo gerado por bot, como pontuações de sentimento, diversidade lexical e distribuição de tópicos, também são usados (Davis et al., 2016; Kudugunta e Ferrara, 2018).

Em situações em que a obtenção de dados rotulados é limitada ou cara, os pesquisadores recorrem a técnicas de aprendizado não supervisionado e semi-supervisionado para detectar bots. Técnicas como agrupamento, detecção de outliers e propagação de rótulos tentam identificar bots analisando estruturas e padrões de dados inerentes, sem exigir rótulos explícitos (Chavoshi et al., 2016; Cao et al., 2014). Esses métodos podem descobrir novos comportamentos e padrões de robôs que as técnicas de aprendizado supervisionado deixam passar .

Além disso, os pesquisadores aplicaram técnicas de PNL para analisar as características linguísticas do texto gerado pelo robô. A análise de sentimentos, a modelagem de tópicos e a análise sintática permitem a extração de padrões e estruturas linguísticas de nível superior (Beskow e Carley, 2018; Addawood et al., 2019). Ao integrar os recursos de NLP em modelos de aprendizado de máquina, os pesquisadores podem distinguir com mais eficácia o conteúdo gerado por robôs do conteúdo gerado por humanos.

2.3. Abordagens baseadas em aprendizado profundo e redes neurais

O advento do aprendizado profundo e das técnicas de redes neurais revolucionou o campo da detecção de robôs sociais. Essas técnicas avançadas podem aprender padrões e recursos complexos a partir de dados brutos, eliminando assim a necessidade de engenharia manual de recursos. Eles têm sido usados para examinar o conteúdo textual e os metadados associados aos perfis e atividades do usuário, fornecendo recursos de detecção mais fortes do que os métodos tradicionais de aprendizado de máquina e NLP.

As redes neurais convolucionais (CNNs) foram implantadas para examinar o conteúdo do texto e extrair recursos complexos de sequências de palavras ou caracteres . Essas redes consistem em várias camadas de operações de convolução e agrupamento que podem reconhecer padrões e hierarquias locais nos dados (Zhang et al., 2015). Pesquisadores usaram CNNs para detectar bots sociais estudando padrões textuais e recursos em conteúdo gerado por bots sociais (Min et al., 2017; Cresci et al., 2017). Redes neurais recorrentes (RNN) e redes de memória de curto prazo (LSTM) (Hochreiter e Schmidhuber, 1997; Chung et al., 2014) têm sido usadas para analisar dependências temporais e sequências em conteúdo gerado por robôs sociais. Essas redes são excelentes para aprender dependências de longo alcance e capturar dados contextuais, tornando-as ideais para analisar sequências de texto, atividades do usuário ou dados de séries temporais. Eles têm sido usados para identificar bots sociais com base em seu conteúdo gerado e padrões e estruturas de atividade temporal (Kedugunta e Ferrara, 2018). Graph Neural Networks (GNNs) têm sido usadas para modelar a estrutura da rede e as interações entre usuários em plataformas online. Essas redes, projetadas para detectar padrões relacionais complexos e dependências em dados estruturados em gráficos, têm sido usadas para detectar bots sociais com base em propriedades de rede e padrões relacionais (Guo et al., 2021).

Por fim, os pesquisadores aproveitam a aprendizagem por transferência e modelos de linguagem pré-treinados, como BERT, GPT e RoBERTa (Devlin et al., 2018; Radford et al., 2018; Liu et al., 2019) para detecção de bots sociais. Esses modelos são pré-treinados em extensos corpora de texto e ajustados para tarefas específicas, que podem extrair informações semânticas e sintáticas ricas do texto. A utilização desses modelos pré-treinados pode aprimorar os recursos de detecção e ajudar a distinguir entre conteúdo gerado por humanos e por robôs (Heidari e Jones, 2020; Guo et al., 2021). A aprendizagem por transferência mostrou-se promissora na adaptação de modelos de detecção de robôs existentes para configurações de linguagem de baixo recurso, melhorando o desempenho da detecção mesmo sob restrições de dados estritas (Haider et al., 2023).

2.4. O impacto de grandes modelos de linguagem em técnicas de detecção

A ascensão dos chatbots gerados por IA, como o ChatGPT, traz novos desafios para a detecção de bots sociais. Esses modelos sofisticados podem gerar texto semelhante ao humano com notável coerência, fluência e consciência de contexto (Radford et al., 2019). Como resultado, os métodos de detecção tradicionais que dependem de padrões linguísticos ou recursos baseados em conteúdo podem ter dificuldade em distinguir entre conteúdo gerado por IA e conteúdo gerado por humanos (Gehrmann et al., 2019; Zellers et al., 2019; Grimme et al., 2022) ).

Os pesquisadores começaram a desenvolver métodos e técnicas de detecção inovadores para enfrentar os desafios colocados pelo ChatGPT e chatbots semelhantes gerados por IA. é encontrar exemplos adversários ou artefatos específicos para os dados ou arquitetura de treinamento do modelo. Ao estudar anomalias e vieses no texto gerado, os pesquisadores podem identificar padrões ou características que indicam conteúdo gerado por IA (Ippolito et al., 2020; Solaiman et al., 2019). Além disso, o ajuste fino de modelos de linguagem pré-treinados em conjuntos de dados contendo conteúdo gerado por IA e gerado por humanos pode melhorar os recursos de detecção desses modelos (Guo et al., 2021).

À medida que o texto gerado por IA se torna mais complexo, os pesquisadores estão comparando bots sociais baseados em texto a técnicas de deepfake que geram imagens ou vídeos realistas e manipulados. Técnicas desenvolvidas para detecção de deepfake, como recursos forenses, aprendizado conjunto e treinamento adversário, podem ser aplicáveis à detecção de texto gerado por IA (Afchar et al., 2018; Li et al., 2020). Os pesquisadores estão explorando técnicas de inteligência artificial explicável (XAI) e métodos de atribuição de recursos, como LIME, SHAP e gradientes de conjunto (Ribeiro et al., 2016; Lundberg e Lee, 2017; Sundararajan et al., 2017) para entender melhor a tomada de decisão. fazendo o processo de modelos de aprendizado profundo e aprimorando seus recursos de detecção. Ao revelar fatores que influenciam as previsões do modelo, esses métodos podem ajudar a identificar novos recursos e padrões indicativos de conteúdo gerado por IA, informando assim o design de técnicas de detecção mais eficazes.

À medida que os chatbots gerados por IA continuam a se desenvolver, eles podem ser usados em configurações multimodais, como gerar texto e imagens simultaneamente ou participar de conversas interativas. Os pesquisadores começaram a investigar técnicas de detecção multimodal que podem analisar e integrar informações de várias modalidades para melhorar a precisão da detecção (Cao et al., 2023).

3. Novos desafios na detecção de bots sociais

Nesta seção, discutimos os novos desafios na detecção de bots sociais devido aos avanços na inteligência artificial e nas técnicas de processamento de linguagem natural. Esses desafios incluem conteúdo gerado por IA cada vez mais complexo, ataque adversário e táticas de evasão empregadas por agentes mal-intencionados, a necessidade de métodos de detecção escaláveis e em tempo real e considerações éticas e questões de privacidade que devem ser abordadas. Ao estudar esses desafios, pretendemos obter uma compreensão mais profunda das complexidades envolvidas na detecção e mitigação do impacto dos robôs sociais na era digital.

3.1. Conteúdo gerado por IA cada vez mais sofisticado

O advento de chatbots avançados gerados por IA, como o ChatGPT e seus sucessores, pode levar a um aumento significativo na sofisticação do conteúdo gerado por bots sociais. As técnicas de detecção tradicionais que dependem de recursos baseados em conteúdo ou métodos de aprendizado superficial podem ter dificuldade em distinguir o conteúdo gerado por humanos do conteúdo gerado por IA.

Vários estudos recentes destacam os desafios impostos pelo conteúdo complexo gerado por IA no contexto da detecção de bots sociais:

A pesquisa GLTR (Gehrmann et al., 2019) descobriu que mesmo um modelo de linguagem simples como o GPT-2 pode gerar texto que é difícil, mesmo para anotadores especializados, distingui-lo do texto escrito por humanos. Presumivelmente, futuras iterações de modelos de linguagem baseados em GPT (incluindo ChatGPT e GPT-4) reduziram a lacuna entre conteúdo gerado por humanos e conteúdo gerado por IA, o que tem implicações para técnicas de detecção baseadas em padrões de linguagem ou recursos baseados em conteúdo. .

O estudo GROVER (Zellers et al., 2019) demonstrou que o texto gerado por IA pode ser muito eficaz para evitar a detecção por humanos e classificadores automatizados. Os pesquisadores descobriram que os modelos de linguagem pré-treinados, quando ajustados na tarefa de gerar e detectar contas falsas, eram mais eficazes na geração de conteúdo enganoso e mais robustos a ataques adversários.

A detecção de conteúdo gerado por IA (como legendas de imagens ou descrições de vídeo) em um ambiente multimodal apresenta desafios adicionais devido à necessidade de integrar e analisar informações de várias modalidades. Para enfrentar esses desafios, os pesquisadores começaram a explorar novas técnicas e métodos de detecção para distinguir efetivamente o conteúdo gerado por humanos do conteúdo gerado por IA. A identificação de exemplos adversários ou artefatos específicos para modelar dados ou arquitetura de treinamento pode ajudar a detectar conteúdo gerado por IA (Solaiman et al., 2019; Wolff e Wolff, 2020; Ippolito et al., 2020).

Aproveitar o conhecimento contido em modelos de linguagem pré-treinados, como BERT, GPT e RoBERTa, pode aprimorar os recursos de detecção de classificadores, capturando informações semânticas e sintáticas ricas em texto (Cresci et al., 2017; Heidari e Jones, 2020; Guo et al., 2017; Heidari e Jones, 2020; Guo et al. al., 2021). Empregar técnicas de IA explicáveis e métodos de atribuição de recursos pode fornecer informações sobre fatores que influenciam as previsões do modelo, ajudando a identificar novos recursos e padrões indicativos de conteúdo gerado por IA.

3.2. Ataques adversários e táticas de evasão

À medida que as técnicas de detecção de bots sociais evoluem, também evoluem as estratégias usadas por agentes mal-intencionados para evitar a detecção. Os robôs sociais são cada vez mais hábeis em evitar a detecção, empregando ataques adversários e estratégias de evasão, apresentando desafios significativos para pesquisadores e profissionais da área. Algumas das principais estratégias e desafios nesta área incluem:

Imitando o comportamento humano: os bots sociais podem cada vez mais adaptar seu comportamento para imitar usuários humanos, tornando-os mais difíceis de detectar usando padrões comportamentais ou recursos baseados em rede (Chang e Ferrara, 2022). Técnicas como análise de sentimento, modelagem de tópicos e criação de perfil de usuário têm sido usadas para distinguir melhor o comportamento humano real do comportamento do bot (Chavoshi et al., 2016; Cresci et al., 2017).

Geração dinâmica de conteúdo: os bots sociais podem empregar estratégias de geração de conteúdo mais diversificadas e sofisticadas, aproveitando os recursos de chatbots avançados gerados por IA, como o ChatGPT, para gerar texto sensível ao contexto, coerente e semelhante ao humano (Zellers et al., 2019). Isso requer o desenvolvimento de novas técnicas de detecção baseadas em conteúdo que possam reconhecer o texto gerado por IA e distingui-lo do conteúdo gerado por humanos.

Adversarial Machine Learning: Atores mal-intencionados podem explorar vulnerabilidades de técnicas de detecção baseadas em aprendizado de máquina criando exemplos contraditórios projetados para enganar classificadores (Biggio et al., 2013). Os pesquisadores precisam desenvolver técnicas de detecção mais fortes e resilientes que possam resistir a ataques adversários, usando métodos como treinamento adversário, aprendizado conjunto e aumento de dados (Szegedy, et al., 2013; Goodfellow, et al., 2014; Tramèr, et al. ., 2017).

Camuflagem e ofuscação: os bots sociais podem empregar várias estratégias de camuflagem e ofuscação, como alterar seus padrões de postagem, alterar sua estrutura de rede ou usar diferentes canais de comunicação para evitar a detecção (Ferrara et al., 2016; Grimme et al., 2018). Os pesquisadores devem monitorar e adaptar constantemente seus métodos de detecção a essas ameaças em constante mudança , incorporando novos recursos e atualizando seus modelos conforme necessário.

3.3. Escalabilidade e detecção em tempo real

A detecção de bots sociais em ambientes on-line dinâmicos em larga escala apresenta desafios significativos em termos de escalabilidade e detecção em tempo real. Plataformas populares de mídia social geram grandes quantidades de dados, exigindo tecnologias de detecção que possam processar e analisar essas informações de forma rápida e eficiente. Além disso, a rápida disseminação de informações nas redes sociais requer detecção em tempo real ou quase em tempo real para mitigar os efeitos das atividades maliciosas de bots sociais antes que causem danos significativos. Isso é especialmente verdadeiro para conteúdo prejudicial, pois rumores negativos, inflamatórios e falsos se espalham mais rapidamente (Ferrara e Yang, 2015; Stella et al., 2018; Vosoughi et al., 2018).

Muitas técnicas avançadas de detecção, especialmente aquelas baseadas em aprendizado profundo e redes neurais, exigem recursos computacionais significativos, e o treinamento e a execução podem consumir muito tempo. Por exemplo, treinar modelos Transformer em larga escala, como BERT ou GPT, envolve sobrecarga computacional significativa, dificultando a implantação desses modelos para detecção de bots sociais em tempo real (Devlin et al., 2018; Radford et al., 2019). Para enfrentar esses desafios, os pesquisadores exploraram várias abordagens para melhorar a escalabilidade e a eficiência das técnicas de detecção de bots sociais:

Compressão e destilação de modelos: a destilação de conhecimento técnico, como poda e quantização de modelos, pode ser usada para reduzir o tamanho e a complexidade computacional de modelos de aprendizado profundo, permitindo uma implantação mais eficiente em cenários de detecção em tempo real (Buciluǎ, et al., 2006). Esses métodos podem ajudar a manter a precisão do modelo enquanto reduzem a sobrecarga computacional associada ao treinamento e à inferência.

Aprendizagem incremental e algoritmos online: técnicas de aprendizagem incremental e algoritmos online podem se adaptar a novos dados para uma detecção mais eficaz em ambientes dinâmicos (JafariAsbagh et al., 2014). Esses métodos podem atualizar o modelo de forma incremental, reduzir a necessidade de retreinamento dispendioso e permitir a detecção em tempo real ou quase em tempo real de bots sociais.

Processamento Paralelo e Distribuído: Técnicas de processamento paralelo e distribuído podem ser usadas para explorar o poder computacional de vários processadores ou máquinas, permitindo processamento e análise eficientes de dados de mídia social em larga escala (Gao et al., 2015). Esses métodos podem ajudar a dimensionar as técnicas de detecção de bots sociais para lidar com grandes quantidades de dados gerados por plataformas populares de mídia social.

Processamento baseado em fluxo e redução de dados: técnicas de processamento baseadas em fluxo podem ser usadas para analisar os dados gerados em tempo real, permitindo uma detecção mais eficiente de bots sociais em ambientes online dinâmicos (Morstatter et al., 2013; JafariAsbagh) et al. , 2014; Gao et al., 2015). Técnicas de redução de dados, como amostragem, esboço e agregação, também podem ser usadas para minimizar a quantidade de dados que precisam ser processados e armazenados, aumentando assim a eficiência das técnicas de detecção.

3.4. Considerações éticas e preocupações com a privacidade

As técnicas de detecção de bots sociais abordam ambientes éticos e de privacidade complexos. Garantir que a detecção e mitigação de bots maliciosos não violem os direitos de usuários genuínos ou comprometam suas informações pessoais é fundamental. Portanto, os desafios éticos e relacionados à privacidade devem ser abordados durante o desenvolvimento e implantação de técnicas de detecção de bots sociais.

Uma grande preocupação com a detecção de bots sociais é o risco de falsos positivos, em que usuários legítimos são erroneamente identificados como bots. Isso pode ter consequências injustas para usuários inocentes, como suspensão de conta ou remoção de conteúdo, potencialmente violando sua liberdade de expressão e direito à informação. Para minimizar esse risco, os pesquisadores devem se concentrar no desenvolvimento de técnicas de detecção extremamente precisas e amplamente validadas em conjuntos de dados diversos e representativos. Além disso, a transparência e a explicabilidade do processo de tomada de decisão são fundamentais para garantir a detecção e mitigação justa e imparcial de bots sociais (Ribeiro et al., 2016).

A detecção de bots sociais geralmente envolve a análise de conteúdo, metadados e padrões comportamentais gerados pelo usuário, que levantam preocupações significativas de privacidade e proteção de dados. Para proteger a privacidade do usuário, as tecnologias de detecção devem cumprir os regulamentos de proteção de dados, como o Regulamento Geral de Proteção de Dados da UE (GDPR), e devem minimizar a coleta, o armazenamento e o processamento de informações pessoais confidenciais. O uso de técnicas de preservação da privacidade, como privacidade diferencial e aprendizado federado, pode ajudar a proteger os dados do usuário durante a análise (Dwork, 2006; Ezzeldin, et al., 2021), mas tem limitações (Fung, et al., 2020).

O rápido desenvolvimento de conteúdo gerado por IA apresenta oportunidades e desafios para a detecção de bots sociais. Embora esses modelos possam melhorar a precisão e robustez das técnicas de detecção, eles também podem ser mal utilizados por agentes mal-intencionados para criar bots sociais mais avançados e indescritíveis. Portanto, pesquisadores e profissionais precisam garantir que o desenvolvimento e a implantação de conteúdo gerado por IA para detecção de bots sociais sejam feitos de forma ética e responsável, com salvaguardas adequadas para evitar o uso indevido.

4. Oportunidades e tendências emergentes

Nesta seção, exploramos as oportunidades e tendências emergentes que moldam o futuro da detecção de robôs sociais. Esses desenvolvimentos oferecem maneiras inovadoras de enfrentar os desafios impostos pelo conteúdo gerado por IA cada vez mais sofisticado e pelas táticas adversárias empregadas pelos bots sociais. Discutiremos o potencial do aprendizado por transferência e aprendizado não supervisionado, métodos de detecção multimodal, o papel do aprendizado colaborativo e federado e a importância da IA explicável e explicabilidade nas técnicas de detecção. Também discutimos oportunidades para combinar várias técnicas de detecção e ajustar o modelo ao longo do tempo. Por fim, propomos a ideia de usar agentes generativos como fonte de dados sintéticos de treinamento. Ao destacar essas oportunidades, pretendemos fornecer um roteiro para que pesquisadores e profissionais aproveitem esses avanços e melhorem a eficácia da detecção de bots sociais.

4.1. Aproveitando o aprendizado por transferência e o aprendizado não supervisionado

Transferir Caso de Aprendizagem

O aprendizado por transferência é uma técnica que permite que os modelos aproveitem o conhecimento adquirido de modelos pré-treinados ou tarefas relacionadas , que podem ser ajustados para detectar robôs sociais (Pan e Yang, 2010). Por exemplo, modelos de linguagem pré-treinados, como BERT (Devlin, et al., 2018) e GPT (Radford, et al., 2019), demonstraram a eficácia da aprendizagem por transferência em tarefas de processamento de linguagem natural. Ao ajustar esses modelos em conjuntos de dados menores e específicos de tarefas, os pesquisadores podem aproveitar as ricas informações semânticas e sintáticas capturadas durante o pré-treinamento para reconhecer o conteúdo gerado pelo bot. Essa abordagem pode ajudar a melhorar a precisão dos classificadores, reduzindo a necessidade de grandes quantidades de dados de treinamento rotulados. Além disso, o aprendizado por transferência pode ajudar a mitigar os efeitos da mudança de domínio, que ocorre quando a distribuição dos dados usados para treinamento difere daquela dos dados de destino (Torrey e Shavlik, 2010). Ao alavancar modelos pré-treinados, os pesquisadores podem se adaptar de forma mais eficaz às mudanças de comportamento e estratégias dos robôs sociais , conforme demonstrado no trabalho de Yang et al. (2020) Detecção de robôs usando modelos baseados em BERT.

Exemplos de Técnicas de Aprendizagem Não Supervisionada (Autoencoders)

As técnicas de aprendizagem não supervisionadas não requerem dados rotulados e podem ser usadas para identificar padrões, anomalias ou agrupamentos de dados que podem indicar a atividade do robô social (Chandola et al., 2009). Abordagens híbridas, como agrupamento, redução de dimensionalidade e codificadores automáticos, podem ajudar a capturar a estrutura subjacente dos dados e revelar o comportamento semelhante ao de um robô subjacente sem depender de exemplos rotulados. Por exemplo, técnicas de redução de dimensionalidade, como a incorporação de vizinhança estocástica com distribuição t (tSNE), podem ser usadas para visualizar dados de alta dimensão, facilitando a identificação de padrões e anomalias de comportamento do usuário (van der Maaten e Hinton, 2008). Combinados com um autoencoder (um tipo de rede neural), eles podem ser usados para aprendizado de recursos não supervisionado, capturando representações latentes de dados que podem ser úteis para detectar robôs (Haider et al., 2023).

Em resumo, alavancar o aprendizado por transferência e métodos de aprendizado não supervisionados pode enfrentar desafios relacionados à escassez de dados, processo de anotação caro e adaptação à mudança de comportamento dos robôs em tarefas de detecção de robôs sociais. Aproveitando o rico conhecimento capturado por modelos pré-treinados e técnicas não supervisionadas, os pesquisadores podem desenvolver métodos de detecção mais precisos e robustos.

4.2. Abordagens multimodais para detecção

Abordagens multimodais que combinam diferentes tipos de dados, como texto, imagens e recursos de rede, podem fornecer uma compreensão mais abrangente e robusta do comportamento do usuário, levando a uma melhor detecção de bots sociais. Ao integrar diferentes fontes de informação, essas técnicas podem capturar padrões complexos e sutis em dados que podem passar despercebidos por abordagens unimodais.

Pesquisa em Abordagens Multimodais (Texto e Imagem)

Recentemente, tem havido um interesse crescente no uso de dados multimodais para detecção de bots sociais. Uma direção promissora é a integração da análise de texto e imagem. Por exemplo, Wu e outros (2019) propuseram uma abordagem multimodal para detecção de notícias falsas por meio da modelagem conjunta de informações textuais e visuais. Seu método usa uma rede de atenção hierárquica para capturar dependências entre texto e recursos visuais , permitindo que o modelo identifique bots que espalham informações enganosas por meio de texto e conteúdo visual. Da mesma forma, Besel e outros (2018) propuseram um modelo que combina pistas textuais e visuais para detectar bots sociais no Twitter, demonstrando a eficácia de abordagens multimodais na captura de informações complementares.

Abordagem multimodal de pesquisa (web, tempo e conteúdo)

Outra direção das abordagens multimodais é a combinação de recursos de rede . A detecção de bots sociais pode se beneficiar da análise das interações do usuário e da estrutura da rede, que podem revelar padrões de interação suspeitos ou estruturas de rede que podem indicar atividade de bot coordenada (Pacheco et al., 2020; Pacheco et al., 2021). Sharma e outros (2021) propuseram um método para combinar recursos temporais com recursos baseados em conteúdo para coordenar atividades de influenciadores em plataformas de mídia social, demonstrando o valor dos recursos temporais.

A abordagem multimodal também pode ser estendida a outros tipos de dados, como áudio ou vídeo, para melhorar ainda mais a detecção de bots sociais. Por exemplo, a análise de áudio ou vídeo pode ser usada para identificar bots que geram ou distribuem deepfakes , que representam uma ameaça significativa para as plataformas online (Rössler et al.). A combinação dessas diferentes fontes de informação pode gerar métodos de detecção mais precisos e robustos, mais capazes de lidar com a natureza evolutiva dos bots sociais.

Em resumo, uma abordagem multimodal para a detecção de bots sociais é uma grande promessa para melhorar a eficiência dos métodos de detecção . Ao combinar diferentes tipos de dados, como texto, imagens e recursos da Web, os pesquisadores podem capturar padrões complexos e sutis nos dados que podem passar despercebidos por abordagens unimodais. Isso pode levar a técnicas de detecção de bots sociais mais precisas e robustas, mitigando com mais eficácia o impacto negativo dos bots sociais em plataformas online.

4.3. Aprendizagem colaborativa e federada para detecção

As abordagens de aprendizado colaborativo e federado podem permitir o aprendizado federado e o compartilhamento de conhecimento em várias organizações ou plataformas, preservando a privacidade dos dados. Esses métodos permitem que os modelos sejam treinados em fontes de dados distribuídas sem a necessidade de dados centralizados , o que ajuda a superar as preocupações com a privacidade e as limitações de compartilhamento de dados. Ao reunir o conhecimento coletivo e os recursos de diferentes organizações, essas abordagens podem levar a técnicas de detecção de bots sociais mais precisas e robustas que podem ser implantadas em diferentes plataformas e domínios.

O aprendizado federado é uma abordagem de aprendizado de máquina distribuído que permite que vários clientes treinem de forma colaborativa um modelo compartilhado, mantendo os dados localmente (McMahan et al., 2016). Essa abordagem é particularmente útil para a detecção de bots sociais, pois permite a criação de modelos globais com base no conhecimento coletivo de organizações individuais sem comprometer a privacidade dos dados do usuário. Em uma configuração de aprendizagem federada, cada organização treina um modelo local usando seus dados e apenas compartilha as atualizações do modelo (por exemplo, gradientes) com um servidor central, que agrega essas atualizações para melhorar o modelo global. Esse processo se repete até a convergência, resultando em um modelo que se beneficia das diversas experiências das organizações participantes.

Pesquisa sobre aprendizagem federada

Vários estudos exploraram o potencial do aprendizado federado para a detecção de bots sociais. Por exemplo, Feng e outros (2020) propuseram um método de aprendizado federado para detectar bots sociais em redes sociais online. Eles demonstram que seu método pode detectar bots com eficácia, preservando a privacidade dos dados, mesmo na presença de dados não IID (distribuídos de forma independente e idêntica) entre os clientes. Da mesma forma, Nguyen e outros (2021) propuseram uma estrutura de aprendizagem federada para detecção de bots sociais que utiliza um mecanismo de atenção hierárquico para capturar as relações entre recursos do usuário, recursos de conteúdo e recursos de rede social.

aprendizado colaborativo

A aprendizagem colaborativa é outra abordagem para a aprendizagem distribuída que permite que várias organizações aprendam em conjunto com os dados, preservando a privacidade (Veale et al., 2018). Em contraste com o aprendizado federado, que depende de um servidor central para agregar atualizações de modelo, as técnicas de aprendizado colaborativo geralmente dependem de protocolos descentralizados (como aprendizado de fofocas ou redes ponto a ponto) para trocar informações e aprender uns com os outros. O aprendizado colaborativo é especialmente útil em situações em que não há um servidor central confiável ou quando uma organização deseja manter o controle sobre seus dados e processo de aprendizado.

Por fim, as abordagens de aprendizado colaborativo e federado têm grande potencial para melhorar a detecção de bots sociais em várias organizações e plataformas, preservando a privacidade dos dados (Ezzeldin et al., 2021). Ao permitir o aprendizado federado e o compartilhamento de conhecimento sem a necessidade de dados centralizados, esses métodos podem ajudar a superar as limitações das técnicas tradicionais de aprendizado de máquina e levar a métodos de detecção de bots sociais mais precisos e robustos.

4.4. IA explicável e interpretabilidade em técnicas de detecção

A inteligência artificial explicável (XAI) e a explicabilidade desempenham um papel crítico no aumento da credibilidade, transparência e responsabilidade das tecnologias de detecção de bots sociais . Ao entender o processo de tomada de decisão subjacente aos modelos de IA, as partes interessadas podem obter informações sobre os fatores que contribuem para a detecção de bots sociais, levando a decisões mais informadas e à melhoria dos métodos de detecção. Além disso, a explicabilidade pode ajudar a abordar preocupações sobre preconceito e implicações éticas, que são especialmente importantes no contexto de plataformas online e mídias sociais.

Modelos interpretáveis, como árvores de decisão, modelos lineares e sistemas baseados em regras, são inerentemente interpretáveis porque seu processo de tomada de decisão é facilmente compreendido por humanos (Ribeiro, et al., 2016). Por exemplo, as árvores de decisão permitem a visualização do processo de decisão, com nós representando segmentações de atributos e nós folhas representando decisões de categorias (Quinlan, 1986). No contexto da detecção de robôs sociais, as árvores de decisão podem ajudar a identificar os principais recursos e regras de decisão que indicam o comportamento do robô (Ferrara et al., 2016).

tecnologia explicável

No entanto, muitos modelos de aprendizado de máquina de última geração, como redes neurais profundas, são frequentemente considerados modelos de caixa preta devido à sua arquitetura complexa e grande número de parâmetros (Adadi e Berrada, 2018). Para tornar esses modelos mais interpretáveis, várias técnicas foram propostas, incluindo Explicação Agnóstica de Modelo Interpretável Localmente (LIME) e Explicação Aditiva SHApley (SHAP) .

O LIME é uma técnica de interpretação que visa fornecer explicações locais para predições individuais de modelos caixa-preta (Ribeiro et al., 2016). Ele funciona usando um modelo interpretável como um modelo linear ou uma árvore de decisão para aproximar o limite de decisão local do modelo . Na detecção de bots sociais, o LIME pode ajudar a identificar os recursos mais importantes para classificar um usuário específico como um bot ou um ser humano , fornecendo, assim, informações sobre o processo de tomada de decisão subjacente.

O SHAP é outra técnica de explicação baseada na teoria dos jogos cooperativos que atribui um valor de importância a cada recurso, calculando contribuição para a previsão de uma determinada instância (Lundberg e Lee, 2017). Ao calcular o valor de Shapley para cada recurso, o SHAP pode fornecer uma distribuição consistente e justa das contribuições de previsão em todos os recursos. No contexto da detecção de bot social, SHAP pode ajudar a descobrir os recursos mais influentes que ajudam a detectar bots, facilitando assim a compreensão e melhoria dos métodos de detecção.

Em resumo, a IA explicável e a explicabilidade são essenciais para aumentar a credibilidade, a transparência e a responsabilidade das tecnologias de detecção de bots sociais. Ao fornecer informações sobre o processo de tomada de decisão dos modelos de IA, as partes interessadas podem tomar decisões mais informadas, melhorar os métodos de detecção e abordar preocupações sobre viés e implicações éticas. Pesquisas futuras devem se concentrar no desenvolvimento de modelos de detecção de robôs sociais mais explicáveis e explicáveis e na exploração da interação entre explicabilidade e desempenho do modelo.

4.5. Combinando várias técnicas de detecção

A detecção efetiva de bots sociais requer uma abordagem integrada que considere os diferentes comportamentos e estratégias empregadas por essas entidades maliciosas. A integração de várias técnicas de detecção pode levar a resultados mais precisos e robustos, abordando uma ampla gama de características e comportamentos do robô. Nesta seção, exploramos várias técnicas de detecção e sua integração , enquanto nos referimos a trabalhos de pesquisa relacionados.

Integração de aprendizado de máquina e tecnologia de processamento de linguagem natural

Uma abordagem amplamente adotada na detecção de bots sociais é a combinação de aprendizado de máquina e técnicas de processamento de linguagem natural. Ao combinar algoritmos de aprendizado supervisionado e não supervisionado e métodos de processamento de linguagem natural, os pesquisadores podem analisar o conteúdo gerado por bots sociais e identificar padrões e características que os distinguem dos usuários humanos (Ferrara et al., 2016). Por exemplo, Yang e outros (2019) propuseram um método baseado em aprendizado profundo combinando rede neural convolucional (CNN) e rede neural recorrente (RNN) para analisar o conteúdo e as características da detecção de robôs, alcançando alta precisão e recuperação.

Integração da estrutura de rede e informações do usuário, integração da dinâmica de tempo e postagem

A análise da Web é outra técnica importante para detectar bots sociais, pois se concentra na análise da estrutura da rede social e dos padrões de interação das contas de bot. Ao investigar esses padrões, os pesquisadores podem identificar comportamentos anômalos e descobrir campanhas coordenadas , como astroturfing e campanhas de desinformação (Ratkiewicz et al., 2011). A análise temporal também provou ser uma ferramenta inestimável para revelar o comportamento de robôs sociais. Ao estudar a dinâmica temporal da atividade do bot, como frequência de postagem e tempo de interação , os pesquisadores podem identificar padrões incomuns que podem indicar comportamento automatizado (Chavoshi et al., 2016). Em seu estudo, Chavoshi e outros (2016) aplicaram a análise temporal para detectar bots sociais no Twitter examinando correlações distorcidas entre a atividade do usuário e a geração de conteúdo. Seu método identificou bots com sucesso com alta precisão e revocação, demonstrando a eficácia da análise temporal na detecção de bots.

estrutura de plataforma cruzada

A análise de plataforma cruzada é outra técnica promissora para a detecção de bot social, pois envolve o exame do comportamento de contas suspeitas de bot em várias plataformas de mídia social. Ao detectar atividades coordenadas e melhorar a generalidade das técnicas de detecção, os pesquisadores podem desenvolver métodos de detecção de robôs mais eficientes e adaptáveis (Zhou e Zafarani, 2018). Shu, e outros. (2018) introduziram um framework multiplataforma chamado FakeNewsNet para estudar a disseminação de notícias falsas e o papel dos bots sociais em sua disseminação . Ao coletar grandes conjuntos de dados de artigos de notícias rotulados como falsos ou reais e analisar as atividades de bots sociais nas plataformas, eles conseguiram identificar padrões na disseminação de notícias falsas e as características dos bots envolvidos na disseminação de notícias falsas.

Em conclusão, a combinação de várias técnicas de detecção, incluindo aprendizado de máquina e processamento de linguagem natural, análise de rede, análise temporal e análise de plataforma cruzada, pode levar a resultados de detecção de robôs sociais mais precisos e robustos.

4.6. Modelos em constante atualização e ajuste fino

Para lidar efetivamente com o cenário em evolução dos bots sociais, é fundamental manter uma abordagem proativa no desenvolvimento e implantação de modelos de detecção. Isso requer atualização constante e ajuste fino do modelo em resposta às mudanças de táticas e estratégias do operador do robô. Nesta seção, nos aprofundamos em vários aspectos da manutenção e melhoria do modelo com referência a trabalhos de pesquisa relacionados.

Coletar novos conjuntos de dados é importante

Garantir que os dados de treinamento usados para algoritmos de aprendizado de máquina estejam atualizados e representativos do ambiente robótico atual é fundamental para manter a eficácia dos modelos de detecção . Isso pode envolver a coleta de novos dados, a rotulagem de dados existentes ou a incorporação de fontes de dados externas, como conjuntos de dados rotulados de outros pesquisadores ou organizações (Ruchansky et al., 2017). Por exemplo, Cressy e outros (2017) demonstram a importância de usar diversos conjuntos de dados de última geração para treinar e avaliar modelos de detecção de bots sociais. Eles realizaram uma comparação sistemática entre vários conjuntos de dados e descobriram que o desempenho dos modelos treinados em conjuntos de dados mais antigos era significativamente menor do que o dos modelos treinados em dados mais novos e diversos.

É importante que os modelos se adaptem às mudanças da plataforma

Adaptar-se às mudanças da plataforma é outro aspecto importante da manutenção dos modelos de detecção. As plataformas de mídia social estão em constante evolução e as atualizações da API ou da interface do usuário podem afetar a disponibilidade de determinados recursos ou introduzir novos padrões de comportamento de bot . Monitorar essas mudanças e ajustar as técnicas de detecção de acordo pode ajudar a garantir a validade contínua dos modelos de detecção (Gorwa et al., 2020). Por exemplo, Echeverria e Zhou (2017) estudaram o impacto da limitação da taxa da API do Twitter na detecção de bots sociais e descobriram que o limite imposto reduziu a precisão de alguns recursos de detecção, enfatizando a necessidade de adaptar os modelos às mudanças da plataforma.

Ajustar os parâmetros do modelo

O ajuste fino dos parâmetros do modelo é uma parte importante da manutenção da validade do modelo de detecção. Avaliar regularmente o desempenho desses modelos e ajustar seus parâmetros para otimizar a precisão, recuperação e outras métricas relevantes pode melhorar os resultados. Isso pode envolver a experimentação de diferentes conjuntos de recursos, algoritmos ou valores de parâmetros e a realização de validação cruzada para avaliar a robustez do modelo . Kudugunta e Ferrara (2018) introduziram um modelo de aprendizado profundo baseado em rede LSTM contextual para detectar bots sociais no Twitter. Eles ajustaram vários hiperparâmetros do modelo e avaliaram seu desempenho por validação cruzada, demonstrando a importância da otimização de parâmetros para obter os melhores resultados.

no loop de feedback

A incorporação de loops de feedback é outra prática importante na manutenção de modelos de detecção. Estabelecer um mecanismo de feedback para coletar informações do usuário sobre a precisão dos resultados da detecção do robô pode ajudar a refinar o modelo e melhorar seu desempenho. Isso pode envolver crowdsourcing, validação de especialistas ou outras formas de envolvimento do usuário para coletar insights e avaliar a eficácia das técnicas de detecção. Por exemplo, Yang et al. (2022) desenvolveram um sistema chamado Botometer que combina detecção de robôs baseada em aprendizado de máquina com feedback do usuário para melhorar seu desempenho. O sistema permite que os usuários relatem falsos positivos e falsos negativos, e a entrada é usada para ajustar o modelo de detecção subjacente.

Em conclusão, a atualização contínua e o ajuste fino dos modelos de detecção de bots sociais são cruciais para ficar à frente do cenário de bots sociais em constante evolução. Ao empregar práticas como atualização de dados de treinamento, adaptação a mudanças de plataforma, ajuste fino de parâmetros de modelo e incorporação de loops de feedback, pesquisadores e profissionais podem desenvolver técnicas de detecção mais eficazes e resilientes para proteger melhor os ecossistemas de informações online.

4.7. Agentes geradores como fonte de dados sintéticos

O campo de detecção de robôs sociais pode se beneficiar muito com a exploração de dados sintéticos , especialmente dados gerados usando proxies comportamentais humanos confiáveis. Discutimos o potencial de agentes generativos (agentes de software computacional que imitam o comportamento humano plausível) para aprimorar as técnicas de detecção de bots sociais, fornecendo uma rica fonte de dados sintéticos com base em grandes modelos de linguagem.

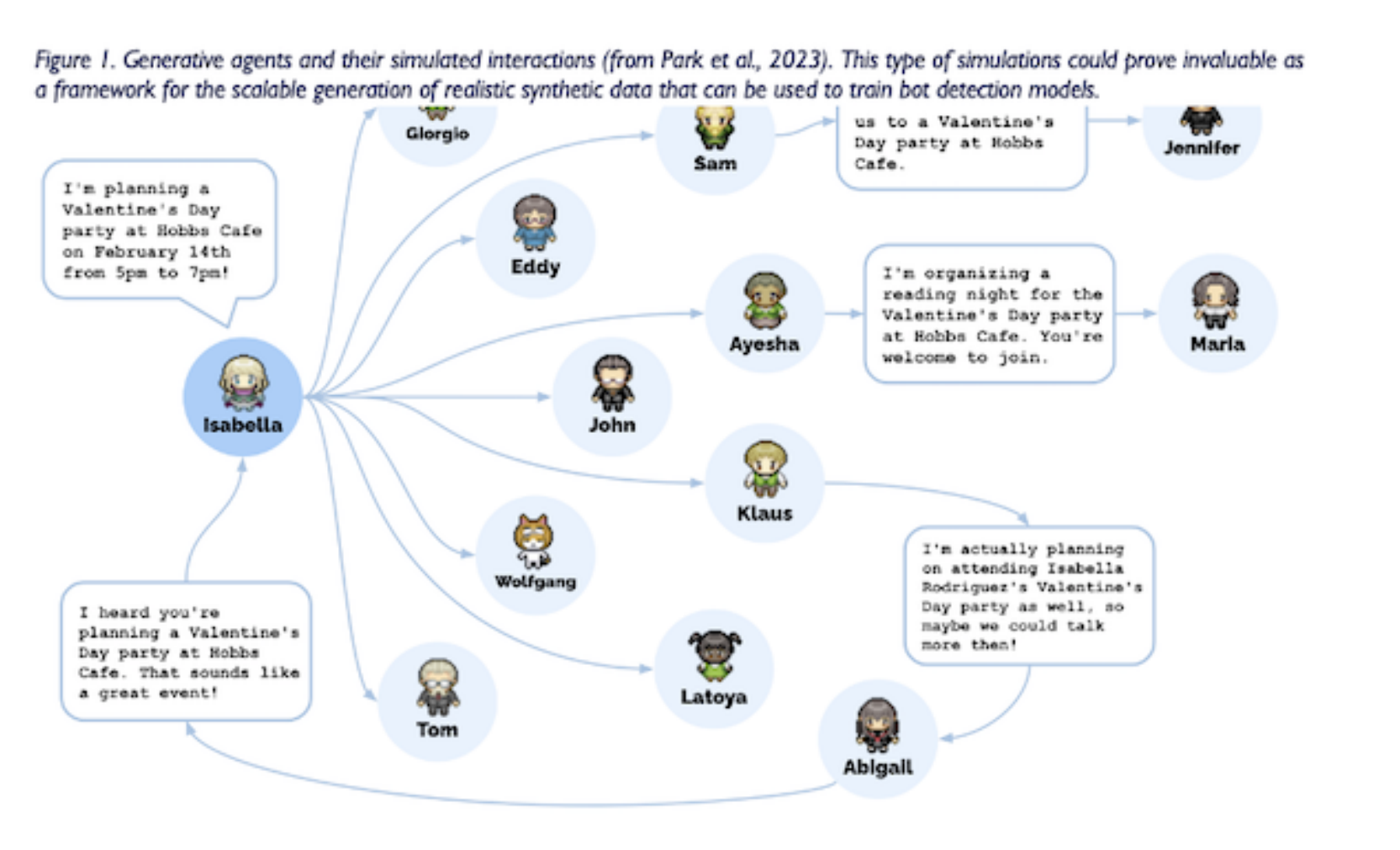

Agentes generativos têm sido explorados na literatura recente, com o objetivo de exibir comportamento humano semelhante a uma classe. Park et al., 2023). Esses agentes podem gerar comportamentos sociais emergentes e pessoais plausíveis (consulte a Figura 1), tornando- os uma fonte valiosa de dados sintéticos para treinamento e avaliação de modelos de detecção de bots sociais .

Ao fundir grandes modelos de linguagem com agentes computacionalmente interativos, os pesquisadores podem gerar grandes quantidades de dados realistas e diversificados que podem ser usados para treinar modelos de detecção mais fortes e precisos. Os dados sintéticos criados pelo agente generativo podem ser usados para simular vários cenários e padrões de comunicação, permitindo que os pesquisadores desenvolvam modelos de detecção que generalizam bem em diferentes ambientes .

Além disso, dados sintéticos criados usando agentes generativos podem ajudar a enfrentar alguns dos desafios enfrentados na detecção de bots sociais, como a escassez de dados rotulados e a natureza em constante evolução do conteúdo gerado por bots. Como os agentes generativos podem ser controlados e manipulados, os pesquisadores podem gerar dados rotulados em escala, reduzindo efetivamente a dependência de anotações manuais e processos de coleta de dados .

Além disso, os agentes generativos podem ser atualizados e ajustados ao longo do tempo para imitar as últimas tendências e padrões observados no conteúdo gerado por bot, garantindo que os dados sintéticos permaneçam relevantes e úteis para treinar e avaliar modelos de detecção. Essa adaptabilidade é fundamental para a batalha contínua contra robôs sociais cada vez mais complexos.

Em conclusão, o uso de agentes generativos e dados sintéticos oferece oportunidades promissoras para aprimorar as técnicas de detecção de bots sociais. Aproveitando grandes modelos de linguagem e proxies computacionais para gerar dados realistas e diversificados , os pesquisadores podem desenvolver modelos de detecção mais fortes e precisos que são mais capazes de identificar e mitigar o impacto de bots sociais mal-intencionados.

5. Estudos de caso: detecção de bots sociais em aplicativos do mundo real

Nesta seção, apresentamos uma série de estudos de caso que ilustram a aplicação prática de técnicas de detecção de robôs sociais em vários domínios. Esses exemplos demonstram a importância da detecção de bot social na abordagem de questões críticas, como interferência eleitoral e manipulação política, campanhas de desinformação e notícias falsas, fraude financeira e manipulação de criptomoedas . Ao examinar esses estudos de caso, pretendemos esclarecer o impacto prático da detecção de bot social e a importância da pesquisa e desenvolvimento contínuos nesse campo.

5.1. Interferência eleitoral e manipulação política

manipulação da opinião pública e interferência eleitoral

Eleição presidencial dos EUA em 2016

Os bots sociais são amplamente utilizados para manipular a opinião pública e interferir nas eleições, pois podem facilmente espalhar propaganda política, desinformação e conteúdo polarizador. A eleição presidencial dos EUA em 2016 é um exemplo bem conhecido em que os bots sociais desempenharam um papel importante na amplificação e disseminação de conteúdo politicamente tendencioso, afetando a dinâmica da eleição (Ferrara, 2015; Bessi e Ferrara, 2016; Badawy et al., 2018; Chang et al. Pessoas, 2021). Pesquisadores desenvolveram várias técnicas de detecção de bots sociais visando especificamente bots políticos com o objetivo de minimizar seu impacto no discurso público e nos processos democráticos (Gorwa et al., 2020; Howard e Kolanyi, 2016).

Bessi e Ferrara (2016) realizaram uma análise aprofundada das eleições presidenciais americanas de 2016 e constataram que os bots sociais foram responsáveis por gerar e disseminar grande parte do conteúdo eleitoral nas plataformas de mídia social, especialmente o Twitter . Eles observaram que os bots geraram cerca de um quinto de toda a conversa sobre eleições e tinham fortes tendências em relação a tópicos e candidatos políticos específicos. Usando algoritmos de aprendizado de máquina para identificar contas de bot com base em padrões de comportamento, Bessie e Ferrara conseguiram descobrir a presença generalizada de bots e seu potencial impacto nas eleições. Essas descobertas foram posteriormente vinculadas a uma operação patrocinada pelo Estado liderada pela Rússia para interferir nas eleições dos EUA (Badawy et al., 2018; Addawood et al., 2019; Luceri et al., 2019).

Reino Unido referendo Brexit 2016

Outro estudo de Howard e Kolanyi (2016) investigou o papel dos robôs sociais no referendo do Brexit de 2016 no Reino Unido. Eles descobriram que os bots contribuíram com uma parcela significativa do tráfego do Twitter relacionado ao referendo, com os bots pró-Brexit sendo mais ativos do que os bots Remain. Os pesquisadores empregaram técnicas de aprendizado de máquina supervisionadas para classificar contas de bot usando recursos como frequência de tweets, taxa de retuítes e similaridade de conteúdo. Suas descobertas destacam a influência potencial dos robôs sociais na formação da opinião pública durante grandes eventos políticos.

Referendo da Independência da Catalunha de 2017

Stella e outros (2018) propuseram um método para detectar bots sociais no contexto de discussões políticas no Twitter, com foco no referendo de independência da Catalunha de 2017. Eles usaram uma combinação de técnicas de aprendizado não supervisionado, como agrupamento e redução de dimensionalidade, para identificar grupos de usuários semelhantes e detectar bots com base em seus padrões comportamentais. Ao analisar o conteúdo produzido por esses bots, Stella et al. A capacidade de detectar campanhas de desinformação coordenadas e obter informações sobre as táticas empregadas pelos operadores de bot durante as eleições.

Em suma, os robôs sociais têm desempenhado um papel importante na manipulação da opinião pública e na interferência nas eleições em vários países. A pesquisa sobre detecção e compreensão do comportamento de bots políticos fornece informações valiosas sobre suas estratégias e seu impacto potencial no processo democrático. Ao desenvolver técnicas de detecção e contramedidas eficazes, o impacto dos bots sociais no discurso público pode ser mitigado e a integridade do processo eleitoral protegida.

5.2. Detecção de campanhas de desinformação por bots sociais

Espalhar desinformação e notícias falsas

A disseminação de desinformação e notícias falsas por meio de plataformas de mídia social tornou-se um grande problema, pois pode levar à desinformação, aumentar a polarização e reduzir a confiança na mídia e nas instituições. Os bots sociais podem exacerbar esse problema, espalhando rapidamente a desinformação e criando a aparência de apoio generalizado a uma narrativa específica (Ferrara, 2017; Shao et al., 2018). Detectar bots sociais envolvidos em campanhas de desinformação é fundamental para reduzir a disseminação de notícias falsas e manter a integridade das informações online.

Contas automatizadas espalhando conteúdo politicamente tendencioso

Analisamos o papel dos bots sociais na formação da opinião pública durante a eleição presidencial francesa (Ferrara, 2017). Nossa investigação sobre a disseminação de desinformação, especialmente no Twitter, encontrou uma presença significativa de contas automatizadas que espalham conteúdo com viés político. O estudo destaca o uso generalizado de bots sociais para promover narrativas distorcidas, manipular o discurso público e polarizar conversas online.

Amplifique o conteúdo de baixa credibilidade

Shao e outros (2018) realizaram um estudo sobre o papel dos bots sociais na disseminação de conteúdo de baixa credibilidade no Twitter durante e após a eleição presidencial de 2016 nos Estados Unidos. Eles descobriram que os bots sociais desempenham um papel importante na amplificação de conteúdo de baixa credibilidade, com alguns bots operando de maneira coordenada. Ao empregar técnicas de aprendizado de máquina, Shao et al. Somos capazes de detectar e caracterizar o comportamento de bots envolvidos na disseminação de desinformação, fornecendo informações valiosas sobre suas táticas e potencial impacto no discurso público.

Detectar notícias falsas e os bots sociais que as espalham

Em um estudo de Ruchansky e outros (2017), os autores propõem um modelo híbrido de deep learning chamado CSI (Capture, Score, and Integrate) para detectar notícias falsas e os bots sociais que fazem com que elas se espalhem. Ao explorar recursos de conteúdo e estrutura de rede social, seu modelo alcança alta precisão na detecção de notícias falsas e dos bots que as espalham, demonstrando o potencial das técnicas baseadas em IA para enfrentar o desafio da desinformação.

Atividade de bot social: informações falsas se espalham mais rápido e mais amplamente do que informações verdadeiras

Em seu estudo, Vosoughi e outros (2018) examinaram a disseminação de notícias reais e falsas online e descobriram que informações falsas se espalham mais rápido e amplamente do que informações reais, em parte devido à atividade de bots sociais. Eles usaram uma variedade de técnicas de aprendizado de máquina para simular a disseminação de notícias e identificar recursos que distinguem as informações verdadeiras das falsas. Suas descobertas destacam a necessidade de detecção efetiva de bots sociais e contramedidas para limitar a disseminação da desinformação.

Desenvolver tecnologia de detecção de bot social (para lidar com desinformação e notícias falsas)

Lidar com desinformação e notícias falsas requer uma abordagem multifacetada, incluindo o desenvolvimento de tecnologia de detecção de bot social que pode identificar e mitigar as atividades de bots envolvidos na disseminação de desinformação. Ao alavancar métodos avançados de aprendizado de máquina e processamento de linguagem natural, os pesquisadores podem entender melhor as estratégias e táticas empregadas por campanhas de desinformação e projetar intervenções para proteger a integridade das fontes de informação online.

5.3. Golpes financeiros e manipulação de criptomoedas

Investigue os detalhes técnicos de como os robôs sociais podem resolver esses problemas

A proliferação de bots sociais em plataformas de mídia social levou a um aumento de golpes financeiros e manipulação de criptomoedas. Nesta seção, nos aprofundamos nos detalhes técnicos de como os robôs sociais resolvem esses problemas, discutindo suas estratégias e possíveis métodos de detecção. Também nos referimos a artigos publicados relacionados para obter informações sobre esse problema crescente.

Os bots sociais podem ser programados para realizar vários golpes financeiros, como esquemas de bomba e despejo, phishing e disseminação de informações falsas para manipular preços de ações ou valores de criptomoedas. Esses bots geralmente imitam o comportamento humano e podem espalhar desinformação com velocidade alarmante, tornando-os particularmente eficazes em enganar usuários desavisados.

No espaço das criptomoedas, descobriu-se que os bots sociais manipulam os mercados influenciando o sentimento do público. Ao gerar uma enxurrada de notícias falsas promovendo certas criptomoedas ou espalhando informações falsas sobre as tendências do mercado, esses bots podem criar uma demanda artificial que aumenta o valor de uma criptomoeda visada. Uma vez que o valor atinge um limite predeterminado, o robô ou seu controlador pode vender suas participações, causando um rápido declínio no valor da criptomoeda e expondo outros investidores a perdas (Vasek e Moore, 2015).

Detectar bots sociais envolvidos em fraudes financeiras e manipulação de criptomoedas pode ser um desafio devido à sua capacidade de adaptar seu comportamento e fugir dos métodos tradicionais de detecção. No entanto, vários estudos propuseram técnicas inovadoras para resolver esse problema. Por exemplo, Nizzoli e colaboradores (2020) desenvolveram uma estrutura baseada em dados para identificar esquemas de pump and dump nos mercados de criptomoedas. Ao coletar e analisar milhões de mensagens de plataformas como Twitter, Telegram e Discord, seu modelo foi capaz de revelar dois mecanismos (esquemas de bomba e Ponzi) que lançam luz sobre o engano associado a suspeitas de contas de bot envolvidas na atividade de fraude de criptomoeda.

Outro estudo de Nghiem e outros (2018) propõe um método para detectar bots sociais relacionados a criptomoedas no Twitter. Os autores usam uma combinação de web analytics, análise de conteúdo e técnicas de aprendizado de máquina para identificar contas de bot que estão promovendo ou espalhando desinformação sobre criptomoedas. Essa abordagem multifacetada provou ser eficaz na detecção de bots envolvidos na manipulação de criptomoedas, mesmo na presença de táticas de evasão sofisticadas.

Para mitigar o impacto dos bots sociais em fraudes financeiras e manipulação de criptomoedas, é crucial que os pesquisadores desenvolvam novas técnicas de detecção para se adaptar às táticas em evolução empregadas por esses bots. Possíveis direções de pesquisa incluem a combinação de algoritmos de aprendizado profundo e aprendizado por reforço e o desenvolvimento de modelos que podem analisar fontes de dados multimodais, como texto, imagens e vídeos (Ferrara, 2022).

6. conclusões

Como os bots maliciosos continuam a impactar o ecossistema de informações online e causam grandes problemas em vários domínios, a detecção de bots sociais tornou-se uma área de pesquisa cada vez mais importante. Nesta seção final, revisamos os desafios e oportunidades na detecção de bots sociais, discutimos o futuro da detecção na era ChatGPT e propomos considerações finais e possíveis direções de pesquisa.

6.1. Recapitulação dos desafios e oportunidades na detecção de bots sociais

Neste artigo, exploramos vários desafios e oportunidades no campo da detecção de bots sociais e o impacto de chatbots avançados gerados por IA, como o ChatGPT, no campo. Ao longo da discussão, nos referimos a um grande número de artigos relevantes publicados, fornecendo uma perspectiva abrangente e tecnicamente detalhada sobre o tema.

Conteúdo gerado por IA cada vez mais complexo (ataques adversários e estratégias de evasão, soluções escaláveis e em tempo real, privacidade ética)

A detecção de bot social enfrenta vários desafios. Um grande desafio é a crescente complexidade do conteúdo gerado por IA, tornando mais difícil distinguir usuários humanos de bots sociais. Além disso, ataques adversários e táticas de evasão complicam ainda mais o processo de detecção à medida que os bots se tornam melhores em escapar dos métodos de detecção tradicionais. Dada a escala massiva e a natureza dinâmica das plataformas de mídia social, a necessidade de soluções de detecção escaláveis e em tempo real é outro desafio . Por fim, as considerações éticas e as preocupações com a privacidade associadas à detecção de bots sociais apresentam desafios únicos que precisam ser abordados para manter a confiança do público e aderir às estruturas legais e éticas.

Aprendizagem de transferência e aprendizagem não supervisionada, métodos de detecção multimodais, aprendizagem colaborativa e federada, inteligência artificial explicável

Apesar desses desafios, ainda há muitas oportunidades para melhorar as técnicas de detecção de bots sociais. O aprendizado por transferência e o aprendizado não supervisionado oferecem métodos promissores para explorar o conhecimento existente e descobrir padrões latentes no comportamento do robô. Os métodos de detecção multimodal podem aproveitar a integração de diferentes fontes de dados e recursos, levando a uma detecção mais robusta e precisa. O aprendizado colaborativo e federado para detecção ajuda a facilitar a cooperação entre diferentes organizações e plataformas e melhora a eficácia geral dos métodos de detecção. Por fim, incorporar IA explicável e explicabilidade em técnicas de detecção pode ajudar a criar confiança e fornecer informações valiosas sobre os processos de tomada de decisão subjacentes a esses modelos.

6.2. O futuro da detecção de bots sociais na era do ChatGPT

À medida que entramos na era do ChatGPT e de outros modelos avançados de linguagem, o futuro da detecção de bots sociais precisará acomodar a crescente complexidade do conteúdo gerado por IA. Pesquisadores e profissionais devem permanecer vigilantes diante do rápido desenvolvimento de chatbots gerados por IA que continuam a confundir a distinção entre conteúdo humano e gerado por máquina (Radford et al., 2019). Esta seção discute o futuro da detecção de bot social, com foco no impacto de chatbots avançados gerados por IA e possíveis caminhos para desenvolvimentos correspondentes em métodos de detecção.

Para neutralizar efetivamente os recursos aprimorados dos chatbots gerados por IA, os pesquisadores devem explorar novos métodos e caminhos que complementem as tecnologias existentes. Uma direção potencial é desenvolver modelos de aprendizado de máquina mais sofisticados que possam explicar as sutilezas e nuances do conteúdo gerado por chatbots avançados como o ChatGPT. Esses modelos devem ser capazes de reconhecer não apenas recursos linguísticos, mas também aspectos contextuais e comportamentais relevantes para o conteúdo gerado por bots.

Aprendizagem por transferência e treinamento adversário (Goodfellow et al., 2014) oferecem caminhos promissores para melhorar a robustez e a generalização dos modelos de detecção de bots sociais. O aprendizado de transferência pode ajudar a alavancar modelos pré-treinados e conhecimento de outros domínios para aprimorar a detecção de robôs. Por outro lado, o treinamento adversário pode introduzir exemplos adversários durante o treinamento do modelo , melhorando assim a adaptabilidade do modelo às técnicas de evasão usadas pelos robôs.

A incorporação de informações contextuais e multimodais nos métodos de detecção é outra maneira potencial de aprimorar os recursos das técnicas de detecção robótica. Ao analisar não apenas o conteúdo de texto, mas também imagens, vídeos e outros tipos de mídia, e levando em consideração o comportamento do usuário e a estrutura da rede, os pesquisadores podem desenvolver modelos de detecção mais abrangentes e poderosos que respondem por uma gama mais ampla de características e comportamentos de bots.

À medida que os chatbots gerados por IA continuam a evoluir, é fundamental considerar as implicações éticas da detecção de bots sociais. É necessário desenvolver diretrizes e políticas que abordem as dimensões ética, legal e social da questão para garantir que os métodos de detecção respeitem a privacidade do usuário e cumpram as estruturas legais.

Concluindo, o futuro da detecção de bots sociais na era do ChatGPT e outros modelos avançados de linguagem exigirá técnicas inovadoras que possam se adaptar ao cenário em rápida mudança do conteúdo gerado por IA. Ao explorar novas metodologias e abordagens, promover colaborações interdisciplinares e abordar a detecção de robôs sociais na era ChatGPT: desafios e oportunidades, implicações éticas da detecção, os pesquisadores podem contribuir para um ambiente online mais seguro e confiável.

6.3. Considerações finais e possíveis direções de pesquisa

Neste artigo, exploramos os desafios e as oportunidades na detecção de bots sociais, com foco no impacto de chatbots avançados gerados por IA, como o ChatGPT. Na seção final, delineamos possíveis direções de pesquisa que podem ajudar a avançar no campo da detecção de robôs sociais e contribuir para o desenvolvimento de técnicas de detecção mais eficientes e confiáveis.

Colaboração humano-robô: À medida que os chatbots gerados por IA se tornam mais sofisticados, é necessário considerar o potencial da colaboração humano-robô na detecção de bots sociais. A experiência no assunto pode ajudar a orientar e refinar os modelos de detecção, enquanto a inteligência artificial pode fornecer o poder de computação necessário para analisar grandes quantidades de dados. A investigação de novos paradigmas de colaboração humano-IA , como aprendizado ativo e sistemas ativos híbridos, pode gerar informações valiosas e melhorar o desempenho da detecção de bots sociais.

Detecção entre plataformas: a maioria dos estudos sobre detecção de bots sociais se concentra em plataformas específicas, como Twitter ou Facebook. No entanto, à medida que novas plataformas de mídia social continuam a surgir, é fundamental desenvolver ensaios que possam ser generalizados entre as plataformas. Isso envolverá a criação de conjuntos de dados multiplataforma e o desenvolvimento de modelos que possam levar em consideração a funcionalidade específica da plataforma e o comportamento do usuário.

Dinâmica temporal de robôs: muitos métodos de detecção existentes são estáticos, concentrando-se em um único instantâneo do comportamento do robô. No entanto, os robôs podem mudar seu comportamento ao longo do tempo, seja como parte de sua estratégia ou em resposta a esforços de detecção (Luceri et al., 2019; Luceri et al., 2020). Pesquisas futuras devem explorar a dinâmica temporal dos robôs sociais, incorporando análise de séries temporais e outras técnicas para rastrear e detectar mudanças nos comportamentos dos robôs (Pozzana e Ferrara, 2020).

Raciocínio contrafactual: à medida que os chatbots gerados por IA melhoram, eles podem gerar conteúdo que imita de perto o comportamento humano. Nesses casos, pode ser útil explorar o raciocínio contrafactual como meio de detectar bots. Ao considerar o que um robô faria em cada situação em comparação com um usuário humano, os pesquisadores podem desenvolver técnicas de detecção novas e mais eficazes.

Ambientes com poucos recursos: Pesquise e desenvolva novas tecnologias para detecção de robôs sociais em idiomas com poucos recursos e use aprendizado de transferência entre idiomas, aprendizado não supervisionado e métodos de aprimoramento de dados para melhorar os recursos de detecção, que podem oferecer suporte a comunidades sub-representadas contra robôs sociais mal-intencionados.