1. O primeiro entendimento

A entropia relativa (entropia relativa) também é conhecida como divergência KL (divergência Kullback-Leibler, KLD, abreviação), divergência de informação (divergência de informação) e ganho de informação (ganho de informação).

A divergência KL é uma medida da assimetria da diferença entre as duas distribuições de probabilidade P e Q.

A divergência de KL é usada para medir o número médio de bits extras necessários para codificar amostras de P usando codificação baseada em Q. Normalmente, P representa a verdadeira distribuição dos dados e Q representa a distribuição teórica dos dados, a distribuição do modelo ou a distribuição aproximada de P.

De acordo com a teoria da informação de Shannon, dada a distribuição de probabilidade de um conjunto de caracteres, podemos projetar uma codificação que minimize o número médio de bits necessários para representar a cadeia de caracteres do conjunto de caracteres. Supondo que esse conjunto de caracteres seja X, para x ∈ X, sua probabilidade de ocorrência é P (x), o número médio de bits necessário para sua codificação ideal é igual à entropia desse conjunto de caracteres: H (X) = ∑x∈XP (x) log [1 / P (x)]

No mesmo conjunto de caracteres, suponha que haja outra distribuição de probabilidade Q (X). Se a codificação ideal da distribuição de probabilidade P (X) (ou seja, o comprimento de codificação do caractere x for igual ao log [1 / P (x)]) para codificar os caracteres que estão em conformidade com a distribuição Q (X), esses caracteres serão Idealmente, use mais bits. A divergência de KL é usada para medir o número médio de bits por caractere neste caso, portanto, pode ser usada para medir a distância entre as duas distribuições. Isto é:

DKL (Q || P) = ∑x∈XQ (x) [log (1 / P (x))] - ∑x∈XQ (x) [log [1 / Q (x)]] = ∑x∈XQ (x) log [Q (x) / P (x)] Como -log (u) é uma função convexa, existem as seguintes desigualdades

DKL (Q || P) = -∑x∈XQ (x) log [P (x) / Q (x)] = E [-logP (x) / Q (x)] ≥ -logE [P (x) / Q (x)] = - log∑x∈XQ (x) P (x) / Q (x) = 0

Ou seja, a divergência KL é sempre maior ou igual a 0. A divergência de KL é igual a 0 se e somente se as duas distribuições forem iguais.

===========================

Vamos dar um exemplo prático: por exemplo, existem quatro categorias e a probabilidade de um método A obter quatro categorias é 0,1, 0,2, 0,3, 0,4. Outro método B (ou situação factual) é obter a probabilidade das quatro categorias serem 0,4, 0,3, 0,2, 0,1 e, em seguida, as duas distribuições

Distância KL (A, B) = 0,1 * log (0,1 / 0,4) + 0,2 * log (0,2 / 0,3) + 0,3 * log (0,3 / 0,2) + 0,4 * log (0,4 / 0,1) Há um positivo nisso, Se for negativo, pode-se provar que KL-Distance ()> = 0.

Como pode ser visto acima, a divergência de KL é assimétrica. Ou seja, KL-Distância (A, B)! = KL-Distância (B, A)

A divergência KL é assimétrica.Claro, se você deseja torná-la simétrica, Ds (p1, p2) = [D (p1, p2) + D (p2, p1)] / 2.

Segundo, o segundo entendimento

Falando em entropia relativa hoje, sabemos que a entropia da informação reflete o grau de ordenação de um sistema.Quanto mais ordenado é o sistema, menor é a entropia da informação e vice-versa. A seguir está a definição de entropia

Se o valor possível de uma variável aleatória X for a probabilidade correspondente

, a entropia da variável aleatória X será definida como

Com a definição de entropia de informações, vamos começar a aprender entropia relativa.

1. Compreensão da entropia relativa A entropia relativa também é chamada entropia mútua, entropia cruzada, informações de identificação, entropia Kullback, divergência Kullback-Leible (isto é, divergência KL), etc. Seja p (x) e q (x) as duas distribuições de probabilidade de probabilidade do valor de X, então a entropia relativa de p a q é

Até certo ponto, a entropia pode medir a distância entre duas variáveis aleatórias. A divergência KL é uma medida da assimetria da diferença entre as duas distribuições de probabilidade P e Q. A divergência de KL é usada para medir o número médio de bits extras necessários para codificar amostras de P usando codificação baseada em Q. Normalmente, P representa a verdadeira distribuição dos dados, Q representa a distribuição teórica dos dados, a distribuição do modelo ou a distribuição aproximada de P.

2. Propriedades da entropia relativa A entropia relativa (divergência KL) tem duas propriedades principais. Como segue

(1) Embora a divergência KL seja intuitivamente uma função de métrica ou distância, não é uma métrica ou distância real porque não possui simetria, ou seja,

(2) O valor da entropia relativa é não negativo, ou seja,

Antes de provar, precisamos reconhecer uma importante desigualdade chamada desigualdade de Gibbs. O conteúdo é o seguinte

3. Aplicação de entropia relativa A entropia relativa pode medir a distância entre duas distribuições aleatórias.Quando as duas distribuições aleatórias são iguais, sua entropia relativa é zero e, quando a diferença entre as duas distribuições aleatórias aumenta, sua entropia relativa também é Aumentará. Portanto, a entropia relativa (divergência KL) pode ser usada para comparar a semelhança de textos, primeiro conte a frequência das palavras e depois calcule a divergência KL. Além disso, na avaliação de sistemas com vários índices, a alocação do peso do índice é um ponto importante e difícil, que pode ser tratado através da entropia relativa.

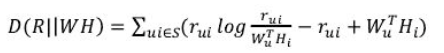

3. Usado em CF

Primeiro, o KLD requer probabilidade (bochecha e 1), mas as pontuações são usadas.

Segundo, o papel dos dois últimos.

De: http://www.cnblogs.com/hxsyl/p/4910218.html