Ao contrário do DP, não precisamos conhecer completamente o modelo do ambiente, pois o MC precisa apenas de experiência, que são os dados simulados. O método de Monte Carlo é encontrar o retorno médio de todos os episódios, portanto é um cenário episódio por episódio.

1.Monte Carlo Prediction

A avaliação da política do método Monte Carlo da primeira visita é calcular a média dos retornos acumulados após o primeiro estado observado por incontáveis episódios até convergir para o valor desejado.

O diagrama de backup do DP mostra todos os possíveis estados sucessores, e o MC possui apenas o episódio amostrado; o DP inclui apenas uma transferência em uma etapa e o MC vai até o final do episódio. Simplificando, a estimativa do DP do valor atual da função de estado deve ser baseada no valor subseqüente do estado, e cada estado do MC é independente um do outro ------- DP requer bootstrap, mas o MC não.

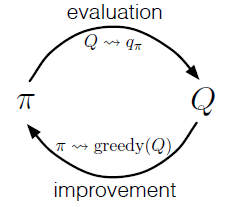

2.Monte Carlo Control

Aqui temos duas suposições: uma é o início exploratório do episódio, mas isso pode ser feito por meio de episódios intermináveis e avaliação de políticas. Para a segunda suposição, existem duas soluções.

1. Supondo que teta, quando for  menor que teta, podemos garantir a convergência; 2. Em vez de esperar pela conclusão da avaliação da política e depois atualizar, mas usando o método iteraion de valor, a cada iteração, ele é atualizado uma vez.

menor que teta, podemos garantir a convergência; 2. Em vez de esperar pela conclusão da avaliação da política e depois atualizar, mas usando o método iteraion de valor, a cada iteração, ele é atualizado uma vez.

Como o método MC não pode esperar até o final do episódio para realizar a avaliação e o aprimoramento da política; mas, em alguns cenários, um episódio levará muito tempo ou não será encerrado, portanto, isso também é uma desvantagem do MC. Além disso, como o MC calcula a média dos retornos das amostras para os episódios, isso fará com que algumas das cenas que ocorreram sejam usadas diretamente em outros lugares, e a aplicabilidade não seja forte.

3. Remova os Exploradores Iniciados

Esta é uma explicação para outra hipótese em 2. Quando não há Iniciação Exploradora no sistema, algumas ações podem não ser selecionadas, portanto ocorrerá um erro ao avaliar Q (s, a ).

A solução é usar a política epsilon-gananciosa.Neste caso, mesmo se não houver Exploração inicial, haverá uma probabilidade de que o epsilon possa escolher outras ações, o que pode resolver a ação que sempre escolhe o máximo de Q (s, a) Ótimo) problema.

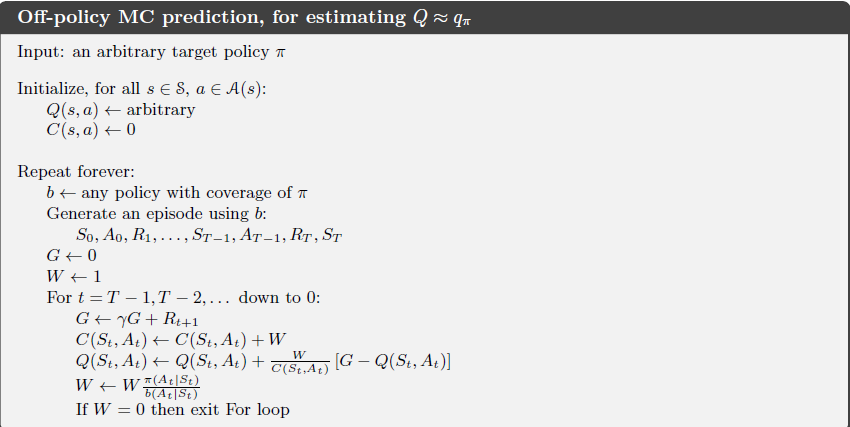

4. Previsão fora da política via amostragem de importância

A política introduzida anteriormente, porque a maior parte das políticas que obtém finalmente é a política gananciosa, que ainda não é a melhor política gananciosa. Se queremos obter a melhor política gananciosa, precisamos de algo fora da política. O uso de fora da política exige que avaliação e aprimoramento não sejam a mesma política; portanto, você deve usar a amostragem de importação para converter os dados amostrados na política de avaliação em dados da política de melhoria. Em termos simples, são necessárias duas políticas, uma é a política de destino (aprender) e a outra é a política de comportamento (dados).

4.1 amostragem por improtância ponderada sam amostragem comum

Existem dois tipos de amostragem de importação aqui, uma é a amostragem comum e a outra é a amostragem por improtância ponderada.

A diferença é: ponderado é tendencioso e baixa variância; ordinário é imparcial e alta variância. Na prática, prefiro usar o método ponderado.

5. controle de MC fora da política

Em geral, os dados da política de comportamento são usados para obter a política ideal π de acordo com Q (s, a) usando ganancioso. Deve-se notar aqui que a política de b deve conter π, ou seja, a ação selecionada em π, b também pode ser selecionada.

6. Resumo

1. As 3 vantagens do MC para DP

(1) Não é necessário modelo de ambiente

(2) modelo de simulação ou amostra pode ser usado

(3) Para parte dos dados, podemos analisar apenas a parte útil dos dados e usar o método MC, que é muito eficiente.

2. Problemas com MC

Como é necessário iniciar a exploração, quando essa suposição for removida, é provável que apenas as ações atualmente amostradas sejam selecionadas e, em seguida, ações melhores nunca sejam selecionadas. Portanto, a política ideal obtida pelo MC dentro da política é a política epsilon-gananciosa.