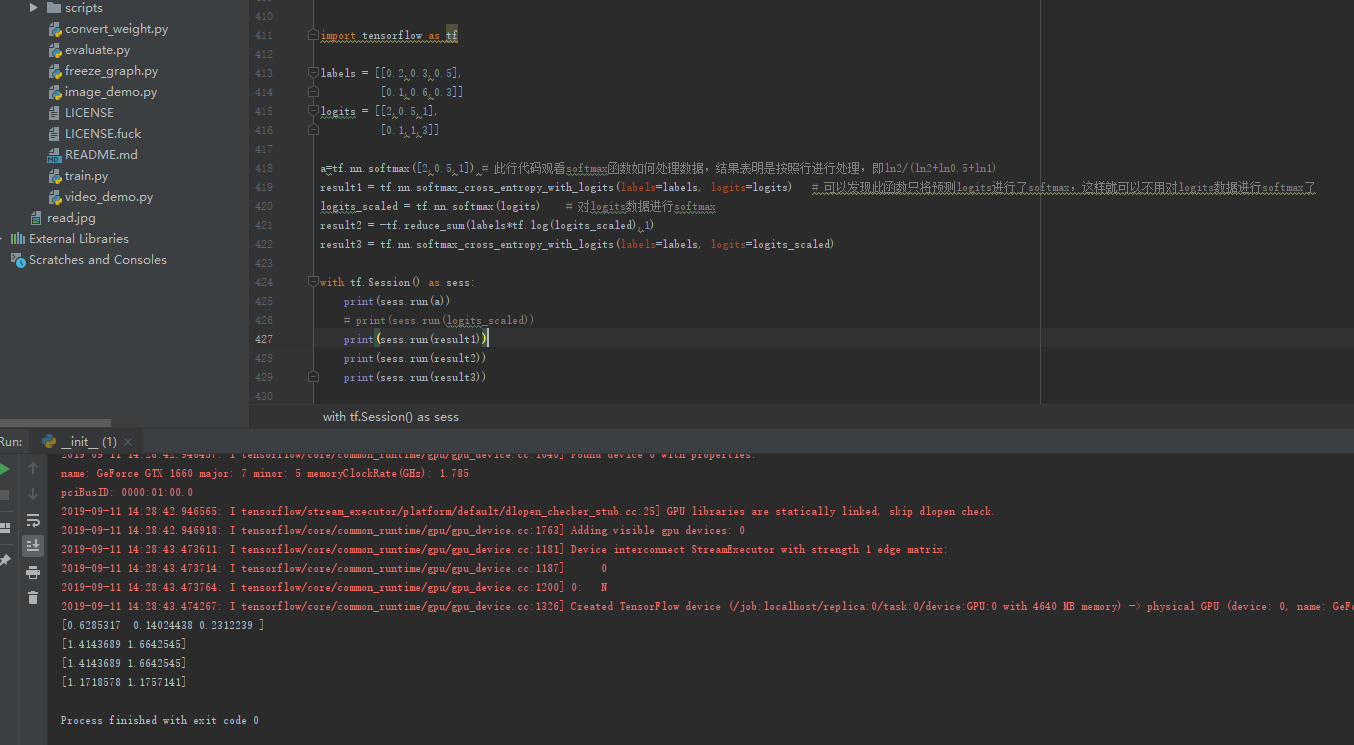

インポートAS tensorflowのTF

ラベル= [0.2,0.3,0.5]、

[0.1,0.6,0.3]

logits = [2,0.5,1]、

[0.1,1,3]

A = tf.nn.softmax( [2,0.5,1])#このラインソフトマックス関数処理データ、すなわち、LN2 /(+ LN2 + ln0.5 LN1)、これはラインに従って処理されていることを示す方法を参照

結果1 = tf.nn.softmax_cross_entropy_with_logits(=ラベルラベル、logits = logits)この関数は唯一あなたがソフトマックスデータをlogitsするために行うことができるようにlogitsは、ソフトマックスた予測見つけることができます。#

logits_scaled = tf.nn.softmax(logits)logitsデータの#ソフトマックス

結果2 = -tf.reduce_sum (ラベル* tf.log(logits_scaled),. 1)

result3 = tf.nn.softmax_cross_entropy_with_logits(=ラベルをラベル、logits = logits_scaled)

tf.Sessionと()sess。viのAS:

印刷(sess.run(A))

#印刷(セッション数.RUN(logits_scaled))

を印刷(sess.run(結果1))

印刷(sess.run(結果2))

プリント(sess.run(result3))

ソフトマックス関数は、実際には以下の通りであるコード/Σnp.power(np.e、XI)が得られた式np.power(np.e、XI)に入力されます。

[2,0.5,1]

= np.power(np.e、2)+ np.power(np.e、0.5)+ np.power(np.e、1)

プリント(np.power(np.e、2)/ A)