内蔵ハイブ

- 必要なコア-site.xmlのHDFS-site.xmlの火花confディレクトリにコピーします。あなたがスパーク・パスの下metastore_dbを見つけた場合は、[、あなたは削除する必要があるときのみ、最初の開始 ]。

- あなたが最初のメタストアを作成するために起動すると、次のように指定する必要がspark.sql.warehouse.dir、このパラメータを

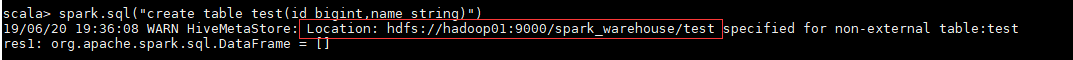

spark-shell --master spark://hadoop01:7077 --conf spark.sql.warehouse.dir=hdfs://hadoop01:9000/spark_warehouse

ただ、テーブルを作成します

scala> spark.sql("create table test(id bigint,name string)")

あなたが見ることができるときに、Hadoopクラスタを結果は以下のとおりであるところ、この表

外部Hive

- ハイブ-site.xmlのは、スパークconfディレクトリにコピーする必要があります。

- metestoreのハイブは、MySQLデータベースを使用する場合は、スパークの瓶の下のディレクトリにMySQLのJDBCドライバパッケージが必要になります。

- SQLクエリは、火花SQLまたは火花シェルによって行うことができます。完全かつハイブ接続。