ディシジョン・ツリー・アルゴリズム

分類と回帰ツリー(CART、分類および回帰ツリー)

ID3アルゴリズム

C4.5アルゴリズム

。カイ二乗自動相互作用検出器( CHAID) スパニングツリーによって多層分割[7]。

MARS:より良いハンドリングの数値データ。

ラベルのサンプルを予測する予測モデルとして決定木。このツリーは、分類木や回帰木として知られています。

データは、以下のように表されます。

前記Yは、目標値ベクトルであり、xがこれらの特性から成る、X 1、X 2、X 3 目標値を得るために、等が挙げられます。

1、「機械学習」ズハウ・ジワからの画像は、第4章

情報エントロピーの分割に基づいて決定木、ブックの分割の原理である:情報は、選択後の最大属性の分割分割を得、情報ゲインの算出は、以下のように記述することができます。

$ D - \ sum_ {i = 1} ^ jD_i * \ FRAC {C_I} {C} $

このうち、情報エントロピー小さく、より良い、より良い情報は大きなを獲得。情報利得式はDDは、同じサンプルと同じで、誘導されたので、$することができる- \ sum_ {i = 1 } ^ jD_i * \ FRAC {C_I} {C} $ 小さく、よりよい結果。だから私は$最小化することにより、怠惰を盗んだ- \ sum_ {Iを= 1 } ^ jD_i * \ FRAC {C_I} {C} $ 情報利得を最大化する効果を達成するために。ここで、現在の属性によるとディディ分割を表し、クラスII、II遊泳の情報エントロピーは、クラスのサンプル数を表し、CCは、サンプルの総数を表します。例えば、データセットは、この属性の分割結果スイカ「パターン」に基づいて算出される必要がある、「パターン」属性透明でわずかに、情報ゲインは3つのサブカテゴリー分割前の分割を差し引いた後にエントロピー三のファジーカテゴリを貼り付け加重平均エントロピー。

後方分岐、正および負のサンプルおよび百分率比の加重和を割ること:計算エントロピーは次のように記述することができます。

$ - \ sum_ {i = 1} ^ jはP_I * log_2p_i $

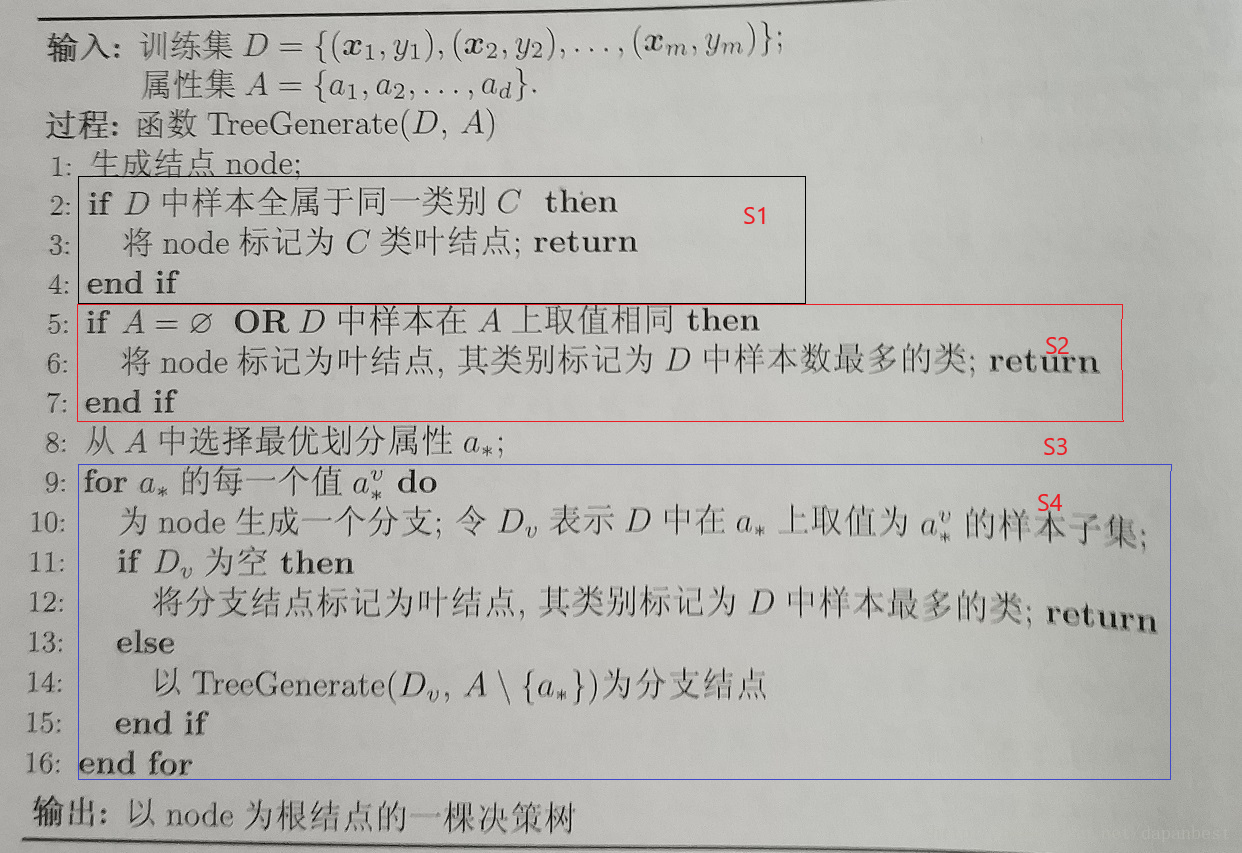

アルゴリズムのコアプロセス:

S1は、この場合には、同じタイプのすべてのノードが

すべてのノードS2]の同じ属性

S3]が最適なパーティションプロパティ見つけるため

S4]を再帰的にサブツリーを作成します

参考文献: