1.ゴシップ

毎晩寝る前に、私は日中に起こったすべてが偽物であり、過ぎ去ったと自分自身に確信させました。毎朝目を覚ますのと同じように、昨夜起こったこともすべて偽物だと感じずにはいられません。実際、よく考えてみると、現実の世界で夢に入ることができるものは非常に限られています。同様に、夢の中のものが現実の世界に流れ込むことができるのは非常に限られています。次に、入口と出口にフィルターに似たものがあり、ほとんどのものをブロックしているはずです。夜は砂の山のように横になり、朝日が差し込むと凝縮して大人っぽく動き回った。ここで表現したいのは、この世界が幻想であると言うのではなく、非常に現実的であると言うことです。現実の世界はカラフルで、あらゆる種類の魔法のような美しいものでいっぱいです。ルールはルールより下のものに適用され、より高いルールはより高いものに適用されます。ランダムな考えで空を壊したくても、この世界の本来のスタイルよりも豊かになることはありません。

2.言語モデル

言語モデルを理解する方法は、人間が情報をエンコードおよびデコードする方法と同じです。人間の脳には、たくさんの言葉に加えて、スタイル、気質、口調などもあります。注意深く考えると、私たちの表現はエッセイの質問のようなものではなく、複数の選択肢の質問のようなものであることがわかります。私たちの記憶にあるさまざまな言語モデルから、私たちが最も良いと思うものを選択します。このようにして、語彙を組み合わせてエンコードし、独自の意見を出力します。私たちの考え方や行動など、自由で恣意的と思われる多くのことは、本質的に選択のプロセスです。これらの中から選択できるモデルは他にもあるかもしれませんが、制限もあります。人がナンセンスを話しているとしても、あるモデルによれば、彼はナンセンスを話しているに違いありません。これらのモデルの存在は、人々の間の情報のエンコードとデコードを実現します。モデルとシンボルの有限性は、人間の有限性も決定します。ニューラルネットワークの言語モデルは、コンテキストを使用して現在の単語を予測し、単語の組み合わせをより詳しく説明しています。

3.N-gram

N-gramは統計言語モデルであり、将来のイベントは限られた履歴にのみ依存するというマルコフの仮説に基づいています。この仮定は簡単に理解できます。たとえば、今日の午後はお腹が空いています。昼食や朝食に何を食べるかによって異なります。うまくいかない場合は、昨日の夕食に何を食べたかに基づいていますが、人間の消化器系の場合です。言う、それは私が去年またはそれ以前に何を食べたかに依存しないでしょう。これは単なる仮説であり、この時間制限のためにすべてのイベントが発生するかどうかはわかりません。少なくともほとんどの場合はこのように思われます。せいぜい、限られた時間の問題です。したがって、この仮定は使用可能であるはずです。

マルコフモデルを言語モデルに適用すると、各単語の外観は、その前の限られた数の単語に依存します。たとえば、この有名なことわざ:「生存か死か、これは考える価値のある質問です。」有限の単語の数を2と仮定すると、「死」という単語は「生存」と「または」に依存します。この有限の数の場合単語数nの異なる定義は、異なるグラムモデルを構成します。たとえば、nが1の場合、ユニグラム、2はバイグラム、3はトリグラムです。

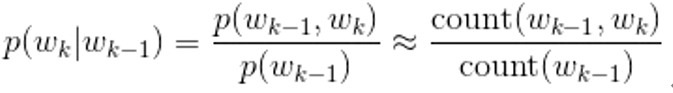

では、上記のアイデアをどのように実装し、言語モデルに適用するのでしょうか。ベイズの公式を使用します。以下の公式の前半はベイズの公式です。ベイズについて詳しく知りたくない場合は、ここをクリックしてください。簡単な答えは、Aの条件下でBが出現する確率= AB / Aの共同確率です。出現の確率。ベイジアンの公式の後にカウント統計が続くことがわかります。つまり、数値が大きい場合、確率はそれらが出現する回数の比率に非常に近いことを意味します。

上記の式に基づいて、N-gramを展開します。次の式は、文全体の確率が文の各単語の確率の積に等しく、文の単語の確率が最初のNの単語に等しいことを説明しています。単語条件の下での確率。Nが1の場合、各単語は独立していることと同等であり、直接確率が乗算されます。これは、最大の可能性を使用することと同等です。Nが2の場合、文全体の確率は、前の単語の条件下で各単語と同等です。の確率を掛けると、同じことが逆になります。

バイナリモデルの確率分布表の例を次に示します。各単語と別の単語の確率を取得できます。確率は、これら2つの単語の組み合わせの出現回数を、すべてのペアワイズ単語の組み合わせの出現回数で割ったものです。一般的には、三元モデルの方が多く使用されますが、双対性が使用できる場合は、三元を使用しないでください。

関連する質問:

1. OOVの問題、つまり、以前になかった単語の場合。この場合、この単語の確率は0になり、文全体の確率は0になります。処理方法はしきい値を設定することで、特定のしきい値を超えるオカレンスのみが語彙に含まれ、UNKの代わりに他の特殊文字が使用されます。これは、しきい値が小さすぎて合計確率の計算に参加しない文字に相当します。

2.スムージング:組み合わせがコーパスにない場合、カウントは0であり、計算された確率もこの時点でゼロです。この場合、各数値に1を加算して、平滑化プロセスを実行します。

2.識別可能性と信頼性:Nが大きすぎると、現在の単語に対する制約が強すぎて、簡単にオーバーフィットになります。そうすると、識別性が高くなり、それに応じて信頼性が低下します。人と言えば、機能が多すぎるトレーニングセットの方が正確ですが、簡単にオーバーフィットします。

評価:

利点:限られた数の単語に基づいているため、効率的です。

短所:以前の情報を関連付けることができず、類似性を反映できず、確率が0である状況が発生する可能性があります。

概要:n-gramは、マルコフ仮説に基づいており、統計を使用してテキスト内の単語の分布を表現するモデルです。テキスト全体の分布確率は、各単語の条件付き確率の乗算で表すことができます。利点は、限られた履歴に基づいて効率的であるということです。欠点は、テキストの類似性を反映できず、以前の情報を関連付けることができないということです。

4.N-gramニューラルネットワーク言語モデル

N-gramニューラルネットワーク言語モデルは、N-gramのアイデアをニューラルネットワークと組み合わせ、コンテキスト情報に基づいて現在の単語を予測するネットワークモデルです。前述の統計ベースのNグラムにはいくつかの欠点があり、機械学習のカテゴリに属します。では、深層学習に基づくニューラルネットワークはどのように見えるでしょうか?

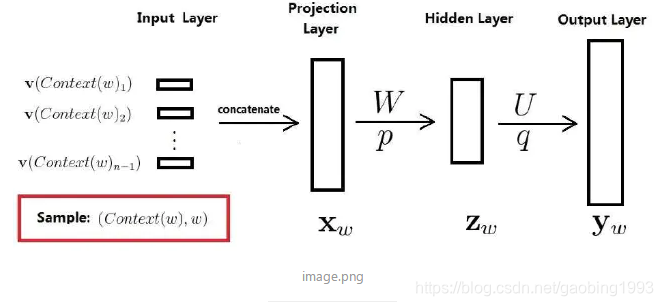

次のネットワーク図をご覧ください。簡単に言えば、コンテキスト情報をモデルに入力して、語彙の各単語の確率を予測します。最も高い確率は、予測値です。これは非常に単純な4層のニューラルネットワークです。いくつかの重要なポイントを理解しましょう。まず、コンテキスト内の各単語がワンホットエンコードされ、次に対応する単語の単語ベクトルが単語ベクトルテーブルから検出され(単語ベクトルテーブルもトレーニングによって取得されます)、投影レイヤーを使用してすべてのコンテキストベクトルが接続されます。次に、隠れ層を介して、tanh非線形アクティベーションが使用され、最終出力はsoftmaxマルチ分類です。

訓練されたモデルができることは、文脈が与えられれば、現在の単語が何であるかを予測することです。次に、モデルの副産物である単語ベクトルテーブルを取得します。各パラメーターの説明:入力レイヤーVの数(context(W))は、コンテキスト内の単語の数と一致します。単語ベクトルテーブルの形状は(単語リスト内の単語の数*単語ベクトルの長さ)です。

概要:上記では、主にN-gramの概念をニューラルネットワークアーキテクチャに適用するためのN-gramニューラルネットワーク言語モデルを紹介しました。これは、上記の統計言語モデルとは異なります。このモデルは、単語ベクトルに基づいて単語間の類似性を計算できます。

5.まとめ

この記事では、N-gramとニューラルネットワーク言語モデルのアイデアについて説明します。マルコフ仮説に基づく言語モデルです。これは、テキスト内の暗黙の単語間の関係を抽出するために使用でき、予測された単語は、指定されたコンテキストを通じて提供されます。それは他の人の言葉を拾うのが大好きな子供のようなものです。

絶望的な未来は私が期待するものではありません。嵐の前に、私は保護のために傘を必要としません。私は継続的な努力を通して自分自身を家族のための傘にしなければなりません。私は若いので失うものは何もありませんでした。また、若いので、恐怖という言葉について話す資格がないと自分に言い聞かせました。誇らしげな花は、風雨から身を守るために花の骨に永遠に隠れたくないので、太陽を見るために、冷酷な風雨に押しつぶされてほこりを作ることをずっと恐れていました。花はしばらく咲き、人々は永遠に生き、障害を乗り越え、風に逆らって飛んでいきます。次の時代を超越したクラシック-ブルーバードをお楽しみください。

【ナルト】ブルーバード-ライブシンギング