1. Abra la página Web https://tophub.today/

2. Presione Ctrl + T para abrir la fuente de la página

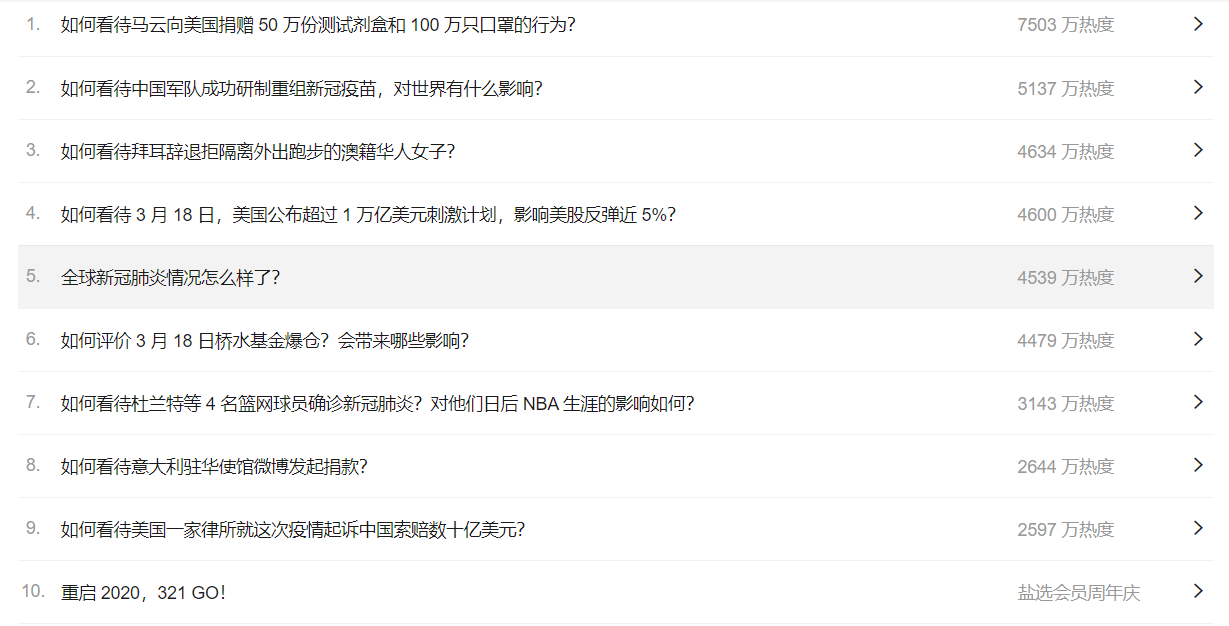

3. Localizar los datos que desea rastrear

4.

Importación Pide importación PANDAS como Pd de BS4 importación BeautifulSoup de PANDAS importación trama de datos LST = [] # crear una lista vacía url = ' https://tophub.today/ ' # URL de las páginas rastreadas DEF GET (url): el intento : cabeceras = { ' el Agente User-- ' : ' la Mozilla / 5.0 (Windows NT 10,0; Win64; x64-) AppleWebKit / 537.36 (KHTML, como el Gecko) la Chrome / 80.0.3987.122 Safari / 537.36 ' } # disfraz reptiles = Requests.get URL (URL, tiempo de espera = 30, cabeceras = cabeceras) # solicitud de transmisión url.raise_for_status () url.encoding = ' UTF-8. ' Retorno url.text la excepción : el retorno " anormal " # Crear una ubicación de datos carpeta de DEF Crear (LST, HTML, NUM): sopa = la BeautifulSoup (HTML, ' html.parser ' ) A = soup.find_all ( ' período ' , el class_ = ' T ' ) B = soup.find_all ( 'lapso 'el class_ = ' E ' ) Imprimir ( ' {:} 10 ^ \ t {:} 30 ^ \ t {:} ^ 10 ' .formato ( ' Rango ' ' Título ' ' calor ' )) para que en Rango (NUM): Imprimir ( ' {:} 10 ^ \ T {:} 30 ^ \ T {:} ^ 10 ' . .formato (I + 1, a [I + 50] .string, B [I + 50 ] .string)) # imprimir el contenido de rastreo lst.append ([I +. 1, un [I + 50] .string, B [I + 50] .string]) # los datos que se arrastran en la lista = HTML GET (url) Crear (LST, HTML,10 ) DF = pd.DataFrame (LST, Columnas = [ ' rango ' , ' Título ' , ' calor ' ]) ZHHot = ' E: \ Nueva carpeta \ sabe calientes datos de graduación de la búsqueda casi diez .xlsx ' df.to_excel (ZHHot)

El rastreo de datos