Einführung

Gängige Methoden des verstärkenden Lernens basieren auf Wertfunktionen oder auf Richtliniengradienten.

Wertfunktion: Wird erhalten, wenn die Wertfunktion optimal istDie optimale Strategie, das heißt unter Zustand s, Die Aktion, die der maximalen Verhaltenswertfunktion maxQ(s,a) entspricht.

Für den kontinuierlichen Aktionsraum des Roboters treten jedoch bei kontinuierlichen Aktionen basierend auf der Wertfunktion die folgenden Probleme auf:

- Wenn der Aktionsraum groß ist oder die Aktionen kontinuierliche Mengen sind, kann die auf Wertfunktionen basierende Methode das Problem nicht effektiv lösen.

- Beim Verbessern der Strategie basierend auf der Wertfunktion ist es notwendig, die Verhaltenswertfunktion für jedes Zustandsverhalten zu erhalten, um die optimale Aktion zu erhalten

. In diesem Fall jedes Zustandsverhalten ist völlig unabhängig und es ist unrealistisch, das Verhalten zu bestimmen, das in einem bestimmten Zustand ausgeführt werden sollte.

Zusammenfassung: Die Verwendung der Wertfunktion Q zur Lösung kontinuierlicher räumlicher Aktionen kann ebenfalls verwendet werden, ist aber nicht einfach zu verwenden, daher erschien die Richtliniengradientenmethode.

1. Politikgradient

Stochastischer Richtliniengradient: Mit direkter Näherung

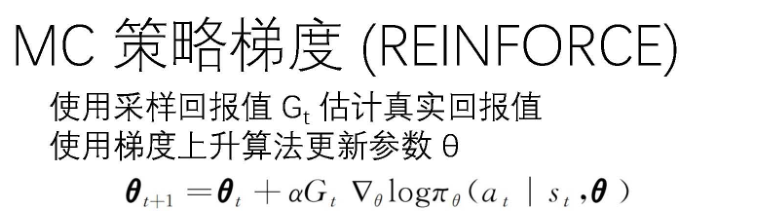

müssen wir die momentanen neuronalen Netzwerkparameter θ ermitteln . Um θ zu lösen, müssen Sie eine Zielfunktion J(θ)=G(θ) (kumulativer Rückgabewert) entwerfen. Die θ-Aktualisierungsformel lautet:

![]()

Diese Methode aktualisiert die Richtlinienparameter basierend auf dem Gradienten der Zielfunktion J(θ).

J(θ) Division 两种:

1. In MC gibt es eine abgeschlossene Kette:

2. In TD, wenn es eine Schrittgrößenbeschränkung gibt:

In der Formel ist ![]() die Verteilung der auf der Grundlage der Strategie generierten Zustände

die Verteilung der auf der Grundlage der Strategie generierten Zustände![]()

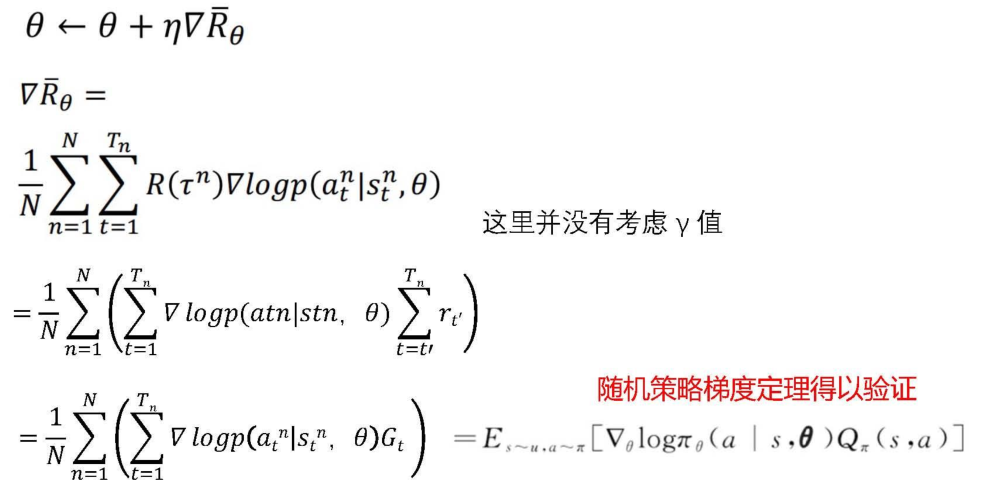

Weiter erhalten wir den Ausdruck des Gradienten:

2.Schauspieler

Der politische Gradient ist das A in AC

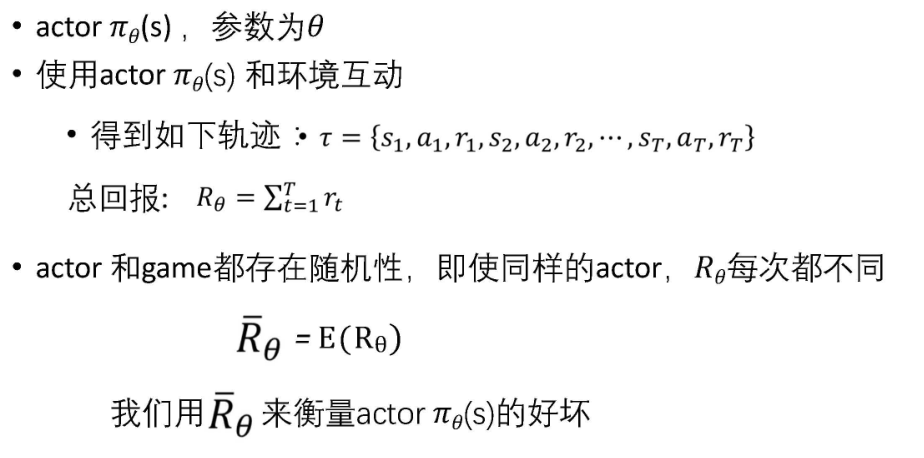

Akteur: Wie Sie der folgenden Abbildung entnehmen können, gibt er das vom Agenten beobachtete Bild ein (bei einem Computer ist es eine Matrix oder ein Vektor) und gibt die Wahrscheinlichkeit aus Aktionen, die der Agent ausführen kann. verteilt.

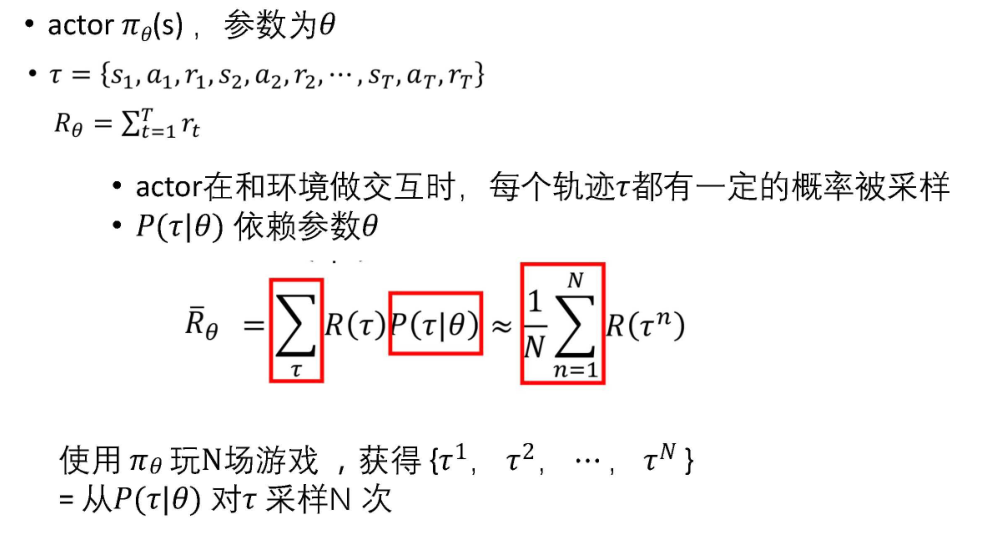

Darüber hinaus müssen wir die Vor- und Nachteile des Akteurs messen. Basierend auf dem Akteur können wir eine Reihe von Renditen erhalten, die durchschnittliche Rendite berechnen und die Vor- und Nachteile der Strategie vergleichen. R ist das J oben.

Dann wollen wir den optimalen Akteur finden (R ist die Erweiterung von J oben) und verwenden die Gradientenaufstiegsmethode, um Folgendes zu erhalten:

3. Erweitern Sie die Tiefe