マルチエージェント強化学習の理論とアルゴリズムの概要

まずはオンポリシーとオフポリシーを理解する[強化学習] 理解すべき 1 つの記事、

オンポリシーとオフポリシー

についての私の理解: オンポリシーとは、データを収集するためのアクションを実行する最新の戦略を使用することですが、トレーニング データはoff-policy は最新の攻略法をまとめたものではありません。On-policy は、同じポリシー ネットワークを使用してアクションをサンプリングし、実行します。このポリシー ネットワークは、Q 値を更新するためにも必要です。

1. 基本的な概念の理解、マルチエージェントのステータス、観察、報酬などを再定義する必要がある:

強化学習 - マルチエージェントの強化学習

強化学習のメモ: ポリシーベースのアプローチ

2. 最新のマルチエージェント強化学習手法のまとめ:

最新のマルチエージェント強化学習手法 【概要】

Transformer についてよく解説します:

Transformer の説明

3. いくつかの基本的なアルゴリズム (PPO、DQN など) のステップ

DQN - PPO プロセスの概要

強化学習ノート: PPO [近接ポリシーの最適化 (近接ポリシーの最適化)]

高度な - PPO コードの行ごとの分析

4. TD の定義、GAE 利点関数など:

GAE 一般化利点推定

5. いくつかの古典的なマルチエージェントアルゴリズムの制限の概要:

[1] 最新のマルチエージェント強化学習手法 [概要]

6. マスターする必要がある協調的(協調的)マルチエージェント アルゴリズム:

1. 価値関数値分解に基づく方法:

(1) COMA アルゴリズム:

[COMA] チームの報酬を独立した報酬に分割するマルチエージェント

アルゴリズム COMA アルゴリズム分析: 反事実的なマルチエージェント政策の勾配

(2) VDN/QMIX/QTRAN/Qatten アルゴリズムの導入と限界:

マルチエージェント深層強化学習値分解手法の概要 (1) - VDN/QMIX/QTRAN/Qatten

(3) QMIX アルゴリズム:

マルチエージェント強化学習の概要 Qmix

コード: https://blog.csdn.net/tianjuewudi/article/details/121005721

(4) QTRAN アルゴリズム:

QTRAN アルゴリズムの詳細説明 (VDN および QMIX のアップグレード版)

(5) Qattenアルゴリズム:

Qatten

(6) MAVEN アルゴリズム:

(7) Weighted QMIX アルゴリズム:

QMIX から WQMIX へ - Weighted QMIX アルゴリズムの詳細説明

(8) QPLEX アルゴリズム:

マルチエージェント強化学習 2021 論文 (5) QPLEX

最後に、大ボスの研究:

マルチエージェント強化学習値関数分解

マルチエージェント強化学習値関数分解に関する論文研究: VDN、QMIX、QTRAN シリーズの長所と短所の分析

2. PPO ベースの手法:

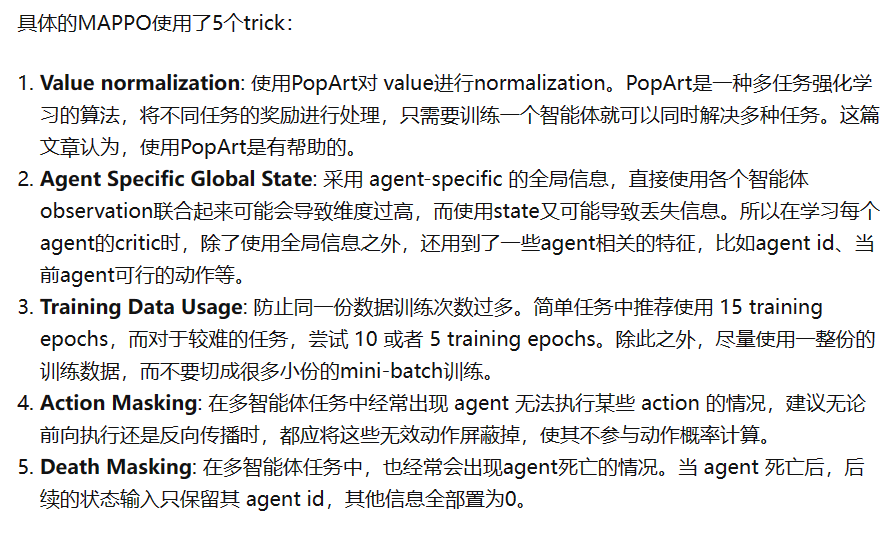

(1) MAPPO

マルチエージェント強化学習 MAPPO 理論解釈

(2) HAPPO

(3)マット

3. 良いコード:

https://github.com/marlbenchmark/on-policy

https://github.com/hijkzzz/pymarl2

4. いくつかの論文の要約

https://www.zhihu.com/people/sanmuyansan-mu-yang/columns

5. Carla、自動運転用マルチエージェント強化学習用シミュレーション ソフトウェア(

非推奨、軽量ではない) /スマート