1. La historia del desarrollo informático

1.1 La primera generación de computadoras

La primera generación de computadoras: computadoras de tubo electrónico (1945~1957).

Cuando se trata de computadoras de tubo, hay que mencionar el nacimiento de los diodos. Cuando estábamos en la escuela secundaria o preparatoria, estábamos expuestos a conocimientos relevantes como la corriente, el voltaje y la resistencia. Antes de entender los diodos, primero entendemos algunos conceptos básicos.

1.1.1, corriente, voltaje, resistencia

En otras palabras, Newton descubrió la gravitación hace mucho tiempo, propuesta por primera vez en el libro "Principios matemáticos de la filosofía natural" publicado en 1687. Sin embargo, la causa de la gravedad nunca se menciona en sus obras.

La gravedad la produce la materia con masa, y la materia está compuesta por átomos, que son las unidades básicas de todos los elementos de la materia, y los átomos están compuestos por núcleos (protones, neutrones) y electrones (con carga negativa) que giran a su alrededor a gran velocidad.

La corriente se genera por el movimiento direccional de las cargas (partículas positivas/negativas, los opuestos se atraen, lo mismo se repelen) . El campo de energía generado por el movimiento de cargas se llama campo eléctrico de Coulomb (el generado por el campo magnético cambiante se llama campo eléctrico inducido). Al igual que las baterías en nuestra vida diaria, se ha acumulado una gran cantidad de cargas positivas y negativas en ambos extremos de la batería (positiva (alto potencial) -> negativa (bajo potencial), esta diferencia de potencial, también conocida como voltaje), su campo eléctrico (diferencia de potencial) es la fuerza misteriosa que impulsa a la carga a moverse . Los electrones en la sustancia en este campo eléctrico formarán una corriente eléctrica.

Entonces, ¿por qué diferentes sustancias conducen la electricidad de manera diferente? Como el metal y la madera, esto se debe a que los núcleos atómicos de diferentes sustancias unen los electrones fuera del núcleo de manera diferente. Siempre que se aplique una ligera fuerza de campo eléctrico en ambos extremos del metal, los electrones se liberarán fácilmente de las restricciones del núcleo atómico para formar una corriente estable. La resistencia de los núcleos atómicos a la corriente eléctrica es lo que llamamos resistencia .

Ley de Ampere : Es una ley electromagnética, que expresa la relación entre la corriente y la dirección de la línea de inducción magnética del campo magnético excitado por la corriente, también conocida como regla de la espiral de la mano derecha.

Ley de Ohm : el físico alemán George Simon Ohm publicó en abril de 1826 el artículo "Determinación de la ley de conducción de metales". En el mismo circuito, la corriente que pasa a través de un conductor es proporcional al voltaje a través del conductor e inversamente proporcional a la resistencia del conductor (I=\frac{U}{R} ).

Ley de Joule : El calor generado por la corriente que pasa por el conductor es proporcional al cuadrado de la corriente, proporcional a la resistencia del conductor y proporcional al tiempo de electrificación (Q={I^2Rt}). Esta es también la razón por la que un cortocircuito generará calor o incluso se incendiará.Cuanto mayor sea la corriente, más evidente será el calor.

1.1.2, el nacimiento del tubo de electrones

En 1877, después de que Edison inventara la lámpara eléctrica de filamento de carbono, la vida útil de la lámpara de filamento de carbono no fue larga porque el filamento de carbono era difícil de soportar la alta temperatura del fuego eléctrico. Edison intentó por todos los medios mejorarlo. En 1883, tuvo un capricho: colocar una lámina de cobre en la bombilla de vacío puede evitar que el filamento de carbono se evapore y prolongar la vida útil de la bombilla. Sin embargo, se encontró con un fenómeno muy extraño, la lámina de cobre no estaba conectada directamente al circuito sino que generaba corriente. Esto es algo increíble. Sensitive Edison afirmó que se trataba de un nuevo descubrimiento, y pensó que podría ser posible fabricar aparatos eléctricos prácticos como amperímetros y voltímetros basados en este descubrimiento. Por esta razón, solicitó una patente, la denominó " Efecto Edison ", y no realizó más investigaciones.

En 1884, Edison le mostró el "efecto Edison" al físico británico Fleming, pero todo esto fue visto por Fleming.

En 1896, se estableció Marconi Wireless Telegraph Company y se contrató a Fleming como consultor. Cuando investigaba y mejoraba los receptores de telégrafo inalámbrico, apareció el efecto Edison. Tomó la batuta de Edison y estudió cuidadosamente este fenómeno. Descubrió que el efecto Edison es en realidad muy simple. Después de encender la bombilla, el filamento emite calor y entra en un estado incandescente.

Si la pieza de metal tiene carga negativa (los opuestos se repelen), los electrones se bloquean y no fluye corriente. Cuando la corriente alterna pasa a través del dispositivo, se convierte en corriente continua (solo flujo unidireccional). Fleming llamó a este tubo con dos electrodos un diodo de vacío, así nació el primer diodo del mundo. Y el 16 de noviembre de 1904 se patentó en el Reino Unido.

Más tarde, el "padre de la radio" - Lee De Forest, después de colocar el cable en forma de Z en el tubo de vacío, siempre que se le aplique un voltaje de cambio débil, se puede recibir una corriente de cambio más grande en la pantalla de metal.

Luego, cambió el cable por una malla metálica en forma de cerca, por lo que su tubo de electrones tiene tres "polos": filamento, pantalla y rejilla, y la rejilla es responsable de controlar y amplificar la señal eléctrica. La radio puede lograr una transmisión a mayor distancia. En 1907, De Forest declaró la patente de invención del triodo de vacío (tubo de electrones) a la Oficina de Patentes de los Estados Unidos.

Durante la Segunda Guerra Mundial, tanto EE. ) se desarrolló con éxito en los Estados Unidos. Acorta el tiempo para calcular la trayectoria a 30 segundos. Consta de 17.468 tubos de electrones. Es una máquina grande y pesada, con un peso de más de 30 toneladas, y ocupa un área tan grande como dos o tres aulas. ENIAC utiliza un triodo de vacío para permitir que la computadora pase la corriente de la red de control, y la eficiencia es miles de veces mayor que la de la computadora electromecánica.

La primera generación de computadoras de tubo de vacío (computadoras de tubo de vacío) se usaba principalmente para la investigación militar y los cálculos científicos, pero había muchos problemas. Si uno de los tubos de vacío se quemaba, la máquina no podía funcionar. Los tubos de vacío quemados tenían que descubrirse manualmente, por lo que era muy difícil fabricarlos, mantenerlos y usarlos.

1.2, la computadora de segunda generación

La segunda generación de computadoras: transistores y mainframes (1958-1963).

Debido al gran tamaño del tubo electrónico y al alto consumo de energía, el tubo electrónico se quema y falla fácilmente. Al final, no pudo adaptarse al desarrollo de la informatización de la microelectrónica, por lo que aparecieron los transistores.

En 1945, Shockley comenzó a usar semiconductores para desarrollar un nuevo amplificador electrónico. Los materiales semiconductores no son lo suficientemente conductivos para ser conductores, pero no lo suficientemente aislantes para ser un aislante (el silicio, el germanio y el nitruro de galio [una nueva generación de materiales semiconductores distintos del silicio] tienen cuatro electrones más externos). El inteligente pero indiferente Shockley eligió trabajar desde casa, dejando libres a sus colegas Walter Bratton y John Bardeen para realizar experimentos en Bell Laboratories en Nueva Jersey.

En 1946, la famosa pionera de las computadoras Grace Heber usó la palabra de una manera interesante en el registro: cuando el operador usaba las computadoras MarkII y MarkIII, ocurría un error porque una polilla se atascaba en el relé, entonces la usaba.

En noviembre de 1947, un descubrimiento accidental de Bratton le dio al físico teórico Bardeen una nueva comprensión crucial del comportamiento de las corrientes eléctricas en la superficie de los semiconductores. Bratton armó un amplificador con plástico, pan de oro y germanio semiconductor, y lo probó. El amplificador fue exitoso, capaz de controlar grandes corrientes con voltajes de entrada muy pequeños. Este es el primer transistor de la historia.

Pero no fue hasta que Shockley mejoró el diseño en 1951 que la gente se dio cuenta de su importancia, y más tarde apareció el triodo NPN.

En 1954, Bell Laboratories en los Estados Unidos desarrolló la primera computadora usando circuitos de transistores, llamada "TRADIC", que estaba equipada con 800 transistores.

Más computadoras de transistores siguieron en las décadas de 1950 y 1960. Una ventaja clave de las computadoras de transistores es su pequeño tamaño, lo que las hace más compactas que las computadoras de tubos de vacío.

En 1956, Shockley, Bardeen y Bratton compartieron el Premio Nobel de Física.

En 1958, IBM fabricó la RCA501, la primera computadora que usaba todos los transistores . La segunda generación de computadoras ha entrado oficialmente en escena.En comparación con las válvulas electrónicas, los transistores son de menor tamaño y tienen un voltaje de funcionamiento muy bajo, una vida más larga y una mayor eficiencia.

Las computadoras de segunda generación se utilizan principalmente para cálculos científicos y de ingeniería, como la resolución de ecuaciones de cálculo parcial, principalmente utilizando el lenguaje FORTRAN, el lenguaje ensamblador y el sistema IBSYS.

1.3, la computadora de tercera generación

La tercera generación de computadoras: circuitos integrados (IC) y minicomputadoras (1964~1970).

En 1958, Texas Instruments y Fairchild desarrollaron sucesivamente el circuito integrado IC, que utilizaba cierta tecnología de proceso para interconectar (empaquetar) los transistores, diodos, resistencias, capacitores, inductores y otros componentes necesarios en un circuito juntos (empaquetado).

Con la invención de los microchips semiconductores (es decir, obleas de silicio) y el rápido desarrollo de los circuitos integrados , también se ha impulsado el nacimiento de la tercera generación de computadoras electrónicas.

En 1964, IBM Corporation de los Estados Unidos lanzó la computadora IBM-360 usando circuitos integrados, marcando el advenimiento de la tercera generación de computadoras. Comenzó a aparecer la tercera generación de computadoras electrónicas fabricadas con circuitos integrados de mediana y pequeña escala .

Aunque los primeros circuitos integrados utilizados en las computadoras de tercera generación integraron docenas de triodos, resistencias y otros componentes, incluso los LSI (circuitos integrados a gran escala) solo pudieron integrar alrededor de 1000. En comparación con las placas de circuito impreso de aproximadamente 10 cm en las computadoras de segunda generación, la misma función se puede lograr con solo 1 mm.

En 1965, para permitir que más personas usaran computadoras, MIT, Bell Labs y General Electric desarrollaron conjuntamente el sistema operativo multitarea de tiempo compartido Multics (el predecesor de UNIX).Más tarde, debido a que Multics era demasiado difícil, el proyecto progresó lentamente.

1.4, la computadora de cuarta generación

La cuarta generación de computadoras - computadoras personales y terminales móviles (VLSI-Very Large Scale Integrated Circuits, 1971~presente).

En 1971, Intel desarrolló la microcomputadora MCS-4, una computadora de cuatro bits con una CPU de 4040. Posteriormente, Intel lanzó el tipo MCS-80, una computadora de ocho bits con una CPU de 8080.

Las microcomputadoras de dieciséis bits comenzaron a florecer entre 1978 y 1983. Los productos cumbre de este período fueron las microcomputadoras Macintosh de Apple y PC/AT286 de IBM.

Después de que Goug Engelbart inventara la interfaz gráfica de usuario, Apple descubrió el valor potencial de la GUI, por lo que diseñó una computadora Apple con GUI, pero debido a la estrategia de mercado cerrado de Apple, no era compatible con otras PC. Esto hace que Apple pierda una buena oportunidad de dominar el PC global.

En 1981, IBM diseñó la PC de IBM y encontró a Bill Gates, con la esperanza de que Bill Gates pudiera proporcionar el sistema operativo (Bill Gates compró el sistema DOS), y la PC de IBM se usó ampliamente en el mercado con CPU Intel y DOS.

En 1985, Microsoft lanzó la primera versión de Microsoft Windows;

En 1995, se lanzó Windows 95, un sistema Windows híbrido de 16 bits/32 bits.

En 1998, se lanzó Windows 98 y el lenguaje ensamblador Intel de 16 bits todavía se usaba ampliamente en la capa inferior.

En 2000, el fracaso de Windows NT y Windows 2000 llevó a Microsoft a lanzar otra versión de Windows 98, llamada Windows Me.

En 2001, Microsoft lanzó una versión mejorada de Windows 2000 llamada Windows XP, que básicamente reemplazó a todas las versiones anteriores de Windows.

En 2007, Windows Vista se lanzó oficialmente el 30 de enero, que es el lanzamiento más largo en la historia de las versiones de Windows.

En 2009, se lanzó Windows 7 y el sistema operativo recibió elogios unánimes del mundo exterior.

En 2012, se lanzó oficialmente Windows 8. Sin embargo, debido a que la interfaz de usuario de Windows 8 es demasiado complicada, muchos forasteros la han criticado.

En 2015, Microsoft lanzó la versión oficial de Windows 10.

En 2021, el 24 de junio, Microsoft lanzó Windows 11, que se lanzará oficialmente el 5 de octubre;

2. Arquitectura informática

2.1 Arquitectura Von Neumann

2.1.1 La maravillosa vida de Von Neumann

Von Neumann, informático, físico y uno de los matemáticos más importantes del siglo XX. Es uno de los científicos polifacéticos en los campos de las computadoras modernas, la teoría de juegos, las armas nucleares y las armas químicas y biológicas. Las generaciones posteriores lo llaman "el padre de las computadoras modernas" y "el padre de la teoría de juegos".

Tiene un talento asombroso en el campo de las matemáticas desde que era un niño. A la edad de seis años, pudo hacer divisiones de ocho dígitos en su cabeza, y a la edad de ocho años dominó el cálculo. A la edad de doce años, comprendió la esencia de la obra maestra de Borel "Teoría de funciones". A la edad de 17 años, publicó su primer artículo matemático.

Sin embargo, sus padres sentían que estudiar matemáticas no daba dinero, por lo que esperaban que von Neumann dejara las matemáticas (porque en ese momento, el campo de la química era relativamente rentable, como era el caso de la familia Nobel en ese momento). Posteriormente, von Neumann llegó a un acuerdo con sus padres, es decir, matricularse en tres universidades al mismo tiempo y completar los estudios en tres universidades. Así que empezó a estudiar ingeniería química en la ETH de Zúrich, mientras hacía los deberes de la tarde para su especialización en matemáticas en la Universidad de Berlín.

En 1926, a la edad de 22 años, obtuvo una licenciatura en química del Instituto Federal de Tecnología de Zúrich y aprobó la defensa de doctorado en matemáticas organizada por David Hilbert en la Universidad de Budapest.

De 1927 a 1929, von Neumann se desempeñó sucesivamente como profesor de matemáticas en la Universidad de Berlín y la Universidad de Hamburgo, y luego se estableció en los EE. UU. Durante este período, utilizó el conocimiento matemático para proporcionar modelos matemáticos para la mecánica cuántica, lo que lo llevó a ocupar una posición destacada en el campo de la física teórica;

Aceptó una cátedra visitante en la Universidad de Princeton en 1930;

En 1931, se convirtió en profesor titular en la Universidad de Princeton;

En 1933, se trasladó al Instituto de Estudios Avanzados de Princeton y, junto con Einstein, el matemático Veblen y el matemático Alexander, se convirtieron en los primeros cuatro profesores designados por el Instituto de Estudios Avanzados (von Neumann es el más joven de los profesores), y trabajó aquí toda su vida.

Más tarde, un hombre llamado Turing imaginó una "máquina de Turing" ficticia para probar la tercera proposición de Hilbert. Su mentor le recomendó a Turing que fuera a la Universidad de Princeton como estudiante de doctorado de Alonzo Church.

En septiembre de 1936, Turing fue invitado a estudiar en el Instituto de Estudios Avanzados de Princeton. Tan pronto como se publicó el artículo de Turing, el entusiasta von Neumann ya había olido la amplia perspectiva de la máquina de Turing. Posteriormente, su investigación se centra en dos cosas, una es la "memoria fina" y la otra es "binaria". Trata los procedimientos almacenados como matemáticas.

En 1944, Goldstein conoció a von Neumann por casualidad y le reveló el proyecto de computadora electrónica y el progreso de la investigación de la Escuela de Ingeniería de Moore.

Antes de que ENIAC (Computadora e Integral Numérica Electrónica) se pusiera en funcionamiento, von Neumann se sintió atraído por el proyecto ENIAC, se dio cuenta de la necesidad de mejorar en gran medida el poder de cómputo y comenzó a prepararse para la transformación completa de esta computadora electrónica. En solo 10 meses, von Neumann convirtió rápidamente los conceptos en propuestas. El nuevo esquema de máquina se denomina "Computadora Electrónica Automática Variable Discreta", abreviatura en inglés EDVAC.

En junio de 1945, von Neumann, Goldstein, Birx y otros publicaron conjuntamente un informe de 101 páginas, que es el famoso "Informe de 101 páginas" en la historia de las computadoras. Este es el famoso "Informe preliminar sobre EDVAC (Computadora electrónica automática de variable discreta) " . Este informe es un documento histórico en la historia de la informática moderna. Estipula claramente que el binario se usa para reemplazar las operaciones decimales. El informe menciona las ventajas del binario y predice que el uso del binario simplificará en gran medida el circuito lógico de la máquina. Y dividir la computadora en cinco componentes principales (calculadora, dispositivo de control lógico, memoria, dispositivos de entrada y salida), esta excelente idea sentó las bases para el diseño de la estructura lógica de las computadoras electrónicas.

Aquí puede preguntar, ¿por qué usar binario? ¿Es no binario?

No es que los diferentes voltajes no binarios puedan representar números diferentes. A medida que aumenta la cantidad de veces que se usa un dispositivo y se ve afectado por el ruido externo y otros entornos, la precisión del almacenamiento de voltaje se deteriorará y pueden aparecer voltajes ambiguos, lo que provocará desviaciones en los resultados. En binario, solo hay dos resultados, encendido y apagado, que determinan las ventajas del binario en términos de estabilidad y complejidad.

El 14 de febrero de 1946, se anunció oficialmente en la Universidad de Pensilvania la primera computadora de uso general ENIAC (sistema decimal, una computadora con programas y cálculos separados, desarrollada por Mauchly y Eckert de la Escuela de Ingeniería Moore de la Universidad de Pensilvania) del mundo.

Su sucesor, EDVAC, fue diseñado con computadoras estructuradas binarias y von Neumann. (EDVAC se entregó al Laboratorio de Investigación Balística en agosto de 1949, y EDVAC no comenzó a funcionar hasta 1951. El motivo de la demora fue que Mauchly y Eckert se fueron de la Universidad de Pensilvania, comenzaron a formar una compañía de computadoras electrónicas y se llevaron a la mayoría de los ingenieros superiores. La eficiencia de EDVAC es cientos de veces mayor que ENIAC. Solo usa 3563 tubos de electrones y 10,000 diodos de cristal, y 1024 líneas de retardo de mercurio para almacenar programas y datos El consumo de energía y el espacio de piso son solo ENIA un tercio de C.)

Más tarde, aparecieron muchas computadoras con estructura de von Neumann, incluyendo MANIAC (Mathematical Analysis Numerical Integral Computer) desarrollada por Los Alamos National Laboratory, ILLAC fabricada por la Universidad de Illinois, y así sucesivamente.

Y von Neumann fue contratado como consultor científico de IBM Corporation, ayudando a la empresa a dar a luz a la primera computadora con programa almacenado, IBM 701, que se lanzó oficialmente en 1952. Fue la primera computadora científica comercial de IBM.

2.1.2 Descripción general de la arquitectura de Von Neumann

La arquitectura de von Neumann reinventa la computadora como tres sistemas independientes, una memoria para almacenar datos e instrucciones, una unidad central de procesamiento para decodificar y ejecutar instrucciones y un conjunto de interfaces de entrada y salida, incluidos cinco componentes principales: unidad aritmética, controlador, memoria, dispositivos de entrada y salida .

1) Dispositivo de entrada: recibe los datos originales y la entrada del programa por parte del usuario, los convierte en binarios y los almacena en la memoria; (I: entrada)

2) Memoria: se utiliza principalmente para almacenar datos y programas; (M: memoria)

3) Dispositivo de salida: convierte los datos almacenados en la memoria en una forma de expresión fácilmente comprensible; (O: salida)

4) Calculadora: operación aritmética + operación lógica (ALU: Unidad Aritmética y Lógica)

5) Controlador: El centro de comando de la computadora. (CU: Unidad de control)

La arquitectura de Von Neumann separa la unidad que procesa la información (CPU) de la unidad que almacena la información (es decir, la memoria) y permite que los datos y las instrucciones se almacenen y direccionen de la misma manera en la memoria .

La arquitectura también introduce el concepto de un ciclo de instrucción: la suma del tiempo que le toma a la CPU obtener una instrucción de la memoria y ejecutarla . El recíproco del tiempo de ciclo: el número de trabajos que se pueden realizar en 1 segundo se llama frecuencia de reloj. La razón por la cual la computadora puede completar automáticamente el trabajo es porque la CPU puede obtener y ejecutar repetidamente instrucciones de la memoria para formar un ciclo cerrado (obtener instrucciones, decodificar instrucciones, ejecutar instrucciones y obtener la siguiente instrucción).

En la etapa de obtención de instrucciones, la instrucción se coloca en el registro. De hecho, el proceso de obtención de la instrucción a través del registro de PC y el registro de instrucción es operado por el controlador, y el proceso de decodificación de la instrucción también es operado por el controlador. Una vez que llega a la etapa de ejecución de instrucciones, ya sean instrucciones de tipo R para operaciones aritméticas y operaciones lógicas, o instrucciones de tipo I para transmisión de datos y bifurcaciones condicionales, todas son operadas por la unidad aritmética lógica, es decir, procesadas por la unidad aritmética.

Con el desarrollo continuo de la tecnología informática, las computadoras modernas tienen muchas mejoras en la estructura en comparación con las primeras computadoras de von Neumann, pero las computadoras actuales están diseñadas principalmente en base a la arquitectura de von Neumann. (Sobre el sistema de estructura informática y la estructura de Harvard)

3. Descripción general del sistema informático

3.1 Descripción general de la composición del sistema informático

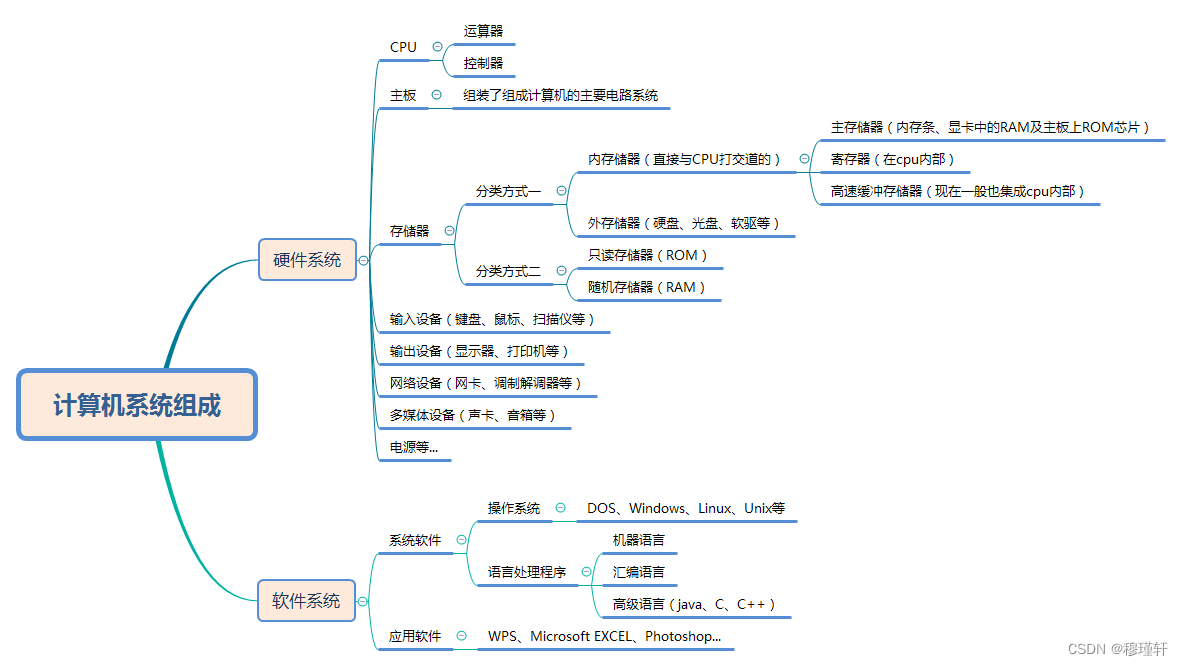

Sabemos que un sistema informático consta de dos partes principales: un sistema de hardware y un sistema de software ;

Sistema de hardware: se refiere a los objetos físicos que se pueden tocar con las manos. Por ejemplo: el hardware necesario de una computadora incluye: placa base, CPU, tarjeta de memoria, tarjeta gráfica, fuente de alimentación, hardware importante incluye: radiador de CPU, disco duro, etc.;

Sistema de software: software compuesto por programas con varias funciones especiales (la interfaz entre el usuario y el hardware). El sistema de software se divide además en software de sistema y software de aplicación;

1) Software del sistema: un sistema que controla y coordina computadoras y dispositivos externos, y apoya el desarrollo y operación de software de aplicación.La función principal es programar, monitorear y mantener los sistemas informáticos.

2) Software de aplicación: software desarrollado para un propósito específico.

3.2, CPU

3.2.1 ¿Qué es una CPU?

La CPU (Unidad central de procesamiento), es decir, la unidad central de procesamiento, consta de una unidad aritmética y un controlador (por supuesto, incluidos varios registros, memoria caché y el bus de datos, control y estado que realiza la conexión entre ellos). Es la unidad de ejecución final del procesamiento de la información y la operación del programa, y controla y administra otro hardware hasta cierto punto. En pocas palabras, es operar de acuerdo con nuestras instrucciones o programación, y procesar los datos en el software de la computadora analizando las instrucciones de la computadora.

Entre ellas, la función del controlador es responsable de coordinar y controlar la secuencia de instrucciones de cada componente de la computadora para ejecutar el programa, incluyendo la obtención de instrucciones, el análisis de instrucciones y la ejecución de instrucciones; la función de la unidad aritmética es procesar datos.

3.2.2, el origen de la CPU

En enero de 1971, el ingeniero Hoff de Intel inventó el primer microprocesador de computadora comercial 4004 del mundo, lo que convirtió a Intel en una empresa de microprocesadores. Aunque este microprocesador de 4 bits tiene solo 45 instrucciones, solo puede ejecutar 50,000 instrucciones por segundo, y la frecuencia es de solo 108 KHz, que ni siquiera es comparable con la primera computadora ENIAC del mundo. Pero su nivel de integración es muy superior, con 2.300 transistores integrados, y un trozo de 4004 pesa menos que una taza (28.350 gramos). Después de usar el chip 4004, se equipa con una memoria de programa, una memoria de datos, un registro de desplazamiento, además de un teclado y un tubo digital para formar una microcomputadora completa. Pero la respuesta de este chip no es muy buena, probablemente debido a la limitada potencia de procesamiento.

En 1972, Intel lanzó el microprocesador 8008. Intel también adoptó la tecnología de instrucción del procesador por primera vez en este microprocesador, lo que hizo que el rendimiento del 8008 fuera el doble que el del 4004, pero la frecuencia aún se establece de manera conservadora entre 200 y 800 KHz. El rendimiento del 8008 fabricado con un proceso de 10 micrones no impresionó a los consumidores.

En 1974, se lanzó el procesador 8080, y el 8080 tuvo el honor de convertirse en el cerebro de la primera computadora personal Altair. En pocos meses, el volumen de ventas de Altair alcanzó decenas de miles.

En 1978, Intel lanzó el primer microprocesador de 16 bits, el 8086, que es el creador de la arquitectura x86. En el mismo año, se lanzó el procesador con mejor rendimiento 8088. El éxito del 8088 hizo que Intel se ubicara entre los Fortune 500.

En 1982, se lanzó el procesador 80286. Su bus de direcciones se amplió a 24 bits y también fue el último procesador de 16 bits de Intel.

En 1985, Intel lanzó el primer procesador X86 de 32 bits 80386, que integraba 275 000 transistores. La característica más crítica fue el uso de un bus de direcciones de 32 bits para admitir un máximo de 4 GB de memoria.

En 1989, Intel lanzó el procesador 80486, que integraba 1,25 millones de transistores, y la frecuencia inicial de 80486 era de 50 MHz. El primer nivel de caché apareció en el 80486. Los primeros 80486 incluían un caché de 8 KB y usaban un proceso de 1000 nm. Intel también ha integrado la FPU (Unidad de Punto Flotante).

En 1993, Intel lanzó la CPU Pentium (Pentium), Pentium adoptó la arquitectura P5, aunque superó a la 80486 en todos los aspectos, el avance más destacado fue la mejora de la FPU. El tamaño de la memoria caché de primer nivel se incrementa a 16 KB.

En 1995, Intel lanzó el Pentium Pro (Pentium Pro).

En 1997, Intel lanzó el Pentium II (Pentium II). AMD y Cyrix también lanzaron los procesadores AMD K6-2 y Cyrix MII del mismo grado.

En 1999, Intel lanzó el procesador Celeron (Celeron) (inicial) y el procesador Pentium III (Pentium III).

En 2000, AMD tomó la iniciativa al lanzar el microprocesador Athlon (Athlon K7) de 1 GHz, cuyo rendimiento superó al de Pentium III. En noviembre, Intel lanzó el procesador Pentium 4, que utiliza una nueva arquitectura Socket 423.

En 2003, Intel lanzó el procesador Pentium M. Y AMD lanzó el procesador de escritorio Athlon 64 de 64 bits (arquitectura K8)

En 2004, AMD lanzó el procesador Sempron (Sempron), utilizando la interfaz Socket A.

En 2005, Intel perdió su negocio de teléfonos móviles, lanzó un procesador de escritorio de 64 bits y lo llamó la serie 6XX, a saber, Pentium 4 6XX. En abril del mismo año, se lanzaron el procesador de doble núcleo Pentium D (que no es compatible con la tecnología Hyper-Threading) y el Pentium E (que admite la tecnología Hyper-Threading) . AMD también lanzó el Athlon 64 X2 de doble núcleo .

En julio de 2006, Intel lanzó una nueva generación de nuevos procesadores de escritorio de microarquitectura Core 2 duo (Core 2 Duo), su eficiencia energética es un 40% superior a la del mejor procesador Intel Pentium y su consumo de energía se reduce en un 40%.

En noviembre de 2007, AMD lanzó la serie de procesadores Phenom basada en la nueva arquitectura K10.

En 2008-2009, todavía era el período de generación Core, Core i7 920 fue el producto clásico de primera generación; en 2009, Intel lanzó el procesador i7/i5/i3 con interfaz LGA1156 y comenzó a empaquetar GPU y CPU en el mismo chip por primera vez, como: i3-530. Y AMD lanzó el Sempron de doble núcleo (Sermpron).Antes del lanzamiento de Ryzen, AMD siempre se estaba poniendo al día con Intel;

En 2011, Intel utilizó el proceso de 32 nm y adoptó las arquitecturas de clasificación de productos i3, i5 e i7. Entre ellas, i3 se centró en el mercado de gama baja con una arquitectura de procesador de doble núcleo y aproximadamente 2 MB de caché secundaria. El procesador i5 se centró en el mercado principal con una arquitectura de procesador de cuatro núcleos y 4 MB de caché secundaria. Y amd lanzó productos APU (CPU+GPU) basados en la arquitectura Fusion, A4, A6, A8 (comúnmente conocidos como bulldozers).

En 2012, Intel lanzó los procesadores de la serie Core i de tercera generación, que incluyen núcleos de gráficos, controladores de memoria, controladores de canales de gráficos y controladores de bus de entrada y salida. En este momento, el puente norte también está integrado en el chip, y la placa base solo tiene el puente sur y no el puente norte.

En 2013, Intel ingresó a la cuarta generación de procesadores Core inteligentes, y en ese momento la memoria todavía usaba DDR3;

En 2015, Intel ingresó al procesador Core inteligente de quinta generación y al procesador de escritorio Core de sexta generación, y en ese momento se lanzó DDR4;

2016: el procesador de escritorio Core de séptima generación comenzó el viaje de exprimir la pasta de dientes, principalmente para aumentar la frecuencia principal, la cantidad de núcleos y la cantidad de hilos;

2017: el procesador de escritorio Core de octava generación; AMD lanzó su propia serie Ryzen;

2018: el procesador de escritorio Core de novena generación;

2020: el procesador de escritorio Core de décima generación; hasta octubre, cuando AMD lanzó la serie Ryzen 5000, recuperó gradualmente la situación;

2021: el procesador de escritorio Core de 11.ª generación; hasta noviembre, el procesador de escritorio Core de 12.ª generación se ha mejorado mucho y es compatible con DDR5;

3.1.3 Descripción general de la composición de la CPU

Cuando el álgebra booleana se usa ampliamente en el análisis y diseño de circuitos lógicos digitales, todos los componentes electrónicos están diseñados para tener solo dos estados de encendido (1) y apagado (0), lo que simplifica enormemente el diseño del circuito.

Dijimos anteriormente que el nacimiento del transistor fue la invención de esta pequeña cosa que permitió a tres personas (John Bardeen, William Shockley y Walter Bratton) ganar el Premio Nobel de Física. Con los transistores, también hay interruptores, es decir, se pueden diseñar circuitos de puertas lógicas (Y, O, NO) En matemáticas discretas, hay un conjunto completo de lógica.

Todo el diseño del chip es un proceso de convertir partes en totalidades. Primero, muchos transistores forman puertas lógicas, varias puertas lógicas forman registros y circuitos combinatorios, y muchos registros y circuitos combinatorios forman circuitos aritméticos, circuitos de control, circuitos de almacenamiento, etc., y luego muchos de estos circuitos forman módulos de comunicación y computación, y estos módulos finalmente forman un chip de CPU .

A fines de la década de 1990, la ciencia y la tecnología electrónica lograron un rápido desarrollo, especialmente con la aplicación generalizada de computadoras electrónicas y circuitos integrados. El tamaño de las CPU se hizo cada vez más pequeño. Cuantos más transistores se integraban en una CPU, más rápida era su eficiencia de procesamiento y su velocidad de cómputo. Desde el procesador 4004 lanzado por Intel en 1971, que integraba 2300 transistores, la cantidad de transistores en el chip de la serie M (M1 Max) lanzado hoy por Apple ha alcanzado los 57 mil millones.

La función principal de la CPU es completar las funciones de obtener instrucciones y ejecutar instrucciones.Estas operaciones son realizadas principalmente por unidades aritméticas y controladores .

Por supuesto, las implementaciones de CPU de diferentes fabricantes en diferentes períodos serán diferentes. Las principales diferencias se reflejan en la arquitectura del conjunto de instrucciones, la ruta de datos y la implementación del controlador de CPU correspondiente. Sin embargo, su diseño no solo busca lo último en rendimiento, sino un compromiso y una compensación en rendimiento y costo.

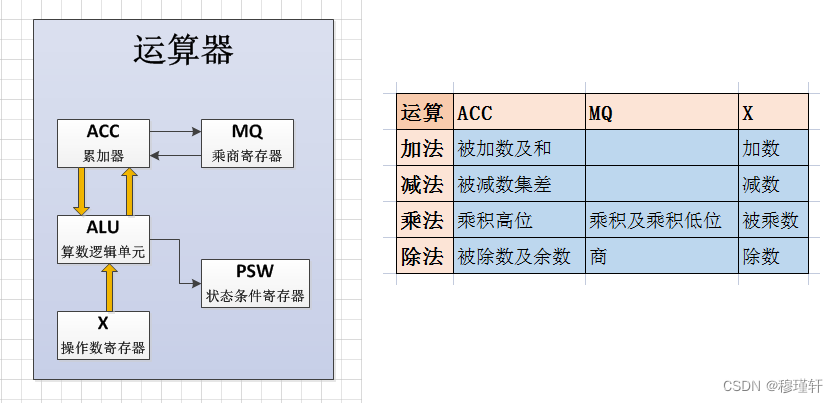

3.1.4 Composición de la CPU - Unidad aritmética

La unidad aritmética es el centro de procesamiento de la computadora, compuesto principalmente por unidad lógica aritmética (ALU)/unidad de operación de punto flotante (FPU) + grupo de registro general (acumulador ACC, MQ es el registro de cociente de multiplicación, X es el registro de operando) + registro especial (registro de estado PSW).

-

Unidad Aritmética Lógica (ALU)

Se basa en un sumador completo, complementado con un circuito compuesto por un registro de desplazamiento y la lógica de control correspondiente.Bajo la acción de una señal de control, puede completar operaciones aritméticas de punto fijo (suma, resta, multiplicación, división), operaciones lógicas (AND, NOR, XOR) y varias operaciones de desplazamiento de datos binarios.

-

Unidad de coma flotante (FPU)

Principalmente responsable de las operaciones de punto flotante y operaciones enteras de alta precisión.

-

registro de propósito general

Se utiliza para guardar los operandos que participan en la operación y los resultados intermedios de la operación.

ACC (acumulador, acumulador): es un registro de propósito general que proporciona un área de trabajo para la ALU y puede guardar temporalmente un operando o resultado de operación para la ALU.

MQ (registro de cociente multiplicador) es un registro de cociente multiplicador;

X es el registro de operandos;

-

Registro de estado (PSW)

Puede haber diferentes regulaciones en diferentes máquinas.PSW generalmente se usa para almacenar dos tipos de información, una es información de estado diversa del resultado de ejecución de la instrucción actual, como si hay un acarreo (bit CF), si hay desbordamiento (bit OF), el resultado es positivo o negativo (bit SF), si el resultado es cero (bit ZF), indicador de paridad (bit PF), etc.; el otro es para almacenar información de control, como habilitar interrupción (bit IF), indicador de seguimiento (bit TF), etc.

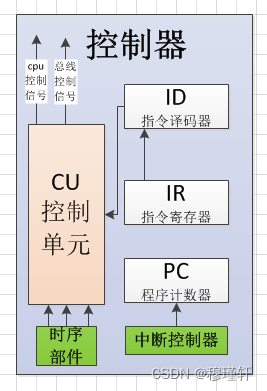

3.1.5 Composición de la CPU - Controlador

El controlador es el centro de comando y control de toda la CPU, que determina la automatización del proceso de cálculo de la computadora. No solo debe asegurar la correcta ejecución del programa, sino también ser capaz de manejar eventos anormales. El controlador generalmente incluye un contador de programa (PC), un registro de instrucciones (IR), un decodificador de instrucciones (ID), un controlador de tiempo, un controlador de bus y un controlador de interrupción.

-

Contador de programa (PC)

El contador de programa (Contador de programa, PC) se utiliza para señalar la dirección de la siguiente instrucción en la memoria principal. Al ejecutar una instrucción, el procesador primero necesita obtener la dirección de la instrucción en la memoria de la PC y obtenerla a través del direccionamiento del bus de direcciones. Al ejecutar una instrucción, la CPU puede incrementar automáticamente el contenido de la PC, si es una instrucción de una sola palabra, entonces (PC)+1, si es una instrucción de dos palabras, entonces (PC)+2.

-

Registro de instrucciones (IR)

El registro de instrucciones (Instruction Register, IR) se utiliza para guardar una instrucción que se está ejecutando actualmente.

-

Decodificador de instrucciones (ID)

El decodificador de instrucciones (Decodificador de instrucciones, ID) es para decodificar la parte del código de operación del registro de instrucciones para generar el potencial de control de la operación requerida por la instrucción y enviarlo al circuito de control de microoperación, bajo la acción de la señal de sincronización del componente secuencial, se genera una señal de control de operación específica.

-

controlador de comando

Principalmente completa las operaciones de obtención de instrucciones, análisis de instrucciones y ejecución de instrucciones.

-

controlador de tiempo

El controlador de tiempo sirve principalmente para proporcionar la señal de control adecuada para cada instrucción en secuencia de tiempo.

El controlador de temporización incluye un generador de reloj y una unidad de definición de multiplicación de frecuencia. Entre ellos, el generador de reloj envía una señal de pulso estable desde el oscilador de cristal de cuarzo, es decir, la frecuencia principal de la CPU; y la unidad de definición de multiplicación de frecuencia define cuántas veces la frecuencia principal de la CPU es la frecuencia de memoria (o frecuencia de bus). En los primeros días, las velocidades de la CPU y la memoria no eran muy diferentes, por lo que los ciclos de la CPU solían ser los mismos que los ciclos de acceso a la memoria. Más tarde, con el desarrollo de la CPU, la velocidad es mucho mayor que la de la memoria, por lo que el ciclo de la CPU suele definirse como una fracción del ciclo de acceso a la memoria.

-

controlador de autobús

El controlador de bus debe gestionar el uso del bus, incluida la gestión de los dispositivos en el bus y la gestión de procesos de los dispositivos que utilizan el bus. En lo que respecta a la CPU, generalmente se divide en un bus interno y un bus externo para que la CPU se comunique con el mundo exterior. El bus externo también se denomina bus del sistema e incluye bus de direcciones, bus de datos, bus de control, etc.

-

controlador de interrupción

Debido a eventos anormales o eventos aleatorios que deben manejarse de inmediato, la computadora detiene temporalmente la ejecución actual, cambia a otro programa de servicio para procesar el evento actual y regresa al programa original después del procesamiento.

Nota: Las interrupciones generadas dentro de la máquina se denominan trampas (interrupciones internas) y las interrupciones provocadas por dispositivos externos se denominan interrupciones externas.

3.1.6 Composición de la CPU - registros

Además del registro de acumulación (ACC), el registro de estado (PSW), el contador de programa (PC) y el registro de instrucciones (IR) presentados anteriormente, también hay registros de direcciones (AR) y registros de datos (DR).

-

Registro de direcciones (AR)

El registro de dirección (Address Register, AR) se utiliza para guardar la dirección de la unidad de memoria principal a la que accede actualmente la CPU.

Dado que existe una diferencia en la velocidad de operación entre la memoria principal y la CPU, los registros de dirección deben usarse para guardar temporalmente la información de dirección de la memoria principal hasta que se complete la operación de acceso a la memoria principal.

-

Registro de datos (DR)

El registro de datos (Data Register, DR), también conocido como registro de búfer de datos, se utiliza para almacenar temporalmente una instrucción o una palabra de datos leída de la memoria principal; a la inversa, cuando una instrucción o una palabra de datos se almacenan en la memoria principal, también se almacenan temporalmente en el registro de datos.

Su función principal es servir como estación de transferencia para la transmisión de información entre la CPU, la memoria principal y los periféricos para compensar la diferencia de velocidad operativa entre la CPU, la memoria principal y los periféricos.

Nota: debe comprender el proceso operativo general de la CPU, y todavía hay muchas cosas que aprender, como la composición de instrucciones (sistemas de instrucciones CISC y RISC), métodos de dirección de instrucciones y datos, ciclos de instrucciones, canalizaciones de instrucciones, lenguaje ensamblador y otros conocimientos.

3.1.7 Composición de CPU - bus

El bus es en realidad un grupo de cables, que son líneas de transmisión de información que conectan varios componentes y se utilizan como una ruta común para la transmisión de información de varios componentes de la computadora.

3.1.7.1, clasificación de autobuses

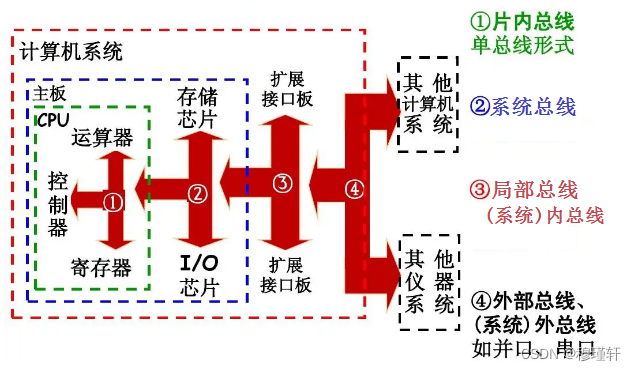

Según su ubicación y función, el autobús se puede dividir en:

1) autobús en chip

Es un bus entre los circuitos unitarios dentro del chip y sirve como canal de información entre estos circuitos unitarios. Como el bus entre componentes como la ALU interna de la CPU, el conjunto de registros y el controlador.

Los buses en chip comunes incluyen: bus AMBA-(Arquitectura avanzada de bus de microcontrolador-Arquitectura avanzada de bus de microcontrolador), bus CoreConnect de IBM, etc.

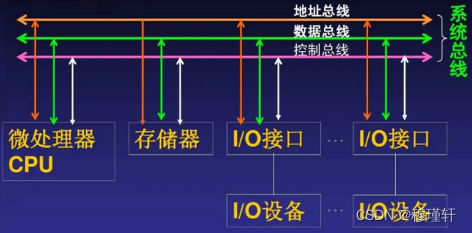

2) Bus del sistema

También llamado bus a nivel de placa, se refiere a la línea de transmisión de información entre los componentes de la CPU, la memoria principal y los dispositivos de E/S (a través de la interfaz de E/S). El bus de la computadora al que a menudo nos referimos se refiere al bus del sistema. El bus del sistema es un canal de información que conecta varias placas enchufables en un sistema multiprocesador y un sistema de supercomputadora de alto rendimiento, y se utiliza para soportar el procesamiento paralelo de múltiples CPU. El bus del sistema se puede dividir en funciones: bus de datos, bus de direcciones y bus de control.

Bus de datos: utilizado para transmitir información de datos;

Bus de direcciones: utilizado para transmitir información de direcciones emitida por la CPU;

Bus de control: transmite señales de control, señales de temporización e información de estado, etc.

3) Autobuses locales

El bus local se refiere a la ruta común que conecta cada módulo principal de la placa base en la placa de circuito impreso. Hay varias ranuras dispuestas una al lado de la otra en la placa base del sistema informático, que es la ranura de expansión del bus local.

Los buses locales implementados actualmente se pueden dividir en buses locales dedicados, buses locales VESA y buses locales PCI.

4) Bus externo

También conocido como bus de comunicación, se utiliza para la comunicación entre sistemas informáticos y sistemas, sistemas informáticos y dispositivos externos, como impresoras, dispositivos de disco, sistemas informáticos e instrumentos.

Los más comunes son USB (Bus serie universal-Bus serie universal), SATA (Accesorio de tecnología avanzada serie-Accesorio de tecnología avanzada serie), SPI (Interfaz periférica serie-Interfaz periférica serie), I2C (Circuito interintegrado-bus serie de dos hilos), UART (Receptor/transmisor asíncrono universal-Transmisor receptor asíncrono universal).

3.1.7.2, índice de rendimiento del bus

Antes de comprender los indicadores de rendimiento del bus, primero comprendamos lo que se denomina frecuencia de reloj, ciclo de reloj, ciclo de máquina y ciclo de instrucción.

-

Frecuencia de reloj

Las computadoras contemporáneas generalmente usan un oscilador de cristal de cuarzo (conocido como oscilador de cristal, generalmente determinado por la placa base) para convertir nuestra corriente alterna en una señal de reloj precisa y estable, y nuestra frecuencia de reloj es la cantidad de veces que el oscilador de cristal oscila en un segundo, generalmente en MHz o GHz .

-

ciclo de reloj

El ciclo de reloj es el recíproco de la frecuencia principal, a veces llamado latido (pulso), es decir, un pulso representa un ciclo de reloj. Es la unidad de tiempo más básica y más pequeña en una computadora , y la computadora solo puede completar una "microoperación" o varias microoperaciones compatibles en un ciclo de reloj.

Por ejemplo: el período de reloj de 1 GHz es f = 1/1 GHz = 1 ns, luego la frecuencia turbo es de 3,2 GHz y el período de reloj es de 0,3125 ns.

-

ciclo de la máquina

En una computadora, para facilitar la gestión, el proceso de ejecución de una instrucción a menudo se divide en varias etapas (como buscar, decodificar, ejecutar, etc.), y cada etapa completa una operación básica. El tiempo requerido para completar una operación básica se llama ciclo de máquina. En general, un ciclo de máquina se compone de varios ciclos de reloj (el ciclo de máquina se especifica artificialmente y en realidad es la división de una etapa del proceso de ejecución de instrucciones).

-

ciclo de instrucción

El tiempo total requerido para ejecutar una instrucción.

1) El ciclo de transmisión del bus

El tiempo requerido para la operación de un autobús, y este tiempo puede ser de N ciclos de reloj.

2) La frecuencia de operación del bus

La frecuencia de operación del bus es el recíproco del ciclo del bus. Es decir, la frecuencia de trabajo del bus = frecuencia de reloj/N.

3) Ancho del bus

El ancho de bus, también conocido como ancho de bits del bus, es el número de bits de datos que se pueden transmitir en el bus al mismo tiempo, es decir, el número de las llamadas señales de datos de 8 bits, 16 bits, 32 bits o 64 bits.

4) Ancho de banda del bus

El ancho de banda del bus se refiere a la velocidad de transmisión de datos del bus, es decir, la cantidad de bits de datos que se pueden transmitir en el bus por unidad de tiempo, generalmente medido por la cantidad de bytes de información transmitida por segundo, y la unidad se puede expresar en (B/s). Ancho de banda del bus = frecuencia operativa del bus × (ancho del bus/8) .

Nota: La razón para dividir por 8 es que la unidad de ancho de banda está representada por (B/s), "B" significa Byte-byte, 1Byte=8bit.

Por ejemplo: suponiendo que un bus del sistema transmite 4 bytes de información en paralelo en un ciclo de bus, un ciclo de bus ocupa 2 ciclos de reloj y la frecuencia de reloj del bus es de 20 MHz, ¿cuál es el ancho de banda del bus?

El ciclo de transmisión del bus =

Ancho de banda del bus = frecuencia de operación del bus × (ancho del bus/8) =

3.3 Tablero principal

3.3.1 ¿Qué es una placa base?

La placa base es uno de los componentes más básicos e importantes de una computadora. La placa base es generalmente una placa de circuito impreso PCB rectangular, en la que se instalan los sistemas de circuitos principales que componen la computadora.Generalmente, hay chips BIOS, chips de control de E/S, interfaces (teclado, COM, USB, MIDI, IDE, SATA, etc.), conectores de luces indicadoras, ranuras de expansión (ranuras de memoria, ranuras PCI, ranuras AGP) y otros componentes.

El núcleo de la placa base es el conjunto de chips de la placa base, que determina las especificaciones, el rendimiento y las funciones generales de la placa base.

Conjuntos de chips Intel: serie H (placas base de gama baja), serie B (gama media), serie Z (gama alta);

Conjuntos de chips AMD: serie A (gama baja), serie B (gama media), serie X (gama alta), TRX40 (gama superior);

3.3.2 Introducción a la estructura del conjunto de chips - Origen del conjunto de chips

Anteriormente aprendimos sobre el historial de desarrollo de la CPU.A principios de la era del procesador 4004, las funciones del procesador eran relativamente simples, principalmente para expandir las funciones informáticas básicas del procesador;

En 1972, Intel lanzó el microprocesador 8008. Intel equipó este microprocesador con un chip muy rico, que incluía una serie de conjuntos de chips como el controlador de sistema 8228/8238, el controlador DMA programable 8257 y el controlador de interrupción 8259. También adoptó la tecnología de instrucción del procesador por primera vez;

En 1978, Intel lanzó el primer microprocesador de 16 bits, el 8086, que es el creador de la arquitectura x86, más tarde, en el procesador 80186, Intel integró el controlador DMA dentro del procesador;

En 1982, se lanzó el procesador 80286 y su bus de direcciones se amplió a 24 bits;

En 1985, Intel lanzó el primer procesador 80386 X86 de 32 bits, cuya característica más importante es el uso de un bus de direcciones de 32 bits para admitir un máximo de 4 GB de memoria;

En 1989, Intel lanzó el procesador 80486. El chipset y el procesador han sufrido grandes cambios en la lógica de diseño del hardware, el primer nivel de caché apareció en el 80486, e Intel también integró la FPU (unidad de punto flotante);

Con la apertura de la era 486, Intel comenzó a ingresar al campo de los conjuntos de chips y lanzó el primer conjunto de chips en la historia de Intel, a saber, la serie Intel 420. Su primer producto se llama 420TX, y también es el primer conjunto de chips proporcionado por Intel para admitir la tecnología PCI. El bus conectado al procesador es FSB (bus frontal) y la frecuencia es de 33 MHz. Admite memoria FPM (modo de página rápida, modo de página rápida), la capacidad máxima admitida es de 128 MB. El chip South Bridge que lo combina es SIO (Super I/O), que proporciona más puertos para la placa base. En este momento, aún no se ha formado formalmente una estructura completa de "North Bridge". Hasta 1993, cuando nació Intel Pentium, Intel se dio cuenta de que aunque el rendimiento del procesador era muy fuerte, no funcionaría sin un buen chipset, fue precisamente por eso que nació una generación de chipsets legendarios : los chipsets de la serie 430 .

En el conjunto de chips de la serie 430, el primer chip puente se ha convertido en dos, a saber, 82349HX North Bridge y 82371SB South Bridge . En este punto, el chipset tiene oficialmente el concepto de puentes norte y sur . El puente norte es principalmente responsable de la transmisión de datos de alta velocidad entre la memoria principal, la CPU y la tarjeta gráfica; mientras que el puente sur es responsable de la transmisión de datos entre dispositivos de baja velocidad como discos, USB y PCI .

3.3.3 Introducción a la estructura del chipset : evolución de la arquitectura del puente Norte-Sur

En 1997, Intel lanzó el Pentium II (Pentium II) y lo equipó con el conjunto de chips de la serie Intel 440, y los chips de los puentes norte y sur tuvieron que estandarizarse mucho.

En 1999, en la era de Pentium III, Intel también lanzó oficialmente el chipset Intel 810, que instaló la tarjeta gráfica integrada Intel i752 en el puente norte por primera vez, y también integró la tarjeta de red y el módulo de tarjeta de sonido AC97 en el puente sur por primera vez.

En 2000, el chip puente sur Pentium 4 se actualizó a ICH4, y el controlador de memoria del puente norte también admitía memoria DDR; en el período posterior de Pentium 4, el chip puente sur de la serie ICH6 admitía tecnología SATA;

En 2006, después de que Intel lanzara los procesadores de la serie Core 2, Intel abandonó oficialmente la memoria DDR y la hizo compatible solo con memoria DDR2. En ese momento, el controlador de memoria de los procesadores Intel todavía estaba en el chip del puente norte, que también es el popular estándar de ranura para tarjetas gráficas durante este período, lo que permite que las tarjetas gráficas tengan velocidades de transmisión de datos más rápidas;

En 2008, Intel lanzó el conjunto de chips X48. El bus frontal soporta oficialmente una velocidad de 1600 MT/s, y el soporte de memoria también puede alcanzar DDR3 1600. El conjunto de chips de esta generación de Southbridge se actualiza a ICH10 nuevamente, admite 6 interfaces SATA 3Gb/s y 12 interfaces USB 2.0. Esto también puede considerarse como la versión final de los chips Southbridge de la serie ICH;

En 2009, salieron los procesadores de la serie Core i y el puente norte también se integró en la CPU. El puente sur original también pasó a llamarse PCH (controlador de plataforma).

3.4, memoria

3.4.1, que es la memoria

La memoria se utiliza para almacenar información de la computadora.

La memoria se divide según su funcionamiento: se puede dividir en memoria de solo lectura (ROM) y memoria de acceso aleatorio (RAM).

La memoria se divide según su función: se puede dividir en memoria interna y memoria externa ;

3.4.2 Introducción a la ROM

La primera ROM es una memoria de semiconductores de estado sólido que solo puede leer los datos almacenados por adelantado. Debido a que la tecnología es inmadura, no se puede borrar ni escribir. Después de salir de fábrica, solo puede leer los datos, por lo que se llama memoria de solo lectura . La mayoría de las memorias de solo lectura están hechas de transistores de efecto MOS (campo de puerta flotante) semiconductor de óxido de metal, que pueden retener electrones durante mucho tiempo incluso cuando se apaga la alimentación, teóricamente hasta diez años o más. A menudo se usa para arrancar en computadoras (cuando la computadora está encendida, la CPU recibe energía y comienza a ejecutar instrucciones, pero debido a que acaba de encenderse, la RAM aún está vacía y no hay instrucciones que deban ejecutarse, por lo que es necesario guardar un pequeño conjunto de instrucciones llamado BIOS en la ROM, que le dice al sistema operativo cómo acceder a la unidad de disco).

En los primeros días, nuestros principales medios de almacenamiento eran el almacenamiento magnético , es decir, los discos magnéticos, que se dividían en disquetes, discos ópticos (láser irradiaba la película de aluminio en el disco óptico para grabar) y discos duros (mecánicos). Todos almacenan información en un estado diferente, por ejemplo: si el disco duro tiene un campo magnético o si el disco óptico tiene marcas grabadas para grabar 0 y 1.

Disquete (Floppy Disk) : Es el medio móvil más antiguo utilizado en las computadoras personales (PC).La lectura y escritura de los disquetes se realiza a través de disqueteras. Es por eso que todos los sistemas operativos que vemos ahora usan la unidad C como el comienzo de la partición del disco duro.

Disco óptico (Optical disc) : Inventado por el inventor estadounidense James Russell en 1965, puede almacenar información digital multimedia como varios textos, sonidos, gráficos, imágenes y animaciones. Se divide en discos no regrabables, como CD-ROM, DVD-ROM, etc.; y discos regrabables, como CD-RW, DVD-RAM, etc. Un disco de 12 cm puede almacenar unos 680 MB de datos.

Unidad de disco duro (mecánica) (HDD para abreviar) : el nombre completo es disco duro Winchester, que consiste en uno o más discos de aluminio o vidrio cubiertos con materiales ferromagnéticos.

Las primeras ROM, según diferentes métodos de escritura, incluyen principalmente:

a) ROM en modo máscara: es una memoria temprana de solo lectura, que se escribe directamente durante el proceso de producción del chip y no se puede modificar posteriormente;

b) PROM (ROM programable por una sola vez): Hay una y sólo una oportunidad de escritura, una vez escrita, no se puede modificar;

Más tarde, con el desarrollo de la tecnología, aparecieron nuevos medios de almacenamiento de semiconductores basados en ROM, tales como:

c) EPROM (ROM Programable Borrable): Puede ser de lectura o escritura. Los métodos de borrado incluyen UVEPROM (borrado ultravioleta) y E2PROM (borrado eléctrico);

d) Memoria flash (Flash Memory): una memoria flash. En la actualidad, las placas base de la mayoría de las microcomputadoras utilizan memorias flash para almacenar programas BIOS . Nuestras unidades de estado sólido (SSD), tarjetas SD, discos U, etc.

Tanto la EPROM como la memoria flash se pueden borrar, lo que no se ajusta al nombre de ROM, pero debido a que se deriva de la tecnología de ROM, parte del nombre original continúa.

3.4.3 La diferencia entre disco duro mecánico y disco duro de estado sólido

Los discos duros mecánicos no son memorias flash, utilizan discos magnéticos para almacenar datos. Al igual que los discos utilizados en el gramófono antiguo que vimos en los dramas de televisión, excepto que el fonógrafo tiene solo un cabezal magnético, mientras que el disco duro tiene dos cabezales magnéticos superior e inferior, y el plato gira a gran velocidad entre los dos cabezales magnéticos. Las unidades de estado sólido utilizan partículas de memoria flash para el almacenamiento de datos.

-

disco duro mecanico

El disco duro fue desarrollado por IBM en los primeros días. En 1980, dos ex empleados de IBM fundaron la empresa y desarrollaron un disco duro de 5 MB de 5,25 pulgadas. Esta empresa es Seagate.

El disco duro mecánico se compone principalmente de platos de disco, cabezales magnéticos, ejes y ejes de transmisión, etc., y los datos se almacenan en los platos de disco.

Lado del disco (Lado) : El disco está compuesto por una pila de discos. Cada disco consta de dos discos. Habrá una cabeza magnética en los discos superior e inferior para lectura y escritura;

Pistas (Track) : Cada disco se dividirá en múltiples círculos concéntricos alrededor del centro del círculo, estos círculos concéntricos se denominan pistas, las pistas se numeran secuencialmente desde 0 de afuera hacia adentro, y cada disco del disco duro tiene de 300 a 1 024 pistas.

Cilindros : un cilindro tridimensional compuesto de pistas en la misma posición en todos los platos se llama cilindro, por lo que el número de cilindros es igual al número de pistas.

Sector : cada círculo concéntrico en el disco es una pista, y cada pista se divide en varios segmentos de arco, y cada segmento de arco es un sector. El tamaño de cada sector se fija en 512 Byte. Un sector es también la unidad de almacenamiento más pequeña de un disco.

Clúster (Cluster) : Varios sectores físicamente adyacentes se denominan clúster. La unidad básica del sistema operativo para leer y escribir en el disco es el sector, y la unidad básica del sistema de archivos es el clúster. Los clústeres generalmente tienen este tipo de tamaños 4K, 8K, 16K, 32K, 64K, etc. Cuanto más grande sea el clúster, mejor será el rendimiento del almacenamiento, pero el espacio se desperdicia seriamente. El tamaño del clúster del sistema de archivos en formato NTFS es 4K.

Por ejemplo: el tamaño real del siguiente archivo es de 8,75 KB y el espacio ocupado es de 12,0 KB, es decir, tres clústeres.

La fórmula de cálculo de la capacidad del disco: capacidad = número de discos × número de sectores (cilindros) × número de bytes en un sector (512 bytes);

Disk /dev/sda: 299.0 GB, 298999349248 bytes

255 heads, 63 sectors/track, 36351 cylinders

Units = cylinders of 16065 * 512 = 8225280 bytes

注:255 heads(磁头)就有255个盘面

容量=255*36351*63*512=36351*8225280=298999349248,即299GB

El disco duro mecánico está conectado a la placa base de la computadora a través de la interfaz.Las interfaces de disco duro mecánico comunes son:

1) Interfaz IDE (Electrónica de unidad integrada, unidad electrónica integrada)

La interfaz de disco duro IDE, también conocida como "disco duro ATA" o "disco duro PATA", es la interfaz principal de los primeros discos duros mecánicos. ATA en sí admite serie y paralelo. La velocidad teórica que puede alcanzar el ATA/133 paralelo más rápido es de 133 MB/s. Sin embargo, actualmente casi no hay discos duros con esta interfaz en el mercado, y la velocidad es lenta y no admite intercambio en caliente.

2) Conector SATA (ATA serie, ATA serie)

La velocidad SATA es más rápida que la interfaz IDE. SATA no depende del ancho de banda del bus del sistema, pero tiene una frecuencia de reloj incorporada y admite conexión en caliente. El ancho de banda de transmisión teórico de la interfaz SATA3.0 es de 6 Gbps. En la actualidad, la mayoría de las interfaces mecánicas de disco duro del mercado son SATA.

3) interfaz SCSI (interfaz de sistema informático pequeño, interfaz de sistema informático pequeño)

SCSI se usa ampliamente en servidores y tiene las ventajas de una amplia gama de aplicaciones, multitarea, gran ancho de banda, bajo uso de CPU e intercambio en caliente, etc., y la velocidad de transmisión teórica alcanza los 320 MB/s.

4) Interfaz SAS (SCSI conectado en serie, SCSI en serie)

SAS es una nueva generación de tecnología SCSI, es lo mismo que el popular disco duro Serial ATA (SATA), utiliza tecnología serial para obtener una mayor velocidad de transmisión.

-

SSD

El disco de estado sólido (Disco de estado sólido) es un disco duro hecho de conjuntos de chips de almacenamiento electrónico de estado sólido. Hay dos tipos de medios de almacenamiento para discos duros de estado sólido. Uno usa memoria flash (chips FLASH) como medio de almacenamiento y el otro usa DRAM como medio de almacenamiento. En la actualidad, el disco duro de estado sólido que usa memoria flash como medio de almacenamiento se usa principalmente más.

La velocidad de las unidades de estado sólido SATA3.0 comunes es de aproximadamente 500 MB/S, mientras que el rendimiento de lectura de las unidades de disco duro mecánicas en esta etapa oscila entre 100 MB/S y 200 MB/S, mientras que el rendimiento máximo de lectura de las unidades de estado sólido M.2 que utilizan el protocolo NVMe puede alcanzar más de 3000 MB/S.

Nota: disco U, unidad flash USB de nombre completo, nombre en inglés "disco flash USB".

El nombre del disco U se originó a partir de un nuevo tipo de dispositivo de almacenamiento producido por Netac Technology, llamado "disco U", que está conectado con una interfaz USB. Dado que Netac ha registrado patentes para equipos con tecnologías similares producidos más tarde, ya no pueden llamarse "discos USB", sino que pasan a llamarse "discos U" con sonidos homofónicos.

Entonces algunas personas tendrán dudas, ¿por qué nuestro disco U habitual se siente más lento que el disco duro mecánico? Aunque el disco U usa partículas de memoria flash, a menudo solo hay dos canales de memoria flash y todavía hay una brecha en el rendimiento de datos de la interfaz del disco U.

3.4.4 RAM - Introducción

Memoria RAM de acceso aleatorio: se refiere a la memoria de acceso aleatorio (memoria de acceso aleatorio, RAM), que intercambia datos directamente con la memoria interna de la CPU. Se puede leer y escribir en cualquier momento, y la velocidad es muy rápida. Por lo general, se utiliza como un medio de almacenamiento de datos temporal a corto plazo para sistemas operativos u otros programas en ejecución. La computadora primero carga el programa o documento solicitado por el usuario en la memoria del disco duro y luego accede a la información de la memoria. La memoria de acceso aleatorio accede a los datos de acuerdo con las direcciones, en lugar de acceder a los datos secuencialmente, principalmente para resolver el problema de la falta de coincidencia de las velocidades de la CPU y el disco duro.

La memoria de acceso aleatorio se puede dividir en RAM bipolar y RAM MOS según el proceso de fabricación.

Nota: Los tubos MOS se tocarán en circuitos lógicos, y los tubos MOS son más prácticos para dispositivos de baja potencia que los triodos. El triodo está controlado por corriente y puede soportar alto voltaje y alta corriente, mientras que el tubo MOS está controlado por voltaje y tiene un bajo consumo de energía. Circuitos comunes de la RAM bipolar: lógica TTL, lógica ECL, lógica I2L.

-

RAM estática (SRAM)

SRAM : la RAM estática utiliza un flip-flop compuesto por 6 transistores MOS como circuito básico. Tiene una integración moderada, un consumo de energía moderado y una velocidad rápida. No necesita actualizar el circuito y la información se perderá solo cuando se apague la alimentación;

-

RAM dinámica (DRAM)

DRAM : la RAM dinámica almacena información según si la capacitancia de la puerta del transistor MOS está cargada. El circuito de la unidad básica generalmente se compone de cuatro transistores, tres transistores y un solo transistor. Tres transistores y un solo transistor son los más utilizados. Sin embargo, debido a la corriente de fuga en este circuito, la carga en el capacitor de la puerta se liberará después de un cierto período de tiempo, por lo que el circuito debe actualizarse (carga regular cada 1ms-3ms), pero su integración es alta, el consumo de energía es bajo y el costo es menor que SRAM. Por lo general, se usa para hacer chips de memoria en tarjetas de memoria.

DRAM tiene principalmente los siguientes tipos:

1) DRAM sincrónica (SDRAM): la frecuencia de DRAM está sincronizada con la frecuencia del bus de la CPU, lo que mejora en gran medida la eficiencia de la transmisión de datos, por lo que se denomina DRAM sincrónica.

La memoria SDRAM tiene los siguientes tipos: PC66/100/133150/166, la frecuencia central (o frecuencia equivalente) es 66MHz, 100Mz, 133MHz, 150MHz, 166MHz.

El ancho de banda máximo de transmisión de datos de una sola memoria SDRAM es 166 MHz × 64 bits ÷ 8 = 1,3 GB/s.

2) Rambus DRAM (RDRAM): proporciona velocidades de transferencia de datos muy altas utilizando varios mecanismos de aceleración en el estrecho bus de memoria de la CPU. RDRAM se ejecuta en un circuito en serie, lo que significa que todas las ranuras de memoria deben llenarse con circuitos para cerrar y acceder a la memoria.

3) SDRAM de doble velocidad de datos (DDR SDRAM) : la SDRAM realiza funciones de lectura/escritura en el flanco ascendente de cada reloj del sistema, mientras que la memoria de acceso aleatorio dinámico síncrono de doble velocidad (SDRAM de doble velocidad de datos, conocida como memoria DDR) realiza funciones de lectura/escritura en cada flanco ascendente y descendente del reloj del sistema, lo que duplica efectivamente el rendimiento de la memoria y mejora en gran medida el rendimiento general .

Cuando se trata de tecnología de memoria, primero mencionaremos DDR, que es una tecnología de memoria convencional ampliamente utilizada en computadoras de escritorio, portátiles, servidores y otros sistemas. La memoria DDR convencional actual es: DDR3 y DDR4.

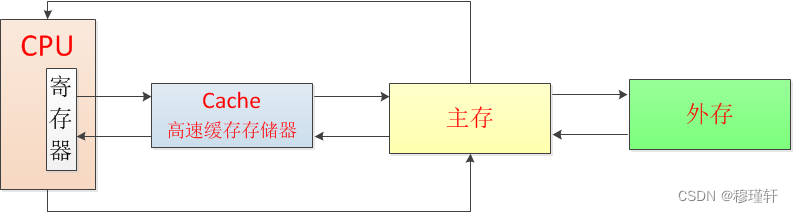

4) DRAM de caché (CDRAM): una memoria DRAM especial con memoria caché en chip (SRAM) y un búfer de DRAM de alta velocidad, que es lo que a menudo llamamos DRAM de caché . Cuando la CPU escribe o lee datos en la memoria, estos datos también se almacenan en la memoria caché. Cuando la CPU necesita los datos nuevamente, la CPU lee los datos del caché en lugar de acceder a la memoria más lenta.

Caché DRAM: caché de nivel 1 (caché L1), caché de nivel 2 (caché L2), caché de nivel 3 (caché L3).

Caché: Es un búfer para el intercambio de datos. Cuando una pieza de hardware quiere leer datos, primero buscará los datos requeridos en el caché. Si los encuentra, los ejecutará directamente. Si no los encuentra, los encontrará en la memoria. El caché se ejecuta mucho más rápido que la memoria, principalmente para resolver el problema de la falta de coincidencia de velocidad entre la CPU y la memoria principal.

La memoria caché se divide actualmente en: caché L1, caché L2 y caché L3. La velocidad de cada capa disminuye en órdenes de magnitud y la capacidad es cada vez mayor.

Cada núcleo tiene su propio caché L1.Hay dos tipos de caché L1: caché de instrucciones L1 (L1-icache) y caché de datos L1 (L1-dcache). El caché de instrucciones L1 se usa para almacenar instrucciones decodificadas, y el caché de datos L1 se usa para almacenar datos a los que se accede con mucha frecuencia;

La caché L2 se utiliza para almacenar datos de memoria utilizados recientemente. Hablando más estrictamente, almacena datos que probablemente serán utilizados por la CPU en el futuro;

Cada núcleo de la mayoría de las CPU multinúcleo tiene su propia caché L2, pero también hay diseños en los que varios núcleos comparten la caché L2. En cualquier caso, L1 es privado para cada núcleo (pero compartido por varios subprocesos dentro de un núcleo).

3.4.5 Historial de desarrollo de la memoria DDR

En 1961, IBM estableció el Centro de Investigación Thomas Watson orientado a los semiconductores en el estado de Nueva York. Fairchild era el proveedor de dispositivos de semiconductores de IBM en ese momento. Gordon Moore de Fairchild predijo que la cantidad de transistores que se pueden acomodar en un circuito integrado se duplicará cada 18 meses, y su rendimiento también se duplicará. Esta es la famosa Ley de Moore;

En 1966, en el Centro de Investigación IBM Thomas Watson, el Dr. Robert Dennard, que en ese momento tenía 34 años, propuso la idea de usar transistores semiconductores de óxido metálico (MOS) para fabricar chips de memoria. El principio es usar si el capacitor almacena carga para almacenar información, y solo se necesita un transistor y un capacitor por cada 1 bit, y esta práctica se ha usado hasta ahora;

Con el rápido ascenso de las empresas de semiconductores como Texas Instruments y Motorola, Fairchild Semiconductor fue fundada por Robert Noyce en 1957. Debido a varias razones, su estado fue reemplazado gradualmente por Texas Instruments;

Hasta agosto de 1968, el niño hada Robert Noyce convenció a Gordon Moore, el jefe del departamento de I + D, de renunciar y crear una nueva empresa. Al principio, llamó a la empresa "Moore-Noyce Electronics Company", pero se sintió incómodo, por lo que cambió el nombre a Intel (Intel).

En abril de 1969, Intel lanzó el C3101, un chip de memoria estática de acceso aleatorio (SRAM) con una capacidad de 64 bits, que solo podía almacenar 8 letras en inglés.

Pronto, Jerry Sanders, uno de los directores de Fairchild, también dejó la empresa y fundó AMD (Advanced Micro Devices, AMD) con otras 7 personas. Y LJ Sevin (experto en transistores de efecto de campo MOS), ingeniero jefe del Centro de Semiconductores de Texas Instruments, hizo que un grupo de colegas renunciara y estableció Mostek (Mostek).

En julio de 1969, Intel Corporation lanzó el chip SRAM C1101 de 256 bits, que es la primera memoria SRAM de gran capacidad del mundo.

En octubre de 1970, se lanzó el primer chip C1103 de memoria dinámica de acceso aleatorio (DRAM), con una capacidad de solo 1Kb;

En 1973, Mostek desarrolló el chip MK4096 de 16 pines, que aumentó la capacidad a 4 K. En ese momento, la memoria fabricada por Texas Instruments, Intel y Motorola era de 22 pines;

Aunque Intel ocupaba el 82,9% de la cuota de mercado mundial de DRAM en 1974, Mostek la superó rápidamente.En ese momento, Intel se centró en el desarrollo del procesador 8080 y logró un gran éxito en el mercado de las microcomputadoras;

En 1978, cuatro ex empleados de Mostek fundaron Micron en un sótano oscuro;

En 1980, el proyecto "VLSI" establecido conjuntamente por Fujitsu, Hitachi, Mitsubishi, NEC y Toshiba logró un gran avance. Varios tipos de dispositivos de copiado de placas y dispositivos de grabado en seco que utilizan rayos ultravioleta, rayos X y haces de electrones han logrado la producción en masa de DRAM.Debido al vertido masivo de DRAM baratas en Japón, Micron se vio obligado a despedir empleados, e incluso Intel sufrió grandes pérdidas y se vio obligado a anunciar su retiro del mercado de DRAM;

En 1982, Japón se convirtió en el mayor productor de DRAM del mundo; en ese momento, el mercado estadounidense de semiconductores fue derrotado por Japón. Al final, Micron obtuvo la licencia de la tecnología DRAM de 64K para Samsung de Corea del Sur, luego Texas Instruments firmó un acuerdo de OEM con Hyundai de Corea del Sur para reducir los costos de fabricación, y Texas Instruments proporcionó el flujo de proceso de DRAM de 64K;

En 1990, Samsung estableció 26 centros de I + D. Dos años más tarde, Samsung tomó la delantera en romper las barreras técnicas y lanzó el primer producto DRAM de 64 millones del mundo;

En 1996, Samsung desarrolló la primera DRAM de 1GB del mundo y ocupó el primer lugar en el mundo, mientras que Hyundai Electronics ocupó el tercer lugar;

En 1999, Hyundai Semiconductor de Corea del Sur, que ocupó el tercer lugar, se fusionó con LG; en el mismo año, Infineon Technologies se estableció formalmente en Munich, Alemania, y su predecesor fue el departamento de semiconductores de Siemens Group;

En 2001, Hyundai Group completó la división y cambió el nombre de la empresa a Hynix Semiconductor Inc. En el mismo año, Micron completó la adquisición del negocio DRAM de Texas Instruments, en ese momento, Samsung de Corea del Sur, Micron de Estados Unidos, Hynix de Corea del Sur e Infineon de Alemania representaban más del 80% del mercado de DRAM, en el mismo año, Samsung Electronics de Corea del Sur desarrolló la memoria DDR2;

En 2004, las tarjetas de memoria DDR2 comenzaron a producirse en masa y gradualmente entraron en el campo de visión de todos;

En 2005, Samsung Electronics de Corea del Sur anunció que había desarrollado la primera memoria DDR3 del mundo;

En 2006, se lanzaron las tarjetas de memoria DDR3;

En 2008, Infineon también se retiró del mercado de DRAM debido a la crisis financiera mundial, en ese momento, los tres principales proveedores de Samsung, Micron y Hynix casi tomaron la gran mayoría del mercado mundial de DRAM;

En enero de 2011, Samsung Electronics de Corea del Sur anunció la finalización de la fabricación y prueba de los módulos DRAM DDR4;

En 2012, SK Group, el tercer chaebol más grande de Corea del Sur, anunció la adquisición del 21,05% de las acciones de Hynix y cambió el nombre de Hynix a SK Hynix (SK Hynix);

En 2014, DDR4 comenzó a ingresar al mercado;

En 2017, se estableció un nuevo subcomité de nitruro de galio (GaN) y carburo de silicio (SiC);

En julio de 2020, la Asociación JEDEC anunció oficialmente el estándar DDR5; en octubre del mismo año, SK hynix anunció que lanzó oficialmente la primera memoria DDR5 del mundo;

En 2021, la cuota de mercado de DRAM de Samsung será del 43,6 %, la cuota de mercado de SK Hynix será del 27,7 % y la cuota de mercado de Micron será del 22,8 %. Solo los tres gigantes ocuparán el 96,1 % del mercado mundial de DRAM.

En 2022, DDR5 ingresará gradualmente al mercado.

3.4.6 Introducción a la memoria de la serie DDR

La siguiente imagen muestra los parámetros de la tarjeta de memoria portátil que compré cuando estaba en la universidad en 2012, y sigue siendo un luchador poderoso.

Antes de comprender la tarjeta de memoria DDR, primero comprendamos algunos conceptos relacionados:

-

Frecuencia del núcleo DDR

La frecuencia del núcleo DDR es la frecuencia de actualización de la matriz de celdas de memoria (Memory Cell Array, es decir, el capacitor interno), que es la frecuencia de funcionamiento real de la memoria. Limitada por el límite de los materiales físicos, la frecuencia central ha estado oscilando entre 133 y 200 MHz.

-

Frecuencia operativa DDR

Dado que la memoria DDR puede transmitir datos tanto en los flancos ascendentes como descendentes del pulso, la frecuencia operativa de DDR es el doble de la frecuencia central.

La frecuencia central es la frecuencia de actualización del arreglo de celdas de memoria (arreglo de celdas de memoria, es decir, el capacitor interno), que es la frecuencia operativa real de la memoria; la frecuencia de reloj es la frecuencia de transmisión del búfer de E/S (búfer de entrada/salida); y la frecuencia de transmisión de datos efectiva se refiere a la frecuencia de transmisión de datos (es decir, la frecuencia equivalente)

-

Frecuencia equivalente de DDR

La frecuencia equivalente y la frecuencia nominal son un concepto. Debido a la aplicación de la tecnología de captación previa, la transmisión de datos se realiza tanto en los flancos ascendentes como descendentes. En el caso de una transmisión equivalente a un solo flanco, la frecuencia equivalente (frecuencia nominal) = frecuencia central × factor de multiplicación.

El nombre de las tarjetas de memoria que solemos ver se basa en la frecuencia nominal de DDR.

NOTA: El factor de multiplicación se explicará más adelante.

-

temporización de la memoria

1) columna de memoria CL que aborda el tiempo de respuesta del pulso (tiempo de retardo);

2) tiempo de retardo tRCD para transferir la dirección de la fila de memoria a la dirección de la columna;

3) tRP: el tiempo requerido para precargar el pulso estroboscópico de la dirección de la fila de memoria;

4) retardo estroboscópico de dirección de fila de memoria tRAS;

Por ejemplo:

Calculemos el tiempo de retardo CL de DDR1~4:

DDR-400 3-3-3-8: 3*2/400=15 ns

DDR2-800 6-6-6-18: 6*2/800=15 ns

DDR3-1333 9-9-9-24: 9*2/1333 = 13,5 ns

DDR4-2133 15-15-15-35: 15*2/2133=14 ns

Nota: La razón para multiplicar por 2 es que la memoria DDR transmite datos dos veces en un ciclo de reloj y se puede obtener un tiempo de retraso para cada ciclo de reloj.

El direccionamiento de una fila y una columna debe tener una intersección, que puede determinar de forma única una dirección de memoria. Generalmente, a la misma frecuencia, cuanto menor sea el valor de CL, mejor será el rendimiento del módulo de memoria (más fácil será el overclocking), y cuanto mayor sea la frecuencia de la memoria a diferentes frecuencias, mejor será el rendimiento.

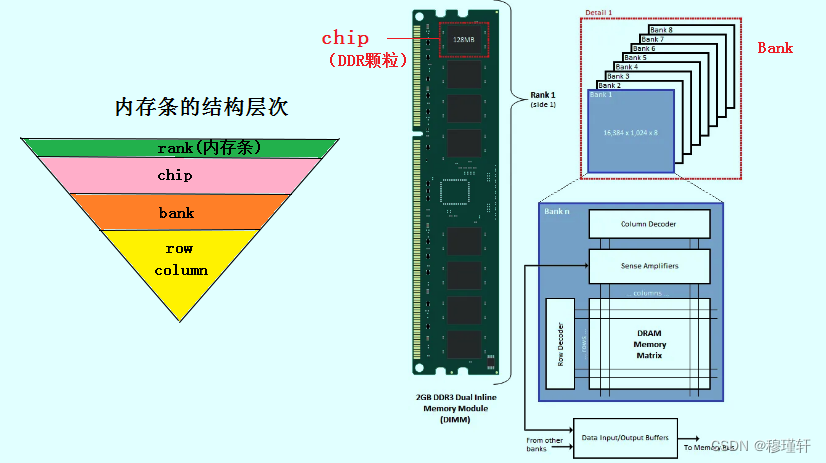

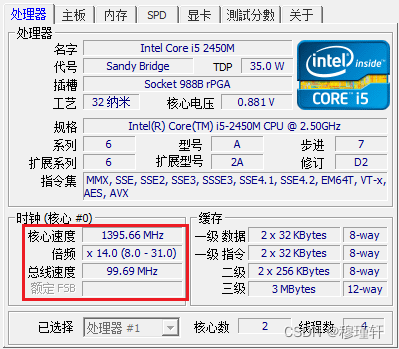

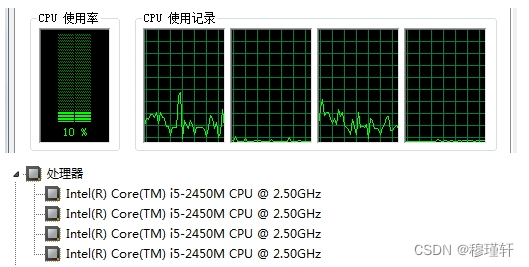

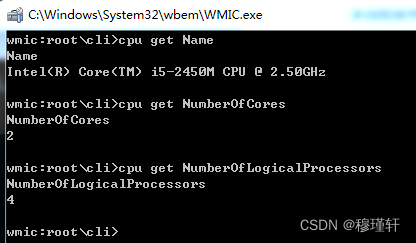

-