Der Originaltext stammt aus meinem persönlichen Blog .

1. Voraussetzungen

Der Server ist ein GPU-Server. Klicken Sie hier , um zu dem von mir verwendeten GPU-Server zu springen. Ich habe Whisper mit einer NVIDIA A 100-Grafikkarte und 4 GB Videospeicher gebaut.

Die Python-Version sollte zwischen 3.8 und 3.11 liegen.

Geben Sie den folgenden Befehl ein, um die verwendete Python-Version zu überprüfen.

python3 -V

2. Installieren Sie Anaconda

Warum Anaconda installieren?

Um Versionskonflikte von Bibliotheken, die von verschiedenen Projekten verwendet werden, zu reduzieren, können wir Anaconda verwenden, um eine virtuelle Python-Umgebung zu erstellen.

Laden Sie das Anaconda-Installationsskript herunter

Suchen Sie das Installationsprogramm, das zu Ihrem System passt.

Nachdem der Download abgeschlossen ist, können wir das Skript direkt ausführen.

bash 脚本.sh

Sie können das Skript auch folgendermaßen ausführen.

chmod +x 脚本.sh

./脚本.sh

Nach Abschluss der Installation müssen Sie erneut eine Verbindung zu SSH herstellen.

Um zu überprüfen, ob die Installation erfolgreich war, können Sie den folgenden Befehl verwenden.

conda -V

3. Installieren Sie FFmpeg

apt install ffmpeg

Nach Eingabe ffmpegder Eingabetaste wird eine Meldung angezeigt, die besagt, dass die Installation erfolgreich war.

4. Installieren Sie den Grafikkartentreiber

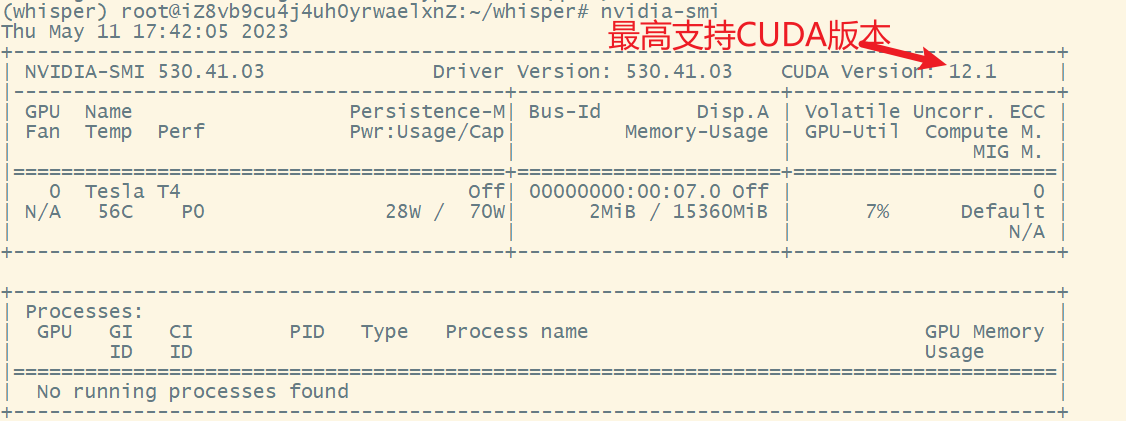

Geben Sie zunächst ein nvidia-smi, um die Grafikkarteninformationen anzuzeigen. Wenn eine Eingabeaufforderung angezeigt wird, bedeutet dies, dass der Grafikkartentreiber installiert wurde.

Wenn der Grafikkartentreiber nicht installiert wurde, gibt es hier zwei Installationsmethoden.

4.1. Methode 1

ubuntu-drivers devices Zeigt Grafiktreiber an, die installiert werden können

apt install nvidia-driver-530 Installieren Sie den empfohlenen Grafiktreiber

nvidia-smi Grafikkarteninformationen anzeigen

4.2. Methode 2

Gehen Sie zur NVIDIAoffiziellen Treiber-Download-Website, um den entsprechenden Grafikkartentreiber herunterzuladen.

Klicken Sie hier, um es herunterzuladen .

Einzelheiten finden Sie in diesem Artikel .

5. Installieren Sie CUDA

Die heruntergeladene CUDA-Version muss kleiner oder gleich der in nvidia-smi angezeigten CUDA-Version sein und kann nicht nach Belieben heruntergeladen werden.

Gemäß der behördlichen Anordnung installieren.

Bearbeiten Sie ~/.bashrcund fügen Sie am Ende den folgenden Befehl hinzu.

export PATH=/usr/local/cuda-12.1/bin${

PATH:+:${

PATH}}

export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:/usr/local/cuda-12.1/lib64

Hinweis: Sie müssen cuda-12.1das Obige auf die Version von CUDA ändern, die Sie selbst installiert haben.

neu laden

source ~/.bashrc

sudo ldconfig

Überprüfen Sie, ob CUDA installiert ist.

nvcc -V

Wenn während des Installationsvorgangs kein Fehler gemeldet wird, die Versionsinformationen jedoch nach Eingabe dieses Befehls nicht ausgegeben werden, ist Ihre Umgebungsvariable nicht oder falsch konfiguriert.

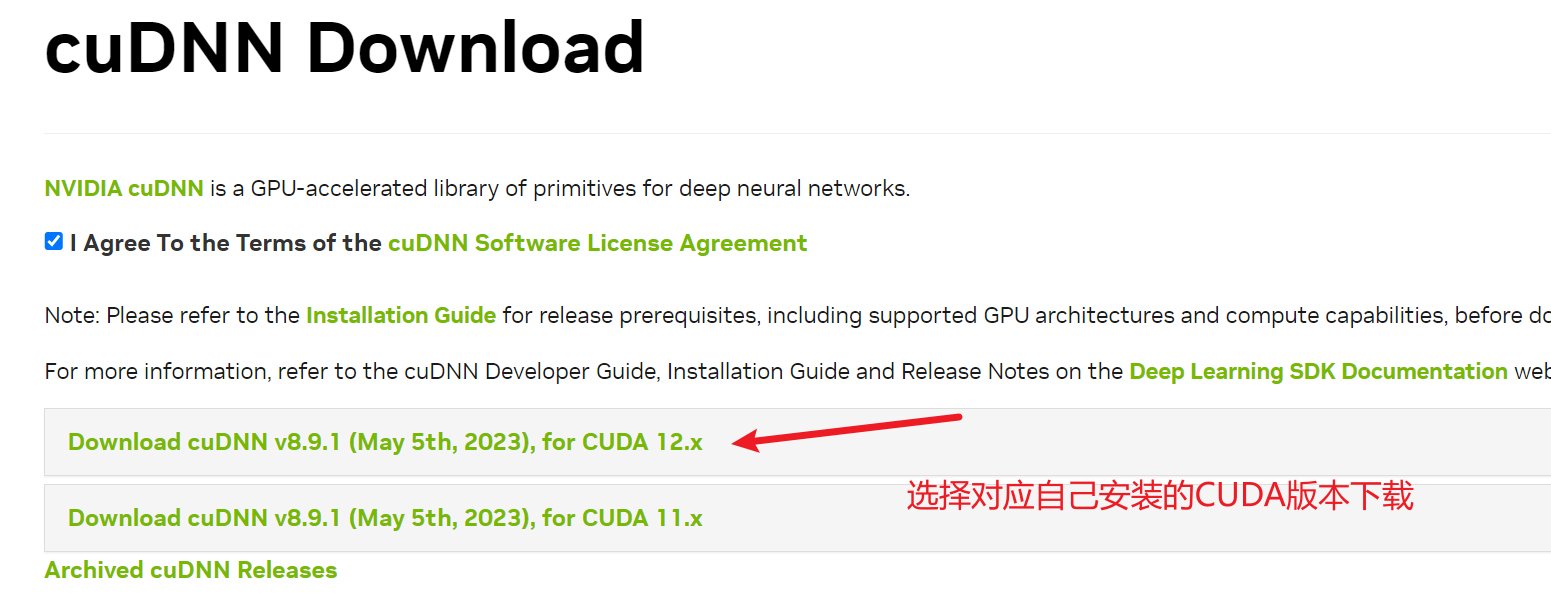

6. cuDNN installieren (optional)

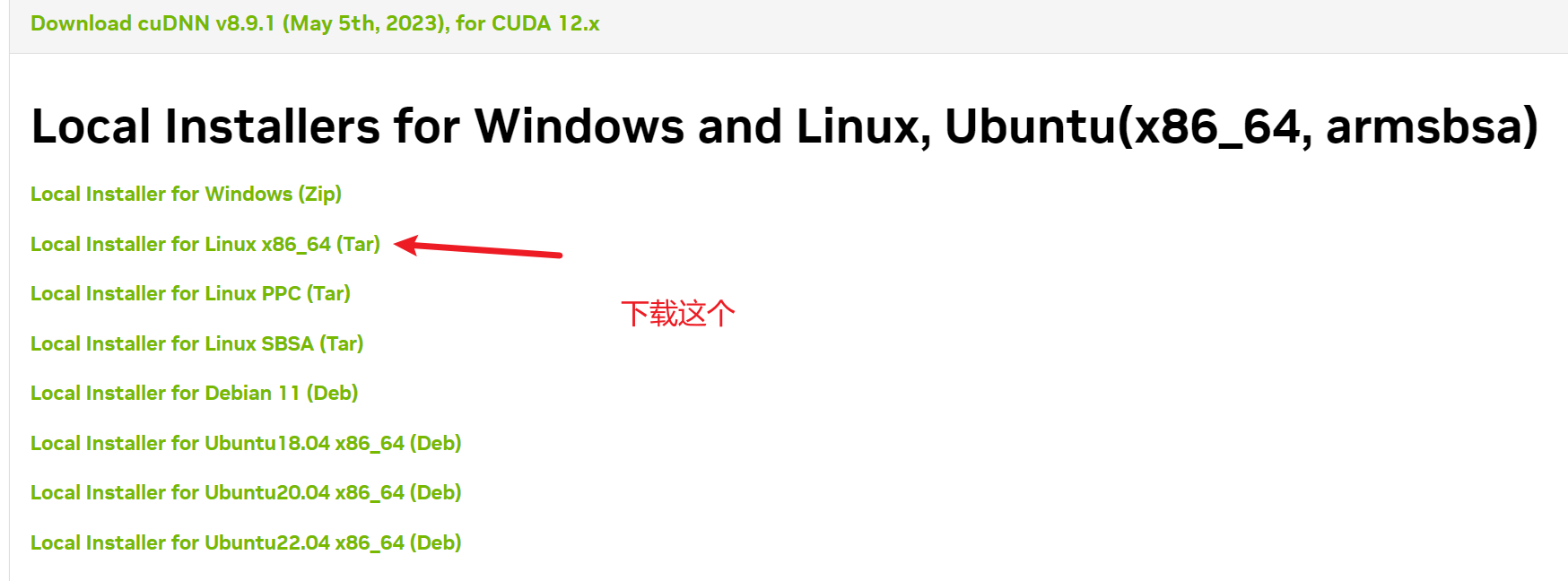

Um cuDNN herunterzuladen, müssen Sie ein NVIDIA-Konto registrieren und bestätigen, dass Sie der Community beitreten möchten. Andernfalls können Sie es nicht herunterladen. Und dieser Download muss vorher authentifiziert werden, sodass Sie ihn nicht direkt über den Dienst herunterladen können. Andernfalls ist das, was Sie herunterladen, nur eine Webseite. Wir müssen sie zuerst auf den lokalen Computer herunterladen und sie dann über den Server auf den Server hochladen rz- oder scp-Befehl.

Nachdem der Download abgeschlossen ist, extrahieren Sie ihn in das CUDA-Verzeichnis.

tar -xvf 文件名

cd 文件夾

sudo cp include/* /usr/local/cuda-12.1/include

sudo cp lib/libcudnn* /usr/local/cuda-12.1/lib64

sudo chmod a+r /usr/local/cuda-12.1/include/cudnn*

sudo chmod a+r /usr/local/cuda-12.1/lib64/libcudnn*

cat /usr/local/cuda/include/cudnn_version.h | grep CUDNN_MAJOR -A 2

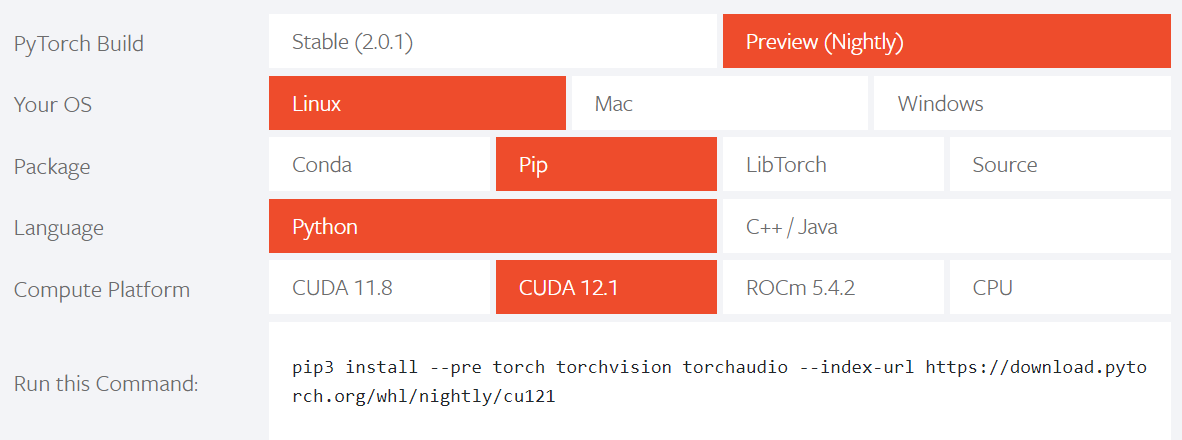

7. Installieren Sie PyTorch

Klicken Sie hier, um PyTorch herunterzuladen

Hinweis: Die installierte Version muss mit Ihrer CUDA-Version übereinstimmen.

Kopieren Sie bei der Installation einfach den offiziellen Befehl direkt.

Anschließend können wir mit dem folgenden Befehl überprüfen, ob die Installation erfolgreich war.

python

import torch

torch.__version__

torch.cuda.is_available()

Der letzte Satz ist der Schlüssel. Nur durch die Rückgabe von True kann Whisper die Grafikkarte zum Transkribieren verwenden, andernfalls nutzt es die CPU zum Transkribieren. Wenn der letzte Satz „Falsch“ zurückgibt, stimmt die in der von Ihnen installierten PyTorch-Version verwendete CUDA-Version möglicherweise nicht mit der bereits auf Ihrem Server installierten CUDA-Version überein.

8. Installieren Sie Whisper

Vor der Installation müssen Sie mit Conda eine virtuelle Umgebung erstellen.

conda create -n whisper python=3.10

Aktivieren Sie die virtuelle Umgebung.

conda activate whisper

Verlassen Sie die virtuelle Umgebung.

conda deactivate

Schauen Sie sich die virtuelle Umgebung an.

conda env list

Löschen Sie die virtuelle Umgebung.

conda remove -n whisper --all

Aktivieren Sie zunächst die virtuelle Umgebung und geben Sie dann zur Installation den folgenden Befehl ein.

pip install -U openai-whisper

Wenn kein Fehler vorliegt, geben wir den folgenden Befehl ein und wenn wir die Informationsausgabe sehen, bedeutet dies, dass die Installation erfolgreich war.

whisper -h

9. Verwendung von Whisper

Die erste Verwendung ist relativ langsam und das Modell muss heruntergeladen werden. Je größer das verwendete Modell, desto langsamer ist die Transkriptionsgeschwindigkeit und desto höher ist die Genauigkeit der Transkription. Whisper hat die höchste Erkennungsgenauigkeit für Spanisch, gefolgt von Italienisch , und dann nur Englisch, während die Erkennung von Mandarin im Mittelfeld liegt.

Hier finden Sie eine kurze Beschreibung der Verwendung von Whisper.

whisper 你要转录的音视频文件 --model large --language Chinese

Mehr Nutzung kann whisper -hzum Anzeigen verwendet werden.