:科学的知識

International Joint Conference on Artificial Intelligence (略して IJCAI) は、人工知能分野で最も重要な学術会議の 1 つで、当初は奇数年に開催されていましたが、2016 年から毎年開催されています。他の地域の人工知能会議 (「xxCAI」) と一緒に開催されることもあり、多くの場合、PRICAI (人工知能に関するパシフィック リム会議)、ECAI (人工知能に関する欧州会議) などの地域会議のために開催されます。 .

# 序文

9月。

前回の記事で、深層学習の代表格であるディープネットワークの中でもResNetネットワークを紹介しましたが、独自のスキップリンクにより、より深いネットワークを構築することが可能です。実は、タイトルの訳によると、残差ネットワークです. 実は、ネットワークで学習するのは残差です(ネットワークの出力と入力の減算が残差です). したがって、ネットワークの構築はネットワークが非常に深い場合、最初の数層が優れた機能を学習できる場合、ネットワークの最後の数層はアイデンティティマッピングと呼ばれます。つまり、入力は出力です。つまり、現在の残差ブロックには何もありません。学習し、それらの重み値はほぼ 1 に等しくなる可能性があります。

今日はもう一つの先駆的な仕事である DenseNet を紹介します. この記事は ResNet のローンチ後の別の傑作です. この記事の著者は ResNet に多少影響を受けているため、ResNet を直接ベンチマークすることも可能であると言われています. 以下に.一緒にDenseNetの素顔を紐解きましょう!

DensNet

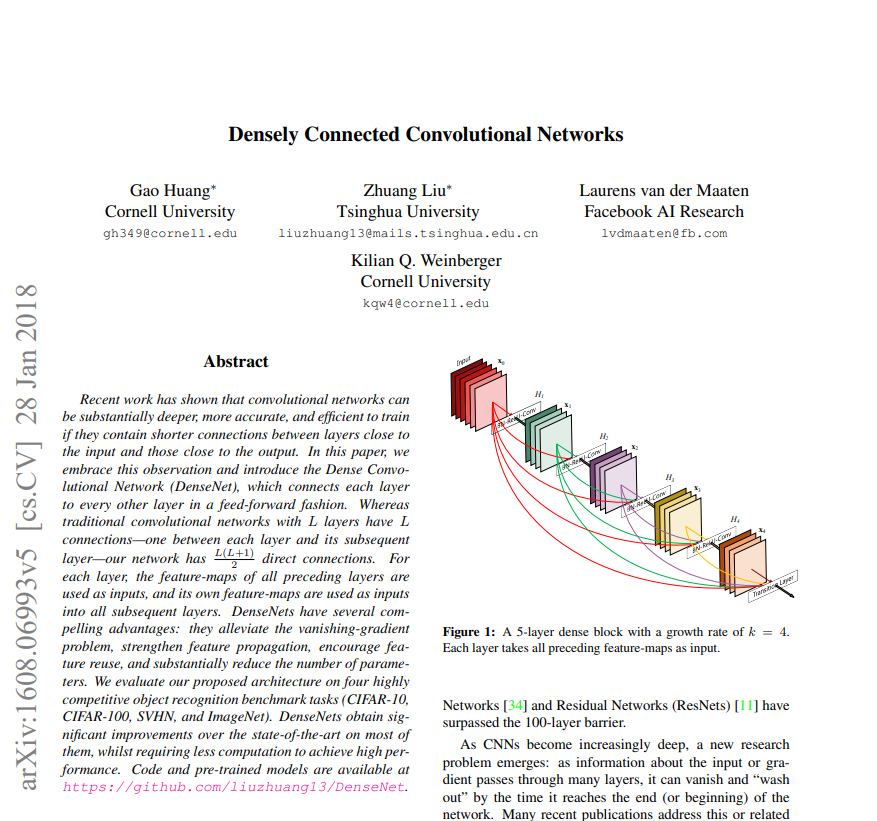

今日共有された記事のタイトルは: Densely Connected Convolutional Networksで、タイトルの翻訳は: Densely Connected Convolutional Network であり、ネットワークの提案された層はかつて複数の分類タスクを支配していました。このネットワークは ResNet と類似点があり, どちらも以前の層構造の機能を使用します. 違いは, ResNet は以前の層の入力 x のみを使用することですが, DenseNet は以前のすべての機能を使用します. そして使用方法は合計の代わりに,それはチャネル次元でのスプライシングです。

論文のスクリーンショット:

論文アドレス:https://arxiv.org/pdf/1608.06993.pdf

1.ネットワークが提案した理由

この記事で述べた理由から、私たちが主な関心事であり、その貢献がそれに続きます。この記事では、要約で次の文に言及しただけです。最近の研究では、畳み込みニューラル ネットワークに入力と出力の間のリンクが短い場合、ニューラル ネットワークはより深く、より正確で、より効率的であることが示されています。著者はこの観点を快く受け入れ、これに基づいて DenseNet を提案しました。

2. ネットワークはどのような問題を解決しますか?

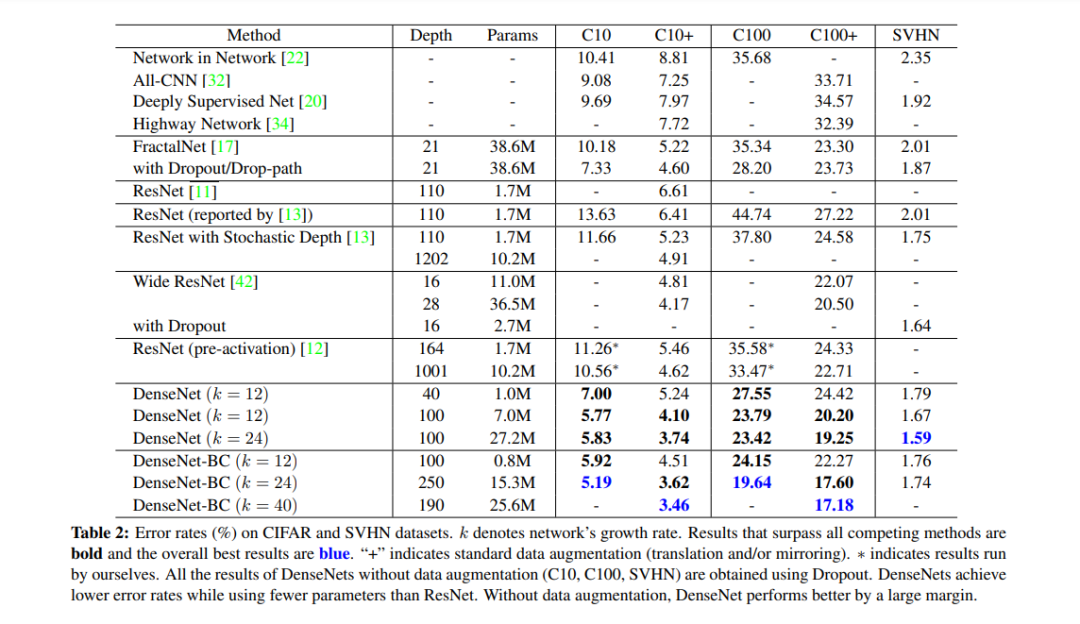

1. 勾配消失の問題を緩和する: 前の記事では、ResNet ネットワークが勾配消失の問題をある程度解決することを紹介しましたが、DenseNet は以前のすべての機能を使用するため、勾配消失の問題もある程度緩和できます。 .

2. 機能伝播の強化: 後のネットワーク レイヤーには前のすべてのレイヤーの機能が含まれているため、低レベルの機能と高レベルの機能が共存していることに相当するため、機能の伝播が強化されています。

3. 機能の再利用を促進する: 基盤となる機能が後続のネットワーク レイヤーに渡されているため、機能は再利用メカニズムを実現し、破棄されません。

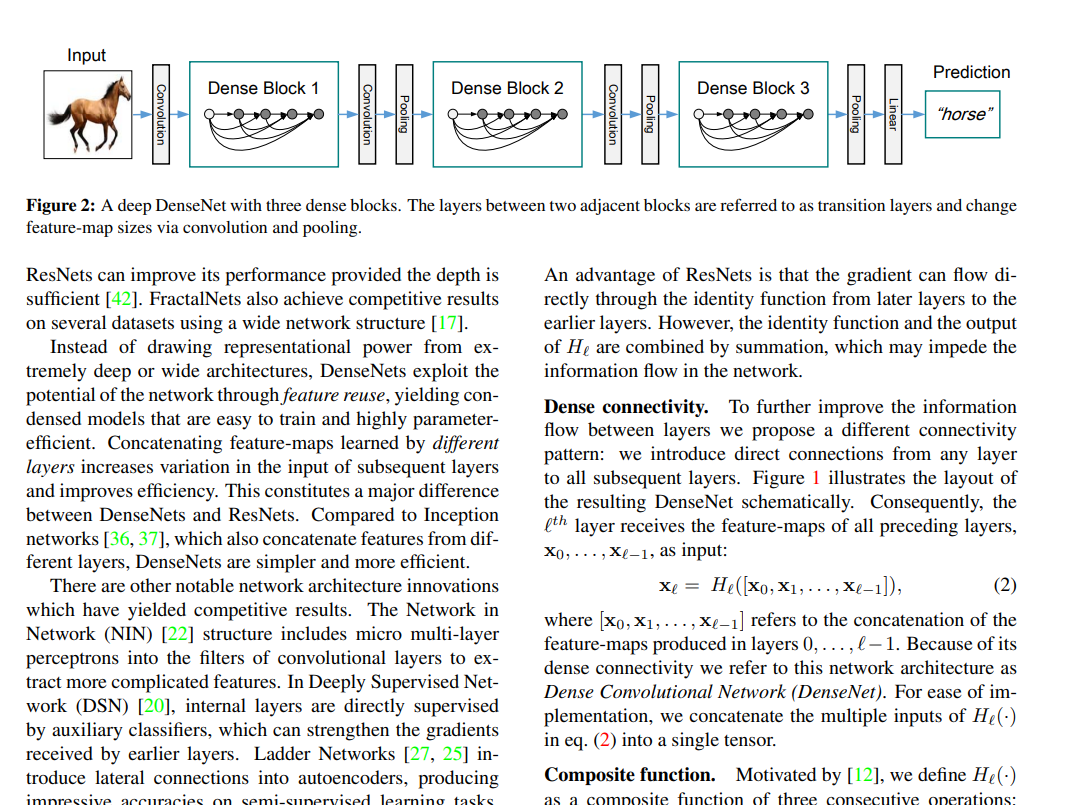

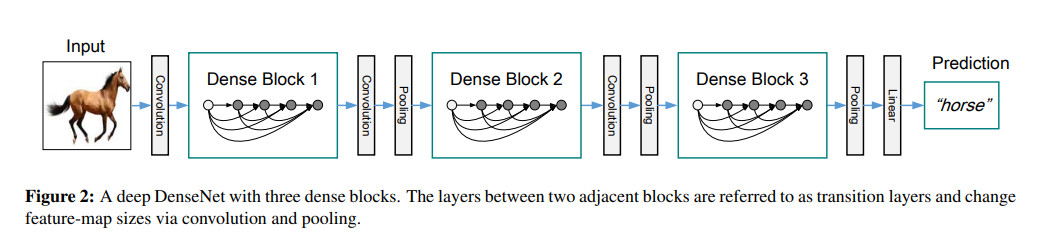

3. ネットワーク構造

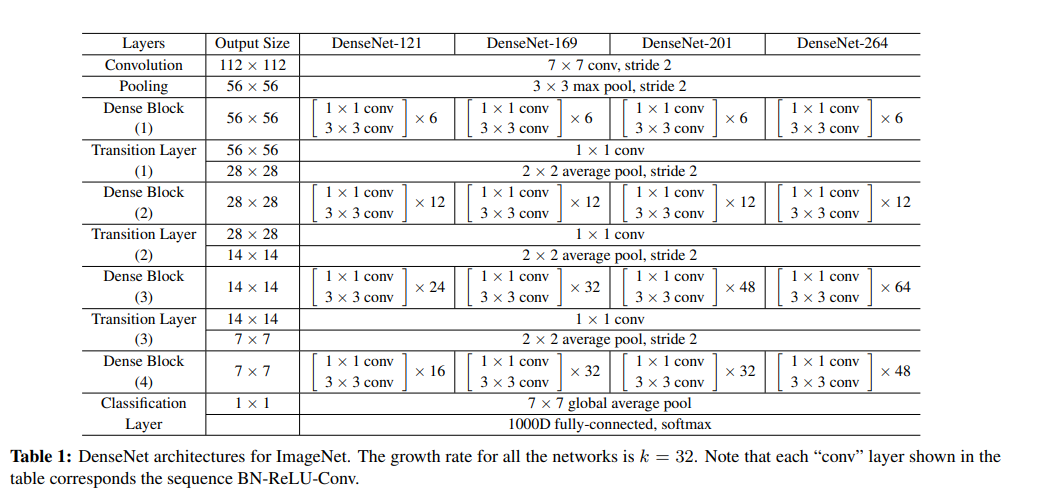

上の図からわかるように、DenseNet は ResNet に似ており、基本ブロックから構築されたネットワークですが、基本ブロックは異なります. Dense Block の各ノード (レイヤー) には、以前のすべての情報が含まれています (特徴マップを連結することにより、チャネル次元で)。DenseNet にはさまざまなレイヤーが含まれています: 121, 169, 201, 264. 最も広く使用されているレイヤーは 121. 他のレイヤーが一般的に使用されていないのはなぜですか? 古いアイアンは推測できます (カードが足りない?)。

なお、各 DenseNet の背後には遷移層があり、その役割は非常に重要であり、後の実践編で説明しますので、引き続きご注目いただければ幸いです。

終わり

エピローグ

この問題の共有は終わりました.DenseNetはその機能多重化操作を使用して、ネットワークをより深く効率的にすると同時に、効果は以前よりも優れています.要約と発見が得意であることが多いと言えます.成功の礎ですが、今日のタスクを実行するとき、私たちのほとんどはまだ ResNet ネットワークを最初に検討しています. その理由を推測して、次の号でそれについて話し続けます.

編集者: 凡人 Yueyi|レビュー: 凡人 Xiaoquanquan

上級ITツアー

過去のレビュー

Deep Learning Theory (Seventeen) -- ResNet のディープ クラシック

深層学習理論 (16) -- GoogLeNet による深さの謎の再探索

深層学習理論 (15) -- VGG による深さの謎の最初の探求

過去 1 年間に行ったこと:

【年末総括】古きに別れ新しきを迎え、2020年、また始めよう

【年末総括】遠い2021年に敬意を表し、違う2022年を迎える

「いいね!」をクリックして行きましょう〜