Hable sobre el escalado automático vertical de pods de Kubernetes (VPA)

Charla de operación y mantenimiento para principiantes de Scofield

Introducción a VPA

El nombre completo de VPA es Vertical Pod Autoscaler, que significa escalado automático de Pod vertical. Establece automáticamente las solicitudes de CPU y memoria de acuerdo con el uso de recursos del contenedor, lo que permite una programación adecuada en los nodos para proporcionar los recursos adecuados para cada Pod.

No solo puede encoger el contenedor que solicita excesivamente recursos, sino también aumentar la capacidad de recursos insuficientes en cualquier momento según su uso.

PD: VPA no cambiará los límites de recursos de Pod.

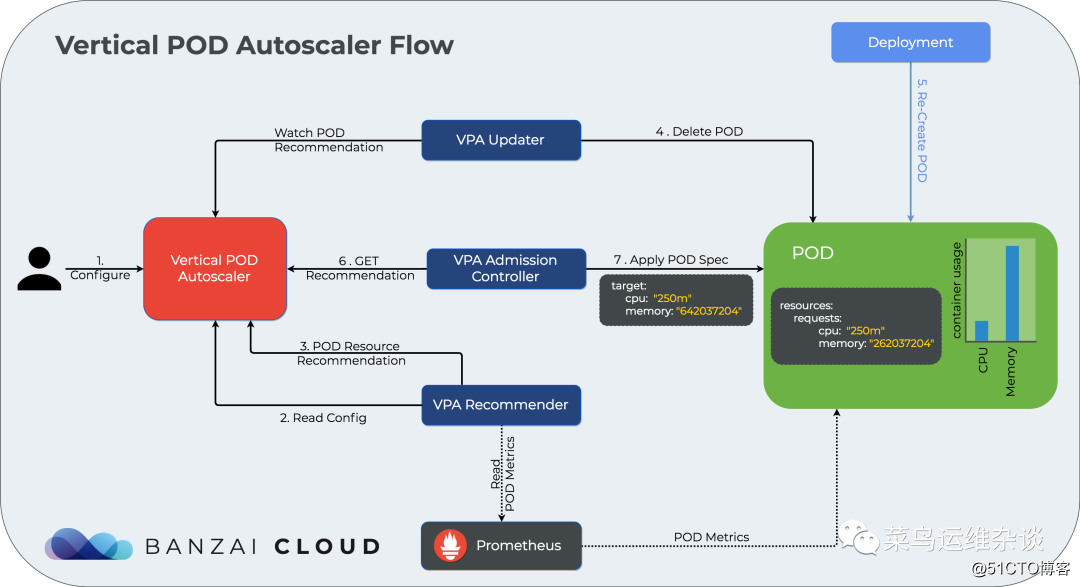

No hay muchas tonterías, solo ve a la imagen, mira el flujo de trabajo de VPA

A continuación, comience el combate real

Implementar servidor de métricas

1. Descargue el archivo de manifiesto de implementación

wget https://github.com/kubernetes-sigs/metrics-server/releases/download/v0.3.7/components.yaml2. Modifique el archivo components.yaml.

- Modificada la dirección espejo, gcr.io es mi propio almacén

- Se modificaron los argumentos del parámetro de inicio del servidor de métricas; de lo contrario, se informará un error que no podrá extraer completamente las métricas de la fuente kubelet_summary ...

- name: metrics-server

image: scofield/metrics-server:v0.3.7

imagePullPolicy: IfNotPresent

args:

- --cert-dir=/tmp

- --secure-port=4443

- /metrics-server

- --kubelet-insecure-tls

- --kubelet-preferred-address-types=InternalIP3. Realice la implementación

kubectl apply -f components.yaml4. Verificación

[root@k8s-node001 metrics-server]# kubectl get po -n kube-system

NAME READY STATUS RESTARTS AGE

metrics-server-7947cb98b6-xw6b8 1/1 Running 0 10m

能获取要top信息视为成功

[root@k8s-node001 metrics-server]# kubectl top nodes

NAME CPU(cores) CPU% MEMORY(bytes) MEMORY%

k8s-node001 618m 7% 4796Mi 15%

k8s-node003 551m 6% 5522Mi 17%

k8s-node004 308m 3% 5830Mi 18%

k8s-node005 526m 6% 5997Mi 38%

k8s-node002 591m 7% 5306Mi 33%Implementar vertical-pod-autoscaler

1. Clona el proyecto del escalador automático

git clone https://github.com/kubernetes/autoscaler.git2. Modificar el archivo de implementación y cambiar el almacén de gcr a mi propio almacén

admission-controller-deployment.yaml

us.gcr.io/k8s-artifacts-prod/autoscaling/vpa-admission-controller:0.8.0

改为

scofield/vpa-admission-controller:0.8.0

recommender-deployment.yaml

us.gcr.io/k8s-artifacts-prod/autoscaling/vpa-recommender:0.8.0

改为

image: scofield/vpa-recommender:0.8.0

updater-deployment.yaml

us.gcr.io/k8s-artifacts-prod/autoscaling/vpa-updater:0.8.0

改为

scofield/vpa-updater:0.8.03. Despliegue

[root@k8s-node001 vertical-pod-autoscaler]# cd autoscaler/vertical-pod-autoscaler

[root@k8s-node001 vertical-pod-autoscaler]# ./hack/vpa-up.sh

Warning: apiextensions.k8s.io/v1beta1 CustomResourceDefinition is deprecated in v1.16+, unavailable in v1.22+; use apiextensions.k8s.io/v1 CustomResourceDefinition

customresourcedefinition.apiextensions.k8s.io/verticalpodautoscalers.autoscaling.k8s.io created

customresourcedefinition.apiextensions.k8s.io/verticalpodautoscalercheckpoints.autoscaling.k8s.io created

clusterrole.rbac.authorization.k8s.io/system:metrics-reader created

clusterrole.rbac.authorization.k8s.io/system:vpa-actor created

clusterrole.rbac.authorization.k8s.io/system:vpa-checkpoint-actor created

clusterrole.rbac.authorization.k8s.io/system:evictioner created

clusterrolebinding.rbac.authorization.k8s.io/system:metrics-reader created

clusterrolebinding.rbac.authorization.k8s.io/system:vpa-actor created

clusterrolebinding.rbac.authorization.k8s.io/system:vpa-checkpoint-actor created

clusterrole.rbac.authorization.k8s.io/system:vpa-target-reader created

clusterrolebinding.rbac.authorization.k8s.io/system:vpa-target-reader-binding created

clusterrolebinding.rbac.authorization.k8s.io/system:vpa-evictionter-binding created

serviceaccount/vpa-admission-controller created

clusterrole.rbac.authorization.k8s.io/system:vpa-admission-controller created

clusterrolebinding.rbac.authorization.k8s.io/system:vpa-admission-controller created

clusterrole.rbac.authorization.k8s.io/system:vpa-status-reader created

clusterrolebinding.rbac.authorization.k8s.io/system:vpa-status-reader-binding created

serviceaccount/vpa-updater created

deployment.apps/vpa-updater created

serviceaccount/vpa-recommender created

deployment.apps/vpa-recommender created

Generating certs for the VPA Admission Controller in /tmp/vpa-certs.

Generating RSA private key, 2048 bit long modulus (2 primes)

............................................................................+++++

.+++++

e is 65537 (0x010001)

Generating RSA private key, 2048 bit long modulus (2 primes)

............+++++

...........................................................................+++++

e is 65537 (0x010001)

Signature ok

subject=CN = vpa-webhook.kube-system.svc

Getting CA Private Key

Uploading certs to the cluster.

secret/vpa-tls-certs created

Deleting /tmp/vpa-certs.

deployment.apps/vpa-admission-controller created

service/vpa-webhook created4. Verifique los resultados, puede ver que metrics-server y vpa ya se están ejecutando normalmente

[root@k8s-node001 autoscaler-master]# kubectl get po -n kube-system

NAME READY STATUS RESTARTS AGE

metrics-server-7947cb98b6-xw6b8 1/1 Running 0 46m

vpa-admission-controller-7d87559549-g77h9 1/1 Running 0 10m

vpa-recommender-84bf7fb9db-65669 1/1 Running 0 10m

vpa-updater-79cc46c7bb-5p889 1/1 Running 0 10mEjemplo 1 updateMode: "Off"

1. Primero implementamos un servicio nginx y lo implementamos en el espacio de nombres: vpa

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app: nginx

name: nginx

namespace: vpa

spec:

replicas: 2

selector:

matchLabels:

app: nginx

template:

metadata:

labels:

app: nginx

spec:

containers:

- image: nginx

name: nginx

resources:

requests:

cpu: 100m

memory: 250MiMira los resultados, 2 pods se ejecutaron normalmente.

[root@k8s-node001 examples]# kubectl get po -n vpa

NAME READY STATUS RESTARTS AGE

pod/nginx-6884b849f7-fswx5 1/1 Running 0 5m54s

pod/nginx-6884b849f7-wz6b8 1/1 Running 0 5m54s2. Para una prueba de presión barata, creamos un servicio de tipo NodePort

[root@k8s-node001 examples]# cat nginx-vpa-ingress.yaml

apiVersion: v1

kind: Service

metadata:

name: nginx

namespace: vpa

spec:

type: NodePort

ports:

- port: 80

targetPort: 80

selector:

app: nginx

[root@k8s-node001 examples]# kubectl get svc -n vpa

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

nginx NodePort 10.97.250.131 <none> 80:32621/TCP 55s

[root@k8s-node001 examples]# curl -I 192.168.100.185:32621

HTTP/1.1 200 OK3. Para crear un VPA,

primero use updateMode: modo "Off", este modo solo obtiene recursos, se recomienda no actualizar Pod

[root@k8s-node001 examples]# cat nginx-vpa-demo.yaml

apiVersion: autoscaling.k8s.io/v1beta2

kind: VerticalPodAutoscaler

metadata:

name: nginx-vpa

namespace: vpa

spec:

targetRef:

apiVersion: "apps/v1"

kind: Deployment

name: nginx

updatePolicy:

updateMode: "Off"

resourcePolicy:

containerPolicies:

- containerName: "nginx"

minAllowed:

cpu: "250m"

memory: "100Mi"

maxAllowed:

cpu: "2000m"

memory: "2048Mi"4. Ver los resultados de la implementación

[root@k8s-node001 examples]# kubectl get vpa -n vpa

NAME AGE

nginx-vpa 2m34s5. Utilice describe para ver los detalles de vpa, centrándose principalmente en las recomendaciones de contenedores.

[root@k8s-node001 examples]# kubectl describe vpa nginx-vpa -n vpa

Name: nginx-vpa

Namespace: vpa

....略去10000字 哈哈......

Update Policy:

Update Mode: Off

Status:

Conditions:

Last Transition Time: 2020-09-28T04:04:25Z

Status: True

Type: RecommendationProvided

Recommendation:

Container Recommendations:

Container Name: nginx

Lower Bound:

Cpu: 250m

Memory: 262144k

Target:

Cpu: 250m

Memory: 262144k

Uncapped Target:

Cpu: 25m

Memory: 262144k

Upper Bound:

Cpu: 803m

Memory: 840190575

Events: <none>entre ellos

Lower Bound: 下限值

Target: 推荐值

Upper Bound: 上限值

Uncapped Target: 如果没有为VPA提供最小或最大边界,则表示目标利用率

上述结果表明,推荐的 Pod 的 CPU 请求为 25m,推荐的内存请求为 262144k 字节。6. Ahora realizamos

una prueba de presión en nginx y ejecutamos un comando de prueba de presión

[root@k8s-node001 examples]# ab -c 100 -n 10000000 http://192.168.100.185:32621/

This is ApacheBench, Version 2.3 <$Revision: 1843412 $>

Copyright 1996 Adam Twiss, Zeus Technology Ltd, http://www.zeustech.net/

Licensed to The Apache Software Foundation, http://www.apache.org/

Benchmarking 192.168.100.185 (be patient)

Completed 1000000 requests

Completed 2000000 requests

Completed 3000000 requests7. Observe los cambios de la recomendación VPA en unos minutos.

[root@k8s-node001 ~]# kubectl describe vpa nginx-vpa -n vpa |tail -n 20

Conditions:

Last Transition Time: 2020-09-28T04:04:25Z

Status: True

Type: RecommendationProvided

Recommendation:

Container Recommendations:

Container Name: nginx

Lower Bound:

Cpu: 250m

Memory: 262144k

Target:

Cpu: 476m

Memory: 262144k

Uncapped Target:

Cpu: 476m

Memory: 262144k

Upper Bound:

Cpu: 2

Memory: 387578728

Events: <none>Se puede ver en la información de salida que VPA da un valor recomendado para Pod: Cpu: 476m, porque configuramos updateMode: "Off" aquí, por lo que el Pod no se actualizará.

Ejemplo 2 updateMode: "Auto"

1. Ahora configuro updateMode: "Auto" para ver qué hará el VPA.

Aquí cambié los recursos a: memory: 50Mi, cpu: 100m

[root@k8s-node001 examples]# kubectl apply -f nginx-vpa.yaml

deployment.apps/nginx created

[root@k8s-node001 examples]# cat nginx-vpa.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app: nginx

name: nginx

namespace: vpa

spec:

replicas: 2

selector:

matchLabels:

app: nginx

template:

metadata:

labels:

app: nginx

spec:

containers:

- image: nginx

name: nginx

resources:

requests:

cpu: 100m

memory: 50Mi

[root@k8s-node001 examples]# kubectl get po -n vpa

NAME READY STATUS RESTARTS AGE

nginx-7ff65f974c-f4vgl 1/1 Running 0 114s

nginx-7ff65f974c-v9ccx 1/1 Running 0 114s2. Implemente vpa nuevamente, aquí el archivo de implementación de VPA nginx-vpa-demo.yaml solo cambia u

pdateMode: "Auto" y el nombre: nginx-vpa-2

[root@k8s-node001 examples]# cat nginx-vpa-demo.yaml

apiVersion: autoscaling.k8s.io/v1beta2

kind: VerticalPodAutoscaler

metadata:

name: nginx-vpa-2

namespace: vpa

spec:

targetRef:

apiVersion: "apps/v1"

kind: Deployment

name: nginx

updatePolicy:

updateMode: "Auto"

resourcePolicy:

containerPolicies:

- containerName: "nginx"

minAllowed:

cpu: "250m"

memory: "100Mi"

maxAllowed:

cpu: "2000m"

memory: "2048Mi"

[root@k8s-node001 examples]# kubectl apply -f nginx-vpa-demo.yaml

verticalpodautoscaler.autoscaling.k8s.io/nginx-vpa created

[root@k8s-node001 examples]# kubectl get vpa -n vpa

NAME AGE

nginx-vpa-2 9s3. Prueba de presión nuevamente

ab -c 1000 -n 100000000 http://192.168.100.185:32621/4. Después de unos minutos, use describe para ver los detalles de vpa, y también solo preste atención a las recomendaciones de contenedores.

[root@k8s-node001 ~]# kubectl describe vpa nginx-vpa-2 -n vpa |tail -n 30

Min Allowed:

Cpu: 250m

Memory: 100Mi

Target Ref:

API Version: apps/v1

Kind: Deployment

Name: nginx

Update Policy:

Update Mode: Auto

Status:

Conditions:

Last Transition Time: 2020-09-28T04:48:25Z

Status: True

Type: RecommendationProvided

Recommendation:

Container Recommendations:

Container Name: nginx

Lower Bound:

Cpu: 250m

Memory: 262144k

Target:

Cpu: 476m

Memory: 262144k

Uncapped Target:

Cpu: 476m

Memory: 262144k

Upper Bound:

Cpu: 2

Memory: 262144k

Events: <none>El objetivo se convierte en CPU: 587 m, memoria: 262144 k

5. Mira el evento evento

[root@k8s-node001 ~]# kubectl get event -n vpa

LAST SEEN TYPE REASON OBJECT MESSAGE

33m Normal Pulling pod/nginx-7ff65f974c-f4vgl Pulling image "nginx"

33m Normal Pulled pod/nginx-7ff65f974c-f4vgl Successfully pulled image "nginx" in 15.880996269s

33m Normal Created pod/nginx-7ff65f974c-f4vgl Created container nginx

33m Normal Started pod/nginx-7ff65f974c-f4vgl Started container nginx

26m Normal EvictedByVPA pod/nginx-7ff65f974c-f4vgl Pod was evicted by VPA Updater to apply resource recommendation.

26m Normal Killing pod/nginx-7ff65f974c-f4vgl Stopping container nginx

35m Normal Scheduled pod/nginx-7ff65f974c-hnzr5 Successfully assigned vpa/nginx-7ff65f974c-hnzr5 to k8s-node005

35m Normal Pulling pod/nginx-7ff65f974c-hnzr5 Pulling image "nginx"

34m Normal Pulled pod/nginx-7ff65f974c-hnzr5 Successfully pulled image "nginx" in 40.750855715s

34m Normal Scheduled pod/nginx-7ff65f974c-v9ccx Successfully assigned vpa/nginx-7ff65f974c-v9ccx to k8s-node004

33m Normal Pulling pod/nginx-7ff65f974c-v9ccx Pulling image "nginx"

33m Normal Pulled pod/nginx-7ff65f974c-v9ccx Successfully pulled image "nginx" in 15.495315629s

33m Normal Created pod/nginx-7ff65f974c-v9ccx Created container nginx

33m Normal Started pod/nginx-7ff65f974c-v9ccx Started container nginxSe puede entender a partir de la información de salida que vpa ejecutó EvictedByVPA, detuvo automáticamente nginx y luego inició un nuevo nginx utilizando los recursos recomendados por VPA

, podemos verificar el pod nginx para obtener confirmación

[root@k8s-node001 ~]# kubectl describe po nginx-7ff65f974c-2m9zl -n vpa

Name: nginx-7ff65f974c-2m9zl

Namespace: vpa

Priority: 0

Node: k8s-node004/192.168.100.184

Start Time: Mon, 28 Sep 2020 00:46:19 -0400

Labels: app=nginx

pod-template-hash=7ff65f974c

Annotations: cni.projectcalico.org/podIP: 100.67.191.53/32

vpaObservedContainers: nginx

vpaUpdates: Pod resources updated by nginx-vpa: container 0: cpu request, memory request

Status: Running

IP: 100.67.191.53

IPs:

IP: 100.67.191.53

Controlled By: ReplicaSet/nginx-7ff65f974c

Containers:

nginx:

Container ID: docker://c96bcd07f35409d47232a0bf862a76a56352bd84ef10a95de8b2e3f6681df43d

Image: nginx

Image ID: docker-pullable://nginx@sha256:c628b67d21744fce822d22fdcc0389f6bd763daac23a6b77147d0712ea7102d0

Port: <none>

Host Port: <none>

State: Running

Started: Mon, 28 Sep 2020 00:46:38 -0400

Ready: True

Restart Count: 0

Requests:

cpu: 476m

memory: 262144kConcéntrese en las solicitudes: cpu: 476m, memoria: 262144k

y luego revise el archivo de implementación

requests:

cpu: 100m

memory: 50MiAhora puede saber lo que ha hecho VPA. Por supuesto, a medida que cambia la carga del servicio, la recomendación de VPA seguirá cambiando posteriormente. Cuando los recursos del pod que se está ejecutando actualmente no alcanzan el valor recomendado de VPA, se ejecutará el desalojo del pod y se volverán a implementar nuevos servicios con recursos suficientes.

Restricciones de uso de VPA

- No se puede utilizar con HPA (Escalador automático de pod horizontal)

- Por ejemplo, Pod usa un controlador de réplica, como Deployment o StatefulSet

¿Cuáles son los beneficios del VPA?

- Los recursos de pod se usan según sea necesario, por lo que los nodos del clúster se usan de manera eficiente.

- Los pods se organizarán en nodos con los recursos disponibles adecuados.

- No es necesario ejecutar tareas de referencia para determinar los valores adecuados para las solicitudes de CPU y memoria.

- VPA puede ajustar las solicitudes de CPU y memoria en cualquier momento sin operación humana, por lo que se puede reducir el tiempo de mantenimiento.

Por último, VPA es una función relativamente nueva de Kubernetes. No se ha practicado a gran escala en el entorno de producción. No se recomienda utilizar el modo de actualización automática en el entorno en línea, pero puede comprender mejor el uso de recursos del servicio utilizando el modo recomendado.

Para obtener más información, visite el sitio web oficial para ver

PD: los artículos de seguimiento se sincronizarán con dev.kubeops.net

Nota: Las imágenes del artículo son de Internet. Si hay alguna infracción, comuníquese conmigo para eliminarla a tiempo.