red de la clasificación clásica de profundidad

AlexNet

- En donde

por la montaña, utilizando RELU, LRN, deserción, la superposición de la agrupación (paso <núcleo) - gráfico

VGG

- característica

- almohadilla cov3x3 = zancada = 1 no altera el tamaño de los caracteres en la figura.

- + = Conv5x5 conv3x3 con3x3

con3x3 conv3x3 + + = conv7x7 conv3x3

reducir cómputo - Hecho más profundo (nivel ++)> más amplios canales (++)

- gráfico

vgg16 (D) vgg19 (E)

v1 inicio

- características:

- característica multiescala también calculado (a)

- 1x1 conv reducir el número de canal (b)

- clasificación del nivel medio de inserción de una capa separada (supervisión profundo?)

- arquitectura del módulo inicio

- arquitectura GoogleNet

grave

-

En el que:

los canales de la red de alineación residuales: 1x1 conv Learning residual -

arquitectura cuello de botella (canal de estrechamiento -> expansión)

- Ejemplo expansión de alineación (por conv 1x1)

- ResNet parámetros de red

Referencias:

Resnet

creación v2

- características:

- Reducir la cantidad de parámetros:

- 5x5 = 3x3 + 3x3 7x7 = 3x3 + 3x3 + 3x3

- 3x3 = 3x1 + 1x3

- La reducción de mapa de características mientras que la expansión del canal:

CONV paralelo Pooling +

- Alchemy Dafa es bueno:

- Una gran proporción de compresión (la agrupación) con precaución, lo que resulta en una rápida reducción de mapa de características

- ++ canal de convergencia favor

- compresión de baja pérdida canal de compresión de 1x1 conv

- La profundidad y el número de la anchura del canal y el equilibrio geométrico profundidad

- arquitectura de red:

v3 inicio

- 特征: clasificador de nivel medio + BN / deserción 层 de regularización

- Arquitectura:

v4 inicio

Más elaborar estructuras complejas, con el fin de verificar resnet única formación acelerada propuesto

Inception-v1 y v2 Resnet

- En donde:

el nombre sugiere, Inception + módulo residual

a la salida del módulo de Inicio-resnet escala const 0,1-0,3

DenseNet

- En donde: el mapa de características de entrada para el bloque en frente de todas las capas de

la capa densa

B. N-> Relu-> Cuello de botella (Channel-> * K. 4) -> CONV (Channel-> K) -> Dropout

capa de transición + 1x1conv BN + RELU (disponible de canal -) + puesta en común (mapa de características -)

¿Por cuello de botella? Bloque denso, si cada función de capa K se generan mapa de características, a continuación, la primera capa no l mapa característico como una entrada, donde k0 representa el número de canales en la capa de entrada. Número de canales de entrada demasiado lío

- Arquitectura:

densenet que las razones específicas para resnet lento, densenet de featuremap mucho más grande que resnet, lo que resulta en muchas de las grandes proceso de convolución de cálculo que resnet, en pocas palabras es fracasos más grandes, más grande el uso de memoria, y la memoria visitas a mucho más acceso a la memoria es muy lento

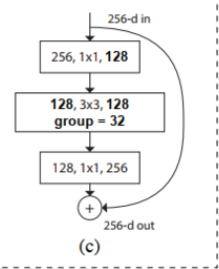

ResNeXt

- El que: en la forma de aumentar el grupo rama

- Arquitectura:

propuesto transformaciones aggregrated, los mismos bloques en una topología de bloque paralelo apilados en lugar del original tres convolución ResNet mejoran la exactitud de los parámetros del modelo en el caso de aumentar significativamente orden, y porque la misma topología , hiperparámetros también redujeron, lo que facilita modelo de trasplante.

resnet V2

- Donde: el BN-relu antes de trasladarse a garantizar la identidad conv mapeo

- Arquitectura:

¿Por qué debería garantizar la distribución de las ramas de identidad?