通过CTPN进行文字定位,CRNN进行文字识别以及Flask Web实现银行卡号码识别

Github地址

由于我并不是机器学习方向,完成此项目只是学校课程需要

所以文章可能只是如何开始并完成这个项目,至于深层次的原理,推荐两篇中文博文

【OCR技术系列之五】自然场景文本检测技术综述(CTPN, SegLink, EAST)

【OCR技术系列之七】端到端不定长文字识别CRNN算法详解

构建基础运行环境

硬件设备以及部分驱动和依赖如下:

Ubuntu18.04 + CUDA 8.0.61 + GeForce GTX 960M + NVIDIA Driver 430.14 + Python3.6 + Tensorflow-gpu

安装完成后,可以通过下面命令在你的设备中检查

克隆源代码,并生成Python3虚拟环境

git clone https://github.com/bay1/card-crnn-ctpn.git

python3 -m virtualenv venv

source venv/bin/activate # 激活虚拟环境

pip install -r requirements.txt # 安装项目依赖配置warpctc-pytorch

项目中用到了warpctc-pytorch,需要我们手动安装

注意这里的命令需要在Python虚拟环境中执行

git clone https://github.com/SeanNaren/warp-ctc.git

cd warp-ctc

mkdir build; cd build

cmake ..

make你可能会遇到如下错误,这是因为你的gcc版本过高,需要低于5.0版本

/usr/local/cuda-8.0/include/host_config.h:119:2: error: #error -- unsupported GNU version! gcc versions later than 5 are not supported!

#error -- unsupported GNU version! gcc versions later than 5 are not supported!

^~~~~如果你系统中有多个gcc版本,你可以执行下面的命令指定"gcc"命令链接的具体指令

比如我指定我系统中存在的另一个gcc版本: gcc-4.9

sudo rm /usr/bin/gcc

sudo ln -s /usr/bin/gcc-4.9 /usr/bin/gcc

你也可能会遇到如下错误

/usr/bin/ld: CMakeFiles/test_gpu.dir/tests/test_gpu_generated_test_gpu.cu.o: relocation R_X86_64_32S against `.bss' can not be used when making a PIE object; recompile with -fPIC

/usr/bin/ld: 最后的链结失败: 输出不可表示的节

collect2: error: ld returned 1 exit status

CMakeFiles/test_gpu.dir/build.make:98: recipe for target 'test_gpu' failed

make[2]: *** [test_gpu] Error 1

CMakeFiles/Makefile2:146: recipe for target 'CMakeFiles/test_gpu.dir/all' failed

make[1]: *** [CMakeFiles/test_gpu.dir/all] Error 2

Makefile:129: recipe for target 'all' failed

make: *** [all] Error 2根据报错内容,我们可以直接修改目录下的CMakeCache.txt

CMAKE_CXX_FLAGS:STRING=-fPIC # 39 行

然后我们根据warp-ctc说明,执行下面命令

cd ../pytorch_binding

python setup.py install此时你可能会遇到如下错误

src/binding.cpp:6:10: fatal error: torch/extension.h: 没有那个文件或目录

#include <torch/extension.h>

^~~~~~~~~~~~~~~~~~~

compilation terminated.

error: command 'x86_64-linux-gnu-gcc' failed with exit status 1根据前人的经验,https://github.com/SeanNaren/warp-ctc/issues/101

我们直接切换以前的版本即可

git checkout ac045b6CTPN

文本位置定位,我直接借用的此项目以及其训练的模型text-detection-ctpn

其实作者训练的模型效果不算很好,不过我手里并没有模型数据,自己训练还是需要下载这位作者的训练数据

所以干脆直接使用作者训练好的模型数据即可,可以从下面两种方式下载作者的ckpt file

将此文件夹放到ctpn/,然后执行如下命令

cd ctpn/utils/bbox

chmod +x make.sh

./make.shPS: 如果你想要自己训练CTPN模型数据,你可以执行ctpn文件夹下的train.py文件

其中text-detection-ctpn只是针对文本进行位置的定位

而我们针对银行卡号进行具体定位,所以还是需要进行一些自定义的处理

我的思路是对选取出来的所有Box进行长宽的计算,然后根据长宽的比例来进行截取卡号区域

当然这种效果的前提是,我们能够将卡号部分检测出来,不过这样实现的效果还是相当不错的

def get_wh(box_coordinate):

"""

计算box坐标宽高

box格式: [xmin, ymin, xmax, ymin, xmax, ymax, xmin, ymax, score]

"""

xmin = box_coordinate[0]

xmax = box_coordinate[2]

ymin = box_coordinate[1]

ymax = box_coordinate[5]

width = xmax - xmin

height = ymax - ymin

return width, heightCRNN

此时需要回到项目根目录,首先对我得到的图片数据进行简单的处理

即将原始图片数据,即data/images的图片,转化为生成lmdb需要的形式

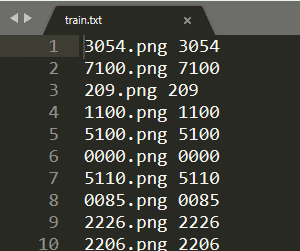

python crnn/handle_images.py图片路径以及正确标签文本: crnn/to_lmdb/train.txt

处理后的图片新路径: crnn/to_lmdb/train_images

然后我们就需要将我们手中的数据转换成train所需要的lmdb文件

执行下面命令

python crnn/to_lmdb/to_lmdb_py3.py # python crnn/to_lmdb/to_lmdb_py2.py 生成的lmdb文件目录: crnn/to_lmdb/lmdb

这时候我们就可以具体训练我们手中的数据

python crnn/train.py

模型保存目录: crnn/expr

自定义参数

这个项目有各种自定义的数据目录,以及训练模型的参数

如果你想修改这些参数或者数据路径,你可以到下面两个文件中

- ctpn/params.py

- crnn/params.py

其中crnn训练模型的参数详解

--random_sample 是否使用随机采样器对数据集进行采样, action='store_true'

--keep_ratio 设置图片保持横纵比缩放, action='store_true'

--adam 使用adma优化器, action='store_true'

--adadelta 使用adadelta优化器, action='store_true'

--saveInterval 设置多少次迭代保存一次模型

--valInterval 设置多少次迭代验证一次

--n_test_disp 每次验证显示的个数

--displayInterval 设置多少次迭代显示一次

--experiment 模型保存目录

--alphabet 设置检测分类

--crnn 选择预训练模型

--beta1

--lr 学习率

--niter 训练回合数

--nh LSTM隐藏层数

--imgW 图片宽度

--imgH 图片高度, default=32

--batchSize 设置batchSize大小, default=64

--workers 工作核数, default=2

--trainroot 训练集路径

--valroot 验证集路径

--cuda 使用GPU, action='store_true'可视化

训练CRNN完成之后,crnn测试加载模型路径默认是: crnn/trained_models/crnn_Rec_done.pth

即我们需要把我们训练好的模型重命名放到这个目录

然后我们就可以在项目根目录执行如下命令

python run.py浏览器打开链接:http://127.0.0.1:5000

效果展示

这是本地迭代了60次的效果

测试图片中能完整识别其中的一张银行卡号