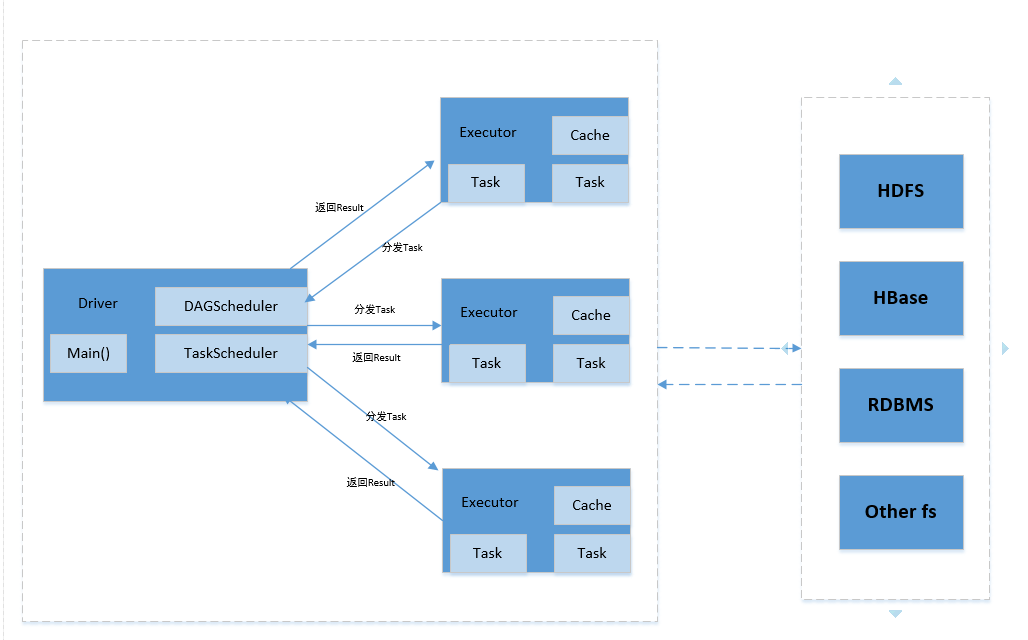

Spark基本架构图如下:

Client:客户端进程,负责提交作业。

Driver:一个Spark作业有一个spark context,一个Spark Context对应一个Driver进程,作业的main函数运行在Driver中。Driver主要负责Spark作业的解析,以及通过DAGSchduler划分stage,将Stage转化成TaskSet提交给TaskScheduler任务调度器,进而调度Task到Executor上执行。

Executor:负责执行Driver分发的Task任务。集群中一个节点可以启动多个Executor,每个Executor可以执行多个Task任务。

Cache:Spark提供了对RDD不同级别的缓存策略,分别可以缓存到内存、磁盘、外部分布式内存存储系统如Tachyon等。

Applicatio:提交的一个作业就是一个Appliation。一个Application只有一个Spark Context。

Job:RDD执行一次Action操作应付生成一个Job。

Task:Spark运行的基本单位,负责 处理RDD的计算逻辑。

Stage:DAGScheduler将Job划分为多个Stage,Stage的划分界限为Shuffle的产生,Suffle标志着上一个Stage的结束和下一个Stage的开始。

TaskSet:划分的Stage会转换成一组相关联的任务集。

RDD(Resilient Distributed Dataset):弹性分布式数据集,可以理解为一种只读的分布式多分区的数组,Spark计算操作都是基于RDD进行的,下面会有详细介绍。

DAG(Directed Acyclic Graph):有向无环图。Spark实现了DAG的计算模型,DAG计算模型是指将一个计算任务按照计算规则分解为若干子任务,这些子任务之间根据逻辑关系构建成有向无环图。