0 摘要

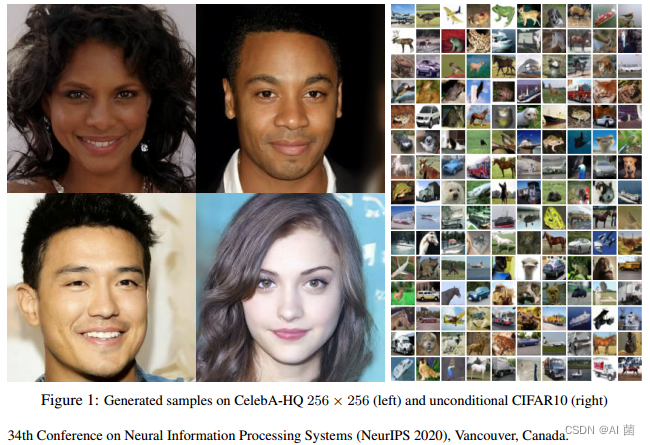

本文使用扩散概率模型合成了高质量的图像结果,扩散概率模型是一类受非平衡热力学启发的潜变量模型。本文最佳结果是通过根据扩散概率模型和朗之万动力学的去噪分数匹配之间的新颖联系设计的加权变分界进行训练来获得的,并且本文的模型自然地承认渐进式有损解压缩方案,该方案可以解释为自回归解码的推广。在CIFAR10 数据集上,本文都获得了不错的分数。

本文github链接:https://github.com/hojonathanho/diffusion.

论文连接:https://arxiv.org/abs/2006.11239

1 引言

各种深度生成模型最近在各种数据模式中展示了高质量的样本。生成对抗网络(GAN)、自回归模型、 flows 和变分自动编码器(VAE)合成了引人注目的图像和音频样本,并且基于能量的建模和评分匹配取得了显着的进步,产生了与 GAN 相当的图像。

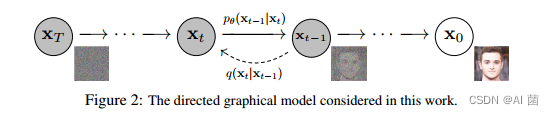

扩散概率模型是使用变分推理训练的参数化马尔可夫链,以在有限时间后生成与数据匹配的样本。该链的转换被学习以逆转扩散过程,这是一个马尔可夫链,在采样的相反方向上逐渐向数据添加噪声,直到信号被破坏。当扩散包含少量高斯噪声时,将采样链转换设置为条件高斯就足够了,从而允许特别简单的神经网络参数化。

本文表明扩散模型能够产生高质量的样本,有时比在其他类型的生成模型上生成的结果更好。此外,本文还证明了扩散模型的某种参数化与训练过程中多个噪声水平上的去噪分数匹配和采样过程中的退火朗之万动力学等价。本文使用这个参数获得了最好的样本质量结果,所以本文认为这个等价性是本文的主要贡献之一。

本文表明扩散模型的采样过程是一种渐进式解码,它类似于自回归解码的比特排序,极大地扩展了自回归模型通常可以实现的功能。

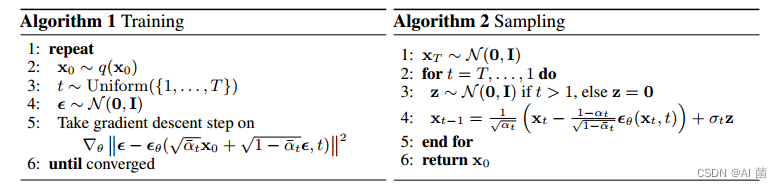

2 训练与推理

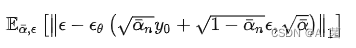

训练过程,其实就是不断迭代得到最佳的参数,来使推到得到的目标损失函数最小:

目标函数的物理意义直观理解就是:让模型输出和随机生成的噪音 距离差值最小。我们的模型的目标其实就是在生成噪音。更准确的说是在生成真实信号与标准高斯分布噪音之间多余的那部分噪音信号,我们可以通过用 标准高斯分布噪音 减去 生成的噪音信号 得到我们最后的 合成信号。

Inference 也就是上面算法右图中的Sampling 过程:用 上一轮输出的带噪音信号减去模型生成的噪音信号乘上一个系数,而第一轮的输入就是一个完完全全的标准高斯分布噪音。

3 实验

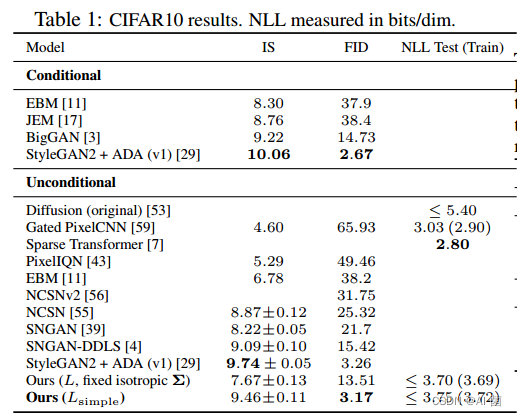

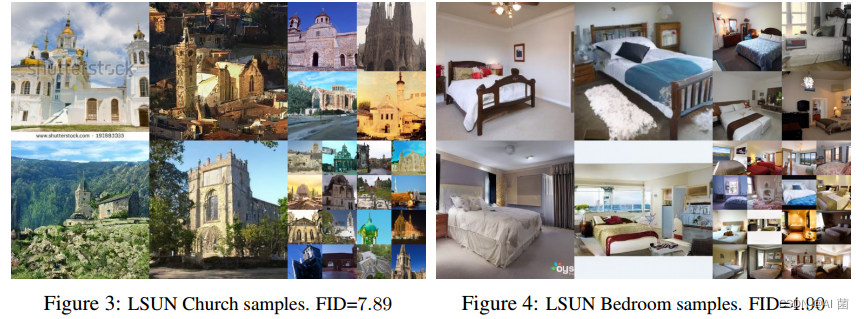

表 1 显示了 CIFAR10 的 IS 分数、FID 分数和负对数似然值(无损编码长度)。我们的 FID 得分为3.17,与文献中的大多数模型(包括类条件模型)相比,我们的无条件模型达到了更好的样本质量。按照标准做法,我们的 FID 分数是针对训练集计算的;当我们针对测试集计算时,分数为 5.24,仍然优于许多文献中的训练集 FID 分数。

Inception Score(IS)和Fréchet Inception Distance(FID)是用于衡量深度学习生成模型生成图像质量的指标。

- IS结合了两个方面的评估:图像质量的期望值(Exp)和图像质量分布的分歧度(KL)

- FID通过比较生成图像和真实图像在特征空间中的分布距离来衡量它们之间的差异,具体而言,FID使用了真实图像和生成图像在Inception网络的中间层的特征向量上的统计特性。

指标详细参考:https://www.zhihu.com/search?type=content&q=Inception%20scores

4 结论

本文利用扩散模型生成了高质量的图像样本,并发现了扩散模型与马尔可夫链训练的变分推理、去噪分数匹配和退火朗格文动力学(以及基于能量的扩展模型)、自回归模型和渐进有损压缩之间的联系。由于扩散模型似乎对图像数据具有极佳的归纳偏差,我们期待着研究它们在其他数据模式中的用途,以及作为其他类型生成模型和机器学习系统的组成部分。