Введение:

Принадлежит повышения пути интеграции обучения. повышение тяжелого весового метода является использование итерационных обучения базовых классификаторов, каждый этап обучения классификатора на основе, для каждого раунда образца взвешивает, вес зависит от результата классификации. Между основания и линейными взвешенными классификаторы, полученными в прошлом сильного классификатора.

Алгоритмический процесс

Линейные взвешенные базовые классификаторы и непрерывно уменьшают ошибку, сгенерированную в процессе обучения.

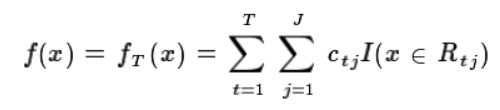

Несколько раундов итераций, каждая итерация производит слабый классификатор, слабые классификаторы (телега регрессионные деревья) в последнем туре классификатора остатков , полученных на основе. F1 на предположении , что сильный ученик получить раунд, потеря является функцией L1, то телега вокруг , чтобы найти дерево, так что потеря функции от значения текущего раунда еще мало.

Как выбрать характеристики (то есть, как генерировать телеги дерева)?

корзина регрессионные деревья:

Squared ошибка сведена к минимуму и, в котором для А = а, то минимальная ошибка множества D, чтобы выбрать значение признака из самых режущих точек.

Классификация дерева:

При использовании коэффициента Джини Вместо энтропии вычисляется для признака А = A, D Джини индекс установленного минимального, отличающийся тем, что выбор наиболее режущих точек

Как построить функцию?

gbdt себя не может производить функции, сочетание функций генерируется. Так, например, генерирует два суб-дерево (корзина Регрессионный деревья) с gbdt, в общей сложности пять узлов листа, затем образец помещают на две суб-дерева, конечно, в одном из выходного листа узла на два суб-дерева из двух последних выход. Лист узлов, так что выход равен 1, в противном случае 0, то вектор состоит из [0,1,1,0,0], которая является комбинацией особенностей вектора, а затем первоначальные особенности ввода вместе с логистической регрессии функция обучения, конечный эффект был улучшен, вместо того, чтобы вручную установить все функции.

Потеря функции подгонки?

Отрицательный градиент функции приближения потерь, чтобы соответствовать круглой потере (остаточной), а затем в соответствии с телегой дерева.

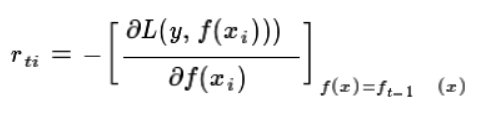

Т I-го круглых образцов, как отрицательный градиент:

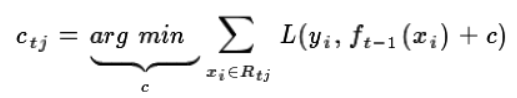

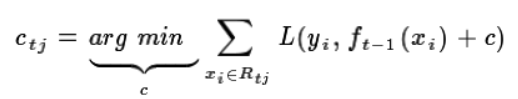

Это отрицательный градиент вычисляется для всех образцов, а затем использовать (XI, RTI) эквивалентен отрицательный градиент в качестве метки, использовать эти данные, чтобы соответствовать телегам дерева, дерево было хорошо, а затем в ( XI, остаточные я) данные во внутреннюю часть дерева, вычисление функции потерь, таким образом, что минимальная функция потерь для получения выходного значения (остаточное с):

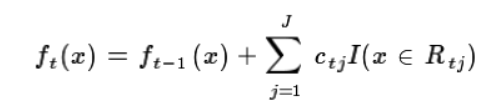

Таким образом, этот раунд решающая функция (остаточная функция стоимости) вышла:

Тогда этот круг функций принятия решений вместе классификатором, получить этот раунд сильного классификатора:

(PS: Если в общей сложности т раунде, так что первый раунд т получить сильный классификатор сильный классификатор окончательный)

Как классифицировать?

Время возврата:

1, слабая инициализация классификаторов, начало первого раунда обучения;

2, итеративный, отрицательный градиент рассчитываются путем установки отрицательного градиента корзины дерева, то такая минимальная функции потерь, наилучшим образом соответствует значениям (невязки).

3, обновлять сильные классификаторы

4, чтобы получить окончательную классификацию наиболее сильных!

Каждый раунд мультипликативная функция решения:

При классификации не то же самое:

Поскольку выход дискретные категории, не напрямую от выхода, чтобы соответствовать выходной категории ошибок класса.

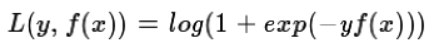

Метод: (1) с использованием экспоненциальной функции потерь, было бы AdaBoost; (2) аналогично функции логистической регрессии логарифмического правдоподобия. Прогнозируемое значение вероятности категории и реальное значение вероятности разницы

Функция потери функция логарифмической вероятности:

Экспоненциальная функция потерь:

Преимущества:

Гибкие различные виды обработки данных;

Планирование меньше времени и с высокой точностью;

Используйте надежную функцию потерь, очень устойчив к выбросам;