O OpenScene, uma abordagem zero-shot simples, porém eficaz, para a compreensão da cena 3D com vocabulários abertos, supera os métodos totalmente supervisionados na segmentação semântica 3D interna com 40, 80 ou 160 categorias.

Endereço do artigo: https://arxiv.org/abs/2211.15654

Endereço do projeto: https://github.com/pengsongyou/openscene

Os métodos tradicionais de compreensão de cena 3D dependem de conjuntos de dados 3D rotulados para treinar modelos de maneira supervisionada para executar uma única tarefa. Em vez disso, os autores propõem um método alternativo, OpenScene, que é um modelo de consulta de saco de palavras aberto para cenas 3D. onde o modelo prevê recursos densos de pontos de cena 3D co-incorporados com pixels de texto e imagem no espaço de recursos CLIP. Essa abordagem de tiro zero permite treinamento independente de tarefa e consulta de vocabulário aberto. Por exemplo, para executar a segmentação semântica 3D SOTA zero-shot, ele primeiro infere recursos CLIP para cada ponto 3D e, em seguida, os classifica com base em sua semelhança com incorporações arbitrárias de rótulos de classe. Mais interessante, ele permite uma variedade de aplicativos de entendimento de cena de vocabulário aberto nunca antes tentados. Por exemplo, ele permite que os usuários insiram consultas de texto arbitrárias e visualizem um mapa de calor indicando quais partes da cena correspondem. O método é capaz de reconhecer objetos , materiais , disponibilidade , atividades e tipos de quartos em cenas 3D complexas , todos treinados usando o mesmo modelo sem nenhum dado 3D rotulado.  Introdução

Introdução

A compreensão da cena 3D é uma tarefa fundamental na visão computacional. Dada uma malha 3D ou nuvem de pontos com um conjunto de poses, bem como informações RGB, o objetivo é inferir a semântica, disponibilidade, funcionalidade e propriedades físicas de cada ponto 3D. Por exemplo, na casa mostrada na imagem acima, queremos prever quais superfícies fazem parte de um ventilador (semântica), são feitas de metal (material), estão na cozinha (tipo de quarto), onde uma pessoa pode sentar ( usabilidade possível), onde uma pessoa pode trabalhar (função) e quais superfícies são macias (propriedades físicas). As respostas a essas perguntas podem ajudar os robôs a interagir de forma inteligente com uma cena ou ajudar os humanos a entendê-la por meio de consultas e visualizações interativas.

No entanto, devido às múltiplas possibilidades de consultas do mundo real, atingir esse amplo objetivo de compreensão da cena é um desafio. Os sistemas tradicionais de compreensão de cena 3D são obtidos por meio de treinamento supervisionado em conjuntos de dados de referência projetados para tarefas específicas (por exemplo, segmentação semântica 3D para um conjunto fechado de 20 categorias). Cada um deles é projetado para responder a um tipo de consulta (esse ponto está em uma cadeira, mesa ou cama?), mas são menos úteis para consultas relacionadas em que os dados de treinamento são escassos (por exemplo, segmentação de objetos raros) ou outros sem 3D supervisão. (por exemplo, estimar as propriedades do material), pouca ajuda é fornecida.

Este artigo estuda como utilizar modelos de incorporação de imagens de texto pré-treinados, como o CLIP, para auxiliar na compreensão da cena 3D. Esses modelos são treinados a partir de grandes conjuntos de dados de imagens com legendas para codificar conjuntamente conceitos visuais e linguísticos em um espaço de recursos compartilhado. Estudos recentes têm mostrado que esses modelos podem ser usados para aumentar a flexibilidade e capacidade de generalização da segmentação semântica de imagens 2D. No entanto, ninguém investigou como explorá-los para melhorar as tarefas de compreensão da cena 3D.

Os autores propõem um método zero-shot simples, mas eficaz, chamado OpenScene para compreensão de cena 3D de vocabulário aberto. A ideia-chave do autor é usar os recursos densos de pontos tridimensionais no espaço de recursos CLIP codificados por strings de texto e pixels de imagem (como mostrado na figura abaixo). Para atingir esse objetivo, os autores estabelecem associações entre pontos 3D em uma cena 3D e pixels em imagens de pose e treinam uma rede 3D para codificar pontos 3D usando recursos de pixel CLIP como supervisão. Essa abordagem alinha pontos 3D a pixels no espaço de recursos e, portanto, a recursos textuais, permitindo consultas de vocabulário aberto em pontos 3D.  O algoritmo de incorporação de ponto 3D do autor inclui convolução 2D e 3D. Primeiro, os autores projetam a localização 3D do ponto em cada imagem e agregam os recursos de pixels relacionados usando a fusão de múltiplas visualizações. Em seguida, treinamos uma rede convolucional 3D esparsa para extração de recursos apenas de geometrias de nuvens de pontos 3D e usamos uma perda que minimiza a diferença entre os recursos de pixel agregados. Por fim, os autores combinam as feições produzidas pela fusão 2D e pela rede 3D em uma única feição para cada ponto 3D. Essa estratégia híbrida de recursos 2D-3D permite que o algoritmo explore padrões salientes em imagens 2D e geometria 3D, sendo assim mais robusto e descritivo do que recursos em um único domínio.

O algoritmo de incorporação de ponto 3D do autor inclui convolução 2D e 3D. Primeiro, os autores projetam a localização 3D do ponto em cada imagem e agregam os recursos de pixels relacionados usando a fusão de múltiplas visualizações. Em seguida, treinamos uma rede convolucional 3D esparsa para extração de recursos apenas de geometrias de nuvens de pontos 3D e usamos uma perda que minimiza a diferença entre os recursos de pixel agregados. Por fim, os autores combinam as feições produzidas pela fusão 2D e pela rede 3D em uma única feição para cada ponto 3D. Essa estratégia híbrida de recursos 2D-3D permite que o algoritmo explore padrões salientes em imagens 2D e geometria 3D, sendo assim mais robusto e descritivo do que recursos em um único domínio.

Depois que os recursos de cada ponto 3D são calculados, podemos executar várias tarefas de consulta de compreensão de cena 3D. Como o modelo CLIP é treinado usando legendas de linguagem natural, ele captura conceitos além dos rótulos de categoria de objeto, incluindo recursos, materiais, propriedades e funções. Por exemplo, calcular a similaridade entre recursos 3D e incorporações "suaves" produz resultados como o mostrado no início do artigo, destacando sofás, camas e cadeiras confortáveis como as melhores correspondências.

Como o método dos autores é zero-shot (ou seja, não usa dados rotulados para a tarefa de destino), ele não funciona tão bem quanto os métodos totalmente supervisionados (por exemplo, segmentação semântica 3D com 20 categorias) em conjuntos de tarefas limitadas em benchmarks tradicionais. No entanto, mostra um desempenho significativamente mais forte em outras tarefas. Por exemplo, supera os métodos totalmente supervisionados na segmentação semântica 3D interna com 40, 80 ou 160 categorias. Ele também tem um desempenho melhor do que outras linhas de base zero-shot e pode ser usado em novos conjuntos de dados sem retreinamento, mesmo que tenham conjuntos de rótulos diferentes. É adequado para digitalização RGBD interna, bem como captura de direção externa.

Método

Uma visão geral da abordagem dos autores é mostrada na figura abaixo. Primeiro, calculamos os recursos por pixel para cada imagem usando um modelo de segmentação semântica 2D orientado a vocabulário aberto pré-treinado. Em seguida, o autor agrega os recursos de pixel de várias visualizações para cada ponto 3D para formar um vetor de recursos de fusão (Image Feature Fusion) para cada ponto. Em seguida, os autores destilam esses recursos fundidos (destilação 3D) usando uma rede 3D que aceita apenas nuvens de pontos 3D como entrada. Combinamos os recursos 2D fundidos e os recursos 3D destilados em um recurso de ponto único (2D-3D Feature Ensemble) e o usamos para responder a consultas com um vocabulário aberto (Inferência).  1. Fusão de recursos de imagem

1. Fusão de recursos de imagem

2. Destilação 3D

2. Destilação 3D  3. Conjunto de recursos 2D-3D

3. Conjunto de recursos 2D-3D

simplesmente o recurso com a maior pontuação do conjunto. whaosoft aiot http://143ai.com  4. Inferência

4. Inferência 探索

探索

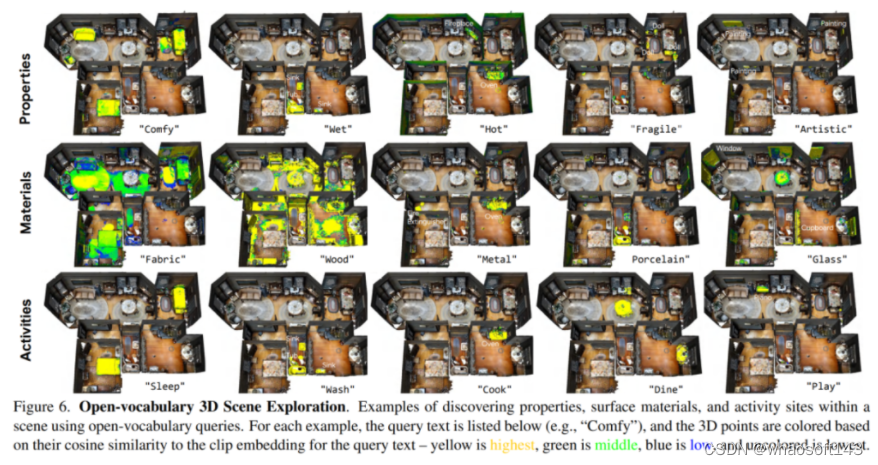

Finalmente, os autores exploram se as cenas 3D podem ser consultadas para propriedades além dos rótulos de classe. Como o espaço de incorporação CLIP é treinado com um corpus de texto em grande escala, ele pode representar muito mais do que rótulos de classe - ele pode codificar propriedades físicas, materiais de superfície, disponibilidade humana, funções potenciais, tipos de sala e muito mais. Nossa hipótese é que podemos usar nossa co-incorporação de pontos 3D com recursos CLIP para descobrir esses tipos de informações sobre a cena.

A imagem abaixo mostra exemplos de resultados para consultas sobre propriedades físicas, materiais de superfície e possíveis locais para eventos. A partir desses exemplos, podemos ver que o OpenScene é realmente capaz de associar palavras a áreas relevantes da cena - por exemplo, cama, sofá e cadeira estofada correspondem a "Confortável", forno e lareira correspondem a "Quente", teclado de piano corresponde a "Tocar " partidas. Essa compreensão diversa da cena 3D será difícil de alcançar com métodos totalmente supervisionados, o que requer extenso trabalho de anotação 3D. Na opinião do autor, este é o resultado mais interessante deste artigo.

discutir

Para resumir, este documento apresenta uma abordagem independente de tarefa para incorporar pontos 3D em um espaço de recurso junto com pixels de texto e imagem e demonstra sua utilidade para compreensão de cena 3D de vocabulário aberto e zero-shot. Ele alcança segmentação semântica 3D de última geração em benchmarks padrão, supera métodos supervisionados em segmentação semântica 3D com muitos rótulos de classe e permite que novos aplicativos de vocabulário aberto consultem cenas 3D arbitrárias de texto e imagem sem usar quaisquer dados 3D rotulados. Esses resultados fornecem uma nova direção para a compreensão da cena 3D, orientando os sistemas de compreensão da cena 3D com modelos básicos treinados a partir de conjuntos de dados multimodais de grande escala, em vez de apenas usar pequenos conjuntos de dados 3D rotulados para treinamento.