Operação totalmente distribuída do Hadoop (ênfase)

(1) Prepare 3 clientes (fechar firewall, ip estático, nome do host)

(2) Instalar JDK

(3) Configurar variáveis de ambiente

(4) Instalar Hadoop

(5) Configurar variáveis de ambiente

(6) Configurar cluster

(7) Início de ponto único

( 8) configurar

o cluster ssh (9) e testar o cluster.A

máquina virtual deve realizar os seguintes testes:

nome do host

ping o nome do host atual

teste ip

ifconfig serviço de

firewall de teste

status iptables

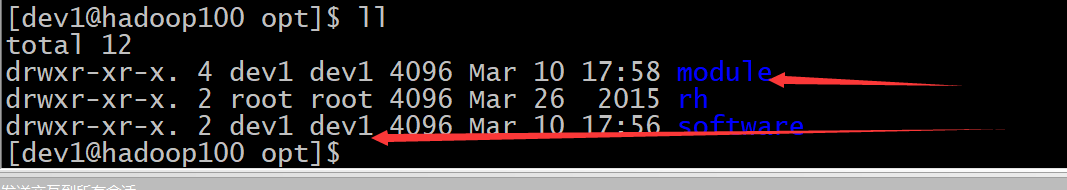

teste permissões de arquivo

ll / opt

scp (cópia segura) cópia segura (do servidor 1 para o servidor 2)

comando:

scp -r $pdir/$fname $user@hadoop$host:$pdir/$fname

命令 递归 要拷贝的文件路径/名称 目的用户@主机:目的路径/名称

Operar sob dev1 Por

exemplo:

cd /opt/module

scp -r /opt/module dev1@hadoop102:/opt/

Em seguida, hadoop101, hadoop102, hadoop103

e, em seguida, operação autorizada

chown dev:dev1 -R /opt/module

Autorizado com sucesso.

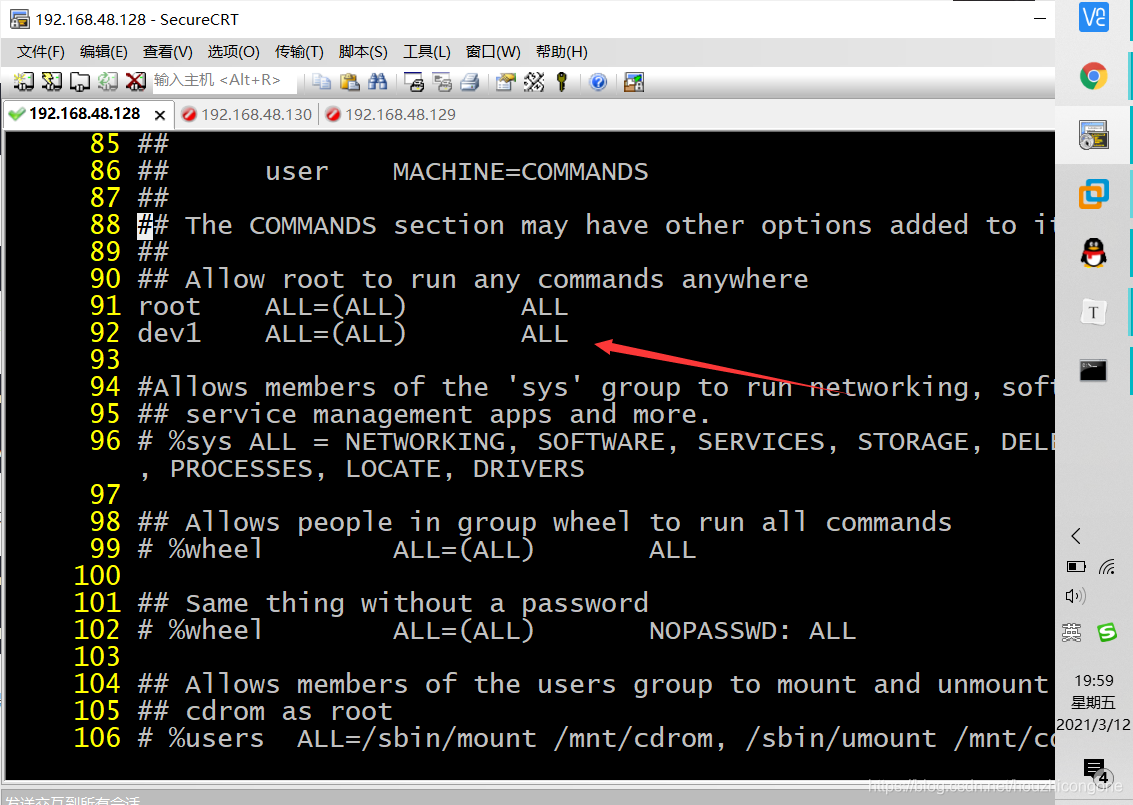

Se as permissões forem insuficientes, então

vi /etc/sudoers

Na set nulinha de comando de autorização abaixo mais 91 desenhando uma linha

pode

source /etc/sudoers

Faça o arquivo funcionar

O Rsync é um comando de sincronização rápido, mais rápido que o scp e

pode evitar a transmissão do mesmo arquivo. Tem a vantagem de ser rápido, evitando copiar o mesmo conteúdo e suportar links simbólicos.

rsync -rvl $pdir/$fname $user@hadoop$host:$pdir/$fname

命令 选项参数 要拷贝的文件路径/名称 目的用户@主机:目的路径/名称

Por exemplo

rsync -rvl /opt/software/ dev1@hadoop102:/opt/software