[Introdução ao caso]

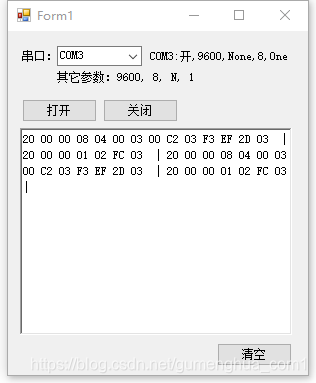

将serialPort类继承后稍做修改,并将其生成dll提交使用。

Arquivo: n459.com/file/25127180-478966362

[Captura de tela de exemplo]

[Código do núcleo]

private void ICP_DataReceived(object sender, System.IO.Ports.SerialDataReceivedEventArgs e)

{

Thread.Sleep(30);

byte[] 串口数据 = new byte[ICP.BytesToRead];

int 串口数据个数 = ICP.Read(串口数据, 0, 串口数据.Length);

ICP.DiscardInBuffer();

if (串口数据个数 <= 0) return;

引用委托写内容到显示(将字节直接显示(串口数据.ToList()));

}

private delegate void 委托写内容到显示(string 内容);

private void 引用委托写内容到显示(string 内容)

{

if (richTextBox1.InvokeRequired)

{

richTextBox1.Invoke(new 委托写内容到显示(写内容到显示), 内容);

}

else

{

写内容到显示(内容);

}

}

/// <summary>

/// 写一个字符串到richTextBox1

/// </summary>

/// <param name="内容"></param>

private void 写内容到显示(string 内容)

{

richTextBox1.Text = 内容;

richTextBox1.Text = " | ";

}

O seguinte é irrelevante:

-------------------------------------------Linha divisória----- ----------------------------------------

O Sistema de Arquivos Databricks (DBFS, Sistema de Arquivos Databricks) é um sistema de arquivos distribuído que é montado no espaço de trabalho do Azure Databricks e pode ser usado em um cluster do Azure Databricks. Um objeto de armazenamento é um arquivo com um formato específico e diferentes formatos têm diferentes mecanismos de leitura e gravação.

DBFS é uma abstração baseada no armazenamento escalonável de objetos, que pode aumentar e reduzir dinamicamente a quantidade de espaço de armazenamento usado de acordo com as necessidades do usuário. O DBFS carregado no Azure Databricks tem as seguintes vantagens:

Monte objetos de armazenamento e acesse dados perfeitamente sem credenciais.

Use a semântica de diretório e arquivo em vez de URLs de armazenamento para interagir com o armazenamento de objeto.

Salve o arquivo no armazenamento de objeto, para que nenhum dado seja perdido após o encerramento do cluster.

Azure Databricks é um sistema de computação distribuído. O cluster fornece recursos de computação, incluindo recursos como CPU, memória e rede. DBFS fornece espaço de armazenamento para dados e arquivos e a capacidade de ler e gravar arquivos. É uma parte muito importante do Azure Databricks. a infraestrutura.

1. Raiz DBFS O

local de armazenamento padrão no DBFS é chamado de raiz DBFS (raiz). Os seguintes locais raiz DBFS armazenam vários tipos de dados:

/ FileStore: arquivos de dados importados, desenhos gerados e bibliotecas

/ conjuntos de dados de banco de dados carregados : conjuntos de dados públicos de amostra, usados para aprender Spark ou testar algoritmos.

/ databricks-results: Arquivos gerados baixando os resultados completos da consulta.

/ tmp: o diretório para armazenar dados temporários

/ usuário: armazenar os arquivos de cada usuário

/ mnt: (invisível por padrão) arquivos carregados (montados) no DBFS, e os dados gravados no caminho do ponto de montagem (/ mnt) são armazenados em Fora do diretório raiz do DBFS.

No novo espaço de trabalho, a raiz DBFS tem as seguintes pastas padrão:

A raiz DBFS também contém dados invisíveis e inacessíveis, incluindo metadados e credenciais de ponto de montagem e certos tipos de logs.

Também há dois locais raiz especiais para DBFS: FileStore e Conjunto de dados do Azure Databricks.

FileStore é um espaço de armazenamento para armazenar arquivos. Os arquivos que podem ser armazenados estão em uma variedade de formatos, incluindo csv, parquet, orc e delta.

Conjunto de dados é um conjunto de dados de amostra por meio do qual os usuários podem testar algoritmos e Spark.

O acesso ao DBFS é geralmente por meio do módulo pysaprk.sql, dbutils e SQL.

Em segundo lugar, use o módulo pyspark.sql para acessar DBFS.

Ao usar o módulo pyspark.sql, faça referência ao arquivo parquet por meio do caminho relativo "/ temp / file". O exemplo a seguir grava o arquivo parquet foo no diretório DBFS / tmp.

# df.write.format ("parquet"). save ("/ tmp / foo", mode = "overwrite")

df.write.parquet ("/ tmp / foo", mode = "overwrite")

e por meio da API Spark Leia o conteúdo do arquivo:

#df = spark.read.format ("parquet"). load ("/ tmp / foo")

df = spark.read.parquet ("/ tmp / foo")

Três, use SQL para acessar DBFS

para formato delta e formato parquet Você pode acessar o DBFS por meio de delta. file_pathOu parquet. Em SQL file_path:

selecione *

em delta./tmp/delta_file

selecione *

do parquet. /tmp/parquet_file

Observe que o formato do arquivo deve ser o mesmo do comando estendido, caso contrário, um erro será relatado; o caminho do arquivo não está entre aspas simples, mas é obtido através de ``.

Quarto, use dbutils para acessar DBFS

dbutils.fs fornece comandos semelhantes ao sistema de arquivos para acessar arquivos em DBFS. Esta seção fornece vários exemplos de como usar o comando dbutils.fs para escrever e ler arquivos em DBFS.

1. Visualize o diretório DBFS

No ambiente python, você pode usar dbutils.fs para visualizar os arquivos no caminho:

display (dbutils.fs.ls ("dbfs: / foobar"))

2, ler e gravar dados

Grave e leia arquivos na raiz DBFS como se fosse um sistema de arquivos local.

Copiar código

criar pasta

dbutils.fs.mkdirs ("/ foobar /")

escrever dados

dbutils.fs.put ("/ foobar / baz.txt", “Olá, mundo!”)

ver cabeça

dbutils.fs.head ("/ foobar / baz.txt")

remover arquivo

dbutils.fs.rm ("/ foobar / baz.txt")

copiar arquivo

dbutils.fs.cp ("/ foobar / a.txt", "/ foobar / b.txt")

Copie o código

3, arquivo de ajuda do comando

dbutils.fs.help ()

dbutils.fs inclui principalmente dois módulos: fsutils para manipular arquivos e montar para montar arquivos

fsutils

cp (de: String, para: String, recurse: boolean = false): boolean -> Copia um arquivo ou diretório, possivelmente através do

cabeçalho FileSystems (arquivo: String, maxBytes: int = 65536): String -> Retorna até o primeiros bytes 'maxBytes' do arquivo fornecido como uma String codificada em UTF-8

ls (dir: String): Seq -> Lista o conteúdo de um diretório

mkdirs (dir: String): boolean -> Cria o diretório fornecido, se assim for não existe, criando também quaisquer diretórios pais necessários

mv (de: String, para: String, recurse: boolean = false): boolean -> Move um arquivo ou diretório, possivelmente entre FileSystems

put (arquivo: String, conteúdo: String, sobrescrever: boolean = false): boolean -> Grava a string fornecida em um arquivo, codificado em UTF-8

rm (dir: String, recurse: boolean = false): boolean -> Remove um arquivo ou diretório

mount

mount (source: String, mountPoint: String, encryptionType: String = “”, owner: String = null, extraConfigs: Map = Map.empty [String, String]): boolean -> Monta o diretório de origem fornecido no DBFS no determinadas montagens de ponto de

montagem: Seq -> Exibe informações sobre o que é montado em DBFS

refreshMounts: boolean -> Força todas as máquinas neste cluster a atualizar seu cache de montagem, garantindo que recebam as informações mais recentes

desmontar (mountPoint: String): boolean -> Exclui um ponto de montagem DBFS