Construção da plataforma EFK (ALIYUN)

Preparação ambiental: k8s-master01 k8s-node2 k8s-node2

Observação: este ambiente requer uma alocação de memória de cerca de 10 G, e vários pontos de memória precisam ser configurados para o nó do pod

Nó do medidor:

Adicionar aliyun, aliyuncs, google warehouse

helm repo add aliyun https://kubernetes.oss-cn-hangzhou.aliyuncs.com/charts helm repo add aliyuncs https://apphub.aliyuncs.com helm repo add incubator http://storage.googleapis.com/kubernetes- incubadora de gráficos

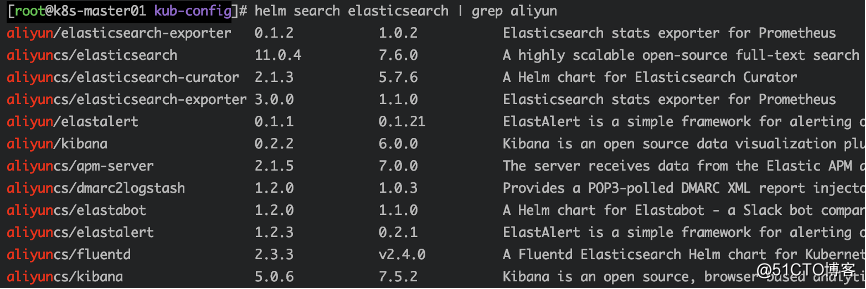

Veja as versões disponíveis

elm search elasticsearch | grep aliyun

Criar diretório de arquivo

mkdir efk cd efk /

Crie um namespace de namespace

kubectl create namespace efk

Baixe os arquivos elasticsearch, fluentd e kibana

helm fetch aliyuncs / elasticsearch --version = 11.0.4 (v2.4.0) helm fetch aliyuncs / fluentd --version = 2.3.3 helm fetch aliyuncs / kibana --version = 5.0.6

Descompactar

tar -xf elasticsearch-11.0.4.tgz tar -xf kibana-5.0.6.tgz tar -xf fluentd-elasticsearch-2.0.7.tgz

Implantar ELASTICSEARCH

Com base nos recursos limitados do experimento, a configuração precisa ser reduzida

vim elasticsearch / values.yaml

mestre: nome: mestre

## Número de réplicas de nó (s) qualificado (s) mestre para implantar

##

réplicas : 1 # O número de réplicas é 1

…

persistência:

## Se verdadeiro, use uma reivindicação de volume persistente, se falso, use emptyDir

##

ativado : falso #Close pv disk montagem

…

coordenando:

## Número de réplicas de nó (s) apenas de coordenação para implantar

##

réplicas : 1 # O número de réplicas é 1

…

dados:

nome: dados

## Número de réplicas de nó (s) de dados para implantar

##

réplicas : 1 # O número de réplicas é 1

…

persistência:

## Se verdadeiro, use uma reivindicação de volume persistente, se falso, use emptyDir

##

ativado : falso #Close pv disk montagem

…

ingerir :

habilitado: falso

nome: ingest

## Número de réplicas de nó (s) de ingestão para implantar

##

réplicas : 1 # O número de réplicas é 1

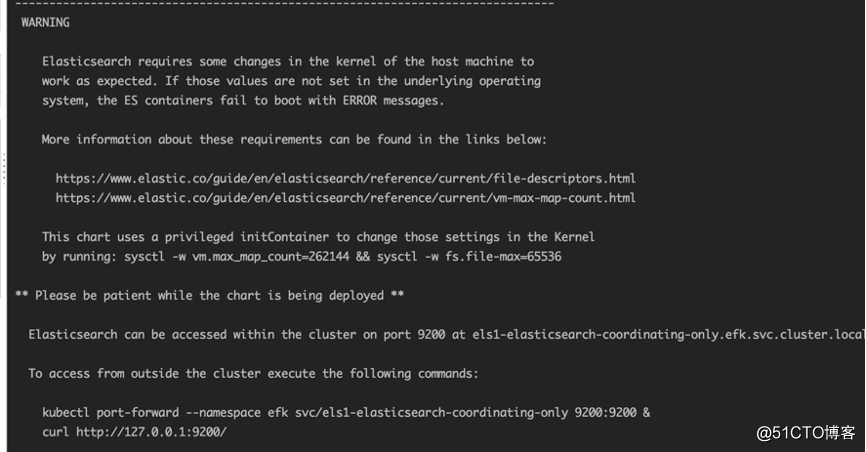

Especifique onde os valores estão localizados no diretório es e implemente

cd elasticsearch helm install --name els1 --namespace = efk -f values.yaml.

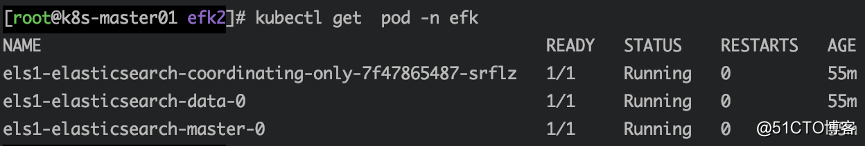

Ver pod

kubectl get pod -n efk

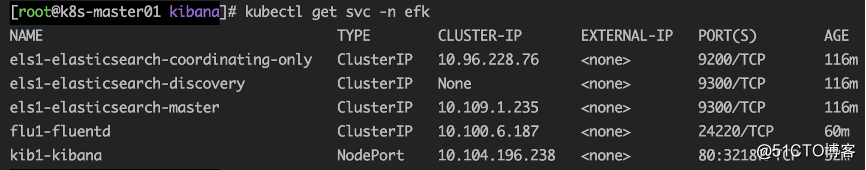

Ver svc

kubectl get svc -n efk

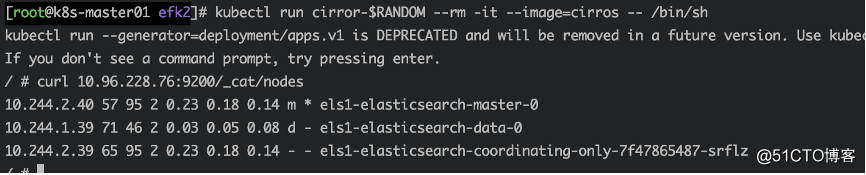

Execute o pod para obter o teste de dados do cluster

kubectl run cirror- $ RANDOM --rm -it --image = cirros - / bin / sh

Obtenha esses dados por meio do curl Elasticsearch: Port / _cat / nodes

curl 10.96.228.76:9200/_cat/nodes

Implantar FLUENTD

cd fluentd- elasticsearch vim values.yaml

# Altere o endereço de acesso Elasticsearch

host: ' elasticsearch-client ' alterado para

host: '10.96.228.76 '

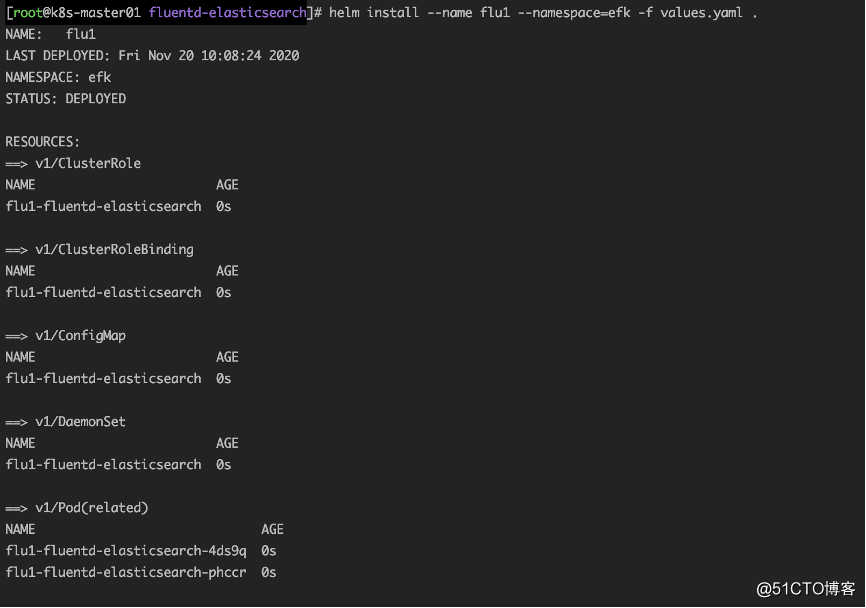

Implante fluentd-elasticsearch onde os valores estão localizados no diretório fluentd

helm install --name flu1 --namespace = efk -f values.yaml.

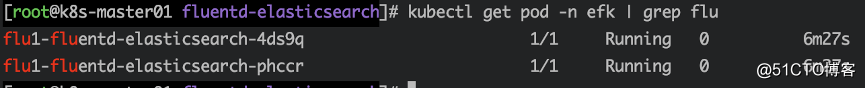

Ver pod

kubectl get pod -n efk | gripe grep

Departamento KIBANA

cd kibana vim values.yaml

persistência:

ativado : falso #Close pv disk montagem

serviço:

porta: 80

tipo : NodePort #svc modo de rede

elasticsearch:

hosts :

-10.96.228.76 #es endereço

porta: porta 9200 #es

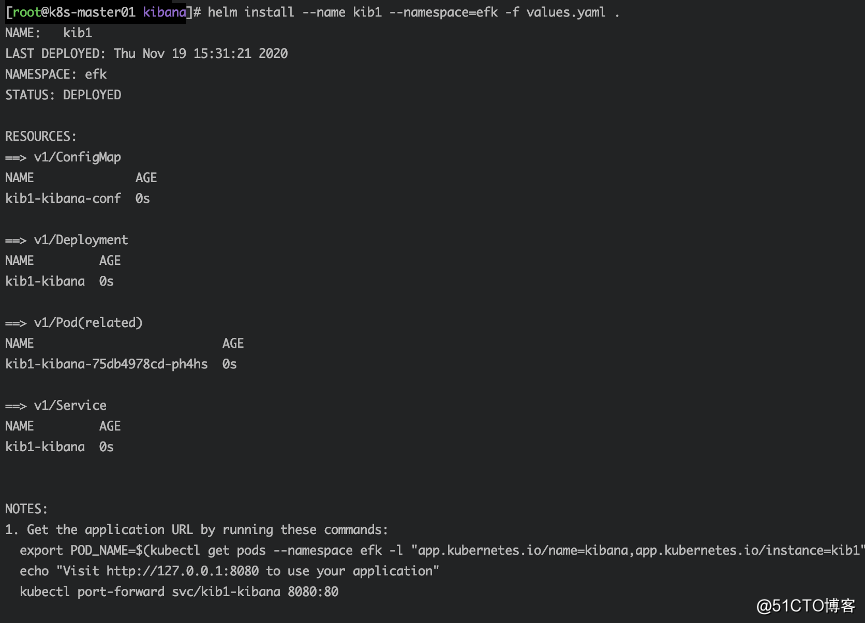

Especifique a localização dos valores no diretório kibana e implemente o kibana

helm install --name kib1 --namespace = efk -f values.yaml.

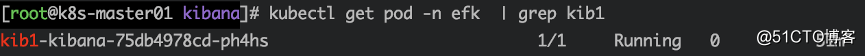

Ver pod

kubectl get pod -n efk | grep kib1

Verifique svc, obtenha a porta

kubectl get svc -n efk

Questão KIBANA

visita do google

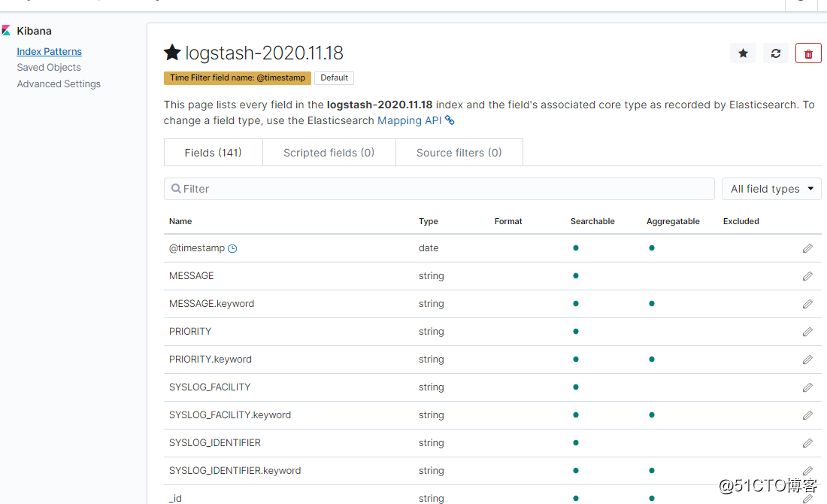

Novo índice

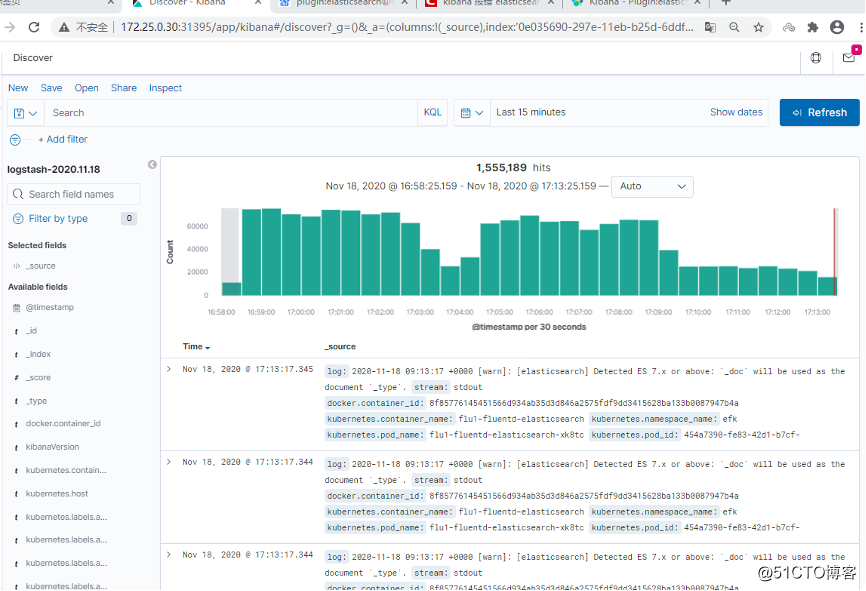

Veja os dados adquiridos

Até agora, está feito. Outros podem ser estudados lentamente.