이 문서는 DQN이, DRL 필드는 매우 중요 기사뿐만 아니라 데이비드 실버 큰 하나님의 일입니다. 이 기사 자체는 어렵지 않다.

이 기사는 RL과 DL 사이의 두 가지 차이점이 말했다

보강은 스칼라 보상을 학습하고, 보상 시끄러운, 스파 스, 가능성이 지연되고, DL 특히지도 학습이 표시 훈련 많은 데이터를 필요 -

- DL은 일반적으로 데이터가 독립적이고 동일하게 분포되어 있다고 가정 하지만 이전과 높은 상관 관계의 학습 후 데이터를 강화하기 위해, 데이터 분포가 변경됩니다

DQN이 동일 실제로 신경 네트워크를 Q-학습, 기초 이론의 버전은 신경 네트워크에 의해 발생하는 몇 가지 문제를 해결하기 위해 이동

벨만 최적 식 : \ (Q _ * (S, A) = E_ {S '\ SIM \ varepsilon} [R + \ 감마 \ 저류 {A'} {최대} Q (S ', A') | S, A] \ )

목적 함수를 최적화하기 위해, GPI에 값을 반복 사용하다 :

\ [L_i (\ theta_i) = E_ {S, A \ SIM \의 Rho (\ CDOT)} (y_i-Q (S, A의; \ theta_ {I})) ^ 2] \]

\ (\은 Rho (S, A)는 \) , 동작 분포 \ (y_i = E_의 {S '\ SIM \ varepsilon} [R & LT + \ 감마 \ 저류 {A'} {최대 } Q (S '은' ; \ {theta_ I-1}) | S, A] \)

화학식 유도체를 찾는 이후 (세미 구배)

\ [\ 블라 _ {\ theta_i} L_i (\ theta_i) = E_ {S, A \ SIM \ RHO (\ cdot) S '\ SIM \ varepsilon} [R + \ 감마 \ 저류 {A'} {최대} Q ( S '는'; \ {theta_ I-1}) - Q (S, A, \ theta_i)) \ 블라 _ {\ theta_i} Q (S, A, \ theta_i)] \]

데이터 분배의 문제를 해결하기 위해, 경험의 재생을 사용

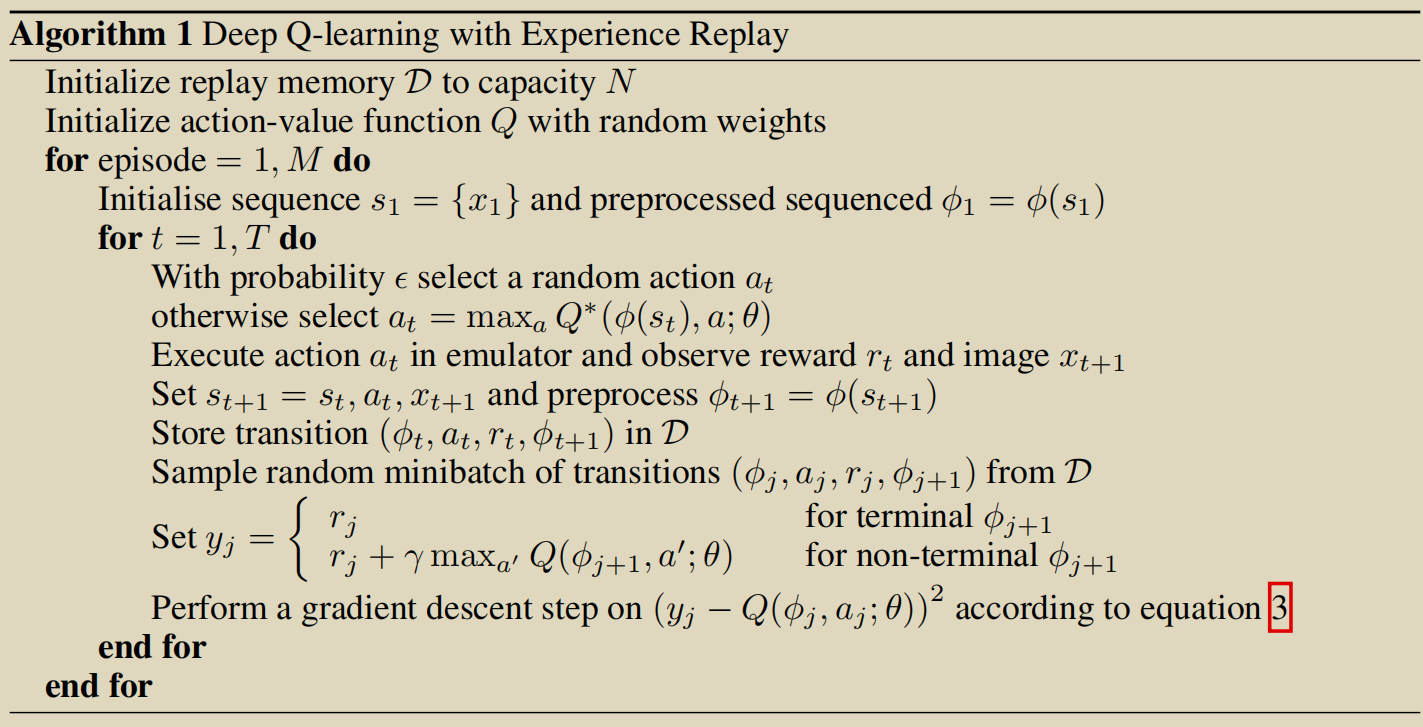

알고리즘 :

알고리즘의

장점 : 1. 경험의 모든 단계는 데이터 효율 향상, 사용을 반복 할 수있는

어느 정도의 분산을 줄이고 랜덤 샘플 버퍼 재생 2. 체류에게 데이터 간의 링크를

3. 오프 정책을 더 부드럽게, 쉽지 않은 지역 최적에 해당하는 것입니다