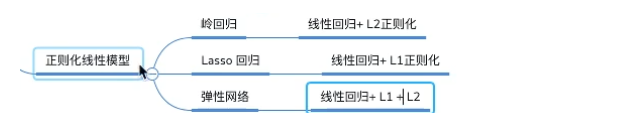

正則化線形モデル

1.Ridge回帰(リッジ回帰も知らティホノフ正則)

+ L2通常の線形回帰

特定の損失関数

+ =損失関数目的関数正則化項

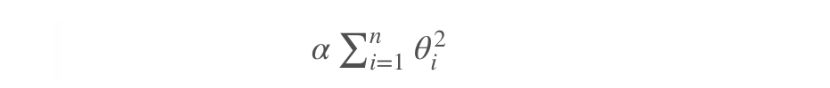

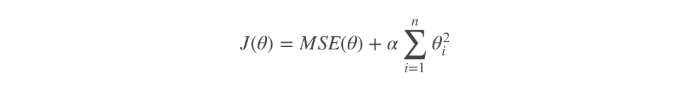

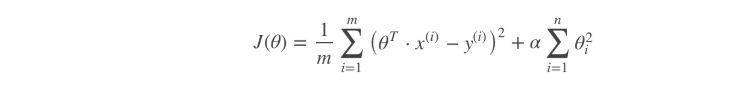

リッジ回帰は、元の線形回帰のコスト関数に正則(正則化項)を添加し、線形回帰の定期的なバージョンです:

同時に達成するために合うデータ、モデルの重みは、可能な目的として小さなとして、リッジ回帰コスト関数:

その

- α= 0:リッジ回帰は、線形回帰縮重しています

2.Lasso復帰

線形回帰+ L1のカノニカル

なげなわリターンは、線形回帰、重みベクトルノルムの正規ℓ1エントリの別の定期的なバージョンです。

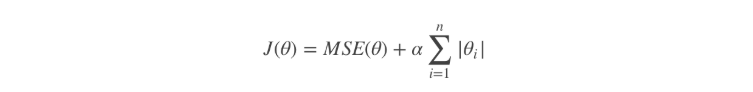

コストなげなわ回帰関数:

[注]

- θiを= 0に投げ縄回帰コスト関数は、非導電性です。

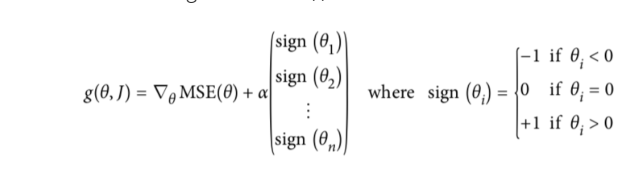

- 溶液:θiを= 0の代わりに勾配ベクトル(劣勾配ベクトル)の勾配の時に、下記式

- 投げ縄回帰二次勾配ベクトル

なげなわ回帰は、非常に重要な特性があります:完全に重要でない重みを排除する傾向があります。

例えば:α値が比較的大きい場合、二次偶数次多項式の劣化が線形である:右次多項式特徴重みはゼロに設定されます。

すなわち、ラッソ回帰特徴選択を自動的に行うことが可能であり、そして(右の重量がゼロでほんの数そのうち)疎なモデルを出力します。

3.弾力性のネットワーク

最初の二つは、リッジ回帰+投げ縄リターン、一緒に融合しました

柔軟なネットワークなげなわとリッジ回帰回帰は妥協した、によって比率(混合比)混合rを制御します:

- R = 0:ネットワークは、弾性リッジ回帰なります

- R = 1:弾性ネットワークは、投げ縄に戻ります

弾力性のあるネットワークのコスト関数:

一般的に、我々はの使用は避けるべき単純な線形回帰方法を正則化法を選択すること、特定の正則化プロセスをモデル化するために、その応答を?

要約:

-

共通:リッジ回帰

-

機能のほんの一部分が有用であると仮定すると:

- 弾性ネットワーク

- なげなわ

- 一般的には、ネットワークの耐障害性のより広範な使用。訓練サンプルの数よりも特徴的寸法の大きいため、または強い関連する状況によって特徴付けられる、投げ縄戻り性能が安定していません。

-

API:

-

from sklearn.linear_model import Ridge, ElasticNet, Lasso

-

4.Earlyの停止

厳密ではない正則を話します

早期の停止は、正則反復学習法の一つです。

そのアプローチは次のとおりです。検証エラー率に訓練を停止するには時間の最小値に達します。