紙タイトル:単一画像超解像のための深い学習:簡単なレビュー

I.Sections

section2の:背景の概念

SECTION3:効率的なニューラルネットワークアーキテクチャforSISR

section4:使用異なるSR

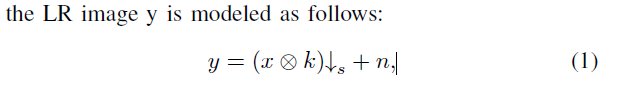

II.Backgrounds

1.

2.Interpolationベース例えばバイキュービック補間などSISRの方法、

[10]とランチョスリサンプリング[11]

3.LearningベースSISR方法:

3.1.Theマルコフ確率場(MRF)[16]のアプローチは、最初フリーマンらによって採用されましたアル。視覚的に満足の画像テクスチャを合成するために豊富な実世界の画像を利用します。

3.2.Neighbor Changらによって提案された方法[17]を埋め込みます。HR画像パッチを復元するために、LRとHRの間で同様のローカルジオメトリを利用しました。

スパース信号回復理論[18]によって3.3.Inspiredは、研究者は、スパースコーディング方法[19]、[20]、[21]、[22]、[23]、[24] SISRの問題を適用しました。

3.4.Lately、ランダムフォレスト[25]また、再生性能の向上を達成するために使用されてきました。

3.5.Meanwhileは、多くの作品は、外部トレーニング例[26]、[27]、[28]、[29]によって導入されたアーティファクトを低減するために、学習ベースのアプローチとの再構成に基づく方法の利点を組み合わせます。

4.deep学習:

人工ニューラルネットワーク(ANN)[32] - >畳み込みニューラルネットワーク(CNN)[35] - >リカレントニューラルネットワーク(RNN)[36] - >制限ボルツマンマシン(RBM)とDNNを事前訓練- >深いボルツマンマシン(DBM)[42]、変オートエンコーダ(VAE)[43]、[44]及び生成的敵対ネット(GAN)[45]

III.DEEPアーキテクチャ用のSISR

近年のSISRのために提案された効率的なアーキテクチャを議論します。

SISRのためのディープアーキテクチャのA.Benchmark

- SRCNN:三層CNNCNN、フィルタ

各層のサイズは64 * 1 * 9 * 9、32 * 64 * 5 * 5と1 * 32 * 5 * 5である

損失関数:平均二乗誤差(MSE)

- 問題:

①最初の質問は出てくる:私たちは、直接これらの問題に対処するための入力としてLRを実装CNNアーキテクチャ設計することができます

どのように我々はより複雑なようなモデルを設計することができますが②?

B.最先端のディープSISRネットワーク

CNNと学習効果的なアップサンプリング:

- アップサンプリング動作:デコンボリューション[50]、または転置畳み込み[51]は

アップサンプリング係数を考えると、デコンボリューション層1のストライドで任意の補間演算(通常、我々は簡単にするために最近傍補間を選択)し、以下の畳み込み演算子で構成されています、図3に示すように、3(近邻插值、乘卷积核)