四日目は、今日は一部を見て来たので、多くの問題...長い時間のためのいくつかの単語と無関連する解釈があり、また、シリーズの前回の記事と一緒にそこにいくつかの興味深い言葉がありますが、しかし、比較的新しい用語の数のため、それ以降の良いモデルの多くは、18年で技術革新が登場し、NAは本当に無限の学習を見つけるdug'll。

しっかりと基盤を強化します。puqにオーストリア!

今日よりボー:ペーパー3.4 3.5 3.6

訂正:

REID 3日目のユークリッド距離とコサイン距離との関係は、ジェーンの間違ったの最終工程において、最後の工程由来のABを、のように記述することができないDIST(A、B)がなるように、ユークリッド距離やユークリッド距離の素晴らしい変換エラー。したがって、最後のステップ1-DIST(A、B)削除することによって。白の学生のおかげで修正します!!

本体:

(1)画像の特徴ベクトル:

このラダーと対応する勾配で、例えば、画像が基準台形として中心に良いエッジが検出された、各セルの勾配方向が観察された、我々は平坦化することができ、このデータは、一次元配列を作成するためにどのこれは特徴ベクトルであり、同様に、以下の円形の特徴ベクトルは、同じ方法を使用して抽出されます。エッジを検出するための基準として中心に、各ユニットで観察された勾配方向であった、そして次に対応する固有ベクトル(一次元配列)を作成します。

(2)スパッツネットとモティネット二つのネットワーク導入該当原理

(3)カテゴリーロス:私自身のクロスエントロピーを使用する前には、より多くの、私は機能のそんなに損失がある気づいていないされて....正と負のサンプル間のこの大きな差に帰着する、の使用削減指数損失を、なぜなら全体のを減らすことになる、コストの影響を予測するために、他の通常のデータポイントを犠牲にして、おそらく処罰され、この時点右のポイントを作るためにグループにはるかに大きな重みにおけるその役割の過程で距離ポイント可能ですが、分類のパフォーマンスは、それが(あまり良くない効果と安定性を参照してください)(堅牢)堅牢ではありません。

分類は、損失関数を帰せ:https://blog.csdn.net/weixin_41065383/article/details/89413819

(4)深研究を抽出深機能を使用:現在一般的に使用されるがありますトリプレット損失と改善四重損失は、すなわち、私たちは前に述べたトリプル損失およびクワッド損失は二つの方法である学習測定します。

同様に、正則化制約のための学習ハッシュコーディング方法がここにあります(私はないLuanjiangアップに、持っていないので...)探求することではありません

(5)解決が困難自分の問題今日:重いMSVF権設定が設定されているか、なぜ、からの平均画像特徴小さい与えられたフレーム画像となり、高重量が、それは指数関数的損失であります差がより与える大きな重みを、なぜですか?関連する情報を検索し、答えを与えるためにMSVFの必要性... = =穴を掘ります

(6)注意機構画像:一般NLPで使用される注意のメカニズムこの記事では、私は注意のメカニズムは写真のために使用することができるかわからない前に、私は見ませんでした.....

次のように関連するリンク、これは私自身の理解と話に基づいて、私はいくつかの記事を見つけましたが、それはビットぎくしゃくを感じています:

https://www.jianshu.com/p/9b922fb83d77

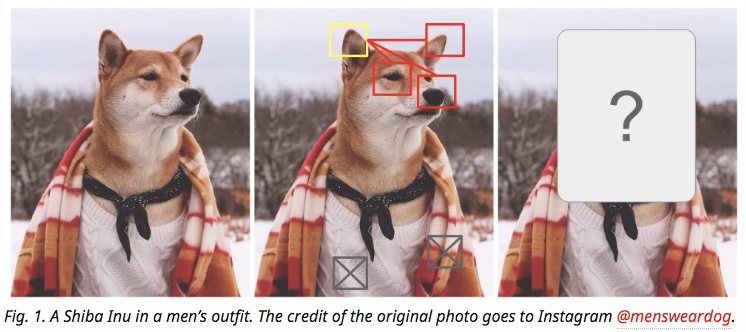

簡単な概要の画像下の注意メカニズムについて:まず、注意メカニズムが何であるかを、私たちは限られた資源の効率的な配分になる画像を見たとき、注意、とき栗を与え、理解することができます示したように、私たちは、犬等犬の鼻、目、であることを確認するために注意を払うだろう 、そして同じ、ここでの学習の深さは、注意機構の中核目的は、情報の数から、現在のミッションの目的の多くの重要な情報を選択してください。

、そして同じ、ここでの学習の深さは、注意機構の中核目的は、情報の数から、現在のミッションの目的の多くの重要な情報を選択してください。

ここでは、NLPで使用される注意のメカニズムを話さない、我々は、画像処理での使用について話しています。

最も注意がエンコーダ・デコーダの枠組みでモデルに添付されたとして注目モデルを学習の深さを理解するために、あなたは、エンコーダ・デコーダのフレームワークで開始する必要があり、当然のことながら、実際には、注意モデルが一般的な考え方として見ることができ、自身が注意を必要とする特定のフレームワークに依存しません。

NLPのエンコーダ・デコーダは、それが何であるかに古典的なモデルは、画像処理(画像の説明)ですか?図:

此时encoder输入部分是一张图片,一般会用CNN来对图片进行特征抽取,decoder部分使用RNN或者LSTM来输出自然语言句子

此时如果加入注意力(Attention)机制能够明显改善系统输出效果,Attention模型在这里起到了类似人类视觉(即我们上面所谈)选择性注意的机制,在输出某个单词的时候会将注意力焦点聚焦在图片中相应的区域上,在处理过程中的图片,如下:

会发现机器在进行图像处理的时候是把注意力集中放在不同位置的,即每个单词也有相应的注意力聚集区域。

这个是图像处理范围中的,没有找到给图像赋予权值的相关资料,但我们通过这种图像处理和之前的图像切块,也可以大致地猜测出,对每一帧图像赋予权重的过程实质上也是利用Attention机制对每张图的不同特点进行了一个分析,然后根据先前的模型(利用LSTM)赋予不同图片相应的权值。(仅个人理解,咳咳QWQ)

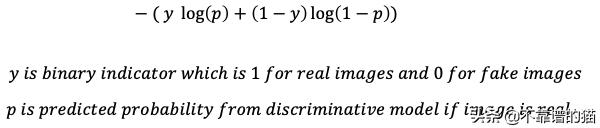

最小化判别损失:这个也就是我们前面所讲的GAN中所涉及的。判别(判别模型D)损失函数是一个与二元分类器(二元即两张不同出处的图片)相关的正则交叉熵损失函数。根据输入图像,损失函数中的一项或另一项将为0,结果将是模型预测图像被正确分类的概率的负对数。换句话说,对于真实图像,“y”将为“1”,对于假图像,“1-y”将为“1”。“p”是图像是真实图像的预测概率,“1-p”是图像是假图像的预测概率。式子如图:

当然啦,在GAN中我们需要把p全部换成D(x),即判别图像正确的概率,或者你也可以把最后一个p换成D(G(x)), 这样的式子就是网上大多数GAN原理的表达式了。

(7)L2损失:既然谈到了L2损失,我们把L1损失和L2损失一起说了伐,放在一起好记emmm

首先,最容易想到的损失函数的定义,就是逐像素比较差异。但为了避免正值和负值相互抵消,我们可以对像素之差取绝对值或平方。

那么取绝对值则是L1损失:

取平方则是L2损失:

那么,它们有什么区别呢,为什么在损失中我们采用的是L2损失讷?

注意L2和L1有什么区别? 康!是不是L2多了一个平方,那么当误差较小(t<=1)时,这个平方是能容忍这个误差的,使它更小一点,而当(t>1)时,这个平方就会放大误差,使它收到更严重的惩罚,然后被out。那么,除此之外,它们也差不多hmmm....

而且,最近的文章也会发现L2损失会出现图像模糊等问题,开始了它的优化版SSIM、MS-SSIM损失函数,这个因为还不涉及,不往下探讨。

(8)孪生网络:这个网络有个很有意思的背景,理解起来也相对其他网络简单,这里直接放链接了,可以康康故事,故事挺有意思的,这篇回答也以问答式呈现,能更好的理解这个网络。

相关链接:https://www.jianshu.com/p/92d7f6eaacf5

(9)InfoGAN: 为什么没有用传统GAN讷?因为在传统GAN中generator(G)的输入是一个连续的噪声信号,并且没有任何约束,导致GAN将z的具体维度与输出(output)的语义特征对应起来,可解释性很差,所以引入了infoGAN。这个我接触的不多,怕引导错大家,自己找了一个比较好理解的

相关链接如:https://blog.csdn.net/wspba/article/details/54808833

今天的学习进度有点慢,有很多新知识和查不到的新知识hmmm...会努力找齐资料的!