E LKクラスター展開環境の準備

ELK ログ分析システムを構成する

| 1 92.168.108.67 |

任意の-node1 |

エス、ログスタッシュ、キバナ |

| 1 92.168.108.189 |

任意のノード2 |

エス、ログスタッシュ |

| 1 92.168.108.32 |

パッチ_ |

ログスタッシュ |

3 つの仮想マシンの構成を増やす

3 台のコンピュータのファイアウォールをオフにする

名前を変更する

![]()

![]()

![]()

1. 2台のコンピュータがファイルを解析するホストを構成します

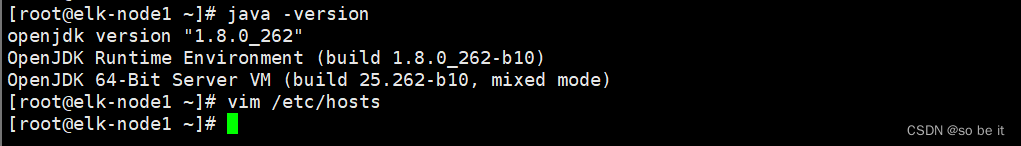

1 と 2は両方とも、独自の Java 環境を持つシステムを使用します。

Javaのバージョンを表示する

java -バージョン

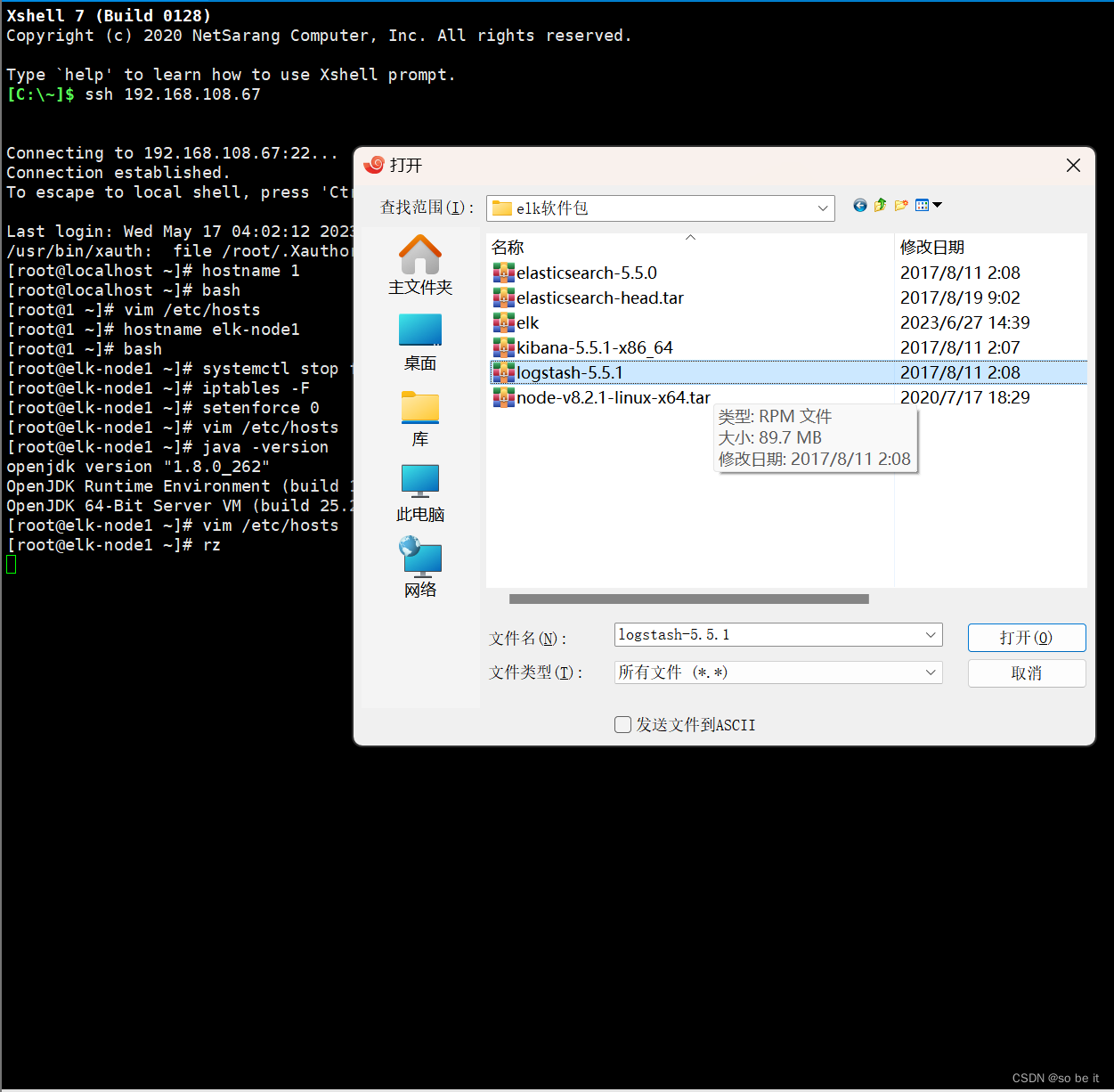

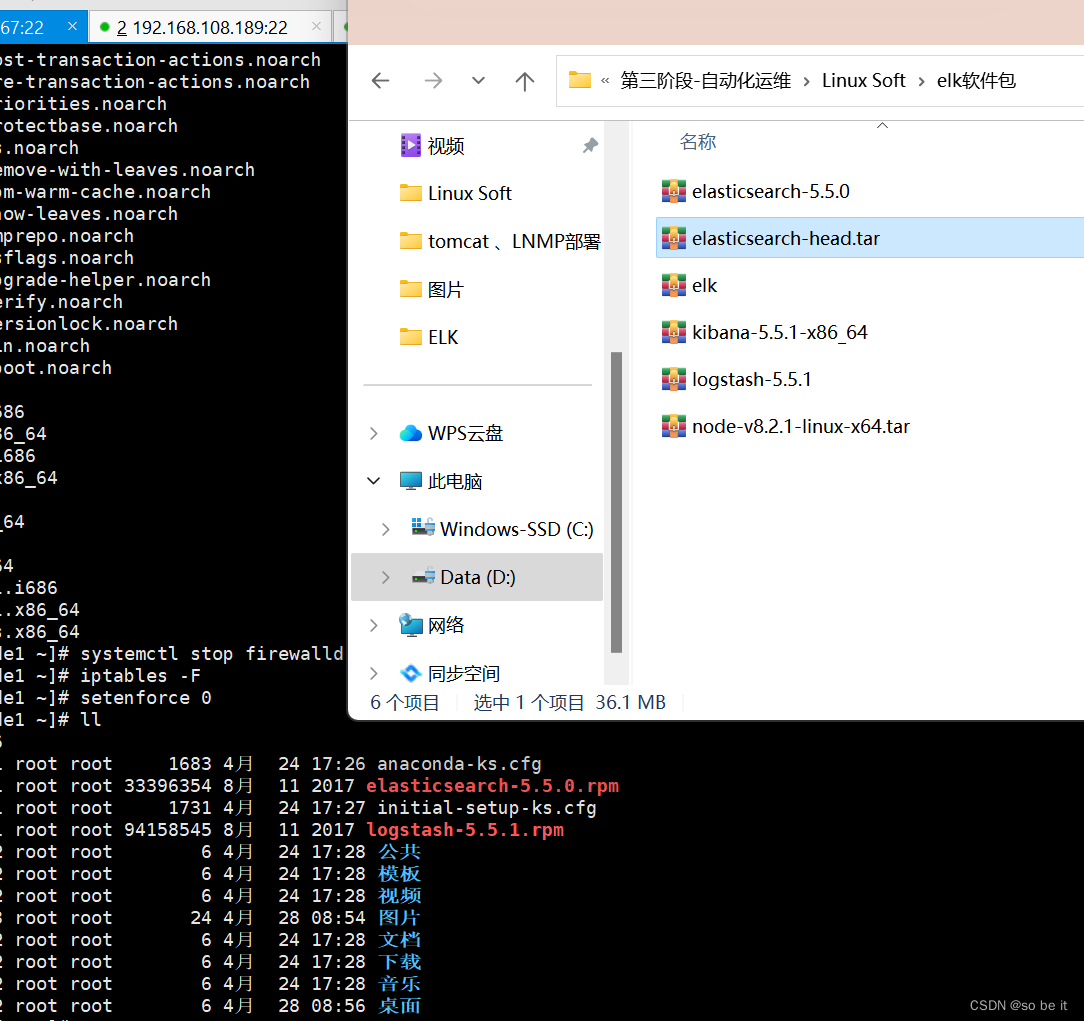

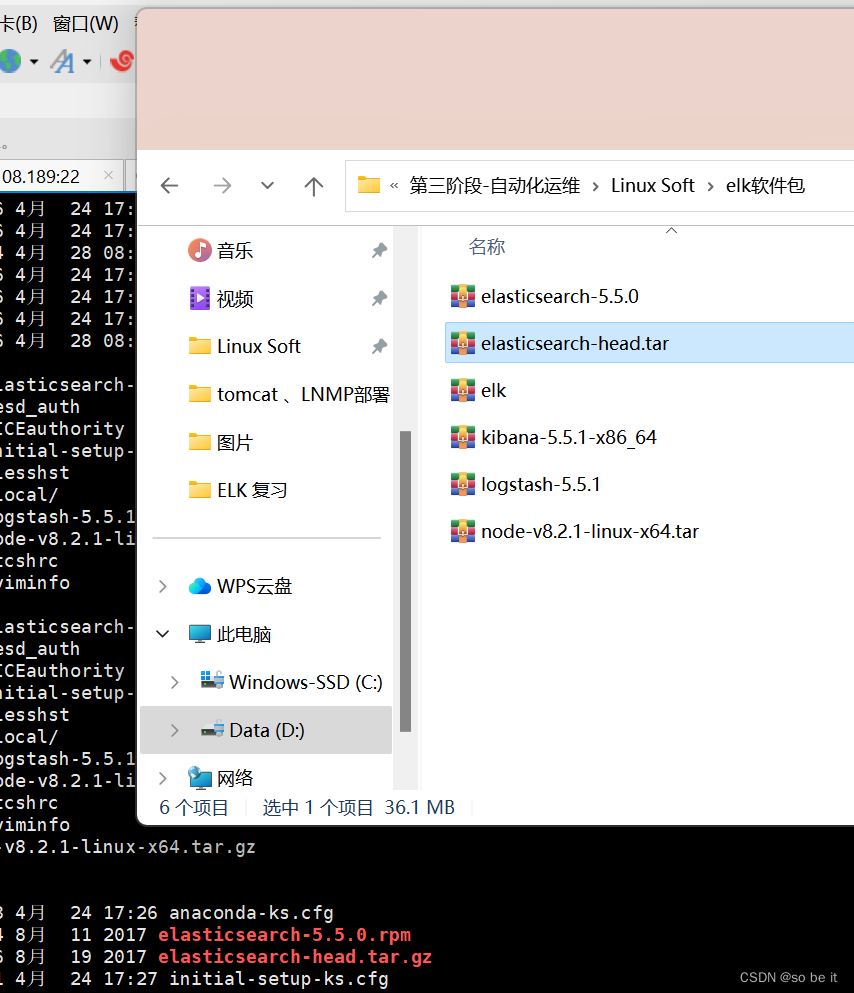

2 つのrz ユニットがソフトウェア パッケージをアップロードします。最初のユニットはすべてのソフトウェア パッケージをアップロードし、2 番目のユニットは 3 つのソフトウェア パッケージのみをアップロードします。

[必要に応じてアップロードすることもできます]

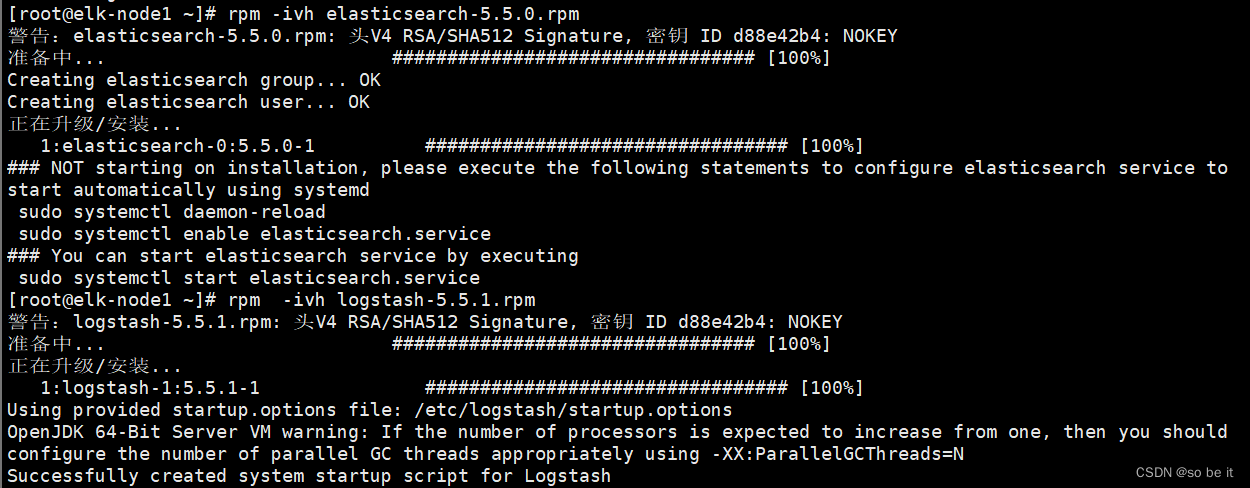

elasticsearchソフトウェア (rz logstash-5.5.1.rpm およびelasticsearch-5.5.0.rpm )をインストールします。

No.1、2 _ _

No.1、2 _ _

rpm -ivh elasticsearch-5.5.0.rpm

rpm -ivh logstash-5.5.1.rpm

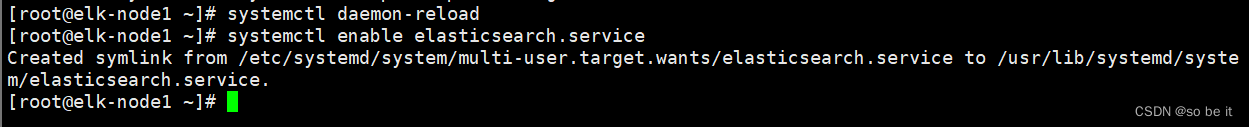

システム内のサービスを再識別し、起動時に自動的に開始するように設定します。

systemctl デーモンのリロード

systemctl は elasticsearch.service を有効にします

ノード1とノード2の構成ファイルを変更します。

vim /etc/elasticsearch/elasticsearch.yml

http.cors.enabled: true

http.cors.allow-origin: "*"

ディレクトリを作成し、ユーザーとグループをelasticsearchに変更します。

mkdir -p /data/elk_data

chown elasticsearch:elasticsearch /data/elk_data/

![]()

elasticsearch.service を開始し、ポートを表示します。

systemctl は elasticsearch.service を開始します

netstat -anpt | グリップ9200

出てくるまでに少し時間がかかります

アクセスノードIP

アクセスノードIP

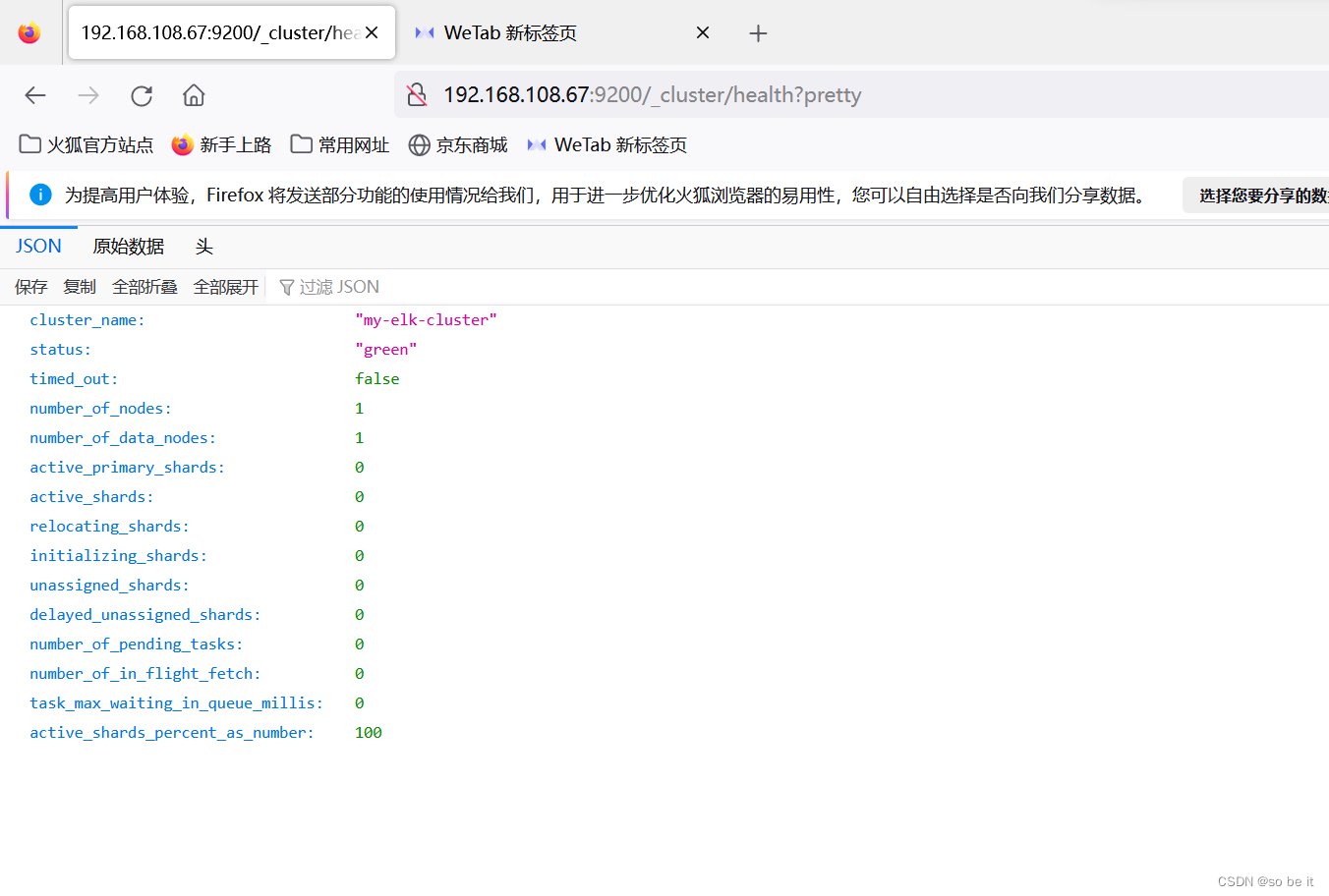

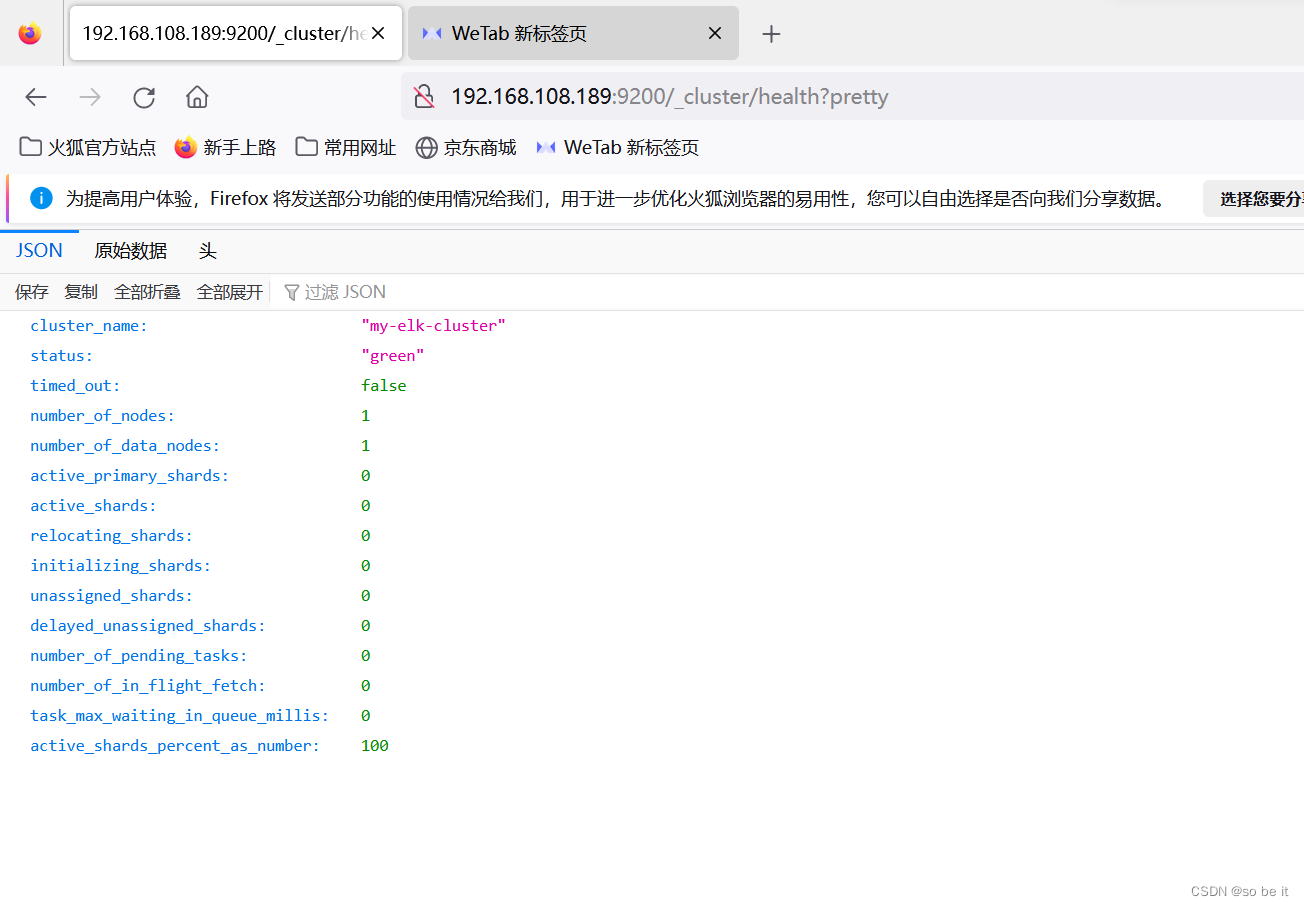

クラスターの健全性ステータスを確認します (緑色のnは健全性を表します)。

http://192.168.108.67:9200/_cluster/health?pretty

http://192.168.108.189:9200/_cluster/health?pretty

チャンネル1

elasticsearch -headプラグインをインストールする

ソフトウェア パッケージを解凍します (rz pull in node-v8.2.1-linux-x64.tar.gz )。

解凍する

tar xf ノード-v8.2.1-linux-x64.tar.gz -C /usr/local/

リンクを作成する

ln -s /usr/local/node-v8.2.1-linux-x64/bin/node /usr/bin/node

ln -s /usr/local/node-v8.2.1-linux-x64/bin/npm /usr/local/bin/

バージョンを表示

ノード -v

npm -v

headパッケージを解凍します( rz pull in elasticsearch-head.tar.gz )。

解凍する

tar xf elasticsearch-head.tar.gz -C /data/elk_data/

elk_dataに cd します

cd /data/それぞれのデータ/

ユーザーとグループを変更する

chown -R elasticsearch:elasticsearch elasticsearch-head/

elasticsearch-headに cd /ダウンロード

cd elasticsearch-head/

npmをインストールする

npmインストール

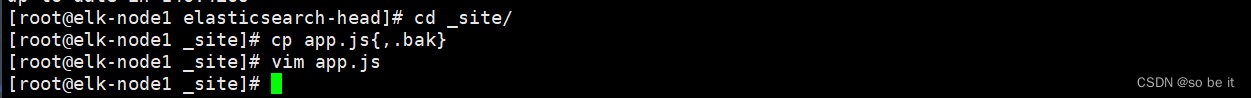

cd でsite/に移動し、app.jsのバックアップを作成して編集します。

cd_サイト/

cp app.js{,.bak}

vim アプリ.js

行 4329 を見つけて、それを自分の IP に変更します。

![]()

npmを起動してelasticsearchを起動します

npm 実行開始 &

systemctl アクセス後にnode2が見つからない場合は elasticsearchを開始します

cd /data/それぞれのデータ/

rm -rf ノード/

ポートに 9100 があるかどうかを確認します

netstat -lnpt | グリップ9100

ip にアクセスしてノードを表示します

データ挿入テストのタイプはテストです

curl -XPUT 'localhost:9200/index-demo/test/1?pretty&pretty' -H 'Content-Type: application/json' -d '{ "user": "zhangsan","mesg":"hello word" } '

http://192.168.200.111:9100/を更新して、インデックスが変更されたかどうかを確認します

ログスタッシュをインストールする

最初のノードにlogstashをインストールします1

rpm -ivh logstash-5.5.1.rpm

logstashサービスを開始し、ソフト リンクを作成します。

systemctl は logstash を起動します

ln -s /usr/share/logstash/bin/logstash /usr/local/bin/

logstashコマンドラインでよく使用されるオプション

-f : このコマンドを使用して Logstash 構成ファイルを指定し、構成ファイルに従って logstash を構成します。

-e : logstash 構成として使用できる文字列が続きます (「」の場合、デフォルトで stdin が入力として使用され、stdout が出力として使用されます)

-t : 構成ファイルが正しいかどうかをテストして終了します

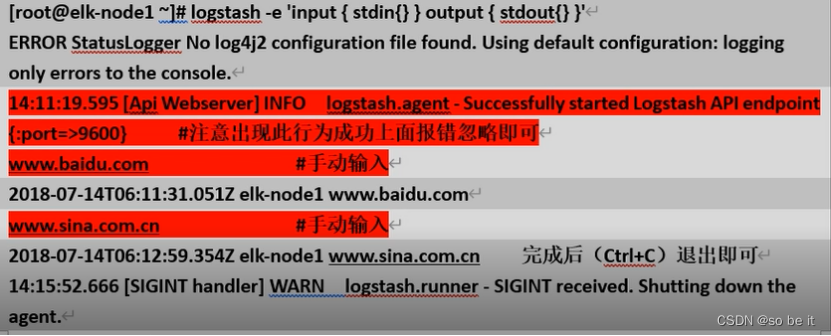

logstash -e を開始し、コマンド ラインで入力を実行します。

logstash -e '入力 { stdin{} } 出力 { stdout{} }'

標準入力はキーボードから入力され、標準出力は画面に直接出力されます。

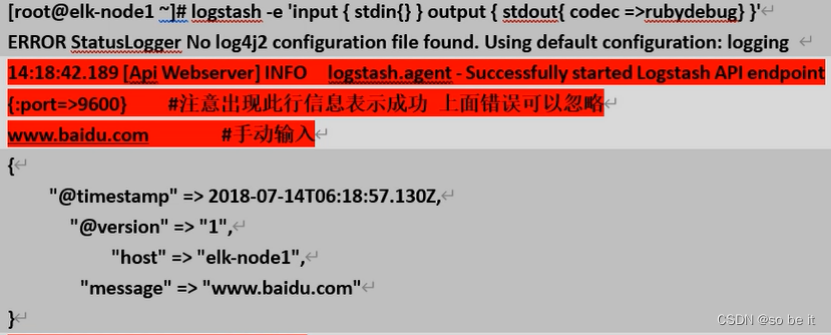

ru bydebugを使用して詳細な出力コーデックを表示する

logstash -e '入力 { stdin{} } 出力 { stdout{ コーデック =>rubydebug} }'

logstash を使用して情報をelasticsearchに書き込む

logstash -e '入力 {stdin{} } 出力 { elasticsearch { hosts=> ["192.168. 2 00.1 11:9200"]} }'

www.baidu.com

www.sina.com.cn

www.ゴーグル.com

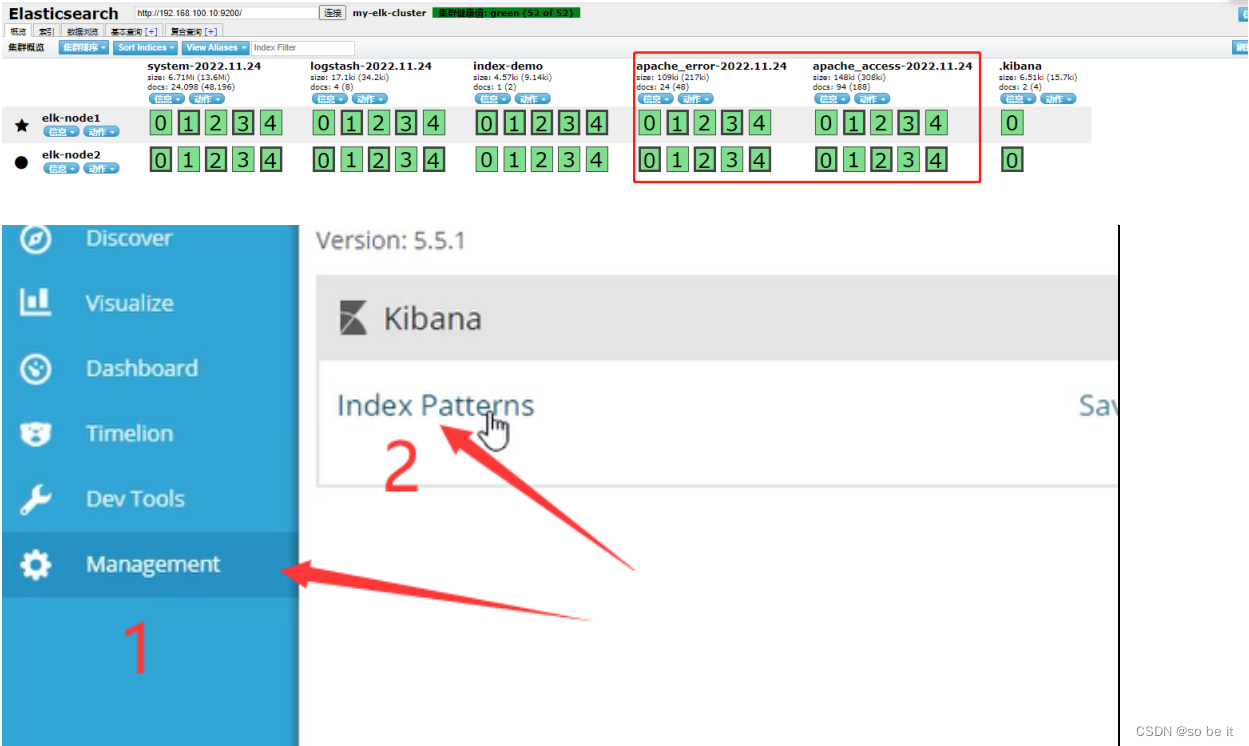

システム ログを収集するように最初のユニットを構成する

cd で logstash に移動し、構成ファイルを書き込みます

cd /etc/logstash/conf.d/

vim systemc.conf

input {

file {

path => "/var/log/messages"

type => "system"

start_position => "beginning"

}

}

output {

elasticsearch {

hosts => ["192.168.100.10:9200"]

index => "system-%{+YYYY.MM.dd}"

}

}ログスタッシュを再起動します

systemctl 再起動 logstash

systemc.confファイルをロードし、es にインポートされているかどうかを確認します。

logstash -f systemc.conf

IP にアクセスしてノードを表示し、再度表示します

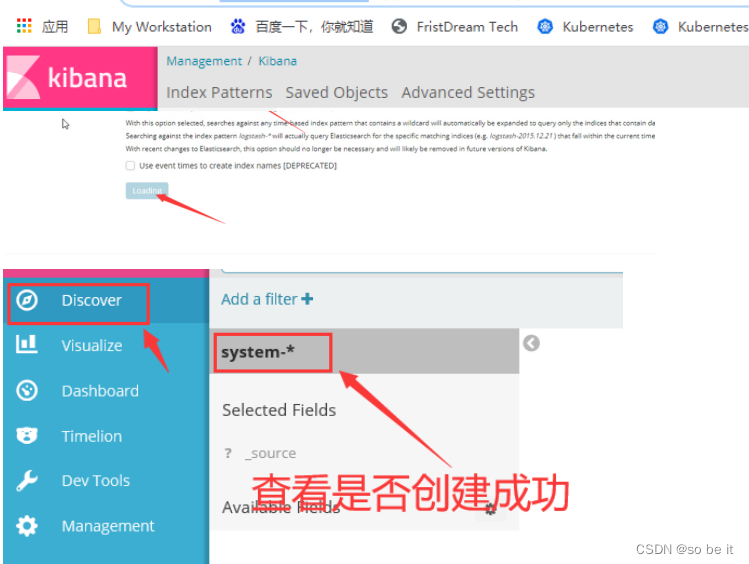

kibana No.1をインストールする

rpm -ivh kibana-5.5.1-x86_64.rpm

起動時に自動的に起動するように設定する

systemctl で kibana.service を有効にする

構成ファイルを変更してサービスを開始します

vim /etc/kibana/kibana.yml

サービスを起動してポートを確認する

systemctl kibana.service を再起動します

netstat -lnpt | グリップ 5601

logstash -f /etc/logstash/conf.d/system.conf

http://192.168.108.67:5601/にアクセスしてください。

チャンネル3

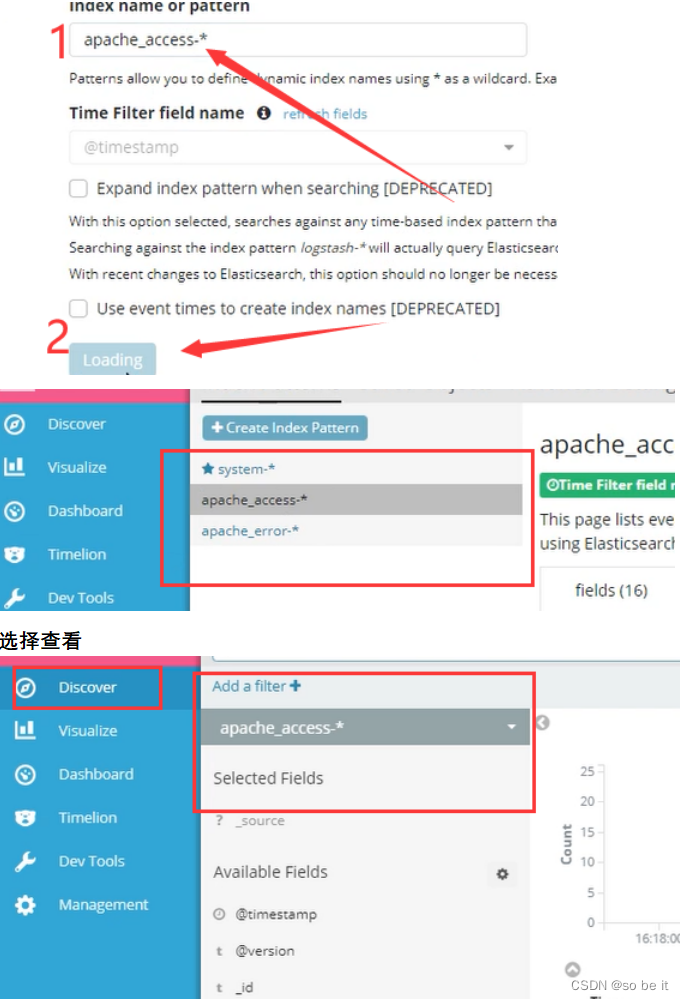

3 番目のステーションを開いて、「apache」という名前を付けます。

ホスト名apache

バッシュ

保護メカニズムをオフにする

iptables -F

systemctl ファイアウォールを停止します

セットフォース0

httpd を開始する

systemctl httpd を開始します

Javaのバージョンを確認する

java -バージョン

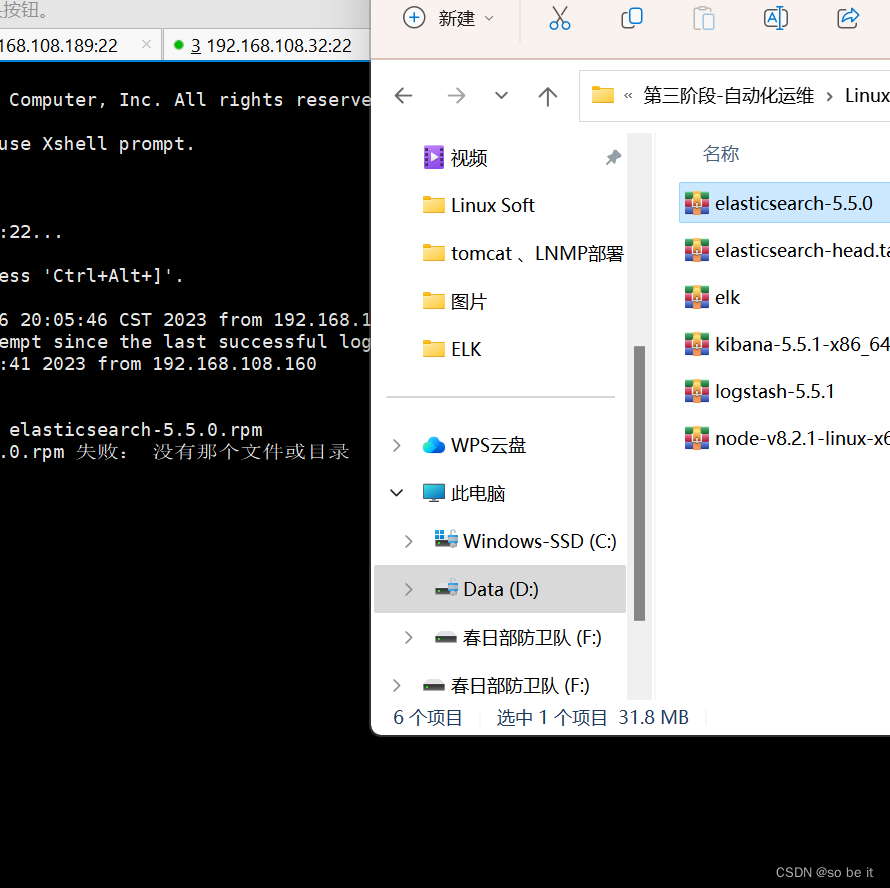

rz アップロード パッケージ

![]()

rpm をインストールし、起動時に自動的に起動するように設定します。

rpm -ivh logstash-5.5.1.rpm

systemctl は logstash.service を有効にします

cdでlogstashに移動します

cd /etc/logstash/conf.d/

vim 設定ファイルを編集する

vim apache_log.conf

input {

file {

path => "/var/log/httpd/access_log"

type => "access"

start_position => "beginning"

}

file {

path => "/var/log/httpd/error_log"

type => "error"

start_position => "beginning"

}

}

output {

if [type] == "access" {

elasticsearch {

hosts => ["192.168.200.111:9200"]

index => "apache_access-%{+YYYY.MM.dd}"

}

}

if [type] == "error" {

elasticsearch {

hosts => ["192.168.200.111:9200"]

index => "apache_error-%{+YYYY.MM.dd}"

}

}

}[root@apache conf.d]# logstash -f apache_log.conf //ファイルをロード

E LKポート番号:

エラスティックサーチ:9 200

elasticsearch -head :9100

ログスタッシュ:9600 入力:4560

ログスタッシュエージェント:9601

キバナ: 5601 _