論文リンク: https://arxiv.org/abs/2102.09844

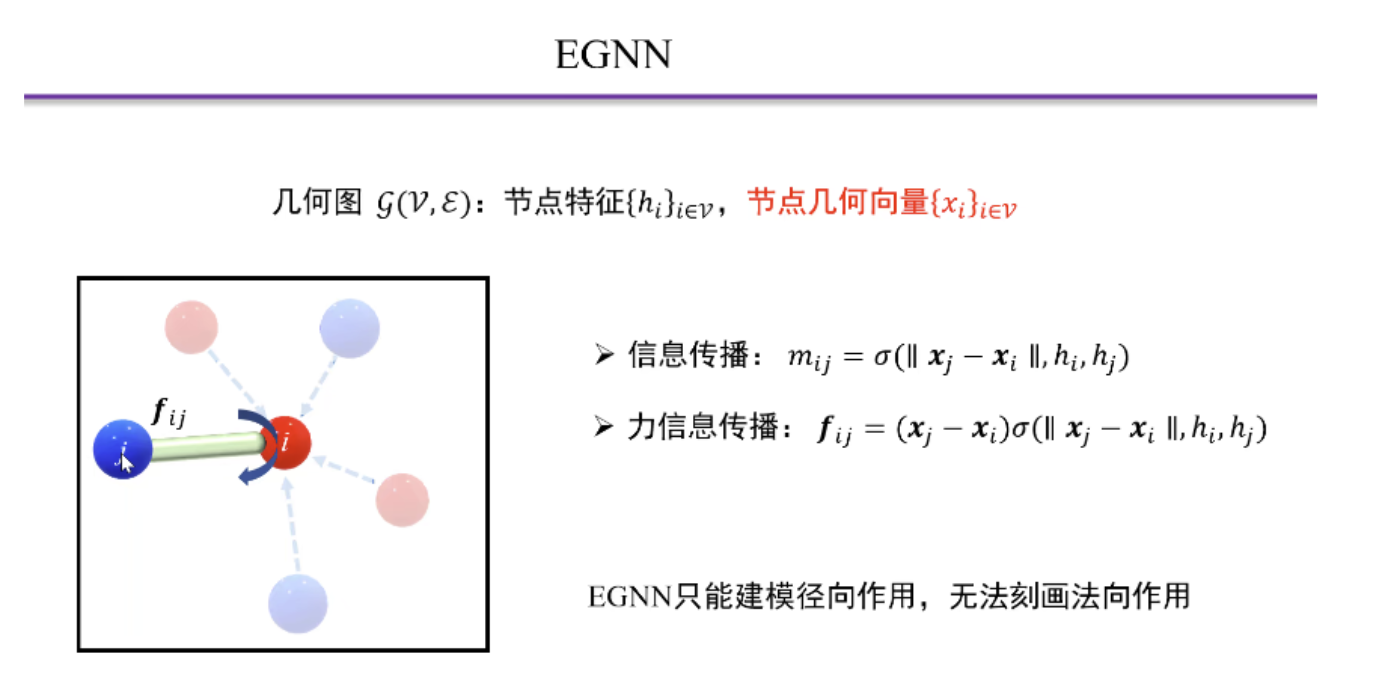

- E(n)-Equivariant Graph Neural Networks (EGNN) と呼ばれる、回転、平行移動、反射、置換を含む等変グラフ ニューラル ネットワークを学習するための新しいモデル

ディープ ラーニングは手作りの機能に大きく取って代わりましたが、多くの進歩はディープ ニューラル ネットワークの帰納的バイアスに大きく依存しています。(誘導バイアス)

ニューラル ネットワークを研究問題に関連する機能に限定する効果的な方法は、問題の対称性、変換などを使用して、特定の対称グループを研究することで現在の問題の計算を簡素化することです。

- CNN の畳み込みは等価変形であり、プーリングは近似不変です。

- GNN 点の配置順序は等変です (異なる点の配置は異なる隣接行列に対応しますが、最終的にこのグラフで表現される情報は同じです)

许多问题都表现出 3D 平移和旋转对称性

- これらの対称操作のセットはSE(3)で示され、反射が含まれる場合、セットはE(3)で示されます。多くの場合、これらのタスクの予測は E(3) 変換に関して等変または不変であることが望ましいです。

最近、等変 E(3) または SE(3) のさまざまな形式と方法が提案されています。これらの研究の多くは、中間ネットワーク層の高次表現タイプの研究において革新を達成しました。ただし、これらの高次表現の変換には、計算コストのかかる係数または近似が必要です。さらに、実際には、多くの種類のデータの入力と出力は、スカラー値 (温度やエネルギーなど、文献ではタイプ 0 と呼ばれます) と 3D ベクトル (速度や運動量など、タイプ 0 と呼ばれます) に制限されます。文献)-1)

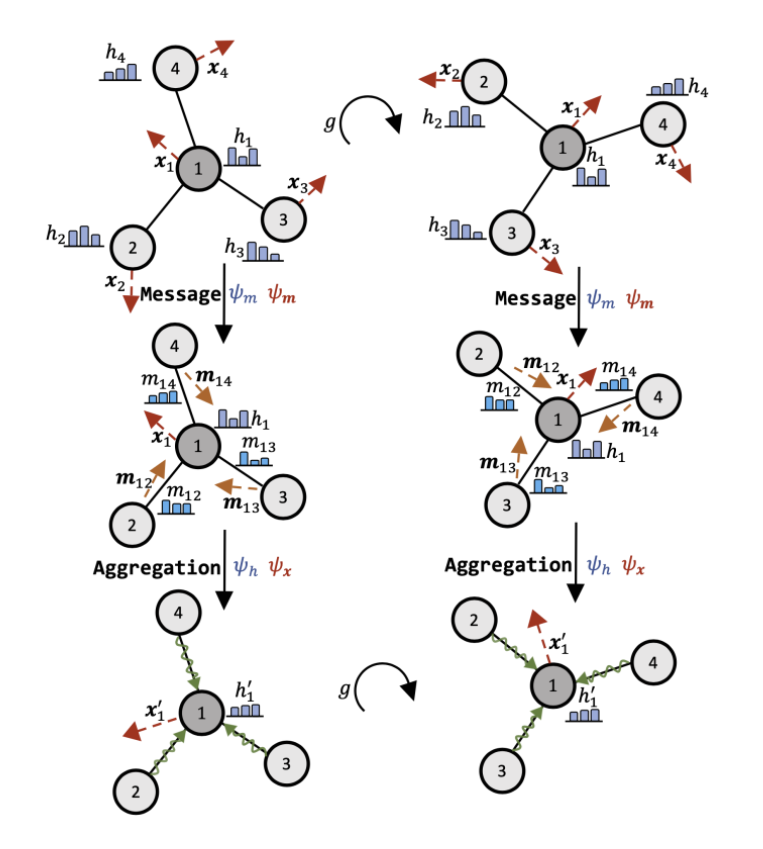

它是平移、旋转和反射等变 (E(n)),以及关于输入点集的置换等变。 模型比以前的方法更简单,同时模型中的等变性不限于 3 维空间,并且可以扩展到更大的维空间,而不会显着增加计算量。

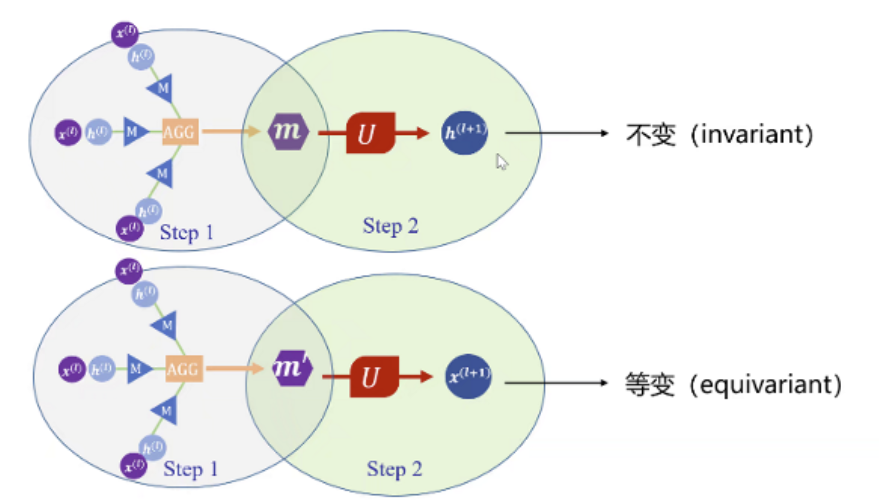

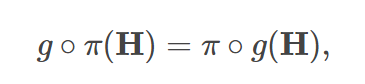

均等な可変性: 最初に移動/回転/配置してからマップします。効果は最初のマップとその後の移動/回転/配置と同じです。

この論文では、次の 3 つのタイプの等分散について検討します。

- 翻訳の等価性

- 回転と反射の等分散性

- 順列等分散。

- 置換同型性:

- 順列不変性:

- 簡単に言うと、順列不変性は出力を入力順序から独立させますが、順列等分散は出力順序を入力順序に対応させます。

- 明らかに、順列不変関数の後に順列不変関数が続く場合、取得された関数は依然として順列不変です。

- これら 2 種類の関数が必要になるのはどのような場合ですか? グラフは自然に乱れているため、ノードの特性を気にする場合は、ノードのラベルを変更してもノードの特性が変わらないようにするか、ノード番号に応じてノードの特性の順序を並べ替える必要があります。グラフの特徴を重視し、ノード ラベルの変更がグラフの特徴に影響を与えないことを望む場合は、均質性を置き換える必要があります。順列の不変性が必要です。

- GNN の順列共分散は大域等分散 (Global Equivariance) と呼ばれ、集計演算子の順列不変は局所不変 (Local Invariance) と呼ばれます

局部不变性诱导全局同变。- 集計演算子の順列不変性は、グローバルな順列共分散には必要ありません。

- すべての同変 GNN を直接定義することには理論上の価値があるだけで、実際的な価値はありません。

- それでは、不変性を満たさない新しい集計演算子を設計して、GNN 全体として同じ変動性を保ちながら、より強力な表現力を持たせる方法はあるのでしょうか? 答えは「はい」です。局所等分散(局所等分散) を導入するだけです。

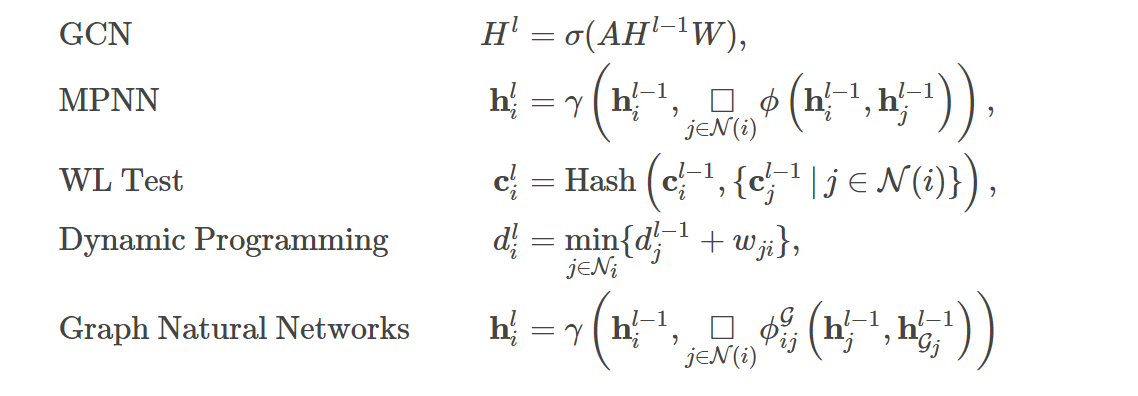

局部同变性:相同邻域结构的节点具有相同的表示

- 置換同型性:

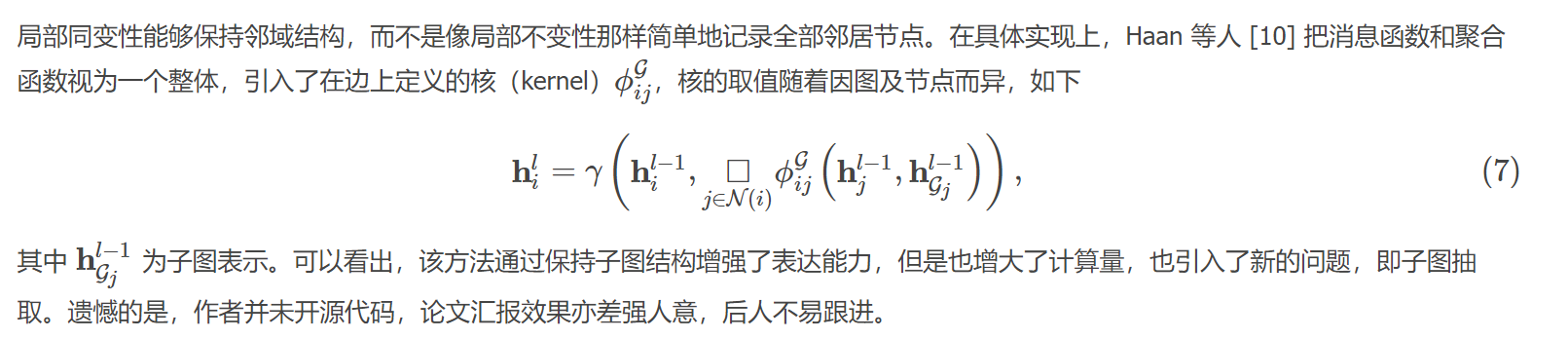

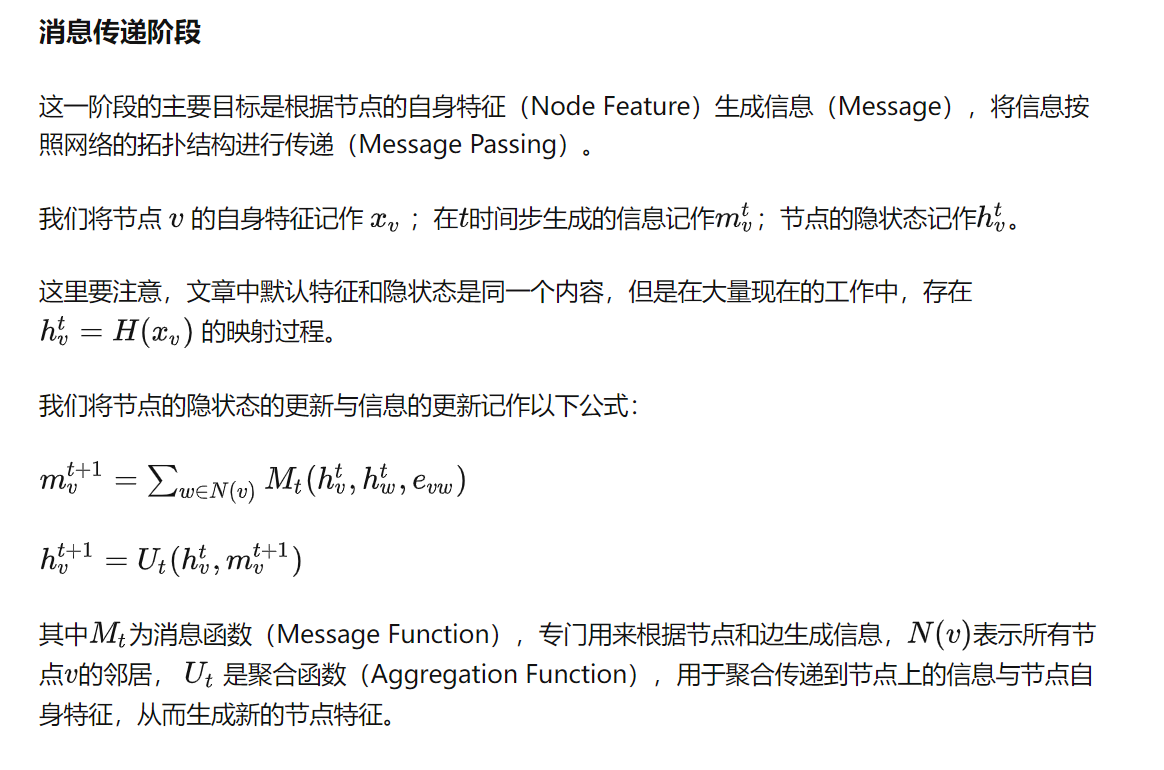

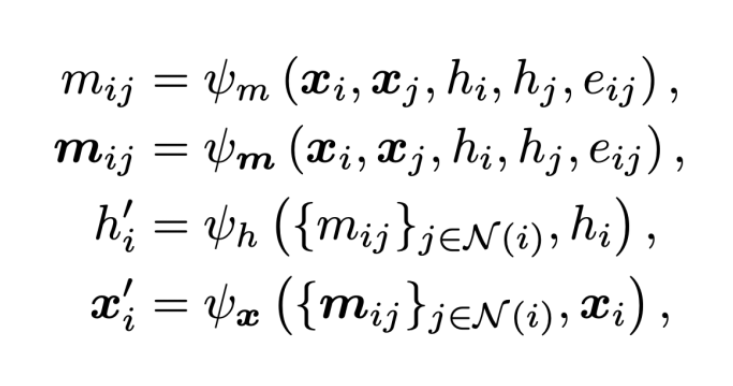

- GNNの表現力を決める3つのポイント:メッセージ機能、更新機能、集計機能

参考:https://www.cnblogs.com/hilbert9221/p/14443747.html

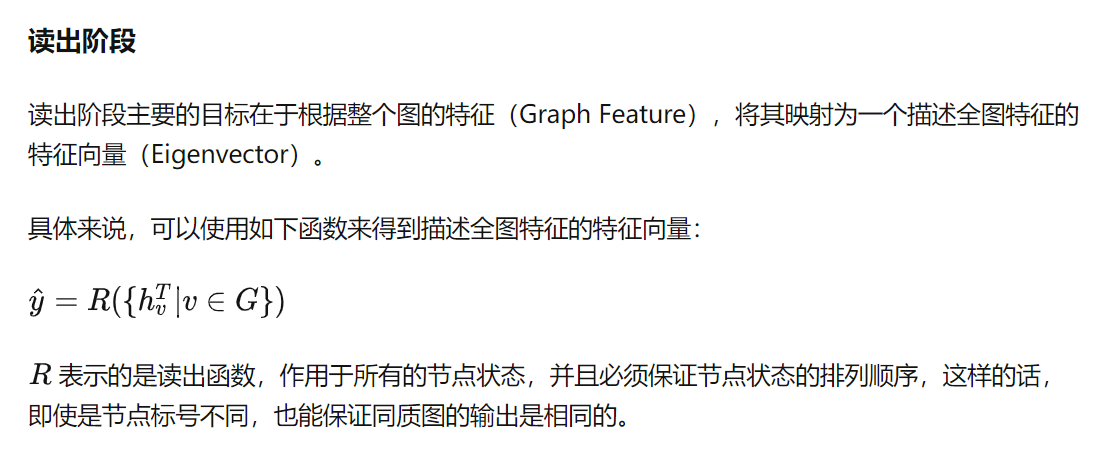

メッセージパッシングフレームワーク MPNN

GCN、GAT、GSAGE

https://zhuanlan.zhihu.com/p/412296850

等変ニューラルネットワークの調査

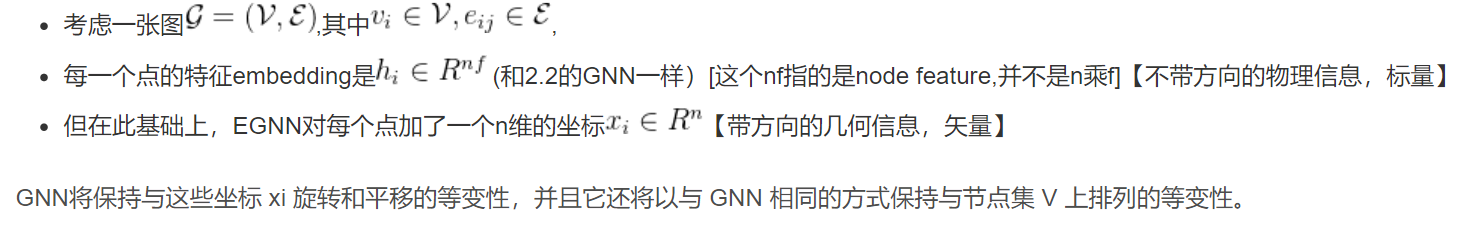

- 物理学や化学の分野では、多くの問題で幾何学的特徴を持つグラフを扱う必要があります。

たとえば、小さな化学分子やタンパク質は、原子とその化学結合関係から構成される幾何学的なグラフとしてモデル化できます。この図には、原子のいくつかの固有の特性が含まれていることに加えて、空間内の各原子の 3 次元座標の幾何学的特性も考慮する必要があります。物理学の多体問題では、各粒子の幾何学的特性には、座標、速度、回転などが含まれます。

不同于一般特征,这些几何特征往往都具备着一些对称性和等变性。このため、対称性のモデリングに基づいて、グラフ ニューラル ネットワークに基づく多数の改良モデルが近年提案されています。このタイプのモデルは、等変対称特性を持つ特徴を処理できない従来のグラフ ニューラル ネットワークの欠点を克服するため、総称して等変グラフ ニューラル ネットワークと呼ばれます。

たとえば、分子のエネルギーを予測する場合、予測が入力ジオメトリに対して不変である必要がありますが、分子動力学アプリケーションでは、予測結果が入力ジオメトリに対して等変である必要があります。

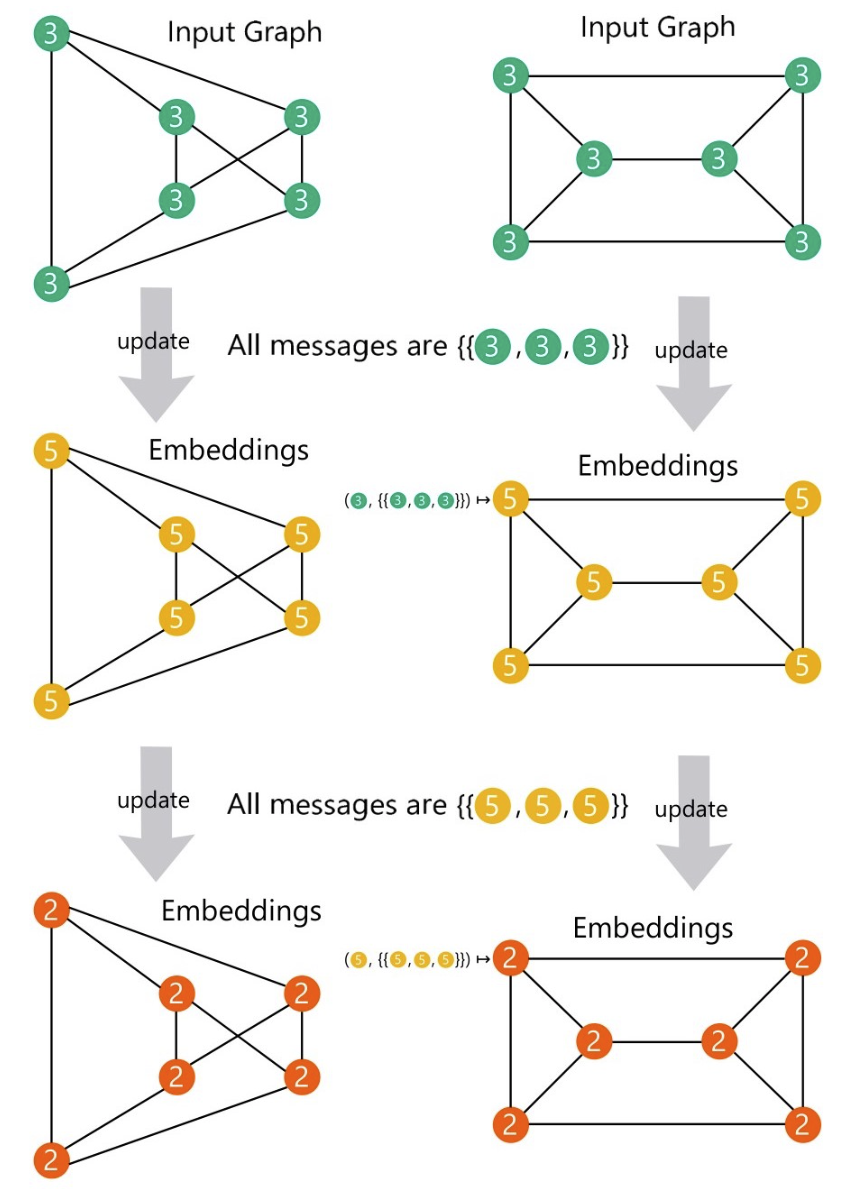

一般的な枠組み

情報の還元不可能な表現に基づくモデル

このタイプのモデルは、コンパクト グループの線形表現が、表現理論における既約表現の一連の直接積に分解できるという理論に基づいています。したがって、等変特性を満たすメッセージモデルは、SE(3) グループで構築されます。

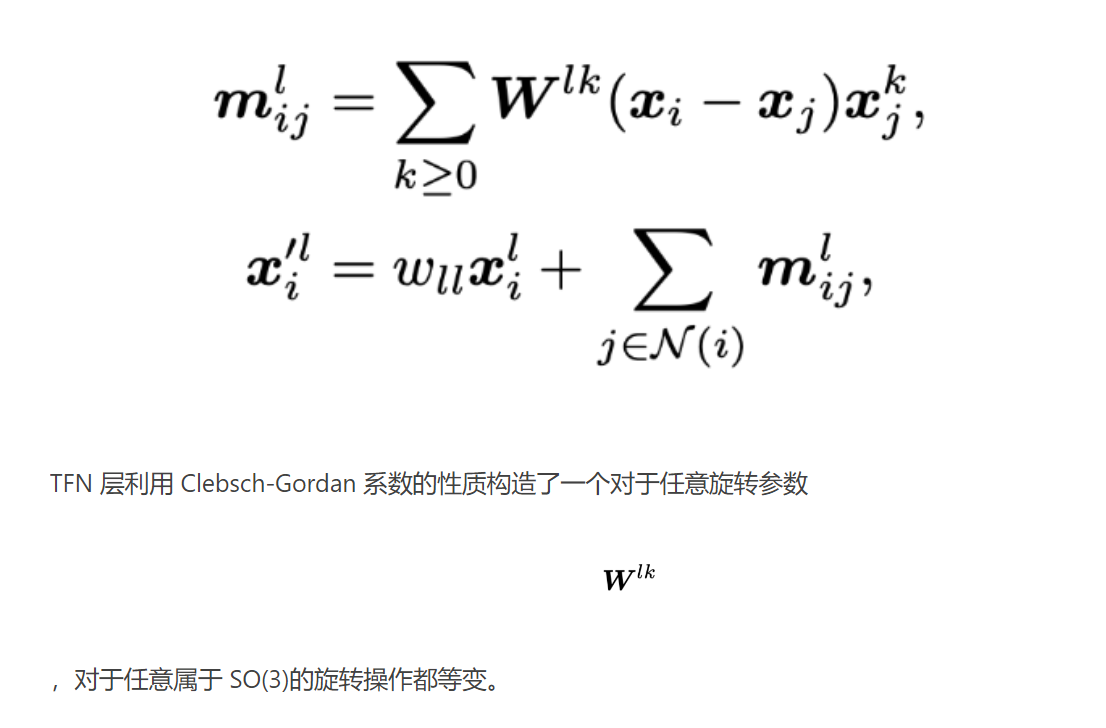

- たとえば、TFN では、

アテンション メカニズムの追加、非線形クレブシュ ゴルダン係数の導入など、TFN 構造に基づいて多くの作業が拡張されています。ただし、これらの方法は計算の複雑さが高く、既約表現は特定のグループにのみ適用できます。これにより、そのようなモデルの表現力が制限されます。

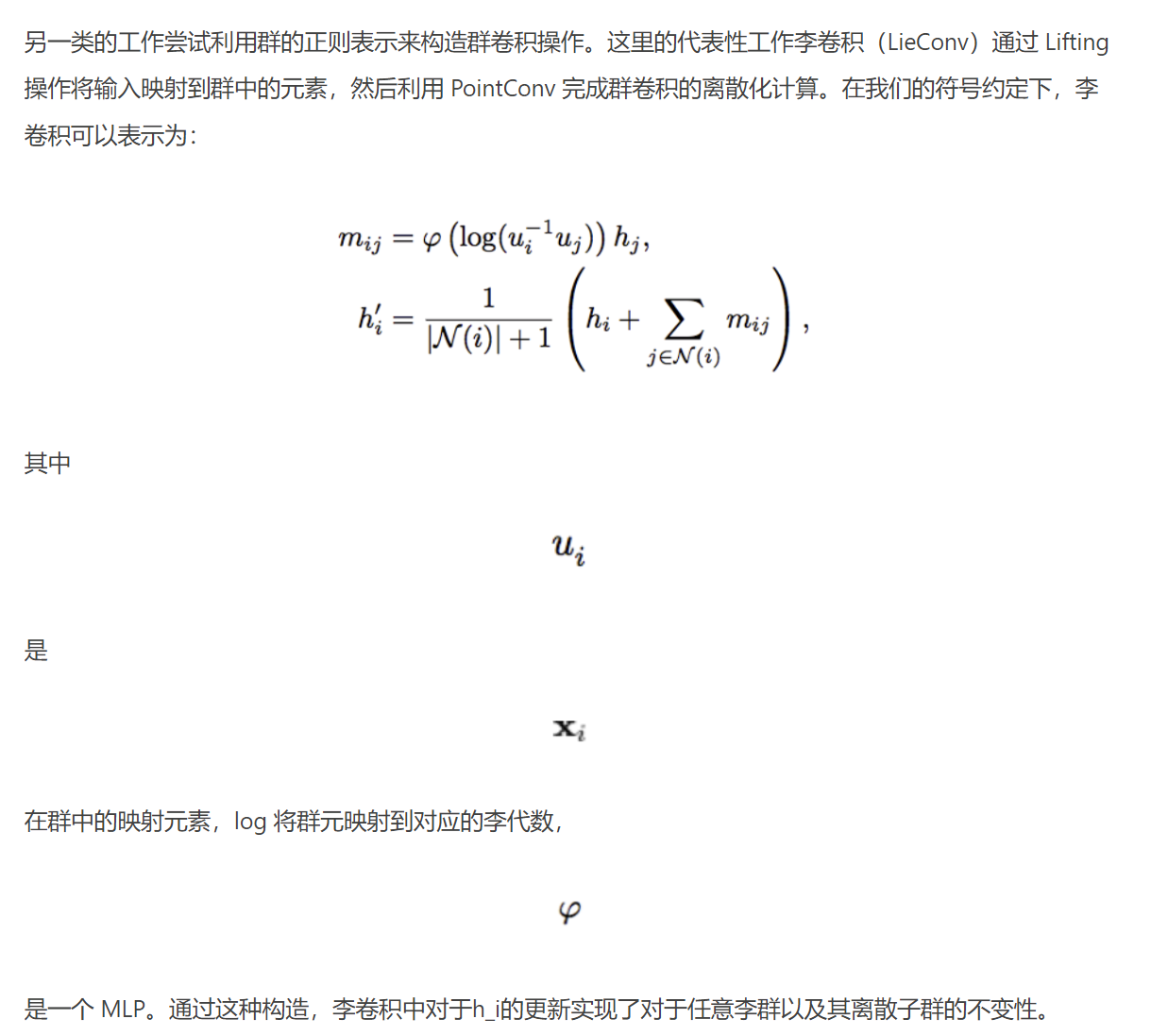

情報の規則的な表現に基づくモデル

この考えに基づいて、LieTransformer はモデルのパフォーマンスをさらに向上させるためのセルフアテンション メカニズムを導入します。リー群の正則表現に基づくモデルは、群の選択においてより柔軟ですが、離散化とサンプリングのため、効率とパフォーマンスの間でトレードオフを行う必要があります。同時に、上記の更新はスカラー情報 h のみを考慮していますが、ハミルトニアン ネットワークなどの作業における更新手法を統合しない限り、幾何情報 x の更新に直接拡張することは困難です。