Annuaire d'articles

-

- 1 démarrage et arrêt à une touche

- 2 processus unique de démarrage et d'arrêt

- 3 Créer des dossiers

- 4 Afficher le contenu du répertoire spécifié

- 5 Téléchargez des fichiers dans le répertoire spécifié HDFS sous linux-> HDFS

- 6 Télécharger HDFS -> Linux

- 7 Ajouter des données linux->HDFS

- 8 Afficher le contenu du fichier HDFS

- 9 Suppression des données HDFS

- 10 Interface graphique sur la page Web

- 11 Résumé

C'est presque la même chose que la commande linux

1 démarrage et arrêt à une touche

Le composant HadoopHDFS dispose de scripts intégrés pour le démarrage et l'arrêt en un clic des clusters HDFS.

$HADOOP_HOME/sbin/start-dfs.sh, démarrage en un clic du cluster HDFS

Principe d'exécution :

Sur la machine exécutant ce script, démarrer SecondaryNameNode

pour lire le contenu core-sitexml (élément fsdefaultFS), confirmer la machine où se trouve NameNode, démarrer NameNode pour lire le contenu des travailleurs, confirmer la machine où se trouve le DataNode et démarrer tous les DataNodes

$HADOOP_HOME/sbin/stop-dfs.sh, arrêt en un clic du cluster HDFS

Principe d'exécution :

Sur la machine qui exécute ce script, fermer le SecondaryNameNode pour lire le contenu core-site.xml (item fs.defaultFS), et valider la machine sur laquelle se trouve le NameNode. Fermez le NameNode pour lire le contenu des workers, confirmez la machine sur laquelle se trouve le DataNode et fermez tous les NameNodes

Les deux versions de syntaxe des commandes suivantes fonctionnent :

hadoop fs

hdfs dfs

2 processus unique de démarrage et d'arrêt

hadoop-daemon.sh(start|status|stop)(namenode|secondarynamenode|datanode) démarrer l'état ou arrêter

hdfs --daemon(start|status|stop)(namenode|secondarynamenode|datanode)

3 Créer des dossiers

hadoop fs -mkdir [-p] <path>

hdfs dfs -mkdir [-p] <path>Le nouveau

chemin de commande de version : hdfs://node1:8020/test L'en-tête de protocole peut être omis, et il identifiera automatiquement si linux ou hdfs

4 Afficher le contenu du répertoire spécifié

` hadoop fs -ls [-h][-R][

-h taille du fichier d'affichage humanisé ; -R affiche de manière récursive le répertoire spécifié et ses sous-répertoires ;

5 Téléchargez des fichiers dans le répertoire spécifié HDFS sous linux-> HDFS

hadoop fs -put [-f] [-p]<localsrc>...<dst> 或 hdfs dfs -put [-f] [-p]<localsrc>...<dst>

-f écrase le fichier cible (s'il existe) -p préserve les heures d'accès et de modification, la propriété et les autorisations.

Avec en-tête de protocole : hdfs dfs -put file:///home/hadoop/test.txt hdfs://node1:8020/

sans en-tête de protocole :hdfs dfs -put ./test.txt /

6 Télécharger HDFS -> Linux

Similaire à 5 : `hdfs dfs -get [-f] [-p]…

7 Ajouter des données linux->HDFS

hdfs dfs -appendToFile <localsrc>...<dst>

8 Afficher le contenu du fichier HDFS

hdfs dfs -cat <src>

Pour lire des fichiers volumineux, vous pouvez utiliser le symbole du tuyau pour coopérer avec plus [tourner la page du contenu]

hdfs dfs -cat<src> | more

9 Suppression des données HDFS

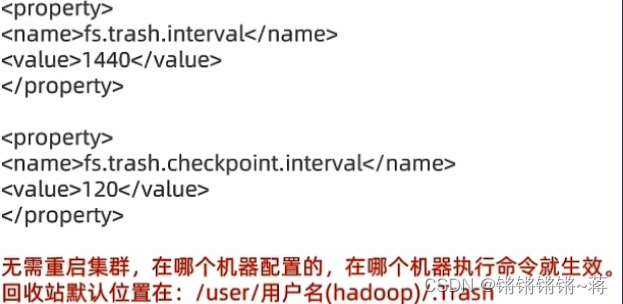

hdfs dfs -rm -r [skipTrash] URI [URI ...]

skipTrash ignore la corbeille. La fonction de corbeille est désactivée par défaut et une configuration est nécessaire pour l'activer. -r vim /export/server/hadoop/etc/hadoop/core-site.xml

est requis pour supprimer le dossier

10 Interface graphique sur la page Web

node1:9870 peut ouvrir le système de fichiers HDFS sur la page Web et peut exploiter des fichiers avec une interface graphique, mais vous devez modifier les autorisations correspondantes dans le fichier de configuration, mais cette opération n'est pas recommandée et il y aura des risques de sécurité. Vous pouvez trouver un plug-in visuel pour effectuer des opérations similaires, comme le plug-in Big Data Tools.

11 Résumé

1 Vous pouvez utiliser la commande :

hadoop fs

hdfs dfs

2. Le protocole du système de fichiers inclut

file:// pour indiquer le fichier local Linux

hdfs://namenode_server:port/ pour indiquer le système de fichiers HDFS

Par exemple, le cluster actuel est exprimée sous la forme : hdfs://node1:8020/ Les en-têtes

de protocole file: // et hdfs:// peuvent être omis sans écrire move, delete put, get upload, download appendToFile Ajouter le contenu au fichier