I.はじめに

画像スティッチング (Image Stitching)は、実世界の画像を使用してパノラマ空間を形成する技術であり、複数の画像をつなぎ合わせて大規模な画像や 360 度のパノラマを作成する、シーン再構成の特殊なケースと言えます。連想のホモグラフィー。画像スティッチングは、動きの検出と追跡、拡張現実、解像度向上、ビデオ圧縮、画像安定化などのマシン ビジョン分野で優れた用途があります。

画像ステッチングの出力は、 2 つの入力画像を結合したものです。

1.特徴抽出: 入力画像内の特徴点を検出します。

2.画像レジストレーション (画像レジストレーション) : 画像間の一連の対応関係を確立し、共通の基準枠内で画像を変換、比較、分析できるようにします。

3.ワーピング: 画像の 1 つを再投影し、その画像をより大きなキャンバスに配置します。

4.画像の融合 (ブレンディング) : 境界付近の画像のグレー レベルを変更することで、これらのギャップが除去され、画像間のスムーズな移行を実現するためにブレンドされた画像が作成されます。ブレンド モードは、2 つのレイヤーをブレンドするために使用されます。

2. 実施方法

SURFをベースにしたイメージステッチ

SIFT アルゴリズムを使用して画像のスティッチングを実現するのは非常に一般的な方法ですが、SIFT は計算量が多いため、高速性が要求される場合には適用できなくなりました。したがって、その改良された手法 SURF は速度が大幅に向上しており (速度は SIFT の 3 倍)、画像スティッチングの分野ではまだ多くのことを行う必要があります。SURFの精度や安定性はSIFTには及ばないものの、それでも総合力は優れています。ステッチの主な手順については、以下で詳しく説明します。

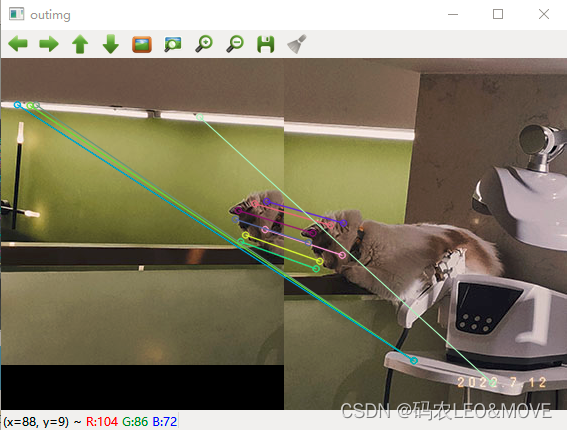

1. 特徴点の抽出とマッチング

//创建SURF对象

//create 参数 海森矩阵阈值

Ptr<SURF> surf;

surf = SURF::create(800);

//暴力匹配器

BFMatcher matcher;

vector<KeyPoint> key1, key2;

Mat c, d;

//寻找特征点

surf->detectAndCompute(left, Mat(), key2, d);

surf->detectAndCompute(right, Mat(), key1, c);

//特征点对比 保存

vector<DMatch>matches;

//使用暴力匹配器匹配特征点 保存

matcher.match(d, c, matches);

//排序 从小到大

sort(matches.begin(), matches.end());

//保留最优的特征点收集

vector<DMatch>good_matches;

int ptrPoint = std::min(50, (int)(matches.size()*0.15));

for(int i=0; i<ptrPoint; i++)

good_matches.push_back(matches[i]);

//最佳匹配的特征点连成一线

Mat outimg;

drawMatches(left, key2, right, key1, good_matches, outimg,

Scalar::all(-1), Scalar::all(-1),

vector<char>(), DrawMatchesFlags::NOT_DRAW_SINGLE_POINTS);

imshow("outimg", outimg);

2. 画像の登録

このようにして、貼り合わせる 2 つの画像の対応点セットが得られます。次に、画像の位置合わせ、つまり 2 つの画像を同じ座標に変換します。このとき、findHomography 関数を使用して取得する必要があります。変換行列。

ただし、findHomography 関数で使用する点集合は Point2f 型であるため、先ほど取得した点集合 Good_matches を処理して Point2f 型の点集合に変換する必要があることに注意してください。

//特征点配准

vector<Point2f>imagepoint1, imagepoint2;

for(int i=0; i<good_matches.size(); i++)

{

imagepoint1.push_back(key1[good_matches[i].trainIdx].pt);

imagepoint2.push_back(key2[good_matches[i].queryIdx].pt);

}

上記の操作の後、imagepoint1 と imagepoint2 を使用して変換行列を見つけ、画像の位置合わせを実現します。

findHomography 関数のパラメーターで CV_RANSAC が選択されていることは注目に値します。RANSAC アルゴリズムを使用して、信頼できるマッチング ポイントのスクリーニングを継続することで、マッチング ポイントのソリューションがより正確になります。

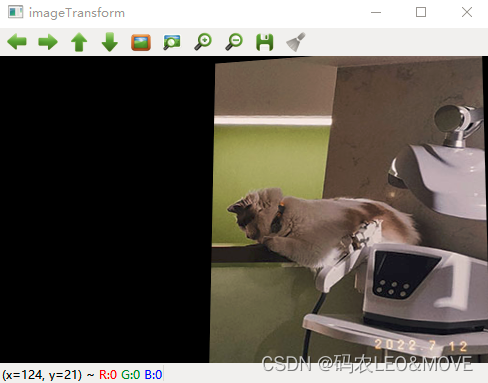

//透视转换

Mat homo = findHomography(imagepoint1, imagepoint2, CV_RANSAC);

imshow("homo", homo);

//右图四个顶点坐标转换计算

CalcCorners(homo, right);

Mat imageTransform;

warpPerspective(right, imageTransform, homo,

Size(MAX(corners.right_top.x, corners.right_bottom.x), left.rows));

imshow("imageTransform", imageTransform);

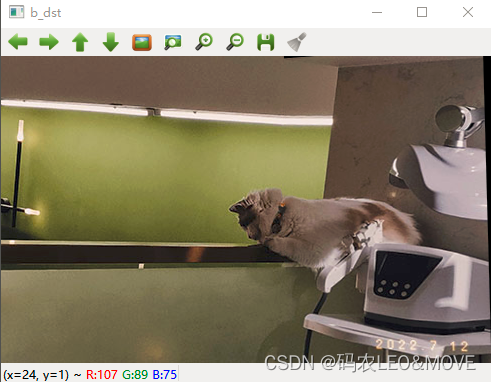

3. 画像のコピー

コピーの考え方は非常に簡単で、左の画像を登録画像に直接コピーするだけです。

int dst_width = imageTransform.cols;

int dst_height = imageTransform.rows;

Mat dst(dst_height, dst_width, CV_8UC3);

dst.setTo(0);

imageTransform.copyTo(dst(Rect(0, 0, imageTransform.cols, imageTransform.rows)));

left.copyTo(dst(Rect(0, 0, left.cols, left.rows)));

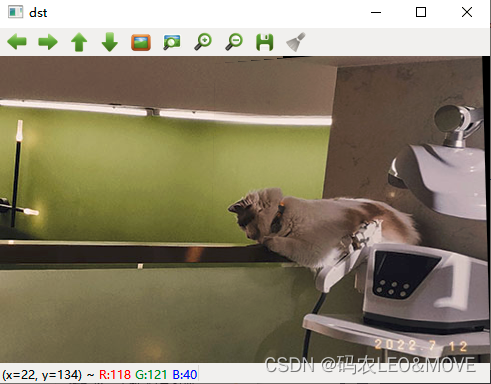

4. 画像融合(デクラック処理)

OptimizeSeam(left, imageTransform, dst);

imshow("dst", dst);

waitKey(0);

//优化两图的连接处,使得拼接自然

void OptimizeSeam(Mat& img1, Mat& trans, Mat& dst)

{

int start = MIN(corners.left_top.x, corners.left_bottom.x);//开始位置,即重叠区域的左边界

double processWidth = img1.cols - start;//重叠区域的宽度

int rows = dst.rows;

int cols = img1.cols; //注意,是列数*通道数

double alpha = 1;//img1中像素的权重

for (int i = 0; i < rows; i++)

{

uchar* p = img1.ptr<uchar>(i); //获取第i行的首地址

uchar* t = trans.ptr<uchar>(i);

uchar* d = dst.ptr<uchar>(i);

for (int j = start; j < cols; j++)

{

//如果遇到图像trans中无像素的黑点,则完全拷贝img1中的数据

if (t[j * 3] == 0 && t[j * 3 + 1] == 0 && t[j * 3 + 2] == 0)

{

alpha = 1;

}

else

{

//img1中像素的权重,与当前处理点距重叠区域左边界的距离成正比,实验证明,这种方法确实好

alpha = (processWidth - (j - start)) / processWidth;

}

d[j * 3] = p[j * 3] * alpha + t[j * 3] * (1 - alpha);

d[j * 3 + 1] = p[j * 3 + 1] * alpha + t[j * 3 + 1] * (1 - alpha);

d[j * 3 + 2] = p[j * 3 + 2] * alpha + t[j * 3 + 2] * (1 - alpha);

}

}

}

3. 完全なコード

#include <iostream>

#include <opencv2/opencv.hpp>

#include <opencv2/highgui.hpp>

#include <opencv2/xfeatures2d.hpp>

#include <opencv2/calib3d.hpp>

#include <opencv2/imgproc.hpp>

using namespace std;

using namespace cv;

using namespace cv::xfeatures2d;

typedef struct

{

Point2f left_top;

Point2f left_bottom;

Point2f right_top;

Point2f right_bottom;

}four_corners_t;

four_corners_t corners;

void CalcCorners(const Mat& H, const Mat& src)

{

double v2[] = {

0, 0, 1 };//左上角

double v1[3];//变换后的坐标值

Mat V2 = Mat(3, 1, CV_64FC1, v2); //列向量

Mat V1 = Mat(3, 1, CV_64FC1, v1); //列向量

V1 = H * V2;

//左上角(0,0,1)

cout << "V2: " << V2 << endl;

cout << "V1: " << V1 << endl;

corners.left_top.x = v1[0] / v1[2];

corners.left_top.y = v1[1] / v1[2];

//左下角(0,src.rows,1)

v2[0] = 0;

v2[1] = src.rows;

v2[2] = 1;

V2 = Mat(3, 1, CV_64FC1, v2); //列向量

V1 = Mat(3, 1, CV_64FC1, v1); //列向量

V1 = H * V2;

corners.left_bottom.x = v1[0] / v1[2];

corners.left_bottom.y = v1[1] / v1[2];

//右上角(src.cols,0,1)

v2[0] = src.cols;

v2[1] = 0;

v2[2] = 1;

V2 = Mat(3, 1, CV_64FC1, v2); //列向量

V1 = Mat(3, 1, CV_64FC1, v1); //列向量

V1 = H * V2;

corners.right_top.x = v1[0] / v1[2];

corners.right_top.y = v1[1] / v1[2];

//右下角(src.cols,src.rows,1)

v2[0] = src.cols;

v2[1] = src.rows;

v2[2] = 1;

V2 = Mat(3, 1, CV_64FC1, v2); //列向量

V1 = Mat(3, 1, CV_64FC1, v1); //列向量

V1 = H * V2;

corners.right_bottom.x = v1[0] / v1[2];

corners.right_bottom.y = v1[1] / v1[2];

}

//优化两图的连接处,使得拼接自然

void OptimizeSeam(Mat& img1, Mat& trans, Mat& dst)

{

int start = MIN(corners.left_top.x, corners.left_bottom.x);//开始位置,即重叠区域的左边界

double processWidth = img1.cols - start;//重叠区域的宽度

int rows = dst.rows;

int cols = img1.cols; //注意,是列数*通道数

double alpha = 1;//img1中像素的权重

for (int i = 0; i < rows; i++)

{

uchar* p = img1.ptr<uchar>(i); //获取第i行的首地址

uchar* t = trans.ptr<uchar>(i);

uchar* d = dst.ptr<uchar>(i);

for (int j = start; j < cols; j++)

{

//如果遇到图像trans中无像素的黑点,则完全拷贝img1中的数据

if (t[j * 3] == 0 && t[j * 3 + 1] == 0 && t[j * 3 + 2] == 0)

{

alpha = 1;

}

else

{

//img1中像素的权重,与当前处理点距重叠区域左边界的距离成正比,实验证明,这种方法确实好

alpha = (processWidth - (j - start)) / processWidth;

}

d[j * 3] = p[j * 3] * alpha + t[j * 3] * (1 - alpha);

d[j * 3 + 1] = p[j * 3 + 1] * alpha + t[j * 3 + 1] * (1 - alpha);

d[j * 3 + 2] = p[j * 3 + 2] * alpha + t[j * 3 + 2] * (1 - alpha);

}

}

}

//计算配准图的四个顶点坐标

int main()

{

Mat left = imread("A.jpg");

Mat right =imread("B.jpg");

imshow("left", left);

imshow("right", right);

//1.特征点提取和匹配

//创建SURF对象

//create 参数 海森矩阵阈值

Ptr<SURF> surf;

surf = SURF::create(800);

//暴力匹配器

BFMatcher matcher;

vector<KeyPoint> key1, key2;

Mat c, d;

//寻找特征点

surf->detectAndCompute(left, Mat(), key2, d);

surf->detectAndCompute(right, Mat(), key1, c);

//特征点对比 保存

vector<DMatch>matches;

//使用暴力匹配器匹配特征点 保存

matcher.match(d, c, matches);

//排序 从小到大

sort(matches.begin(), matches.end());

//保留最优的特征点收集

vector<DMatch>good_matches;

int ptrPoint = std::min(50, (int)(matches.size()*0.15));

for(int i=0; i<ptrPoint; i++)

good_matches.push_back(matches[i]);

//最佳匹配的特征点连成一线

Mat outimg;

drawMatches(left, key2, right, key1, good_matches, outimg,

Scalar::all(-1), Scalar::all(-1),

vector<char>(), DrawMatchesFlags::NOT_DRAW_SINGLE_POINTS);

imshow("outimg", outimg);

//2.图像配准

//特征点配准

vector<Point2f>imagepoint1, imagepoint2;

for(int i=0; i<good_matches.size(); i++)

{

imagepoint1.push_back(key1[good_matches[i].trainIdx].pt);

imagepoint2.push_back(key2[good_matches[i].queryIdx].pt);

}

//透视转换

Mat homo = findHomography(imagepoint1, imagepoint2, CV_RANSAC);

imshow("homo", homo);

//右图四个顶点坐标转换计算

CalcCorners(homo, right);

Mat imageTransform;

warpPerspective(right, imageTransform, homo,

Size(MAX(corners.right_top.x, corners.right_bottom.x), left.rows));

imshow("imageTransform", imageTransform);

//3.图像拷贝

int dst_width = imageTransform.cols;

int dst_height = imageTransform.rows;

Mat dst(dst_height, dst_width, CV_8UC3);

dst.setTo(0);

imageTransform.copyTo(dst(Rect(0, 0, imageTransform.cols, imageTransform.rows)));

left.copyTo(dst(Rect(0, 0, left.cols, left.rows)));

//4.优化拼接最终结果图,去除黑边

OptimizeSeam(left, imageTransform, dst);

imshow("dst", dst);

waitKey(0);

return 0;

}