LVS + Keepalived高可用性クラスターの展開(詳細な写真とテキスト!)

記事のディレクトリ

1. LVS + Keepalived高可用性クラスター

1.LVS

Linux Virtual Server

LVSは、実際にはIPアドレスに基づく仮想化アプリケーションと同等であり、IPアドレスとコンテンツ要求の分散に基づく負荷分散のための効率的なソリューションを提案します。

2.キープアライブ機能と役割

自動フェイルオーバーをサポート(フェイルオーバー)

ノードヘルスチェックのサポート(ヘルスチェック)

LVSロードスケジューラとノードサーバーの可用性を確認します。マスターホストに障害が発生した場合は、バックアップノードに切り替えて通常のビジネスを確保します。マスターに障害が発生すると、マスターはクラスターに再参加し、ビジネスはマスターノードに戻ります。

3.キープアライブ実装原則の分析

- キープアライブは、Linuxサーバーのマルチマシンホットバックアップ機能を実現するためにVRRPホットバックアッププロトコルを採用しています

- VRRP(Virtual Routing Redundancy Protocol)は、ルーターのバックアップソリューションです。

- 複数のルーターがホットバックアップグループを形成し、共有仮想IPアドレスを介して外部にサービスを提供します

- 各ホットスタンバイグループには、同時にサービスを提供するメインルーターが1つだけあり、他のルーターは冗長状態にあります。

- 現在オンラインのルーターに障害が発生した場合、他のルーターが設定された優先度に従って仮想IPアドレスを自動的に引き継ぎ、サービスを提供し続けます

次に、LVS-DRのARP問題

ARPテーブルのエントリによると、ルーターは新しい要求メッセージをRealServerに転送し、ディレクターのVIPが無効になるようにします。

- 解決:

ノードサーバーを処理するには、カーネルパラメータarp_announce = 2を設定します。システムはIPパケットの送信元アドレスを使用してARP要求の送信元アドレスを設定しませんが、送信インターフェイスのIPアドレスを選択します。

ARPの2つの問題を解決する方法を設定する

- /etc/sysctl.confファイルを変更します

net.ipv4.conf.lo.arp_ignore=1

net.ipv4.conf.lo.arp_announce=2

net.ipv4.conf.all.arp_ignore=1

net.ipv4.conf.all.arp_announce=2

3つのLVS負荷分散DRモードクラスター展開手順

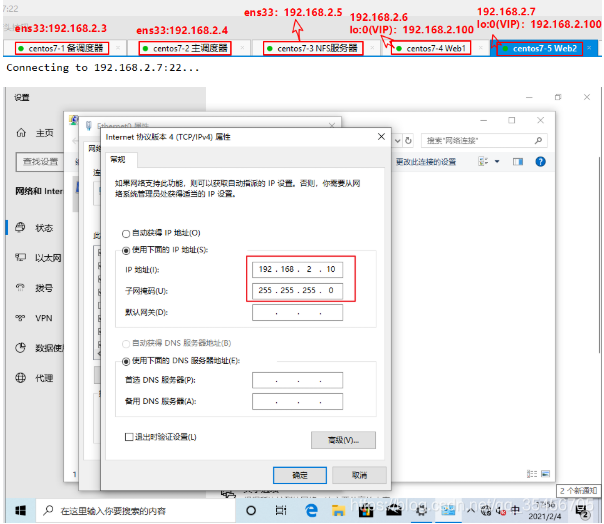

環境設定:

| ホスト | オペレーティング・システム | IPアドレス | 必要なツール/サービス |

|---|---|---|---|

| メインロードスケジューラ | CentOS7 7-2 |

ens33:192.168.2.4 | ipvsadm、keepalived |

| バックアップロードスケジューラ | CentOS7 7-1 |

ens33:192.168.2.3 | ipvsadm、keepalived |

| NFSサーバー | CentOS7 7-3 |

ens33:192.168.2.5 | rpcbind、nfs-utils |

| Webノードサーバー1 | CentOS7 7-4 |

192.168.2.6 lo:0(VIP):192.168.2.100 |

rpcbind、nfs-utils、httpd |

| Webノードサーバー2 | CentOS7 7-5 |

192.168.2.7 lo:0(VIP):192.168.2.100 |

rpcbind、nfs-utils、httpd |

| クライアント | ウインドウズ10 | 192.168.2.10 |

注意:

1)サーバー、スケジューラー、およびクライアントのMACアドレスは同じであってはなりません。同じアドレスを使用しないと、エラーが報告されます。同じLAN内では、ゲートウェイとDNSは必要ありません。

2)ここのスケジューラーは仮想ネットワークカードens33:0を必要としなくなりました

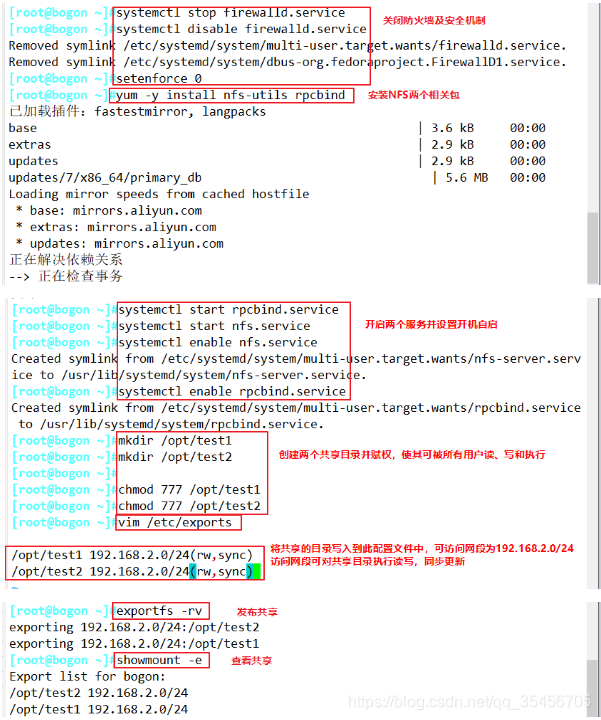

1.共有ストレージを展開します

NFSサーバー:ens33:192.168.2.5

systemctl stop firewalld.service

systemctl disable firewalld.service

setenforce 0

yum -y install nfs-utils rpcbind

systemctl start rpcbind.service

systemctl start nfs.service

systemctl enable nfs.service

systemctl enable rpcbind.service

mkdir /opt/test1

mkdir /opt/test2

chmod 777 /opt/test1

chmod 777 /opt/test2

vim /etc/exports

/opt/test1 192.168.2.0/24(rw,sync)

/opt/test2 192.168.2.0/24(rw,sync)

exportfs -rv

2.ノードサーバーを構成します

Webノードサーバー1:ens33:192.168.2.6 lo:0(VIP):192.168.2.100

Webノードサーバー2:ens33:192.168.2.7 lo:0(VIP):192.168.2.100

次は2つのサーバーの同じ構成です

systemctl stop firewalld.service

systemctl disable firewalld.service

setenforce 0

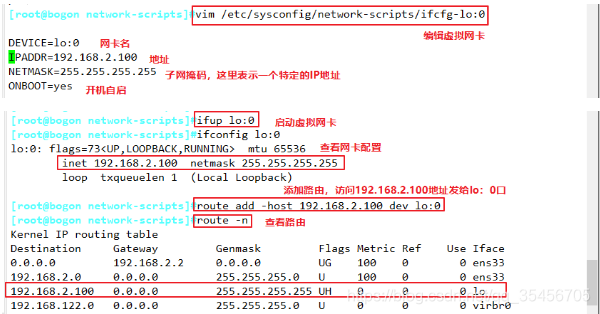

(1)仮想IPアドレスを構成します(VIP:192.168.2.100)

#此地址仅用做发送 Web 响应数据包的源地址,并不需要监听客户机的访问请求(改由调度器监听并分发)。

#因此使用虚接口 lo:0 来承载 VIP 地址,并为本机添加一条路有记录,将访问 VIP 的数据限制在本地,以避免通信紊乱。

vim /etc/sysconfig/network-scripts/ifcfg-lo:0

DEVICE=lo:0

IPADDR=192.168.2.100

NETMASK=255.255.255.255

ONBOOT=yes

ifup lo:0

ifconfig lo:0

#设置临时的路由,重启失效;禁锢路由

route add -host 192.168.2.100 dev lo:0

#查看路由

route -n

#开机自动添加路由,生产环境应该用这个

vim /etc/rc.local

/sbin/route add -host 192.168.2.100 dev lo:0

chmod +x /etc/rc.d/rc.local

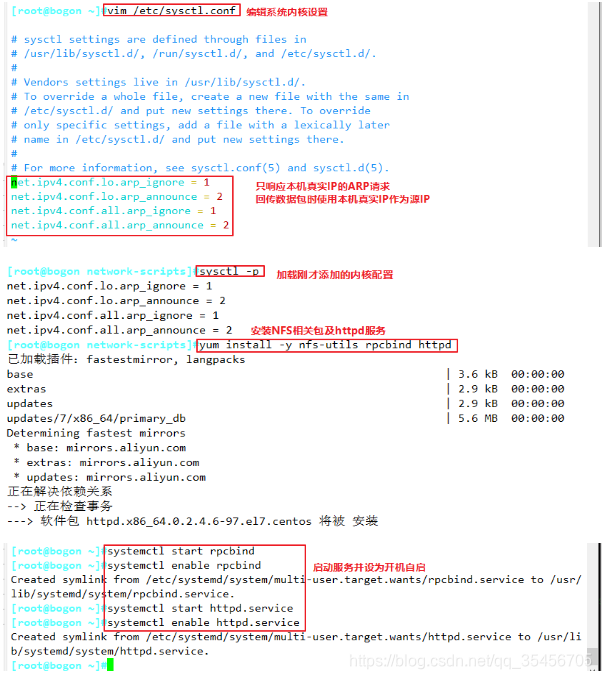

(2)カーネルのARP応答パラメータを調整します

vim /etc/sysctl.conf

......

net.ipv4.conf.lo.arp_ignore = 1 #系统只响应目的IP为本地IP的ARP请求

net.ipv4.conf.lo.arp_announce = 2 #系统不使用IP包的源地址来设置ARP请求的源地址,而选择发送接口的IP地址

net.ipv4.conf.all.arp_ignore = 1

net.ipv4.conf.all.arp_announce = 2

sysctl -p

yum install -y nfs-utils rpcbind httpd

systemctl start rpcbind

systemctl enable rpcbind

systemctl start httpd.service

systemctl enable httpd.service

(3)2つのWebサーバーの最初の2つのステップは同じですが、次の構成は同じではありません

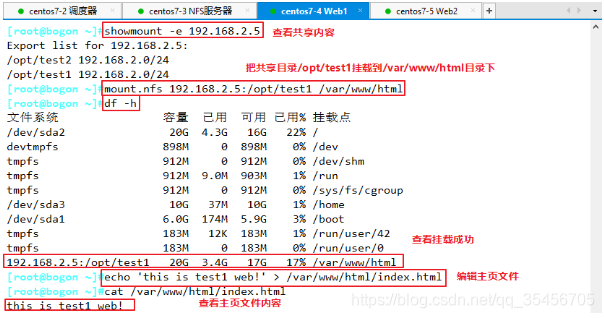

Web1サーバー:ens33:192.168.2.6 lo:0(VIP):192.168.2.100

showmount -e 192.168.2.5

mount.nfs 192.168.2.5:/opt/test1 /var/www/html

df -h

echo 'this is test1 web!' > /var/www/html/index.html

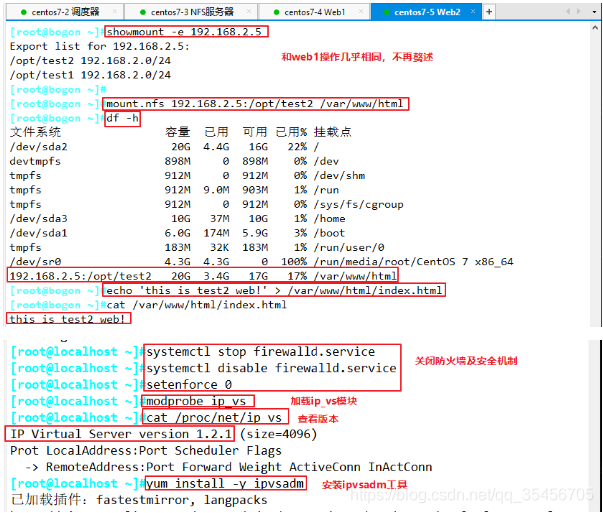

Web2サーバー:ens33:192.168.2.7 lo:0(VIP):192.168.2.100

showmount -e 192.168.2.5

mount.nfs 192.168.2.5:/opt/test2 /var/www/html

df -h

echo 'this is test2 web!' > /var/www/html/index.html

3.ロードスケジューラを構成します

メインロードスケジューラ:192.168.2.4 lo:0(VIP):192.168.2.100

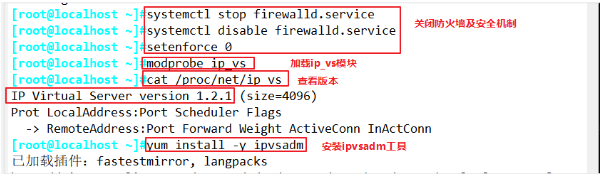

(1)ファイアウォールをオフにして、ip_vsモジュールをロードします

systemctl stop firewalld.service

systemctl disable firewalld.service

setenforce 0

#加载ip_vs模块,并安装ipvsadm工具

modprobe ip_vs

cat /proc/net/ip_vs

yum install -y ipvsadm

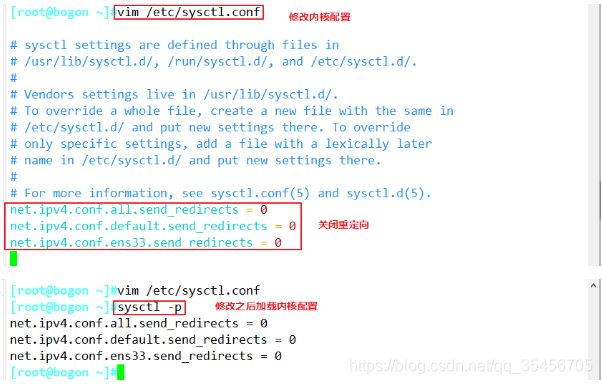

(2)proc応答パラメータを調整します

#由于 LVS 负载调度器和各节点需要共用 VIP 地址,应该关闭Linux 内核的重定向参数响应,不充当路由器,

vim /etc/sysctl.conf

net.ipv4.conf.all.send_redirects = 0

net.ipv4.conf.default.send_redirects = 0

net.ipv4.conf.ens33.send_redirects = 0

sysctl -p

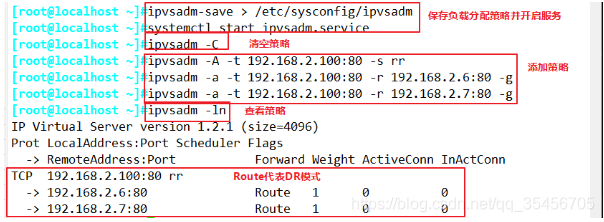

(3)負荷分散戦略を構成する

メインロードスケジューラ:192.168.2.4

ipvsadm-save > /etc/sysconfig/ipvsadm

或者

ipvsadm --save > /etc/sysconfig/ipvsadm

systemctl start ipvsadm.service

#清除原有策略

ipvsadm -C

ipvsadm -A -t 192.168.2.4:80 -s rr

ipvsadm -a -t 192.168.2.4:80 -r 192.168.2.6:80 -g #如果这里是隧道模式,直接将-g替换成-i即可

ipvsadm -a -t 192.168.2.4:80 -r 192.168.2.7:80 -g

#查看节点状态,Route代表 DR模式

ipvsadm -ln

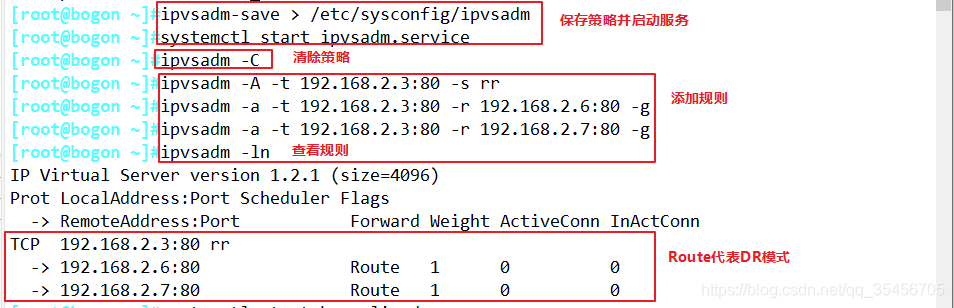

バックアップロードスケジューラ:192.168.2.3

ipvsadm-save > /etc/sysconfig/ipvsadm

或者

ipvsadm --save > /etc/sysconfig/ipvsadm

systemctl start ipvsadm.service

#清除原有策略

ipvsadm -C

ipvsadm -A -t 192.168.2.3:80 -s rr

ipvsadm -a -t 192.168.2.3:80 -r 192.168.2.6:80 -g #如果这里是隧道模式,直接将-g替换成-i即可

ipvsadm -a -t 192.168.2.3:80 -r 192.168.2.7:80 -g

#查看节点状态,Route代表 DR模式

ipvsadm -ln

(4)keeplivedを構成します

メインロードスケジューラ:192.168.2.4

スタンバイロードスケジューラ:192.168.2.3

yum -y install keepalived

cd /etc/keepalived/

cp keepalived.conf keepalived.conf.bak

構成ファイルを変更する

vim keepalived.conf

......

#定义全局参数

global_defs {

#10行修改,邮件服务指向本地

smtp_server 127.0.0.1

#12行修改,指定服务器(路由器)的名称,主备服务器名称须不同,主为LVS_01,备为LVS_02

router_id LVS_01

#14行修改;加注释;vrrp_strict:严格遵守VRRP协议。下列情况将会阻止启动Keepalived:1. 没有VIP地址。2. 单播邻居。3. 在VRRP版本2中有IPv6地址。

#vrrp_strict

}

#定义VRRP热备实例参数

vrrp_instance VI_1 {

#20行修改;指定热备状态,主为MASTER,备为BACKUP

state MASTER

#21行修改;指定承载vip地址的物理接口

interface ens33

#22行修改;指定虚拟路由器的ID号,每个热备组保持一致

virtual_router_id 10

#23行修改;指定优先级,数值越大优先级越高,主为100,备为90

priority 100

#通告间隔秒数(心跳频率)

advert_int 1

#定义认证信息,每个热备组保持一致

authentication {

#认证类型

auth_type PASS

#27行修改,指定验证密码,主备服务器保持一致

auth_pass 123456

}

#指定群集vip地址

virtual_ipaddress {

192.168.2.100

}

}

#34行修改,指定虚拟服务器地址(VIP)、端口,定义虚拟服务器和Web服务器池参数

virtual_server 192.168.2.100 80 {

#健康检查的间隔时间(秒)

delay_loop 6

#指定调度算法,轮询(rr)

lb_algo rr

#37行修改,指定群集工作模式,直接路由(DR)

lb_kind DR

#连接保持时间(秒)

persistence_timeout 50

#应用服务采用的是TCP协议

protocol TCP

#41行修改,指定第一个Web节点的地址、端口

real_server 192.168.2.6 80 {

#节点的权重

weight 1

#43行删除,添加以下健康检查方式

TCP_CHECK {

#添加检查的目标端口

connect_port 80

#添加连接超时(秒)

connect_timeout 3

#添加重试次数

nb_get_retry 3

#添加重试间隔

delay_before_retry 4

}

}

#添加第二个 Web节点的地址、端口

real_server 192.168.2.7 80 {

weight 1

TCP_CHECK {

connect_port 80

connect_timeout 3

nb_get_retry 3

delay_before_retry 4

}

}

}

#删除后面多余的配置

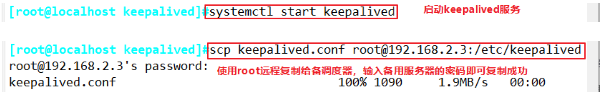

systemctl start keepalived

#查看虚拟网卡vip

ip addr show dev ens33

変更後にサービスを開始する

構成パラメーターは3つの場所でのみ異なるため、構成ファイルをスタンバイスケジューラーにリモートでコピーし、スタンバイスケジューラーで次のパラメーターを変更します。

#12行修改,指定服务器(路由器)的名称,主备服务器名称须不同,主为LVS_01,备为LVS_02

router_id LVS_02

#20行修改;指定热备状态,主为MASTER,备为BACKUP

state BACKUP

#23行修改;指定优先级,数值越大优先级越高,主为100,备为90

priority 90

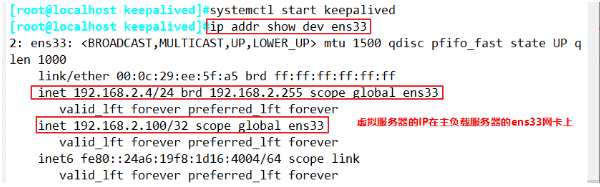

2つのロードスケジューラを設定して開始したら、「ip addr show dev ens33」を使用して、仮想ネットワークカードのvipを表示します。

メインロードスケジューラ:192.168.2.4上

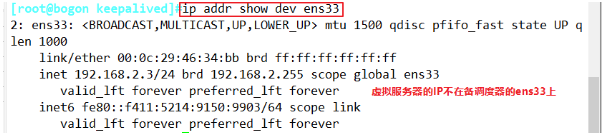

バックアップロードスケジューラ:192.168.2.3

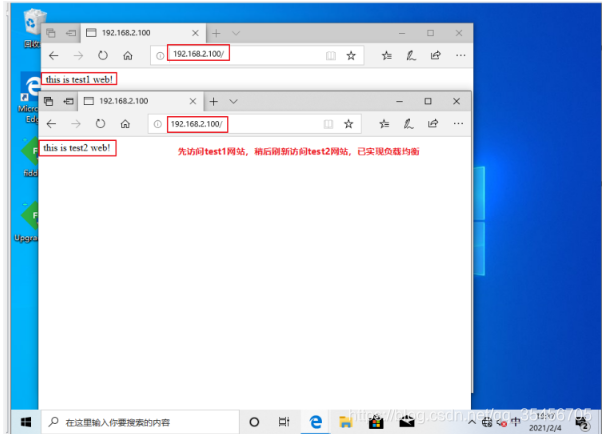

4.テスト検証

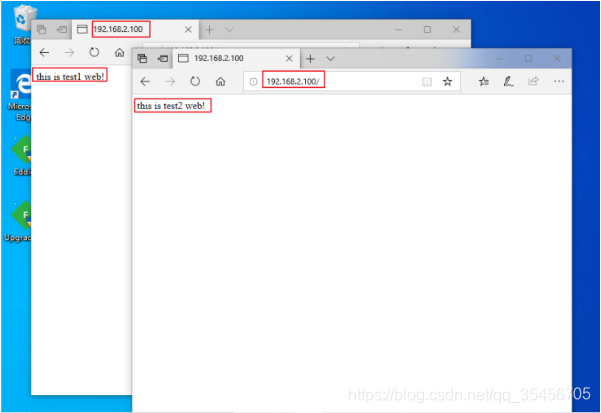

(1)クライアントでhttp://192.168.2.100/にアクセスし、テストの負荷分散が成功したことを更新し、表示をポーリングします

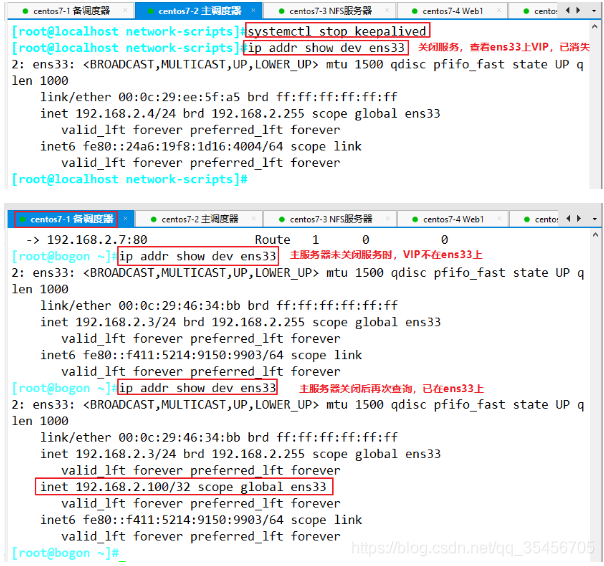

(2)メインディスパッチサーバーのkeepalived.serviceサービスを閉じてテストします

また、Windows 10クライアントがhttp://192.168.2.100/に再度アクセスしても、引き続き機能し、ポーリングが表示されます。