オペレーティングシステムのバージョンを確認します

$ sudo lsb_release -a

A.準備作業(オプション)

教育ネットワークミラーの追加1.1

まず、元の/etc/apt/sources.listのバックアップを作成します。

$ sudo cp /etc/apt/sources.list /etc/apt/sources.list.backup

その後、$ sudo vim /etc/apt/sources.listコマンドはの/etc/apt/sources.listの内容全体を交換します

# 清华大学镜像,默认注释了源码镜像以提高 apt update 速度,如有需要可自行取消注释

deb https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ xenial main restricted universe multiverse

# deb-src https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ xenial main restricted universe multiverse

deb https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ xenial-updates main restricted universe multiverse

# deb-src https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ xenial-updates main restricted universe multiverse

deb https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ xenial-backports main restricted universe multiverse

# deb-src https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ xenial-backports main restricted universe multiverse

deb https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ xenial-security main restricted universe multiverse

# deb-src https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ xenial-security main restricted universe multiverse

# 预发布软件源,不建议启用

# deb https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ xenial-proposed main restricted universe multiverse

# deb-src https://mirrors.tuna.tsinghua.edu.cn/ubuntu/ xenial-proposed main restricted universe multiverse

若しくは

#上海交通大学更新服务器

deb http://ftp.sjtu.edu.cn/ubuntu/ lucid main multiverse restricted universe

deb http://ftp.sjtu.edu.cn/ubuntu/ lucid-backports main multiverse restricted universe

deb http://ftp.sjtu.edu.cn/ubuntu/ lucid-proposed main multiverse restricted universe

deb http://ftp.sjtu.edu.cn/ubuntu/ lucid-security main multiverse restricted universe

deb http://ftp.sjtu.edu.cn/ubuntu/ lucid-updates main multiverse restricted universe

deb-src http://ftp.sjtu.edu.cn/ubuntu/ lucid main multiverse restricted universe

deb-src http://ftp.sjtu.edu.cn/ubuntu/ lucid-backports main multiverse restricted universe

deb-src http://ftp.sjtu.edu.cn/ubuntu/ lucid-proposed main multiverse restricted universe

deb-src http://ftp.sjtu.edu.cn/ubuntu/ lucid-security main multiverse restricted universe

deb-src http://ftp.sjtu.edu.cn/ubuntu/ lucid-updates main multiverse restricted universe

最後に、データソースを更新。

$ sudo apt-get update #更新数据源

$ sudo apt-get upgrade #更新软件版本,可以不执行

1.2ホスト名を変更

18.04 Ubuntuのあなたは、ファイル/etc/cloud/cloud.cfgを変更する必要があります

$ sudo vim /etc/cloud/cloud.cfg #找到preserve_hostname: false修改为preserve_hostname: true

3台のコンピュータ名は次のとおりです。マスター、Slave01、Slave02。コマンドを使用します。

$ sudo vim /etc/hostname #永久修改主机名(需要重新启动$ sudo reboot)

変更は、保存してください。あなたは、コンピュータ名を変更できるようにするには、コンピュータを再起動する必要があります。またはコマンドを使用します。

$ sudo hostname Master #临时修改主机名

注:このコマンドを実行した後、一時的に再起動した後、(新しいターミナルにホスト名が変更されている参照するために)ホスト名をホスト名を変更し、元に戻します。

1.3の設定IPアドレス

のUbuntu 18.04の設定/etc/netplan/50-cloud-init.yaml

$ sudo vim /etc/netplan/50-cloud-init.yaml #双网卡地址配置

$ sudo netplan apply #配置生效

3台のコンピュータは、(あなたはそれを見るために$ ifconfigコマンドを使用することができ、いくつかはまたens32、デフォルトはens160と呼ばれてい、ここではeth0と呼ばれるデフォルトのカード)静的IPアドレスを設定します。

$ sudo vim /etc/network/interfaces

1.4変更の/ etc / hosts

使用して$ ifconfig、コンピュータのIPアドレスを表示するコマンドを。

中3台のコンピュータ順次入力$sudo vim /etc/hosts(IPアドレスは、実際の状況に応じたことに注意してください)以下を修正するためには:

編集した後、pingコマンド局3つのコンピュータを接続することができます。

$ ping Slave01

$ ping Slave02

$ ping Master

作成するために、1.5のHadoopユーザー

3台のコンピュータは、(あなたが状況に応じて、Hadoopのユーザー名を設定することができます)マイルアカウントという名前のHadoopユーザーに設定されています

$ sudo useradd -m miles -s /bin/bash #创建hadoop用户叫做miles,并使用/bin/bash作为shell

$ sudo passwd miles #为hadoop用户设置密码,之后需要连续输入两次密码(例如:密码为0123456789)

$ sudo adduser miles sudo #为hadoop用户增加管理员权限

$ su - miles #切换当前用户为用户miles(hadoop用户)

$ sudo apt-get update #更新hadoop用户的apt,方便后面的安装

1.6 SSHのインストールは、パスワードなしでSSHを設定し

、すでにSSHが提供する場合は、このステップをスキップして、パスワードなしでSSHを設定することができます。

$ sudo apt-get install openssh-server #安装SSH server

SSHログインパスワードアップませ集合ません。

$ ssh localhost #登陆SSH,第一次登陆输入yes

$ exit #退出登录的ssh localhost

$ cd ~/.ssh/ #如果没法进入该目录,执行一次ssh localhost

$ ssh-keygen -t rsa

入力した後に$ ssh-keygen -t rsa以下のように文の後、三つの連続タッピングキャリッジを必要とする:

前記第1の後続のコマンド入力(ノートレコード)を容易にするために、デフォルト位置に格納された転送キーを可能にすることです。第二及び第三は、決定されたパスフレーズ、ほとんど相関しています。出力は、図に示したものと同様の表示された場合、入力が完了した後に2回押し、すなわち成功:

ここでファイルid_rsaと秘密鍵(キーprivite)、id_rsa.pubファイルの公開鍵(公開鍵)。2つのキーがの〜/ .ssh /、の〜/ .ssh /コマンド$ CDをディレクトリに移動ディレクトリにデフォルトです。そして、次のコマンドを入力します。

$ cat ./id_rsa.pub >> ./authorized_keys #将id_rsa.pub追加到授权的key中,创建authorized_keys文件

$ chmod 600 authorized_keys #修改authorized_keys的权限为:拥有者读写权

$ ssh localhost

この時間は、ローカルホストにログインするためのパスワードを必要としない、以下見ることができます。それが失敗した場合は、上記の手順を繰り返し、または「SSHログインパスワードフリー」の答えを追求するために検索することができます。

繰り返し各コンピュータ上のステップ1.6(SSHがインストールされ、SSHパスワードなし)、およびid_rsa.pub authorized_keysにを達成するためには、それぞれSlave01に公共およびSlave02を生成します。次に、以下のコマンドは、2つのつの子ノード上で実行されます。

$ scp miles@Master:~/.ssh/id_rsa.pub ./master_rsa.pub #将Master上的公钥id_rsa.pub复制到子节点上,并命名为master_rsa.pub

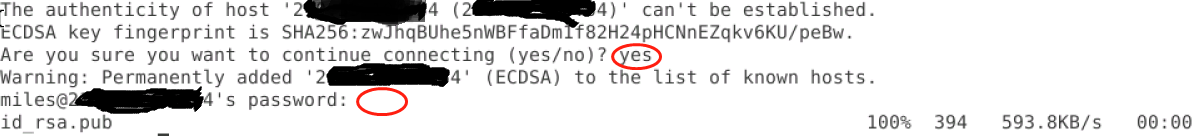

次の画像が表示され、答えは「はい」とマイルユーザのパスワード。

$ cat master_rsa.pub >> ./authorized_keys #将master_rsa.pub追加到子节点上授权的key中

バックマスターノードマスターに、コマンドを入力してください$ ssh Slave01直接ログインできるかどうかをテストします。この時点で、あなたは直接2つのスレーブマスターノード(パスワードなし)が見つかり、ログインすることができます。

Q:どのようにスレーブノード間でログインするためのパスワードのでしょうか?

II。インストールjdk8

ダウンロードしたパッケージについて、https://www.cnblogs.com/gbyukg/p/3326825.htmlに相談

2018年11月8日オフHadoop3.1.1が最新jdk11サポートしないことが判明し

、インストールするのHadoopシステムのニーズ内のコンピュータを。ダウンロードする最初のOracleの公式ウェブサイトでは、次のjdk8 http://www.oracle.com/technetwork/java/javase/downloads/index.html環境変数の設定をインストール、に基づいて、PCシステムの対応するバージョンを選択し、私はjdk-を選びました8u191-のlinux-x64.tar.gz

$ sudo mkdir /usr/lib/jvm #创建jvm文件夹

$ sudo tar -zxvf Downloads/jdk-8u191-linux-x64.tar.gz -C /usr/lib/jvm

#解压到/usr/lib/jvm目录下,jdk下载后默认路径为~/Downloads中

$ cd /usr/lib/jvm #进入该目录

$ sudo mv jdk1.8.0_191 java #将jdk1.8.0_191目录重命名为java

$ vim ~/.bashrc #给JDK配置环境变量

注意:

- 許可は、JVMフォルダを作成するのに十分でない場合はどこに、あなたは、関連するディレクトリの下に使用することができます

$ sudo -iフォルダを作成するには、rootアカウントを入力するためのコマンド。 - また使用され、インストールされていない場合は、編集環境変数にVIMを使用することをお勧め

$sudo apt-get install vimインストールします。

最後の.bashrcファイルに次の命令を追加します。

export JAVA_HOME=/usr/lib/jvm/java

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH

以下のような:

ファイルの変更が完了したら、次のコマンドを入力します。

$ source ~/.bashrc #使新配置的环境变量生效

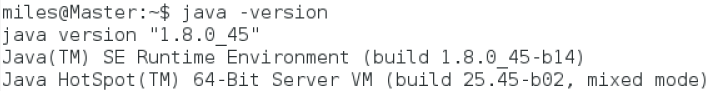

$ java -version #检测是否安装成功,查看java版本

以下に示すように、コンテンツが表示された場合は、インストールに成功しています。

III。インストールのHadoop-3.1.1

Hadoopのシステム内のコンピュータをインストールする必要があります。

Hadoopの-3.1.1.tar.gzは、http://mirrors.hust.edu.cn/apache/hadoop/common/からインストールをダウンロードすることができます。

$ sudo tar -zxvf hadoop-3.1.1.tar.gz -C /usr/local #解压到/usr/local目录下

$ cd /usr/local

$ sudo mv hadoop-3.1.1 hadoop #将hadoop-3.1.1目录重命名为hadoop

$ sudo chown -R miles ./hadoop #修改文件权限,属于用户miles

Hadoopが使用、環境変数を設定するため$ vim ~/.bashrcの.bashrcファイルに次のコードを追加し、コマンドを:

export HADOOP_HOME=/usr/local/hadoop

export CLASSPATH=$($HADOOP_HOME/bin/hadoop classpath):$CLASSPATH

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib:$HADOOP_COMMON_LIB_NATIVE_DIR"

以下に示すように

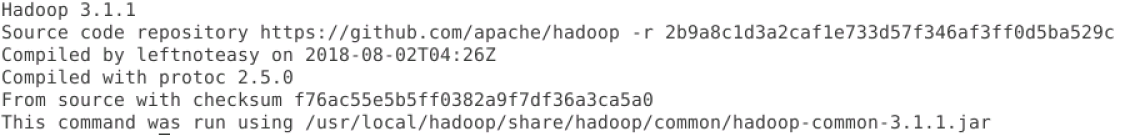

実行するsource ~/.bashrc設定が有効になります。そして、使用し$ hadoop version成功した場合は、図に示すように、それは、次の情報を返し、正常にインストールをHadoopのコマンドを。

四。Hadoopの動作モード

営業Hadoopクラスタは、すなわち、3つのモードがあります。

- ローカル/スタンドアロンモード:デフォルトでは、このモードでは、Javaプログラムを実行するために使用されています。

- 分散シミュレーションモード(別名擬似分布パターン):コンピュータ上の分散シミュレーション。開発で使用するために、実行するためのスタンドアロンのJavaプログラムなどなどHDFS、糸、MapReduceの、などの各プロセスのHadoopの保護者、、。

- 完全分散型:実用に適しのHadoopの使用、(を含む)は、2つ以上のクラスタ内の複数のコンピュータを。本明細書モードを使用します。

また、Hadoopの2.xとHadoopが異なり3.X、テキスト(https://blog.csdn.net/wshyb0314/article/details「ビッグデータHadoop2.x Hadoop3.xは、変更内容と比較して」読み/ 82184680)。ここで、次の表に示すように、彼らは、異なるデフォルトで使用するポート番号。

V.完全分散構成

5.1ディレクトリ(マスタのみに配置された)を作成し

、メインディレクトリデータの格納と交流として使用されたHadoopのtmpディレクトリのユーザーで作成すると、DFS(ユーザー名マイル)、および名前の下にサブディレクトリを作成し、データDFSディレクトリのコマンドは以下の通りであります:

$ mkdir -p ~/dfs/name #在普通用户主目录下同时创建dfs目录及其子目录name

$ mkdir ~/dfs/data #创建dfs的子目录data

$ mkdir ~/tmp #在普通用户主目录下创建目录tmp

5.2コンフィギュレーション・ファイルの変更

は/ usr / local / Hadoopの/などのプロファイルの経路(セットに従ってHADOOP_HOME) / Hadoopの/ ディレクトリ、そのディレクトリにあります。

$ cd /usr/local/hadoop/etc/hadoop/

-

実行

$ sudo vim workers、3台のコンピュータにホスト名を追加します。 -

実行は

$ sudo vim core-site.xml、最終文書はなり<configuration> </configuration>交換すること

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://Master:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/home/miles/tmp</value>

</property>

</configuration>

- 実行

$ sudo vim hadoop-env.sh、設定JAVA_HOME JDKのインストール。

Javaホーム:JAVA_HOME =は/ usr / libに/ JVM / Javaの

Hadoopのホームディレクトリ:HADOOP_HOME =は/ usr / local /の Hadoopの( これが設定されていない)

、次のように:

- 実装

$ sudo vim hdfs-site.xml交換する最終文書

<configuration>

<property>

<name>dfs.namenode.http-address</name>

<!-- Master为当前机器名或者IP地址 -->

<value>hdfs://Master:9001</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<!-- 以下为存放节点命名的路径 -->

<value>/home/miles/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<!-- 以下为存放数据命名的路径 -->

<value>/home/miles/dfs/data</value>

</property>

<property>

<name>dfs.replication</name>

<!-- 备份次数,因为有2台DataNode-->

<value>2</value>

</property>

<property>

<name>dfs.webhdfs.enabled</name>

<!-- Web HDFS-->

<value>true</value>

</property>

</configuration>

- 実行は

$ sudo vim mapred-site.xml、最終文書はなり<configuration> </configuration>交換すること

<configuration>

<property>

<name>mapreduce.framework.name</name>

<!-- MapReduce Framework -->

<value>yarn</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<!-- MapReduce JobHistory, 当前计算机的IP -->

<value>Master:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<!-- MapReduce Web App JobHistory, 当前计算机的IP -->

<value>Master:19888</value>

</property>

<property>

<name>yarn.app.mapreduce.am.env</name>

<value>HADOOP_MAPRED_HOME=/usr/local/hadoop</value>

</property>

<property>

<name>mapreduce.map.env</name>

<value>HADOOP_MAPRED_HOME=/usr/local/hadoop</value>

</property>

<name>mapreduce.reduce.env</name>

<value>HADOOP_MAPRED_HOME=/usr/local/hadoop</value>

</property>

</configuration>

- 実行は

$ sudo vim yarn-site.xml、最終文書はなり<configuration> </configuration>交換すること

<configuration>

<!-- Site specific YARN configuration properties -->

<property>

<name>yarn.resourcemanager.hostname</name>

<!-- Master为当前机器名或者ip号 -->

<value>Master</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<!-- Node Manager辅助服务 -->

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name>

<!-- Node Manager辅助服务类 -->

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

<property>

<name>yarn.nodemanager.resource.cpu-vcores</name>

<!-- CPU个数,需要根据当前计算机的CPU设置-->

<value>2</value>

</property>

<property>

<name>yarn.resourcemanager.admin.address</name>

<!-- Resource Manager管理地址 -->

<value>Master:8033</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<!-- Resource Manager Web地址 -->

<value>Master:8088</value>

</property>

</configuration>

VI。Hadoopの設定ファイルをコピーします。

マスター設定後、すべてのノードにマスターは/ usr / local / Hadoopの(HADOOP_HOME)ディレクトリスレーブのコンフィギュレーションファイルをコピーする必要があります。まず、マスター上で次のコマンドを実行します。

$ cd /usr/local

$ sudo rm -r ./hadoop/tmp #删除Hadoop临时文件

$ sudo rm -r ./hadoop/logs/* #删除Hadoop日志文件

$ tar -zcf ~/hadoop.master.tar.gz ./hadoop #将Hadoop的配置目录压缩成一个文件到用户主目录下

$ cd ~

$ scp ./hadoop.master.tar.gz miles@Slave01:~/ #将压缩包文件复制到Slave01主机上miles用户的主目录下

次に、スレーブノードで次のコマンドを実行します。

$ sudo rm -r /usr/local/hadoop #删除原来的Hadoop文件和目录

$ sudo tar -zxf ~/hadoop.master.tar.gz -C /usr/local #解压缩都/usr/local目录中

$ sudo chown -R miles /usr/local/hadoop #修改/usr/local/hadoop目录的拥有者为Hadoop用户miles

VII。スタートのHadoop

1. HDFSの

名前ノードの初期化●

マスターは名前ノードで、スレーブはこれだけHDFSマスターは、次のコマンドでフォーマットする必要があり、データノードであります:

$ hdfs namenode -format #初始化namenode

あればフォーマットは、複数の情報、3行目が生成されます

......ストレージディレクトリ/ home /マイル/正常にフォーマットされたHDFS /名前を、その後の書式設定HDFSの成功を。

「状態0で終了する」エラーリターンが失敗の「ステータス1で終了」、成功しません。

●テスト開始HDFSは

マスターで次のコマンドを実行します

$ start-dfs.sh #启动dfs

$ start-yarn.sh #启动yarn

$ mapred --daemon start historyserver #启动historyserver,它不是必须的步骤

マスター上で実行$jpsコマンドには、5つのプロセスを見ることができます。

NameNode

SecondaryNameNode

NodeManager

ResourceManager

Jps

JobHistoryServer

スレーブ上で実行$jpsコマンドは、次の3つのプロセスを見ることができます。

DataNode

NodeManager

Jps

注:任意のプロセスの欠如は間違いを表明しています。//マスター:9870(Hadoop3)またはhttp://マスター:50070(Hadoop2ブラウザのHTTPを介してアクセスすることができる ) ログの表示ログ、またはノードとデータノードの名前。

Hadoopクラスタの例を確認2.

マスター上で実行$ hdfs dfsadmin -reportデータノードが正常に起動するかどうかを確認するためのコマンドを。正常起動した場合、それは、図1に示すように、以下の情報を返します。ゼロではないライブdatanodes、クラスタが正常に開始したことを示しています。次の図は、クラスタが3つのデータノードを持って示しています。

、9870のまたはIPアドレスhttp://192.168.1.10:9870以下に示すように、ウェブクラスタの状態を参照してください://マスター:あなたは、ブラウザのhttpで入力することができます。

八。のHadoopプラットフォームのテスト

- WORDCOUNT

Hadoopのインストールディレクトリ内(は/ usr / local / Hadoopの/ )、 を提供ワードカウントプログラム--WordCount。WORDCOUNTプログラムは、MapReduceのとHDFSを利用して、Hadoopのコンピューティングプラットフォーム上で実行されています。これは、単語がファイルに表示された回数をカウントして、統計的な結果を与えることができます。私たちは、Hadoopのプラットフォームが正常に実行するかどうかを検出することができ、プログラムを実行することによってWORDCOUNT。

1 HDFS上の適切なディレクトリとそれに対応するテキストファイルを確立します。ホームディレクトリでは(/ホーム/マイル/)フォルダの入力を作成し、フォルダの入力を入力して、次のコマンドを実行します。

$ mkdir /home/miles/input

$ cd /home/miles/input

FILE01は、文書やFILE02を作成し、次のように注文されているカウントされる内容を書き込みます:

$ echo "hello world bye world" > file01 #写内容到文件file01中

$ echo "hello hadoop goodbye hadoop" >file02 #写内容到文件file02中

2次のコマンドを実行し、HDFS、HDFSディレクトリの入力にアップロードFILE01とFILE02上のディレクトリ入力を作成します。

$ cd /home/miles/input

$ hadoop fs -mkdir /hadoopusers/miles/input #创建HDFS的/hadoopusers/miles/input目录

$ hadoop fs -put * /hadoopusers/miles/input #将/home/miles/input目录下的文件上传到HDFS的/hadoopusers/miles/input目录

$ hadoop fs -ls /hadoopusers/miles/input #/查看HDFS的/hadoopusers/miles/input目录下文件的状态

場合は、端末の表示:

-rw-r--r-- 4 miles supergroup 22 2018-11-09 21:43 input/file01

-rw-r--r-- 4 miles supergroup 28 2018-11-09 21:43 input/file02

これは、ファイルがHDFSの成功にアップロードすることを意味します。

3ファイル名を指定して実行WORDCOUNTプログラム

エントリ(セット応じHADOOP_HOME)は/ usr / local / Hadoopのの/ etcの / Hadoopの//シェア/ Hadoopの/のMapReduce ディレクトリ。その後、プログラムは、次のコマンドを実行しWORDCOUNT

#进入目录

$ cd /usr/local/hadoop/share/hadoop/mapreduce

#执行Wordcount程序

$ hadoop jar hadoop-mapreduce-examples-3.1.1.jar wordcount /hadoopusers/miles/input /hadoopusers/miles/output

注:出力には、空のディレクトリに新しいものでなければなりません。

以下の情報が表示されている場合は、端末を操作すると、より多くの情報システムを生成します。

18/11/09 21:56:18 INFO mapreduce.Job: map 0% reduce 0%

18/11/09 21:56:29 INFO mapreduce.Job: map 100% reduce 0%

18/11/09 21:56:38 INFO mapreduce.Job: map 100% reduce 100%

18/11/09 21:56:38 INFO mapreduce.Job: Job job_1410242637907_0001 completed successfully

18/11/09 21:56:38 INFO mapreduce.Job: Counters: 43

表示プログラムが動作中のMapReduce分散プログラミングモードを行いました。

4プログラムの業績出力は

WORDCOUNTプログラムの実行が完了した後、調査結果は、出力ディレクトリの下の部分-R-00000 HDFSファイルに出力されます。統計単語を表示するには、次のコマンドを入力します。

$ hadoop fs -cat /hadoopusers/miles/output/part-r-00000

端末ディスプレイの出力端子:

bye 1

goodbye 1

hadoop 2

hello 2

world 2

私たちは、Hadoopのクラスタが正常にHadoopプラットフォームが正常に実行できることを示し、各単語が表示されてファイルFILE01とFILE02の数をカウントすることができ、その結果から見ることができます。

Q:どのように設定し、デフォルトディレクトリのHadoopユーザーを変更するために、知っているのですか?

- ビューHadoopクラスタ情報

8088またはhttp://192.168.1.10:8080を、以下のように、ウェブインタフェースを介してHadoopクラスタの情報を表示://マスター:実行時には、ブラウザのhttpで入力します。

Hadoopクラスタは、上記正しく起動されています。あなたはHadoopクラスタを閉鎖する必要がある場合は、マスター上でコマンドを実行することができます。

$ stop-yarn.sh

$ stop-dfs.sh

$ mapred --daemon stop historyserver #关闭历史记录服务

Q:セルフは、本実験によればHadoopクラスタの構成とドッカー(容器)を使用します。

IX。エラー

“2018-10-30 13:30:40,855 WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform… using builtin-java classes where applicable”

/ etc / profileを、以下の設定を追加します。

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export HADOOP_HOME=/usr/local/hadoop

export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib:$HADOOP_COMMON_LIB_NATIVE_DIR"

構成を検証します:$ source /etc/profile

- データノード起動しないとき、今Hadoopの場合はやり直す前に、しかし、特に、正常に起動することはできません。次のコマンドを実行し、マスター、ファイルデータの名前に名前保存されたクラスタ名を削除することができます。

$ rm -r /home/miles/hdfs/name/*

$ rm -r /home/miles/hdfs/data/*

そして、すべてのノードを含む、マスターとスレーブを含むすべての一時ファイルは、次のコマンドを実行します。

$ rm -r /home/miles/tmp/*

再実行では$ hdfs namenode -format、コマンド、Hadoopクラスタを再フォーマットします。

3.「次のエラーが発生した場合はjava.net.ConnectException: Call From Master/192.168.1.10 to Master:8032 failed on connection exception: java.net.ConnectException: Connection refused; For more details see: http://wiki.apache.org/hadoop/ConnectionRefused、」可能性の高い原因をこのResourceManagerが起動しなかったです。

リファレンス

- ApacheのHadoopの3.1.1公式文書https://hadoop.apache.org/docs/r3.1.1/

- Hadoopクラスタは、英語版https://hadoop.apache.org/docs/stable/hadoop-project-dist/hadoop-common/ClusterSetup.htmlをインストール

- Hadoopの3.xの新機能解析https://www.cnblogs.com/smartloli/p/9028267.html

- XFCE4とvncserverを設定https://www.howtoing.com/how-to-install-and-configure-vnc-on-ubuntu-18-04

- インストールおよび構成(擬似分散環境)のHadoop Ubuntu16.04 https://www.cnblogs.com/87hbteo/p/7606012.html

- 完全分散型のHadoopクラスタのセットアップhttps://blog.csdn.net/u014636511/article/details/80171002

- 超詳細な記録のHadoop3.1.0完全分散型クラスタ配置https://blog.csdn.net/weixin_42142630/article/details/81837131

- 超詳細な記録のHadoop3.1.0完全分散型クラスタ配置https://blog.csdn.net/dream_an/article/details/80258283?utm_source=blogxgwz0

- ビルドへのHadoop環境(スタンドアロン)https://blog.csdn.net/qazwsxpcm/article/details/78637874?utm_source=blogxgwz0

- インストールと配備のHadoop3.0安定版https://blog.csdn.net/rlnLo2pNEfx9c/article/details/78816075